好的!我将非常详细地解释灾难性遗忘(Catastrophic Forgetting)的机制、成因以及其在深度学习中的具体表现。以下内容将分为多个层次展开:

1. 灾难性遗忘的定义

灾难性遗忘(Catastrophic Forgetting)是指神经网络在学习新任务时,快速丢失对旧任务的知识的现象。这一概念最早由McCloskey & Cohen(1989)在研究人类记忆时提出,后来被广泛应用于神经网络领域。

典型场景:

- 模型先在任务A上训练,达到高性能。

- 接着在任务B上继续训练(不重新接触任务A的数据)。

- 训练后,模型在任务B上表现良好,但在任务A上的性能急剧下降。

示例:

- 一个图像分类模型先学会识别猫和狗(任务A),再学习识别汽车和飞机(任务B),之后可能完全无法正确分类猫和狗。

2. 灾难性遗忘的成因

灾难性遗忘的根本原因在于神经网络的参数更新机制,具体可分为以下几个层面:

(1) 参数共享与覆盖

-

参数空间重叠:

- 神经网络通过共享参数处理不同任务。当学习新任务时,梯度更新会覆盖旧任务相关的参数。

- 数学视角:假设旧任务A的损失函数为 ( L_A(\theta) ),新任务B的损失为 ( L_B(\theta) )。优化器通过 ( \theta \leftarrow \theta - \eta \nabla L_B(\theta) ) 更新参数,这可能导致 ( \theta ) 移出 ( L_A ) 的低损失区域。

-

任务间冲突:

- 如果任务A和任务B的最优参数方向相反,优化新任务会直接破坏旧任务的性能。

- 示例:在自然语言处理中,任务A要求模型输出长文本,任务B要求输出短文本,参数调整可能互相矛盾。

(2) 监督信号的动态变化

-

输出层干扰:

- 输出层的参数直接关联任务特定的决策边界。当新任务引入新的类别(如新增分类标签)时,输出层的权重会被重新分配,导致旧类别权重被稀释或覆盖。

-

隐层表征漂移:

- 中间层的特征表示(Feature Representation)会随新任务的学习发生偏移。即使输出层未被修改,隐层的变化也会使旧任务的推理路径失效。

(3) 优化器的“短视性”

-

局部最优陷阱:

- 随机梯度下降(SGD)等优化器专注于当前批次数据的损失最小化,缺乏对旧任务损失的“记忆”。

- 对比人类学习:人类可以通过主动回忆巩固旧知识,但标准优化器没有这种机制。

-

学习率的影响:

- 过高的学习率会加速参数覆盖。例如,在微调大模型时,若全参数以高学习率更新,旧知识可能被迅速破坏。

(4) 任务相似性与容量限制

-

任务相似度低:

- 如果新旧任务差异较大(如文本分类 vs. 图像生成),模型需要不同的特征提取逻辑,参数冲突会更严重。

-

模型容量不足:

- 当模型参数规模较小时,有限的容量无法同时编码多个任务的知识,导致新旧任务互相挤压。

(5) 突触可塑性的缺失

- 神经科学的启示:

- 人脑通过选择性突触可塑性(某些突触稳定,某些可修改)实现持续学习。而标准神经网络的所有参数默认均可更新,缺乏稳定性机制。

3. 灾难性遗忘的具体表现

以大语言模型(LLM)微调为例:

- 初始状态:

- 模型在通用语料上预训练,掌握广泛的语言模式和知识。

- 微调阶段:

- 用垂直领域数据(如医学文本)微调模型,使其适配特定任务。

- 灾难性遗忘:

- 模型在医学任务上表现提升,但通用能力(如写诗、代码生成)显著下降。

- 根本原因:微调过程中,语言建模的通用参数被医学领域的梯度更新覆盖。

4. 解决灾难性遗忘的常见方法

理解成因后,解决思路主要围绕限制参数更新或引入记忆机制:

(1) 参数隔离(Parameter Isolation)

- 核心思想:为不同任务分配独立的参数子集。

- 方法举例:

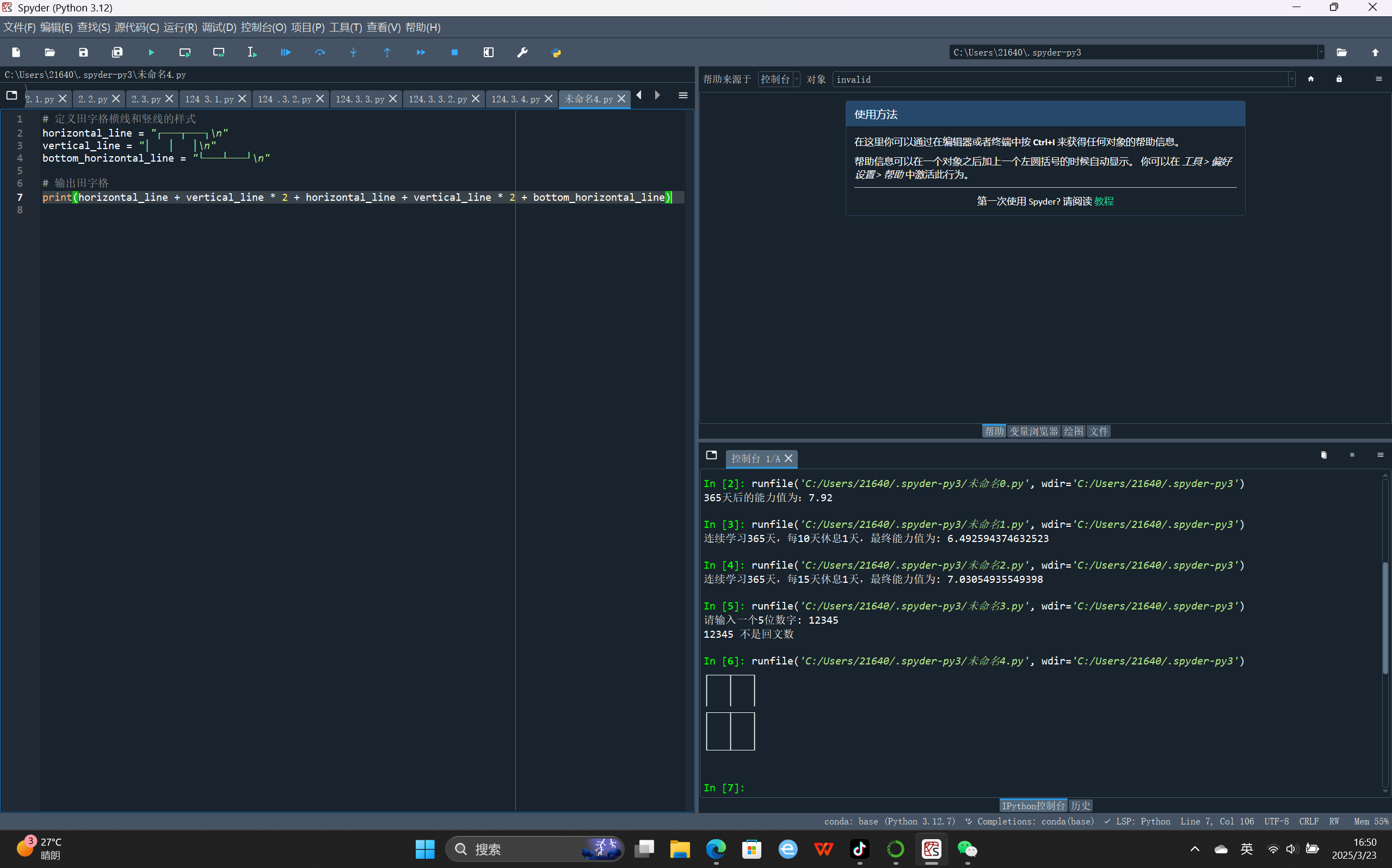

- LoRA:冻结原模型参数,通过低秩矩阵增量更新。

- Adapter Tuning:在Transformer层中插入小型适配器模块,仅训练适配器。

- MoE(混合专家):为不同任务分配不同的“专家”子网络。

(2) 正则化约束

- 弹性权重固化(EWC):

- 计算旧任务参数的重要性,限制重要参数的更新幅度。

- 知识蒸馏:

- 用旧模型的输出作为监督信号,强制新模型保留旧行为。

(3) 回放机制(Rehearsal)

- 数据回放:

- 在训练新任务时,混合少量旧任务数据,重新激活旧记忆。

- 生成回放:

- 用生成模型(如GAN)合成旧任务数据,避免存储真实数据。

(4) 架构设计

- 渐进式网络:

- 为每个任务扩展新的网络分支,避免参数覆盖。

- 动态网络:

- 根据输入任务动态激活不同子网络(如MoE的门控机制)。

5. 研究前沿与挑战

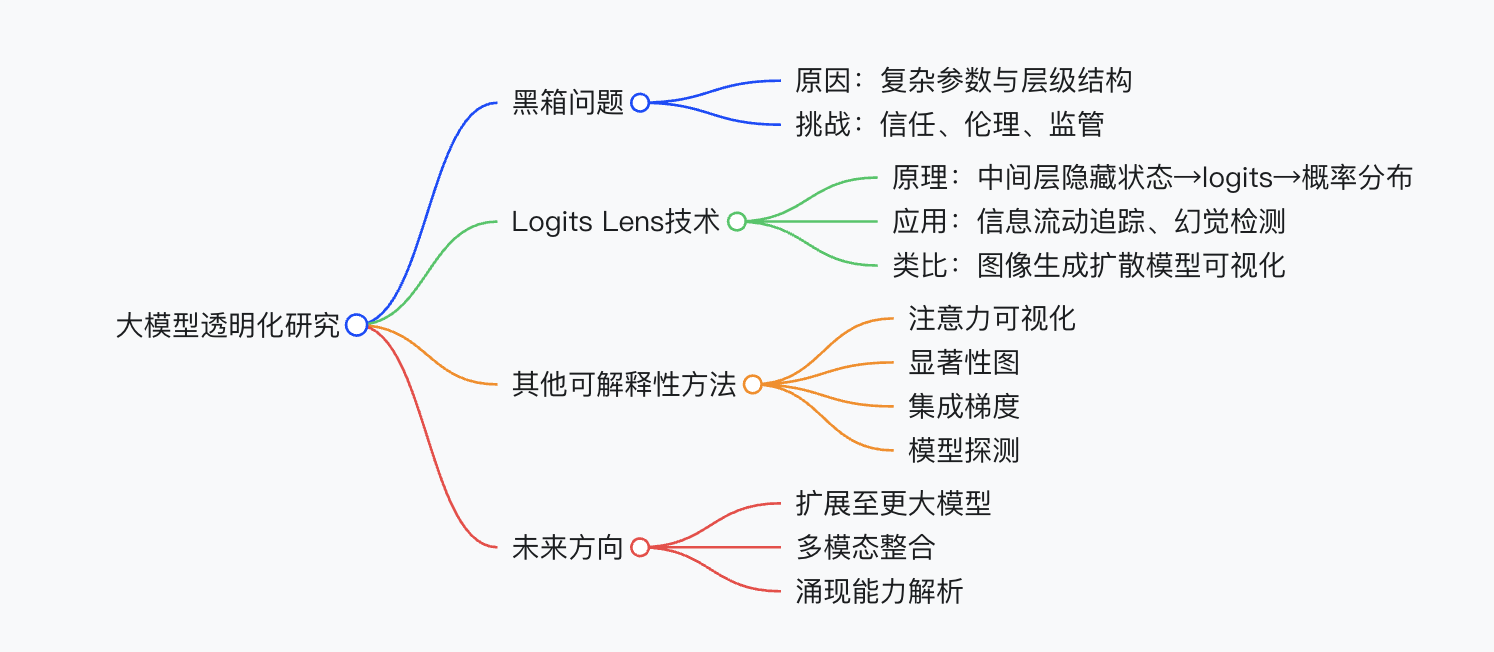

- LLM场景的特殊性:

- LLM参数量极大(如千亿级),传统方法计算开销高,需探索更高效的方式(如LoRAMoE)。

- 任务增量 vs. 类别增量:

- 如何区分任务边界?现实场景中任务可能动态变化且无明确标识。

- 理论分析:

- 从损失函数几何视角分析参数更新轨迹(如论文)。

6. 动手验证实验建议

若要直观理解灾难性遗忘,可设计以下实验:

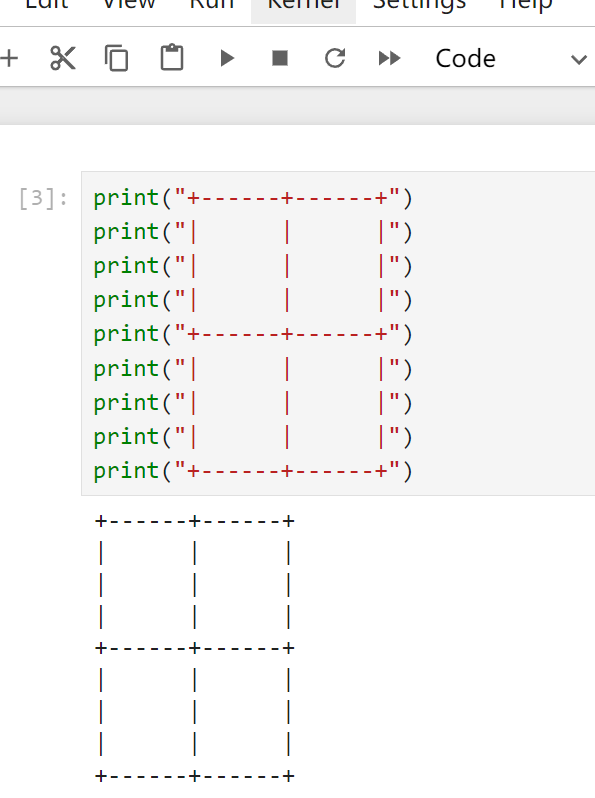

- 基础实验:

- 用MNIST数据集训练一个简单CNN分类10个数字。

- 分阶段训练:先训练0-4类,再训练5-9类,观察旧类别准确率是否暴跌。

- LLM实验:

- 微调BERT模型完成情感分析任务,随后继续微调其完成实体识别任务,测试情感分析性能变化。

- 对比解决方案:

- 在相同实验中使用LoRA或Adapter,观察遗忘是否缓解。

总结

灾难性遗忘的本质是神经网络在持续学习(Continual Learning)中缺乏对旧知识的保护机制。理解其成因后,可通过参数隔离、正则化、动态架构等方法缓解问题。当前LLM的高效调参技术(如LoRA、MoE)均与此问题密切相关,建议结合代码实践(如Hugging Face PEFT库)加深理解。