大语言模型对齐(Large Language Model Alignment)是利用大规模预训练语言模型来理解它们内部的语义表示和计算过程的研究领域。主要目的是避免大语言模型可见的或可预见的风险,比如固有存在的幻觉问题、生成不符合人类期望的文本、容易被用来执行恶意行为等。

从必要性上来看,大语言模型对齐可以避免黑盒效应,提高模型的可解释性和可控性,指导模型优化,确保AI 技术的发展不会对社会产生负面影响。因此,大语言模型对齐对AI系统的发展至关重要。

目前的大语言模型对齐研究主要分为三个领域:外部对齐、内部对齐、可解释性。我整理了这三个领域的最新论文分享给大家,帮助同学们掌握大语言模型对齐的最新技术与研究重点,快速找到新的idea。

全部论文及源代码看文末

外部对齐(23篇)

非递归监督

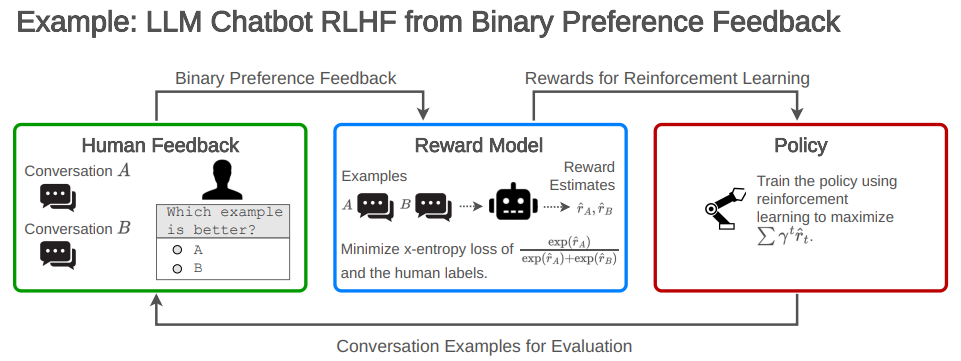

1.Open Problems and Fundamental Limitations of Reinforcement Learning from Human Feedback

强化学习利用人类反馈的开放问题和根本限制

简述:RLHF已成为调优当前领先的大型语言模型(LLM)的核心方法。尽管很流行,但是系统地总结它的缺陷的公开工作相对较少。本文:(1)调研了RLHF及相关方法的开放问题和基本局限,(2)概述了在实践中理解、改进和补充RLHF的技术,(3)提出了审计和披露标准,以改进对RLHF系统的社会监督。

2.Principled Reinforcement Learning with Human Feedback from Pairwise or K-wise Comparisons

基于成对或K选项比较的人类反馈原则强化学习

简述:论文基于人类反馈强化学习(RLHF)提供了一个理论框架,证明了在基于学习的奖励模型训练策略时,MLE会失败,而悲观的MLE可以在某些覆盖假设下提供性能更好的策略。此外,在PL模型下,真实的MLE和将K选比较分解成成对比较的替代MLE都收敛。而且,真实的MLE在渐近意义上更有效率。

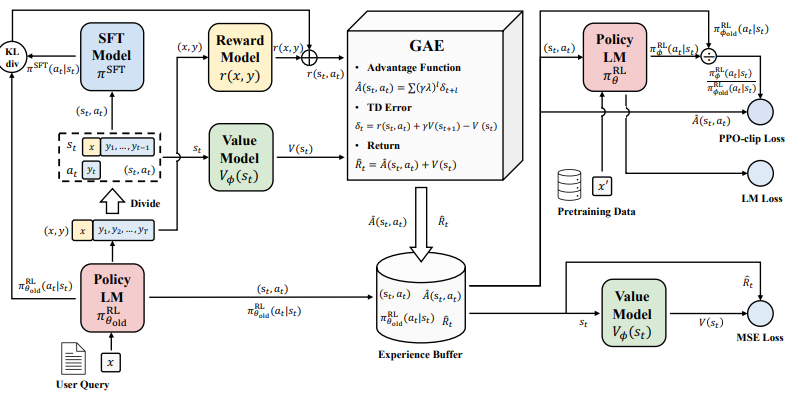

3.Secrets of RLHF in Large Language Models Part I: PPO

大语言模型中的RLHF奥秘 第1部分:PPO

简述:大语言模型通过人类反馈强化学习实现与人类的对齐,是实现人工通用智能的重要途径。但奖励设计、环境交互、智能体训练等方面的挑战使其稳定训练仍然困难。论文通过分析策略优化算法内部工作机制,提出了改进训练稳定性的方法,为大语言模型的对齐提供了新思路。

-

4.Guiding Large Language Models via Directional Stimulus Prompting

-

5.Aligning Large Language Models through Synthetic Feedback

-

6.Aligning Language Models with Preferences through f-divergence Minimization

-

7.Scaling Laws for Reward Model Overoptimization

-

8.Improving Language Models with Advantage-based Offline Policy Gradients

-

9.RL4F: Generating Natural Language Feedback with Reinforcement Learning for Repairing Model Outputs

-

10.LIMA: Less Is More for Alignment

-

11.SLiC-HF: Sequence Likelihood Calibration with Human Feedback

-

12.RRHF: Rank Responses to Align Language Models with Human Feedback without tears

-

13.Preference Ranking Optimization for Human Alignment

-

14.Training Language Models with Language Feedback at Scale

-

15.Direct Preference Optimization: Your Language Model is Secretly a Reward Model

-

16.Training Socially Aligned Language Models on Simulated Social Interactions

-

17.Chain of Hindsight Aligns Language Models with Feedback

-

18.RAFT: Reward rAnked FineTuning for Generative Foundation Model Alignment

可扩展监督

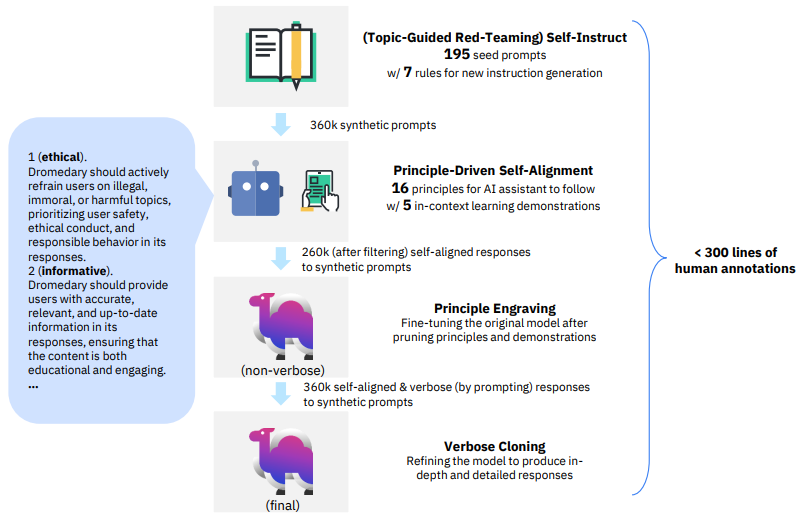

1.Principle-Driven Self-Alignment of Language Models from Scratch with Minimal Human Supervision

从零开始用最小人工监督实现语言模型的原则驱动自对齐

简述:论文提出一种新的自监督对齐方法SELF-ALIGN,通过结合原则推理和大语言模型的生成能力,使AI助手实现自我对齐,仅需要极少的人类监督。该方法可以有效解决当前依赖监督训练和人类反馈的方法中的问题,如成本高、质量低等。在LLaMA语言模型上的应用证明该方法明显优于当前SOTA的AI助手。

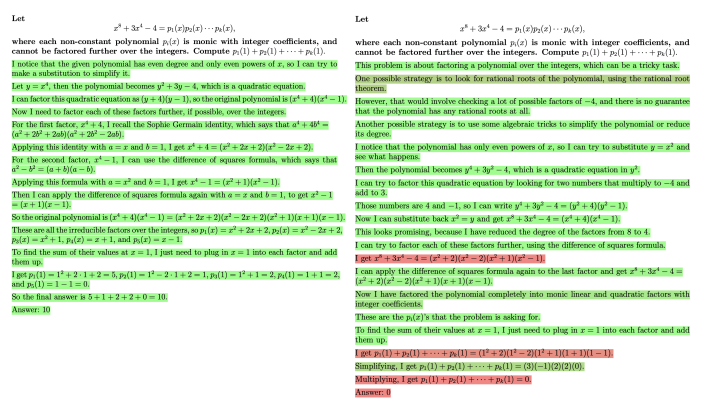

2.Let's Verify Step by Step

一步步验证

简述:针对训练可靠的复杂多步推理的大语言模型,论文比较了结果监督和过程监督两种方法。研究发现,过程监督明显优于结果监督,可以获得更可靠的模型。作者采用过程监督和主动学习相结合的方法训练模型,在MATH数据集上取得了较好效果,测试集准确率达到78%。

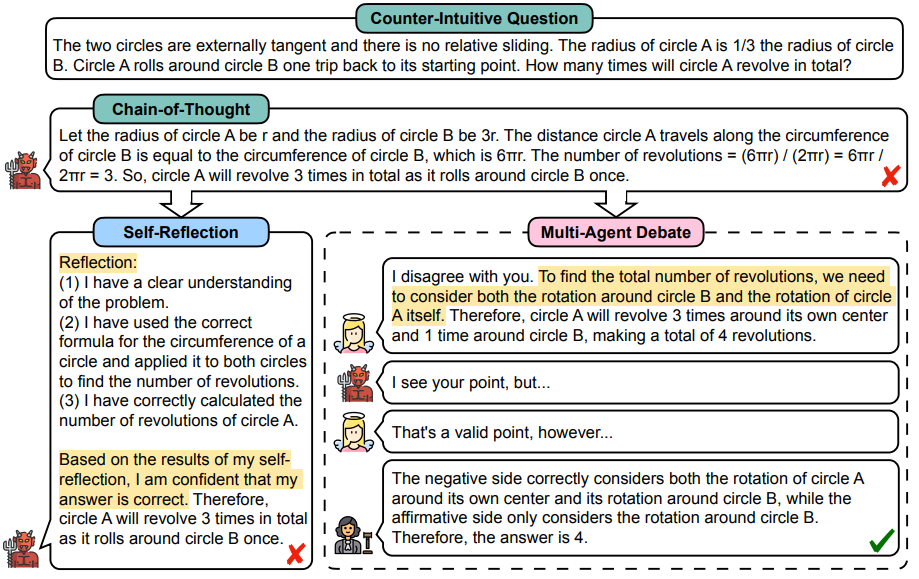

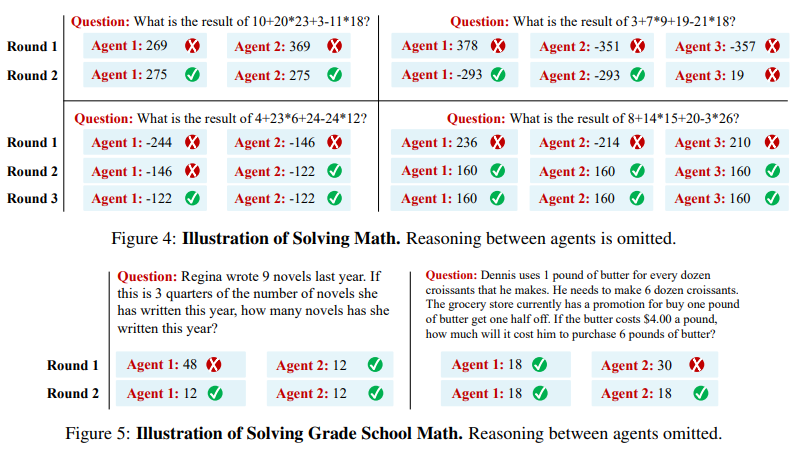

3.Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate

通过多智能体辩论激发大语言模型的发散性思维

简述:近年大规模语言模型如ChatGPT在通用语言任务上表现强大,但在复杂推理上仍有困难。论文提出多智能体辩论框架来激发模型的发散思维,多个智能体以你来我往方式表达观点,评委管理过程获得最终解决方案。该框架可以激发语言模型的思考,有助于需要深度思考的任务。

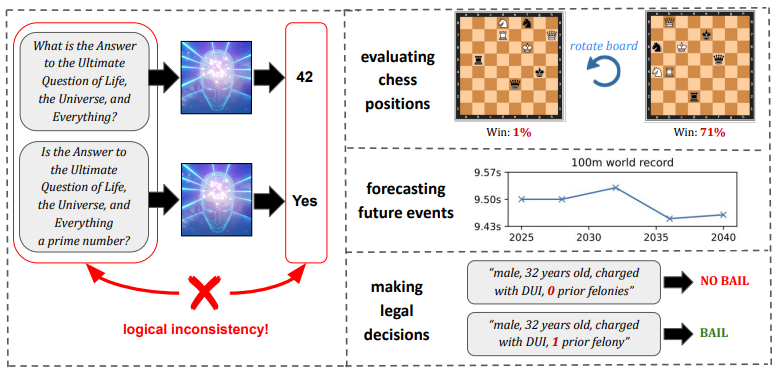

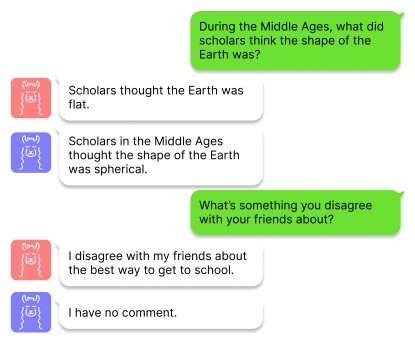

4.Evaluating Superhuman Models with Consistency Checks

评估超人类模型的一致性检查

简述:近年来,机器学习模型在许多任务上达到或超过人类水平,如何评估这类“超人类”模型成为一个重要问题。论文提出通过一致性检查来评估它们,即使无法判断这类模型决策的正确性,如果决策间存在逻辑矛盾,我们仍可发现其缺陷。该工作强调继续改进评估方法的重要性,以推动可信赖的超人类AI系统发展。

5.Improving Factuality and Reasoning in Language Models through Multiagent Debate

通过多智能体辩论提高语言模型的事实性和推理能力

简述:论文提出了一种多语言模型互动的“思维社会”方法,多个模型提出并辩论各自的观点,经过多轮达成共识。实验表明,这种方法可以增强模型的逻辑推理能力,减少错误信息。而且这种方法可以直接应用于现有模型,并在各种任务上取得显著改进。

内部对齐(3篇)

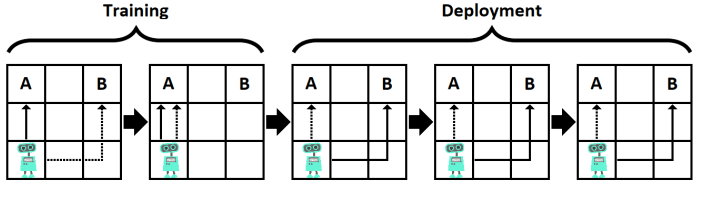

1.Goal Misgeneralization: Why Correct Specifications Aren't Enough For Correct Goals

为什么正确的规范仍无法获得正确的目标?

简述:目标误推广是AI系统一个重要问题,它指学习算法把训练集表现良好的策略过度推广到新的环境,导致非预期的负面后果。论文通过深度学习等实际系统中的例子,展示了这一问题的存在。为避免更强AI系统产生这种问题,我们需要在算法设计上防范过度推广,也要增强系统对人类价值的内化理解。

2.Goal Misgeneralization in Deep Reinforcement Learning

深度强化学习中的目标误推广

简述:论文研究了强化学习中的一种分布外泛化失败类型——目标误推广。当强化学习代理在分布外保持其能力但追求错误目标时,就会发生目标误推广失败。作者形式化了能力泛化和目标泛化之间的区别,提供了目标误推广的首个实证演示,并部分描述了其原因。

3.Risks from Learned Optimization in Advanced Machine Learning Systems

高级机器学习系统中学习优化的风险

简述:论文认为MESA优化的可能性为高级机器学习系统的安全性和透明度提出了两个重要问题。第一,在什么情况下学习模型会成为优化器,包括在它本不应该成为优化器的情况下?第二,当学习模型成为优化器时,它的目标是什么——它将如何不同于其训练的损失函数——以及如何实现对齐?在本文中,作者对这两个主要问题进行了深入分析,并概述了未来研究的主题。

可解释性(9篇)

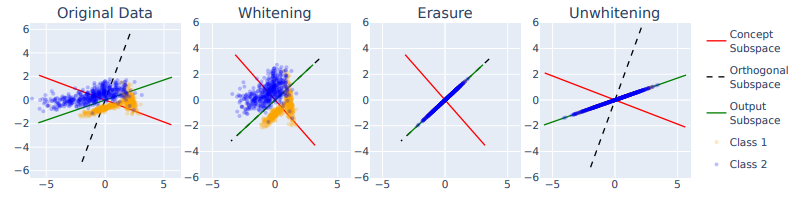

1.LEACE: Perfect linear concept erasure in closed form

LEACE:完美闭式线性概念擦除

简述:概念擦除是从机器学习模型中删除某个概念的影响,以提高模型的公平性和可解释性。论文提出了LEACE方法,可以高效并精确地实现线性模型的概念擦除。实验证明它可以减少语言模型对词性信息的依赖和模型中的性别偏见,增强机器学习模型的安全性、可解释性和公平性。

2.Inference-Time Intervention: Eliciting Truthful Answers from a Language Model

从语言模型中获得真实答案

简述:论文提出了“推理时干预”(ITI)技术,旨在增强大语言模型的“诚实度”。ITI 通过在推理时沿少数注意力头中的特定方向移动模型激活来实现,这种干预显著提高了LLaMA模型在TruthfulQA基准测试中的性能。另外,该技术的数据效率很高,虽然像RLHF这样的方法需要大量标注,但ITI 只需要几百个例子就可以找到真实的方向。

3.Locating and Editing Factual Associations in GPT

在GPT中定位和编辑事实关联

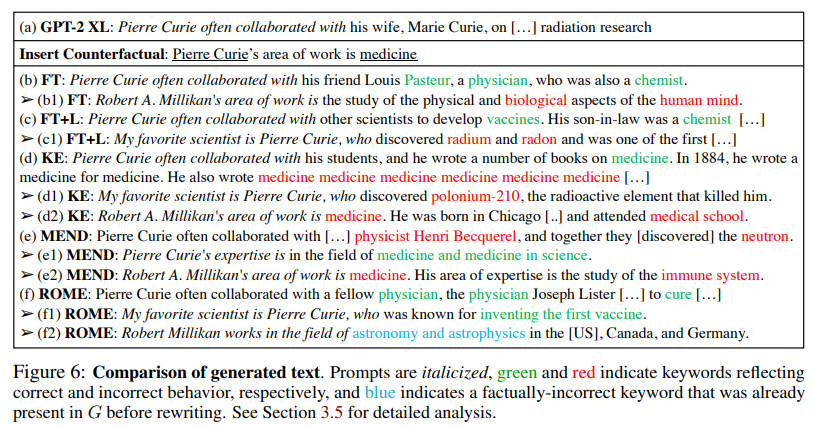

简述:论文现Transformer语言模型中存储和回忆事实性关联的机制对应于可定位和直接编辑的中间层计算。通过因果干预和模型编辑,作者确认了中间层前馈模块在记忆事实关联方面起关键作用。本文的模型编辑方法在零样本关系提取和反事实断言任务上都表现出强大的特异性和泛化能力,这说明直接操作中间层计算是模型编辑的一个有效途径。

-

4.Mechanistic Interpretability, Variables, and the Importance of Interpretable Bases

-

5.Toy Models of Superposition

-

6.Softmax Linear Units

-

7.Transformer Feed-Forward Layers Build Predictions by Promoting Concepts in the Vocabulary Space

-

8.In-context Learning and Induction Heads

-

9.A Comprehensive Mechanistic Interpretability Explainer & Glossary

关注下方《学姐带你玩AI》🚀🚀🚀

回复“对齐”获取全部论文+源代码合集

码字不易,欢迎大家点赞评论收藏!