★OpenAI;ChatGPT;Sam Altman;Assistance API;GPT4 Turbo;DALL-E 3;多模态交互;算力调度;算力调优;大模型训练;GH200;snowflake;AGI;AIGC;H100;A100;DGX Cloud 集群;Base Command;GPU算力;华为 Atlas 900 集群;NVIDIA NVLink;开发者大会

北京时间11月7日凌晨2点,OpenAI在旧金山举行的开发者大会吸引了全球的关注。在不到一小时的线上发布会上,OpenAI发布许多重磅消息,鼓励企业使用OpenAI的技术构建基于人工智能的聊天机器人和自主智能体。

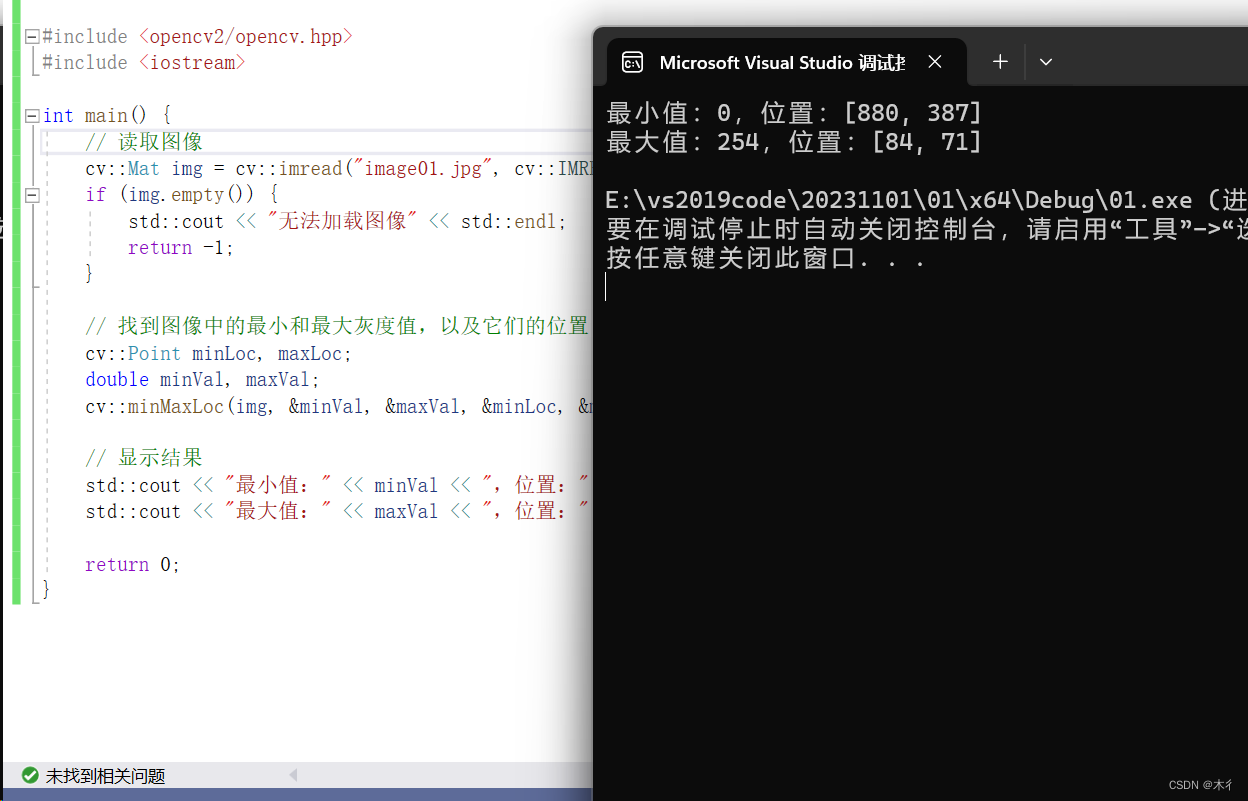

算力对训练模型的重要性日益凸显。随着大模型训练的流行,全球显卡和算力正在快速增长。算力后周期市场也在迅速崛起。其中“后”更多是指后服务市场,涵盖从显卡服务器到货IDC之后,形成稳定算力到输出稳定商业推理结果全过程。该过程主要涉及云化、调优、调度、部署、落地和数据管理等环节。

![]()

算力的后周期

大模型训练困难、商用成本高昂和安全问题担忧,催生算力后周期市场需求。大模型训练面临超大规模参数和运算量问题,需要解决显卡之间数据并行和运算合作,使得后周期需求如云化、调优、调度等应运而生。参数多则准确度高,而反应时间和消耗费用也愈增,开发者需要面对如何快速将新模型部署到应用场景问题。另外,大模型安全问题也令人担忧,需要考虑如何实现在保证数据安全的前提下,企业原有数据库与训练系统的相互调用,以及如何实现原有数据对“AI”训练的可用等。

全球算力后周期发展呈现出两个截然不同生态。在涉及算力使用和大模型训练等上层建筑时,整个行业对于资本支出、模型经验积累等方面的壁垒正在逐渐加深。大模型时代,天量资本支出已经成为入场券,模型研究从“巧夺天工”到“重剑无锋”的转变,使得大算力、大模型的壁垒不断提高,行业格局加速走向巨头通吃。

![]()

Buy More Save More 的典型代表 英伟达GH200 芯片

在商业落地、数据安全和平台可视化等模型下游环节中,北美创业公司展现出百花齐放的生态。在训练过程与资源可视化、数据库调用、模型加速部署与性价比调节等方面,涌现出一批优秀创业公司与解决方案。同时,原有领域龙头软件公司也在积极开发方案,对接AI需求。与大模型和算力战争中的巨头垄断不同,这个领域各个环节充满生机,更容易在细分环节中成长出新的优秀独角兽公司。

![]()

数据库巨头 Snowflake 与英伟达合作

随着国内算力资源增长和模型训练深入,对算力和模型层面的投资将重新聚焦。受海外算力制裁的影响,国内如昇腾等国产优秀生态发展和起量过程中,可能也将涌现出一批优秀的行业加速库、生态软件公司,扩展出具有中国特色的相关模型服务体系,走出一条有中国特色的模型服务体系之路。

OpenAI开发者大会亮点

OpenAI CEO Sam Altman在会上介绍了公司的一系列重要进展,包括推出新的GPT-4 Turbo模型,该模型具有更强大的功能、更长的上下文和更强的控制能力。同时,OpenAI还推出Assistance API,旨在简化开发者构建辅助代理。

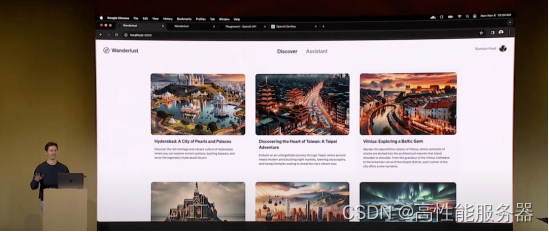

Altman强调自然语言将成为未来与计算机互动的重要方式,并展示通过对话编程GPT的能力。GPT商店即将推出,允许用户分享和发现创新的GPT应用,并提供收入分享激励。此外,OpenAI还与微软深化合作,展示新的文本到语音模型和改进的功能调用。

![]()

一、GPT4 Turbo发布

GPT-4 Turbo,在6个方面对GPT-4进行升级:

-

上下文对话长度:GPT-4 Turbo支持更长的上下文对话长度,达到128K,是GPT-4的16倍。

-

模型控制:采用新模型控制技术,使开发者更精细地调整输出,提升用户体验。

-

知识库更新:至2023年4月,比GPT-4的知识库新近2年。

-

多模态API:集成DALL-E 3、带视觉输入的GPT-4 Turbo和新的语音合成模型。

-

定制微调:允许开发者针对特定领域进行自定义微调。

-

更低价格和更高限制:价格更低但使用限制更高,输入输出token价格仅为GPT-4的1/3和1/2,每分钟限制提升一倍。

Sam Altman声称,GPT-4 Turbo可供所有付费开发者通过gpt-4-1106-preview API进行尝鲜,相关稳定版本预计将在未来几周内发布。

二、GPT Store将上线

定制版GPT可以根据用户日常生活、特定任务或工作需求提供个性化帮助,如学习棋类游戏规则、辅导孩子数学、提高写作能力或设计贴纸等。用户甚至可以与他人分享自己定制的GPT。

用户无需编程就可以创建自己的GPT,过程非常简单,只需给GPT输入指令和知识,然后选择其功能,例如网络搜索、图像生成或数据分析。定制GPT可以私人使用,也可以面向公司内部或制作公共通用版本。

OpenAI正在为ChatGPT Plus和企业版ChatGPT用户提供定制GPT示例,例如AI图像生成应用Canva和自动化平台Zapier。从本周三开始,企业版用户可以为特定客户、部门或数据集创建自己的ChatGPT,并可以授权内部用户无代码设计企业定制GPT,并安全发布到内部工作区。管理控制台可以选择如何在公司内共享这些GPT,以及是否允许使用外部GPT。

![]()

三、New GPT Draft

OpenAI表示,即使不会编程也可以制作GPT模型。只需与ChatGPT聊天,描述需求,就可以定制一个GPT模型,使GPT变得非常容易使用,可为每个人提供代理权,做想做的事。

四、全面的API助手

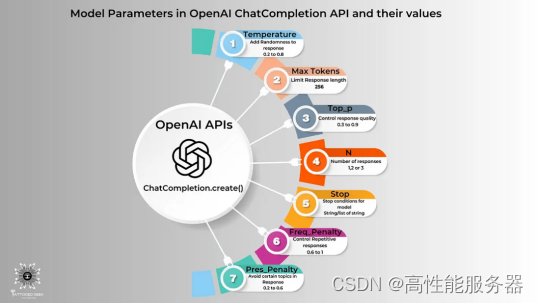

API是一种计算接口,规定了不同软件组件之间的交互方式、可进行调用或请求的种类、如何进行调用或请求,以及应使用的数据格式和应遵循的惯例等。

根据OpenAI公司的官方信息,目前使用GPT-4和GPT-3.5 Turbo上传750词的文档分别需要支付0.06美元和0.003美元(以最高速度计算)。在这次大会上,OpenAI还发布具有记忆功能的内存存储API,可以提高大模型的计算速度,并将开发者的API调用成本降低95%。

此外,OpenAI还发布专门的Assistants API,使开发人员可以更轻松地构建自己的辅助AI应用,调用模型和工具以实现自己的目标。

Assistants API 提供代码解释、检索和函数调用等新功能,帮助开发者处理繁重工作,从而构建高质量AI应用。OpenAI介绍,这种API是为了灵活性设计,用例范围广泛,包括基于自然语言的数据分析应用、编码助手、AI驱动的假期规划器、语音控制DJ、智能视觉画布。Assistants API功能和新GPT产品相同,都支持自定义指令和一些工具,例如代码解释器、检索和函数调用。

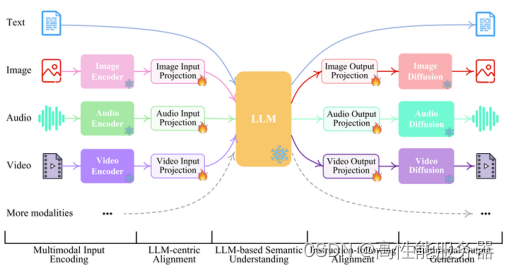

五、多模态交互

新版本GPT增加多模态功能,包括视觉、图像创建和文本转语音。GPT-4 Turbo可以接受图像作为输入,从而实现生成标题、分析现实世界图像和阅读带图形文档等用例。视觉输入的定价根据图像大小而定。

此外,OpenAI计划为主要GPT-4 Turbo模型提供视觉支持。对于新版本GPT付费用户,主要功能更新包括更方便地上传多种格式文件,如PDF、数据文件等(未来将支持更多文件类型)。

GPT-4 Turbo的不同模式具有不同优势和功能短板,其中多模态模式可以同时处理文本、图像、声音等多种类型数据,但仅支持图片上传;数据分析模式具备较强的数据处理和分析能力,但不能实时联网;实时联网模式和DALL-E则不支持文件上传。在旧版本中,用户需要自己选择模式;在新版本中,GPT-4 Turbo将根据用户需求自动选择和编排多个工具完成任务,向AI智能体角色迭代。

云化-调优-调度

巨头战场,技术为骨,通信为魂

一、算力云化:算力租赁势起,被 AI 重定义的云计算

1、AGI 时代到来,GPU 算力需求爆发,云计算面临新挑战

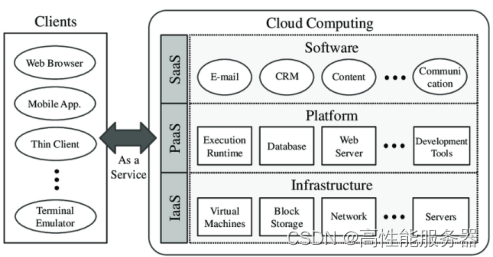

云计算是科技行业过去十年发展最迅速领域之一,推动全球数字化程度持续提升。随着互联网高速发展和众多中小型及初创公司对数字化需求爆发,自购ICT基础设施投入巨大且运维难度高,不适合具有灵活需求高速发展长尾客户。而通过云计算,用户可以随时获取云上资源,按需使用按需付费,可无限扩展。云计算将计算资源池化,通过软件实现自动化管理,提高资源利用效率,并发展出IaaS、PaaS、SaaS等多种形式,极大地促进互联网发展和全球数字化进程。

云计算原理图

随着OpenAI ChatGPT引领的生成式AI的崛起,算力需求正在从CPU向GPU跃迁。企业人工智能发展需求爆发,需要支持开发人员创建新一代人工智能应用程序的基础设施。许多企业转向云计算,采用越来越复杂的基础设施,从GPU到GPU集群,以满足人工智能模型训练需求。

CPU 和 GPU 的对比

随着大模型的持续发展,如OpenAI的GPT-3拥有1750亿个参数,规模前所未有,模型迭代需要更大规模。对于大模型训练而言,高速互联的高性能GPU集群是关键门槛,不仅涉及GPU本身,还包括GPU之间高速互联以及与交换机、光模块等基础设施的互联。与此相比,以CPU和存储服务器为主传统基础设施明显不够,资本开支和技术难度也明显提升,抬高了进入大模型的门槛。

英伟达 H100 集群

大模型训练需要大规模GPU集群进行数月连续训练,同时产生大量计算和数据交换需求。与此相比,传统CPU和存储集群的内部通信互联要求明显提高。在传统云计算时代,高速光模块和高端交换机只在超大型数据中心核心节点使用,例如400G和对应的光模块。但在超算集群中,使用H100集群,第一层便使用400G光模块,向上则使用800G光模块和相应交换机,网络互联要求明显提高。

英伟达 DGX A100 与 DGX H100 互联结构

随着基础设施日益复杂,宕机风险增加,维持运行需耗费更多精力和资源。开发人工智能不仅需要基础设施服务,更需要全栈能力。企业需将所有功能集成到平台中:

1)用于开发和部署端到端人工智能工作流的框架和工具,涵盖数据准备、训练、推理和部署。

2)面向开发人员的平台,管理从简单计算机视觉应用到复杂大型语言模型的所有内容。

3)智能编排层和调度程序,为每个作业提供适当资源,动态回收和重新分配资源。

4)自动化基础设施管理,优化平台性能和正常运行时间,确保每项工作无忧执行。

5)超高带宽、低延迟网络集群,专为多节点训练设计,可在多个加速计算节点上并行处理大型人工智能模型。

2、DGX Cloud 发布,云算力进入 GPU 新时代

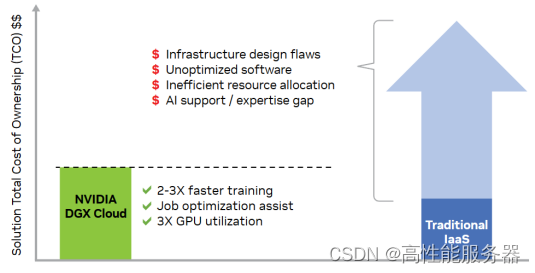

英伟达于2023年3月21日发布的DGX Cloud改变传统计算框架,为现代深度学习提供理想环境。DGX Cloud结合人工智能和云计算,旨在为企业提供最先进的AI训练服务。该平台采用NVIDIA DGX SuperPOD架构,具备分布式训练能力,其速度较不支持NVIDIA网络的服务快两倍以上。

![]()

英伟达 DGX Cloud 集群

英伟达的DGX Cloud为现代AI开发树立新的标杆,是世界上第一个专用于开发生成式人工智能的平台。DGX Cloud是英伟达针对传统IaaS产品在AI时代面临的困境而推出的产品,其使用效率是传统基础设施的三倍。DGX Cloud集成NVIDIA基础命令平台,简化人工智能开发的过程。

![]()

NVIDIA DGX 云人工智能软件堆栈

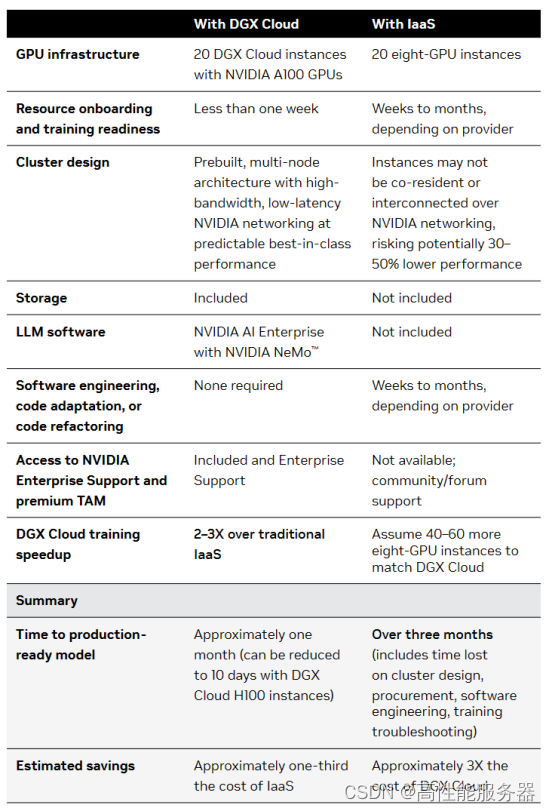

DGX Cloud在传统IaaS上展现出全面领先优势。其基于NVIDIA DGX技术,为各行业创新提供加速解决方案。通过DGX Cloud,企业可专注于人工智能创新,无需纠缠于基础设施。企业能够获得可靠、快速的资源分配,完全优化执行工作负载,并减少所需时间和精力,从而降低总体拥有成本。根据英伟达官网的比较,DGX Cloud相比传统IaaS服务具有2-3倍的训练速度优势和三倍的GPU利用率提升。

NVIDIA DGX 与传统 IaaS 比较优势明显

![]()

NVIDIA DGX 与传统 IaaS 比较优势明显

3、现状:GPU 禁令,国产算力进程加速,合理分配利用资源重要性突显

根据英伟达2023 年 10 月 23 日向 SEC 提交的 8-K文件,美国政府已通知英伟达,对总处理性能为4800或更高的数据中心设计或销售产品实施新的出口管制,并适用于题为“实施附加出口管制:某些先进计算项目;超级计算机和半导体最终用途;更新和更正”的法规。受影响的产品包括 A100、A800、H100、H800 和 L40S,这些产品于 10 月 17 日被要求在 30 天后禁售。

随着高端算力芯片禁令生效,国内AI产业发展受到制约。华为、寒武纪、海光、壁仞、摩尔线程等国产算力芯片的商业化和生态建设有望加速。科大讯飞与华为昇腾已启动专项攻关,合力打造通用人工智能新底座,华为昇腾910B能力已基本可对标英伟达A100。

![]()

华为 Atlas 900 集群

5、跨区域、跨集群、跨架构的算力调度调优能力日益重要

在大规模训练中,相比传统云计算,需要考虑的问题更为复杂。如何利用多卡突破内存限制?如何实现大量计算资源的通信和协作?如何将各种大规模训练技术整合成一个完整高效的方案?因此,大规模训练技术的挑战可归纳为内存、通讯、计算和调优四个方面。

![]()

大模型训练四大挑战

在大模型训练中,数据和算力是最核心的两个要素。过去AI的发展方向是使用少量数据和参数来构建模型,而现在随着OpenAI现象级产品出现,人们发现使用海量数据和算力训练模型能力有了质的飞跃。目前大模型还处于早期阶段,未来大模型的发展将主要集中在提高参数数量和提升算力集群规模上。

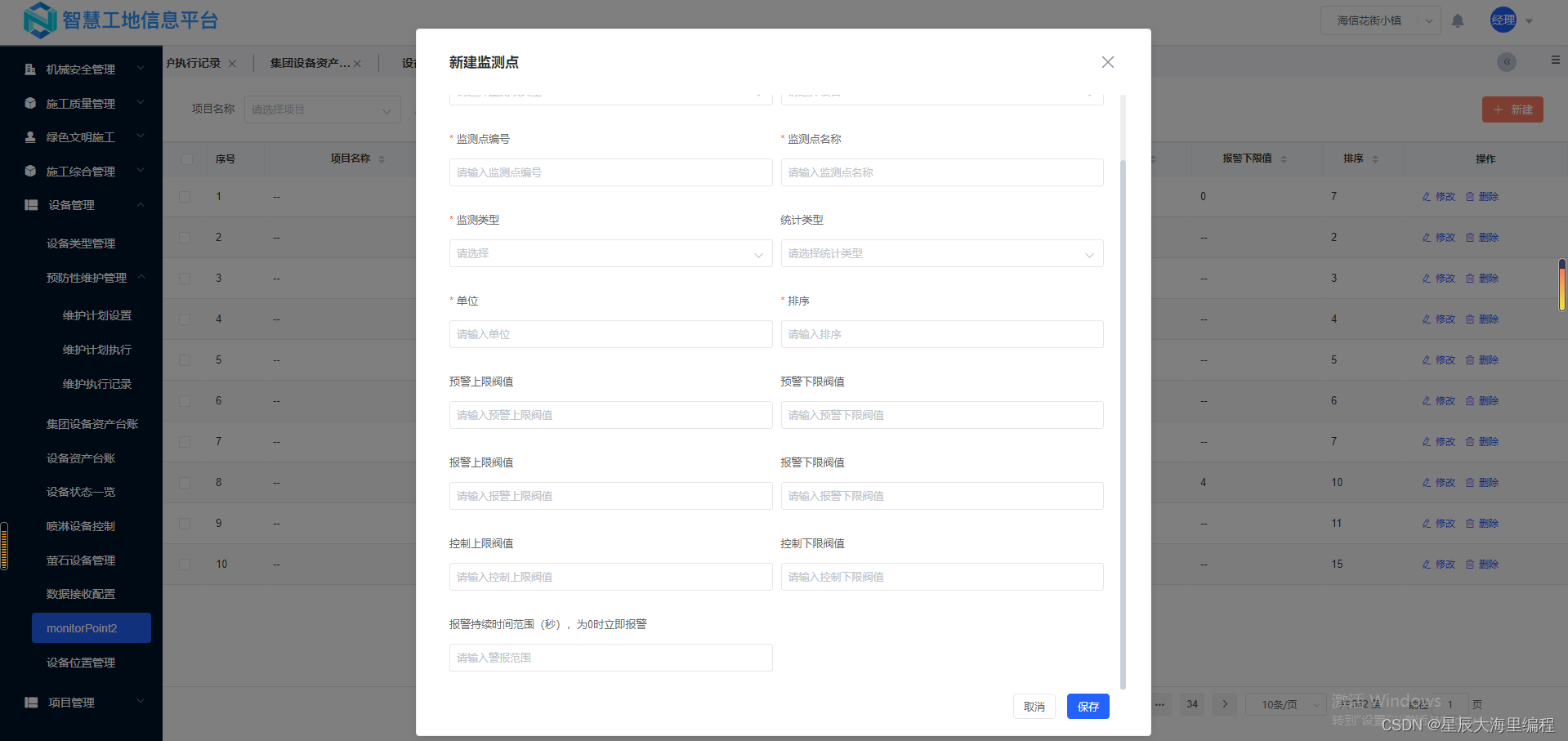

英伟达作为全球GPU领军企业,很早就开始布局AI领域。回顾英伟达超算方案,从DGX A100到DGX H100,再到最新的DGX GH200,除GPU算力提升外,通信能力的大幅持续增长也非常明显。在AI领域中,通信作用的重要性不亚于计算能力。英伟达早在2019年就收购网络交换公司Mellanox,以增强其在数据中心网络交换领域的实力,这充分体现了英伟达的超前眼光和对通信的重视。

以GH200为例,其NVLink提供高达900GB/s双向带宽,单向带宽为450GB/s。当8张卡一起使用时,总带宽高达28.8TBps。这些带宽分摊到三个NVLink Switch上,每个Switch的上下行带宽为9.6TBps。这意味着,对于800G的光模块来说,每个Switch需要24只。一台服务器中共有72只800G光模块,GPU与800G光模块的比例为1:9。相比之下,DGX H100架构的GPU与800G光模块比例约为1:3,而DGX A100主要使用400G光模块。从英伟达产品的迭代可以看出,公司在通信方面持续发力,以匹配计算能力的提升。

![]()

英伟达 DGX GH200,256 个 GPU 组成的完全连接的 NVIDIA NVLink 交换机系统拓扑结构

要高效发挥算力集群能力,打破通信墙是唯一的选择。随着集群中显卡数量的增长,如果算力不能线性提升,就无法充分利用高价购买的GPU能力。目前,最佳的方式是通过高速互联打破通信墙,允许万卡规模集群中的跨GPU数据交换,保证数据交换畅通无阻。提高通信能力是目前最有效的“调优”方式,无论多么出色的调度和调优,都无法比拟使用高性能交换机和高速光模块构建的集群内部“高速公路”。

此外,跨架构、跨集群的算力调度也是一个现实问题。跨区域算力调度需求也在增长,例如东数西算等。在模型训练层面,调优也是一个重要方面。

二、算力调优:大模型时代,通信即调优

1、算力调优是算力发展的终身课题

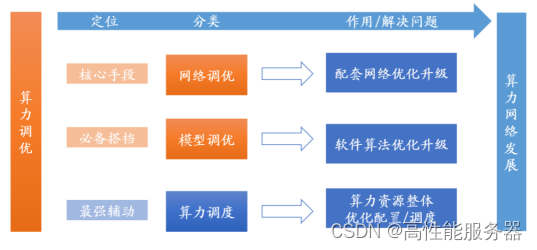

算力调优本质上是将有限的算力资源进行重新配置并达到最优状态。在微观层面,算力调优关注模型调优,包括减少模型训练和推理时占用的显存。在宏观层面,算力调优涉及模型调优、网络调优和算力调度三个层次。其中,网络调优在大规模分布式并行训练背景下愈发重要,高性能网络应具备超大规模、超高带宽和超长稳定三大性能。算力调度则是将算力作为资源进行优化分配,解决算力资源供需不匹配问题。

![]()

三大算力调优措施针对解决不同的算力问题

算力发展带来三个重大变化,这促使算力调优成为核心议题。这三个变化分别是:算力需求总量的增加、算力需求的扩散和算力需求的多样化。

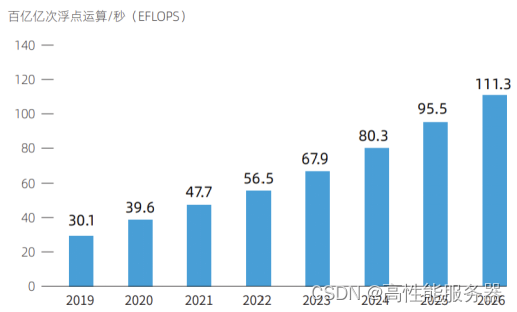

1)随着5G和AI等产业的快速发展,通用算力和智能算力需求都在不断增加。

通用算力需求因各种应用逐渐兴起而提升,同时大数据、智能汽车、智慧城市、物联网等新业态新平台出现也加大了通用算力的需求量。而智能算力需求随着AIGC产业的迅速发展,国内大模型训练和推理的快速推进,智算成为大模型落地不可或缺的生产力之一,需求空间巨大。据IDC和浪潮预测,到2026年,国内通用算力规模将达到111.3EFLOPS,智能算力规模将达到1271.4EFLOPS。

![]()

2019-2026 中国通用算力规模及预测

2)算力需求最初主要集中在单一设备上,如计算机和工业智能设备等。但随着5G和AI时代的到来,海量数据已经扩散到各类设备上,如汽车、公路、城市智慧屏等各类终端都需要数据处理能力。

3)随着数字经济的崛起,算力需求逐渐走向多元化。自动驾驶的算力需求主要集中在高性能、低延迟和实时性上;而生成式AI的算力需求则需要大量GPU并行计算,主要集中在稳定长时间输出能力上;边缘计算的算力需求主要在于短距离和低时延。

2、网络调优:算力调优的核心手段

1)源起:从 GPU 的通信出发

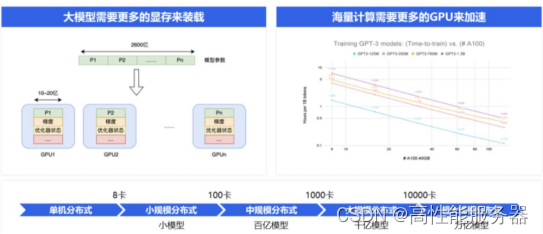

在AI时代GPU成为核心处理器,广泛应用于图像图形处理和AI推理。然而,随着大模型复杂度不断提升,单卡GPU显存有限,难以满足训练需求。例如,百度文心一言大模型拥有2600亿个参数,而一个80GB显存的A800只能存储10-20亿参数,因此需要100-200块GPU来存放2600亿的模型。此外未来大模型训练将需要更多的参数和计算,进一步增加GPU需求。为适应算力需求,多张GPU甚至多台服务器需要联合工作,分布式训练成为核心训练方式。

![]()

大模型发展下对分布式训练诉求提升

网络连接在分布式系统中发挥重要作用,根据连接层级可分为单卡、多卡和多机互联。单卡内的网络为计算用的神经网,多卡之间的连接通常采用PCIe或高带宽通信网络,而多机之间的连接则通常采用RDMA网络。

-

多卡互联:传统 PCIe 与 NVLINK/CAPI/GenZ/CCIX/CXL 的“百家争鸣”

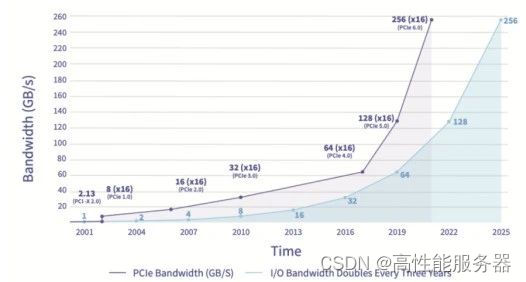

总线是数据通信中必不可少的通道,PCIe是最广泛使用的总线协议。总线是服务器主板上不同硬件之间进行数据通信管道,对数据传输速度起到决定性作用。PCIe协议由英特尔于2001年提出,主要用于连接CPU与其他高速设备如GPU、SSD、网卡、显卡等。PCIe经历多个版本的更新,传输速率和带宽不断提高,目前已经更新到6.0版本,传输速率高达64GT/s,16通道的带宽达到256GB/s。

![]()

PCIe6.0 版本的带宽大幅提高

随着AIGC的发展,算力需求大幅增加,GPU多卡组合成为趋势。然而,PCIe的数据传输速率和网络延迟无法满足这种需求。为提高总线通信效率和降低延迟,各家纷纷推出替代协议。

CAPI协议最早由IBM推出,本质上是在现有高速I/O标准之上的应用程序扩展,增加缓存一致性和更低延迟等内容。但由于IBM服务器份额的持续下降,CAPI协议缺少用户基础,最终未能广泛流传。

GenZ协议是一个不依赖于任何芯片平台的开放性组织,众多厂家参与其中,包括AMD、ARM、IBM、Nvidia、Xilinx等。GenZ将总线协议拓展成交换式网络并加入GenZSwitch,提高拓展性。

CXL协议于2019年由Intel推出,与CAPI协议思路类似。2021年底吸收了GenZ协议共同发展,2022年兼并了OpenCAPI协议。CXL具备内存接口,逐渐成长为设备互连标准的重要主导协议之一。

CCIX协议是ARM加入的另一个开放协议,功能类似GenZ但未被吸收兼并。

NVLINK协议是英伟达提出的高速GPU互联协议,相比传统PCIe总线协议,NVLINK在三个方面做出重大改变。首先支持网状拓扑结构,解决通道数量有限问题;其次统一内存,允许GPU共享公共内存池,减少GPU之间复制数据需要,提高效率;最后支持直接内存访问,不需要CPU参与,GPU可以直接读取彼此内存,从而降低网络延迟。此外,为解决GPU之间通讯不均衡问题,英伟达还引入NVSwitch,一种类似于交换机ASIC的物理芯片,通过NVLink接口将多个GPU高速互联,创建高带宽多节点GPU集群。2023年5月29日,英伟达推出AI超级计算机DGX GH200,通过NVLink和NVSwitch连接256个GH200芯片,所有GPU连接成一个整体协同运行,可访问内存突破100TB。

-

多机互联:IB 网络与以太网络并存

在分布式训练中,RDMA网络成为最佳选择,包括IB网络和以太网络。传统的TCP/IP网络通信通过内核发送消息,涉及较多数据移动和复制,不适合高性能计算、大数据分析等需要高并发、低时延场景。RDMA是一种计算机网络技术,可直接远程访问内存数据,无需内核介入,不占用CPU资源,可显著提高数据传输性能并降低延迟,适合大规模并行计算机集群网络需求。

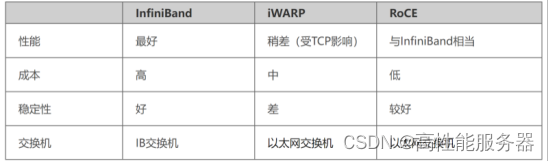

目前有三种RDMA:Infiniband、RoCE和iWARP,后两者基于以太网技术。Infiniband是专为RDMA设计的网络,从硬件级别保证可靠传输,成本高但带宽和延迟更优;RoCE基于以太网做RDMA,可使用普通以太网交换机,成本较低但需要支持RoCE的网卡;iWARP基于TCP的RDMA网络,利用TCP达到可靠传输,在大型组网中会占用大量内存资源,对系统规格要求更高,但也可使用普通以太网交换机并需要支持iWARP的网卡。

![]()

RoCE 、iWARP和 InfiniBand 比较

3)现状:AI 的网络新需求

AI大模型训练和推理对网络提出超大规模、超高带宽和超长稳定的需求。超大规模的模型直接影响训练速度,使用更多的GPU可以缩短训练时间。超高带宽的Allreduce直接影响大规模分布式下的整体效率,高带宽可以获得更高的加速比。

大模型训练时长通常至少为几个星期,稳定性非常重要,包括GPU可用性和网络可用性。在千卡规模下,如果GPU的月可用性为99.9%,模型训练一月内遇到故障发生中断的概率较高。网络可用性对于大模型的训练至关重要,包括数据集的读取以及训练过程中checkpoint的读写,必须保证更高的可用性以减少模型训练中断。因此,在大规模分布式AI训练中,需要使用更多的GPU和更高的带宽,并确保网络的可用性和稳定性。

OpenAI 在训练过程中使用 checkpoint 来保证连续性。Checkpoint 是训练过程中保存的已训练模型在特定时间点的版本,包含模型的权重、参数和其他重要信息。加入 checkpoint 后,即使训练中断,也可以随时回到并使用已保存 checkpoint 处的模型,而无需从头开始训练。此外,checkpoint 还可以提高实验的可重现性、进行模型评估以及实现迁移学习等功能。

4)未来:网络为主,可视化为辅

面对AI大模型对算力网络通信提出的新需求,提升网络通信能力是核心,同时需要辅助智算可视化等硬件。三大需求(超大规模、超高带宽和超长稳定)都强调网络通信能力的提升。优化过程中,网络可视化等核心硬件也起到重要作用。

在算力集群中,无论使用以太网还是InfiniBand协议构建通信网络,数据都以包的形式传输。为监控网络流量,避免拥堵或硬件故障影响系统效率,需要实时监测每条通信链路的状态。如在三层网络架构中,有一种名为DPFR(Data Plane Fast Recovery)的经典优化方法,可以实现毫秒级收敛。DPFR分为本地快速收敛和远端快速收敛。本地收敛是指叶交换机掌握指挥权,可以自行选择要访问的脊交换机;远端收敛是指脊交换机掌握指挥权,如果该交换机南向通道故障,脊交换机可以向正常运行的叶交换机发送故障报文,指挥叶交换机切换线路。

![]()

DPFR 本地快速收敛(上)和远端快速收敛(下)

网络调优的核心是利用软件或硬件技术抓取数据包进行分析。数据包嗅探抓取分为软件实现和硬件实现两种方式。常用的软件实现包括Wireshark(处理TCP/UDP)、Fiddler(处理HTTP/HTTPS)、tcpdump&windump、solarwinds、nast、Kismet等。

软件抓包会消耗部分系统性能。首先,混杂模式下的网卡处于“广播模式”,需要处理网络下层收发的所有数据包,这本身就会消耗一部分网卡性能。其次,软件抓包需要复制和存储数据包,会占用一部分CPU和存储资源。同时,像Wireshark这种软件大多只能监控系统内单一网络节点的流量,难以覆盖全局网络,更适合被动故障排除作业,而不适用于主动风险监测。

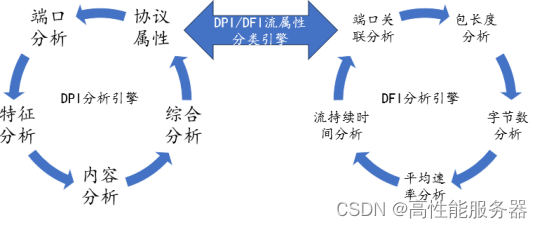

为确保不影响系统整体性能,并行或串行接入的软硬件结合工具应运而生,其中常用的包括DPI和DFI。DPI(深度报文检测)是一种基于报文应用层信息进行流量检测和控制的功能,着重分析应用层,能够识别各种应用及其内容。当IP数据包、TCP或UDP数据流经过支持DPI技术硬件设备时,设备会深入读取报文载荷进行分析和重组,识别应用程序内容,然后根据设备定义的管理策略对流量进行后续处理。DFI(深度/动态流检测)采用基于流量行为应用识别技术,即不同应用类型在会话连接或数据流上的状态各不相同。DPI技术适用于需要精细和准确识别、精细管理的环境;而DFI技术适用于需要高效识别、粗放管理的环境。

DPI 和 DFI 的流程比较

DPI/DFI由独立硬件串/并接在物理层,对物理层性能无影响。以浩瀚深度的DPI软硬件产品为例,可部署在电信网络各层级节点,通过SaaS/PaaS实现数据收集、分析和呈现。DPI硬件串接或并接在通信物理层,通过镜像数据包实现无损网络监测。DPI软件可嵌入DPI硬件、独立服务器或交换机/路由器中,实现网络监测。

网络可视化是一种高效流量监控工具。通过SaaS/PaaS,可以实现对各层级DPI监测节点的数据收集、分析和呈现,将这些网络数据以客户和应用所需的方式展示出来,帮助用户准确掌握网络运行情况以及其中的有价值信息。结合大数据分析与挖掘、多维度数据关联分析、流量控制和管理等手段,实现网络管理、信息安全和商业智能的一类应用系统,通常称为网络视化。

5)模型调优

模型层面调优和软件层面调优不同于传统性能优化,如游戏或软件的优化。在当前模型快速迭代、参数竞争激烈的情况下,削减参数、减少GPU集群训练时间或算力总量并不是主要关注问题。头部玩家更关心如何让重金投入的GPU集群充分发挥其算力,以实现更快模型迭代和参数扩展。因此,模型层面的调优可以理解为如何通过设计模型架构来最大化GPU性能,而非压缩非必要环节以节省算力。

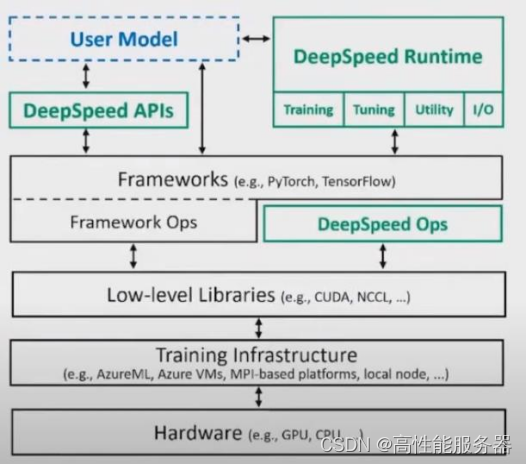

AI模型训练主要基于Tensor Flow和PyTorch两个框架。这些框架提供AI训练所需的操作系统、工具和运算流程,同时也提供优化GPU使用的完善框架。模型训练过程类似于生产线,每层训练步骤对应生产线上一个工序。优化GPU使用的方法主要是并行处理,即对流水线任务进行分配或优化。

模型层面的并行主要有两种:数据并行和模型并行。数据并行是指将一层模型运算所需的数据分配到多张显卡上进行计算,然后汇总结果进行下一层运算。而模型并行是将一次训练所需的多个运算步骤分别放在多张显卡上进行计算,但随着模型体积不断增大,单个显卡难以承载完整的计算任务,因此模型并行正在逐渐被数据并行所取代。数据并行的瓶颈在于数据的实时切分和通信,进一步突显了通信能力的重要性。

![]()

数据并行

除框架或训练原理自带并行能力外,专用训练调优工具也进一步方便用户使用。目前,全球模型训练者主要使用微软提供的开源工具库DeepSpeed来进行训练调优。DeepSpeed通过预处理训练数据等方式,优化了数据进入GPU的效率和所需空间,从而为发挥GPU集群性能或提高小GPU训练上限提供解决方案。

DeepSpeed

利用框架和DeepSpeed两大工具进行模型调优后,积累的经验将加深各大模型厂商的训练能力壁垒,提高训练效率和性能。随着大模型时代的到来,模型算法层面的优化和算力、金钱性价比的追求日渐式微,而重参数、数据、算力堆叠被认为是通向AGI的必经之路。因此,模型层面的进化更多地发生在如何更好地调用GPU算力的训练系统和工具库层面。

三、算力调度:全局最强辅助

1、算力调度是什么?

算力调度是将算力作为资源进行分配和优化的过程,实现算力灵活流动,解决算力供需矛盾、网络传输问题和资源普惠问题。根据供给能力和动态需求,进行算力资源整合和分配,涉及基础设施底层计算、存储、网络等多维资源统一管理和调度。

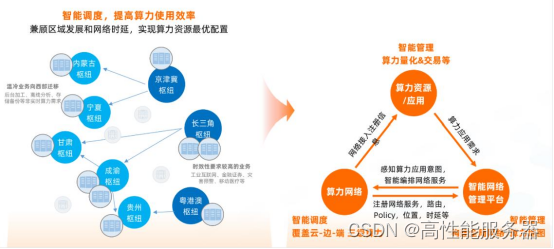

![]()

智能调度和智能管理算力量化&交易图

2、算力在哪里调度?

算力调度适用于多种场景,包括云与云之间、云和数据中心之间、云网端之间,以及按行业、地区、层级划分。其中,跨区域调度和跨层级调度是较为典型的两个场景。跨区域调度是指实现东西部算力协同,打通需求估计不足的算力资源,以实现算力资源跨区域调度。而跨层级调度则是指将算力资源协调应用于云、边缘、终端等不同层级,实现算力灵活调度和优化分配。

![]()

算力调度场景分布

3、如何实施?

算力调度目前尚处于逐步落地阶段,具体实施步骤有待在执行中逐渐完善。根据算力分布分散、需求具备多样性和灵活性等特质,通常算力调度需要包含三个核心步骤:

1)整合多元异构资源

对底层算力资源进行标准化,建立度量模型和评估标准,摸清算力调度区域的设施和资源情况,整合不同所有方的闲置资源;

2)搭建算力调度平台

整合实时感知、供需匹配、智能调度、服务运营和监测管理等多种功能,根据资源分布情况动态计算最佳调度策略,实现统一的算力交易和售卖;

3)建立标准规范体系

包括算力交易、管理和安全规则,涉及产品定价、自动结算、账本记录、权利义务和可信服务机制。

4、谁在参与?

算力调度平台作为算网大脑,在算力发展中后期的重要性将进一步提升。目前,国内已经涌现多个算力调度平台,按主导方可分为四大类,其中运营商算力调度平台的基础能力较为显著。这些平台包括电信运营商主导平台、地方政府主导平台、企业主导平台和行业机构主导型平台。不同平台的优势和特点各不相同,但都致力于整合和优化算力资源的分配。

其中,中国电信、中国移动、中国联通等运营商在算力调度方面具有强大的网络基础设施和资源整合能力,能够实现算力资源的高速互联和数据传输的稳定运行。此外,一些互联网和科技巨头企业也在算力调度方面进行了积极探索和实践,如阿里云、中科曙光等。同时,行业机构也在推动算力调度平台的发展,如中国信通院联合中国电信发布的一体化算力算网调度平台等。

软件服务

海外先行,百花齐放,部署先行

软件服务的三个方向:数据管理、模型落地、训练可视化

一、数据管理

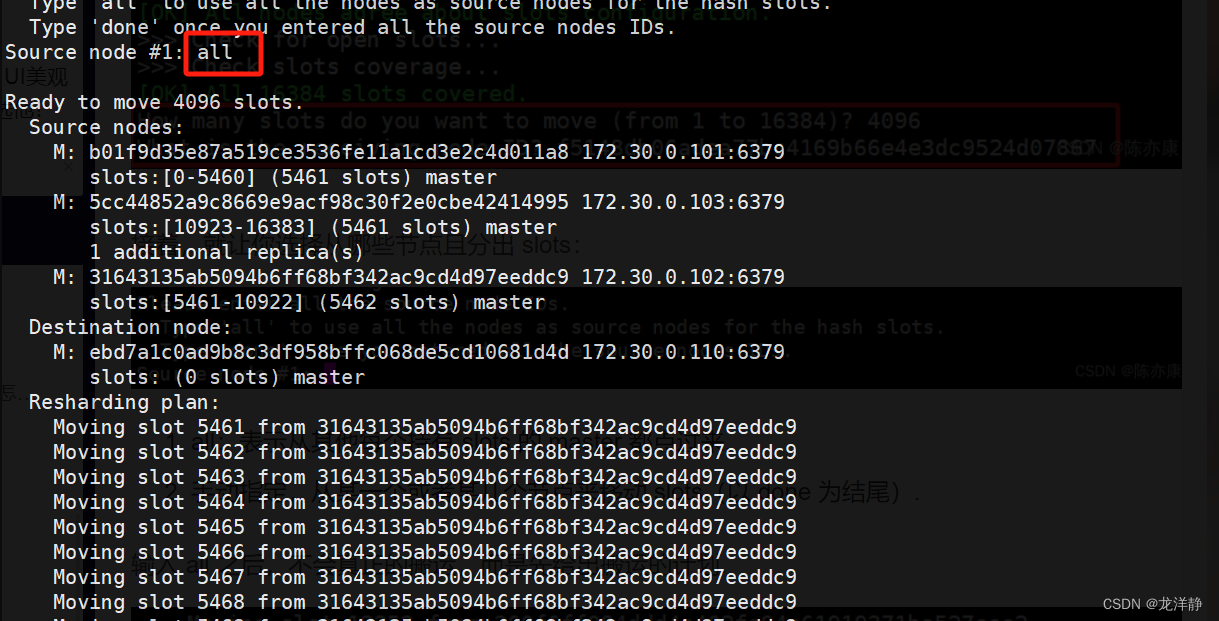

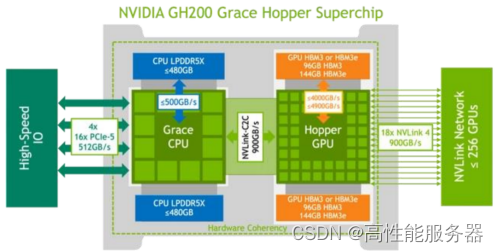

模型微调的基础是优质、结构化的数据管理,推动大模型训练向高精度、高安全和垂直专业化发展。现有的开源 LLM 是“预训练模型”,即已收集大量训练数据并提前训练模型,如 NVIDIA NeMo 和 MetaLlama 能流利使用各种语言,对各种话题有一定了解,但受训练数据限制,对某些专业领域不够深入。以 Snowflake 为例,该平台支持客户使用自己的数据集进行模型的进一步训练和微调,以保证定制的模型在特定领域做到专精。Snowflake 子公司 Applica 凭借 TILT(Text-Image-Layout-Transformer)模型,专精于智能文档。

二、模型落地

Modular Mojo 是一种下一代设计模型和加速库设计语言。其通过创建 Mojo 编程语言,利用 Python 的语法和社区生态,以及 MILR(一种开源编译器),针对 AI 开发中的异构计算和 Python 的多线程编译问题进行优化。

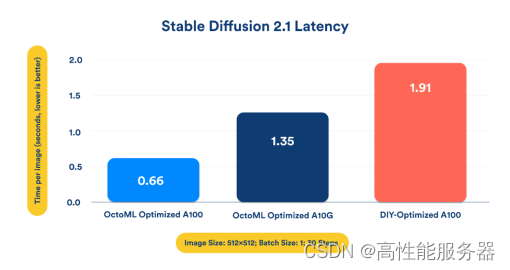

OctoML 是一种模型部署工具,能够快速实现成品模型在各种算力设备上的优化和部署。以 OctoML 部署的 Stable Diffusion 为例,OctoML 利用机器学习优化技术能够实现三倍的推理速度,支持快速模型微调。

OctoML 优化多 GPU 部署和连续批处理,Llama2 实现 3 倍性能提升。随着大模型参数量增加,GPU 负载并非线性增长,而是呈指数增长。因为参数数量的提升带来多 GPU 并行计算问题和大模型最为经典的 KV 缓存问题。针对这些问题,OctoAI 进行优化。

OctoAI 多 GPU 跑分结果

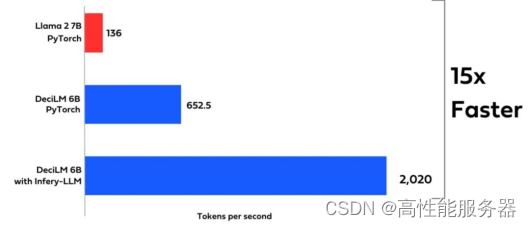

Deci 致力于模型部署层面的优化和小模型功能的提升。DeciLM 解码器的 Transformer 具备可变的 Grouped-Query Attention(GQA)能力,即能够改变不同 Transformer 层的 attention 组、键值和数值的数量。DeciLM 是首个在 Transformer 层结构上实现互不重复的语言模型。60 亿参数的 DeciLM 模型在性能上超越 PyTorch 的 70 亿参数 Llama2。

![]()

DeciLM 与 Llama2 在 token 生成上的性能对比

三、训练可视化

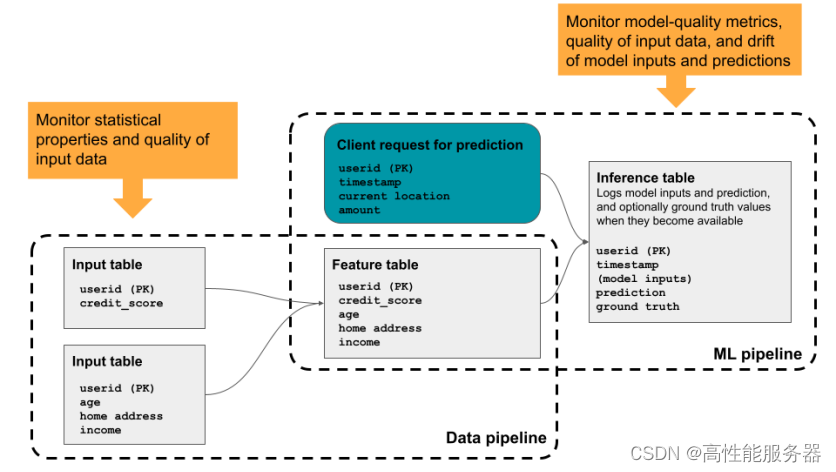

Databricks 是一款 GPU 资源管理工具,提供模型和训练进度的可视化功能。其核心业务是将数据湖和数据仓库统一到一个平台,即湖仓一体。与 Snowflake 类似,在数据库功能实现方式上存在一定的差异。通过 Lakehouse AI 的算力集群资源管理,开发者可以更好地进行模型训练和推理的监控。Databricks Lakehouse Monitoring 通过监控数据管道和训练管道来实现 LLM 的性能和质量管理,并创建可视化界面。

Databricks Lakehouse Monitoring 帮助开发者监控模型的训练推理

蓝海大脑大模型训练平台

蓝海大脑大模型训练平台提供强大的算力支持,包括基于开放加速模组高速互联的AI加速器。配置高速内存且支持全互联拓扑,满足大模型训练中张量并行的通信需求。支持高性能I/O扩展,同时可以扩展至万卡AI集群,满足大模型流水线和数据并行的通信需求。强大的液冷系统热插拔及智能电源管理技术,当BMC收到PSU故障或错误警告(如断电、电涌,过热),自动强制系统的CPU进入ULFM(超低频模式,以实现最低功耗)。致力于通过“低碳节能”为客户提供环保绿色的高性能计算解决方案。主要应用于深度学习、学术教育、生物医药、地球勘探、气象海洋、超算中心、AI及大数据等领域。

构建基于英伟达GPU的全场景AI基础设施方案,适用于“端、边、云”等各种应用环境。帮助开发者更快速、更高效地构建和部署AI应用。

![]()

一、为什么需要大模型?

1、模型效果更优

大模型在各场景上的效果均优于普通模型。

2、创造能力更强

大模型能够进行内容生成(AIGC),助力内容规模化生产。

3、灵活定制场景

通过举例子的方式,定制大模型海量的应用场景。

4、标注数据更少

通过学习少量行业数据,大模型就能够应对特定业务场景的需求。

二、平台特点

1、异构计算资源调度

一种基于通用服务器和专用硬件的综合解决方案,用于调度和管理多种异构计算资源,包括CPU、GPU等。通过强大的虚拟化管理功能,能够轻松部署底层计算资源,并高效运行各种模型。同时充分发挥不同异构资源的硬件加速能力,以加快模型的运行速度和生成速度。

2、稳定可靠的数据存储

支持多存储类型协议,包括块、文件和对象存储服务。将存储资源池化实现模型和生成数据的自由流通,提高数据的利用率。同时采用多副本、多级故障域和故障自恢复等数据保护机制,确保模型和数据的安全稳定运行。

3、高性能分布式网络

提供算力资源的网络和存储,并通过分布式网络机制进行转发,透传物理网络性能,显著提高模型算力的效率和性能。

4、全方位安全保障

在模型托管方面,采用严格的权限管理机制,确保模型仓库的安全性。在数据存储方面,提供私有化部署和数据磁盘加密等措施,保证数据的安全可控性。同时,在模型分发和运行过程中,提供全面的账号认证和日志审计功能,全方位保障模型和数据的安全性。

三、常用配置

1、CPU:

-

Intel Xeon Gold 8358P 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

-

Intel Xeon Platinum 8350C 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

-

Intel Xeon Platinum 8458P 28C/56T 2.7GHz 38.5MB,DDR4 2933,Turbo,HT 205W

-

Intel Xeon Platinum 8468 Processor 48C/64T 2.1GHz 105M Cache 350W

-

AMD EPYC™ 7742 64C/128T,2.25GHz to 3.4GHz,256MB,DDR4 3200MT/s,225W

-

AMD EPYC™ 9654 96C/192T,2.4GHz to 3.55GHz to 3.7GHz,384MB,DDR5 4800MT/s,360W

2、GPU:

-

NVIDIA L40S GPU 48GB

-

NVIDIA NVLink-A100-SXM640GB

-

NVIDIA HGX A800 80GB

-

NVIDIA Tesla H800 80GB HBM2

-

NVIDIA A800-80GB-400Wx8-NvlinkSW×8