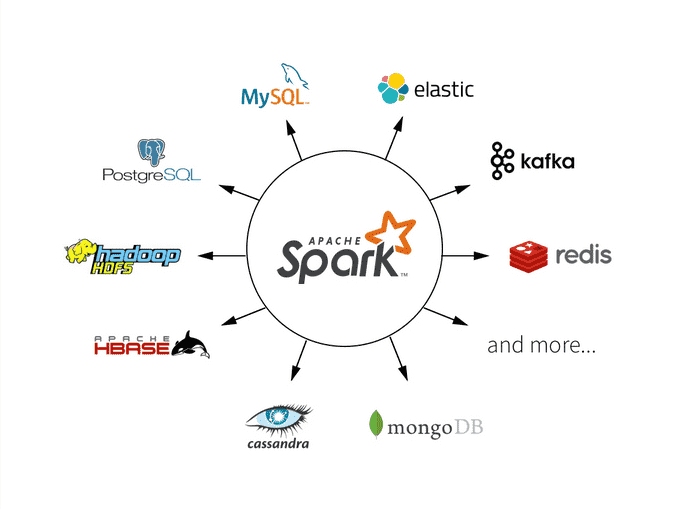

Apache Spark和Apache Kafka是大数据领域中非常流行的工具,用于数据处理和流数据处理。本文将深入探讨如何在Spark中集成Kafka,并演示如何进行流数据处理。将提供丰富的示例代码,以帮助大家更好地理解这一集成过程。

Spark与Kafka的基本概念

在开始集成之前,首先了解一下Spark和Kafka的基本概念。

-

Apache Spark:Spark是一个快速、通用的分布式计算引擎,具有内存计算能力。它提供了高级API,用于大规模数据处理、机器学习、图形处理等任务。Spark的核心概念包括弹性分布式数据集(RDD)、DataFrame和Dataset等。

-

Apache Kafka:Kafka是一个分布式流数据平台,用于收集、存储和处理实时数据流。它具有高吞吐量、可伸缩性和持久性等特点,适用于处理大量流数据。

集成Spark与Kafka

要在Spark中集成Kafka,首先需要添加Kafka的依赖库,以便在Spark应用程序中使用Kafka的API。

以下是一个示例代码片段,演示了如何在Spark中进行集成:

from pyspark.sql import SparkSession# 创建Spark会话

spark = SparkSession.builder.appName("SparkKafkaIntegration").getOrCreate()# 添加Kafka依赖库

spark.sparkContext.addPyFile("/path/to/spark-streaming-kafka-0-10-xxx.jar")

在上述示例中,首先创建了一个Spark会话,然后通过addPyFile方法添加了Kafka的依赖库。这个依赖库包含了与Kafka集群的连接信息。

使用Kafka的API

一旦完成集成,可以在Spark应用程序中使用Kafka的API来访问和处理Kafka中的流数据。

以下是一些示例代码,演示了如何使用Kafka的API:

1. 读取Kafka流数据

from pyspark.streaming import StreamingContext

from pyspark.streaming.kafka import KafkaUtils# 创建StreamingContext

ssc = StreamingContext(spark.sparkContext, batchDuration=5)# 定义Kafka参数

kafkaParams = {"bootstrap.servers": "localhost:9092", # Kafka集群地址"group.id": "my-group" # 消费者组ID

}# 创建Kafka流

kafkaStream = KafkaUtils.createDirectStream(ssc, ["my-topic"], kafkaParams)# 处理Kafka流数据

def process_stream(stream):# 在这里编写流数据处理逻辑passkafkaStream.foreachRDD(process_stream)# 启动StreamingContext

ssc.start()# 等待StreamingContext终止

ssc.awaitTermination()

在这个示例中,首先创建了一个StreamingContext,然后定义了Kafka连接参数。接下来,使用KafkaUtils创建了一个Kafka流,指定了要消费的Kafka主题。最后,定义了一个处理流数据的函数process_stream,并通过foreachRDD将流数据传递给这个函数。

2. 将处理后的数据写入外部存储

在处理Kafka流数据后,通常会希望将结果数据写入外部存储,例如HDFS或数据库。

以下是一个示例代码片段,演示了如何将处理后的数据写入HDFS:

def process_stream(stream):# 在这里编写流数据处理逻辑# 处理完的结果数据processed_data = ...# 将结果数据写入HDFSprocessed_data.write \.format("parquet") \.mode("append") \.save("/path/to/hdfs/output")

在这个示例中,首先定义了一个处理流数据的函数process_stream,然后将处理后的结果数据写入HDFS。

性能优化

在使用Spark与Kafka集成进行流数据处理时,性能优化是一个关键考虑因素。

以下是一些性能优化的建议:

-

调整批处理大小:根据需求和硬件资源,调整批处理大小以平衡吞吐量和延迟。

-

使用检查点:使用Spark的检查点功能来保留中间处理结果,以便在故障发生时能够快速恢复。

-

考虑水印:使用水印来处理迟到的事件,以确保数据处理的正确性。

-

使用并行性:根据集群的资源配置,调整Spark Streaming的并行度以提高性能。

示例代码:Spark与Kafka的集成

以下是一个完整的示例代码片段,演示了如何在Spark中集成Kafka并进行流数据处理:

from pyspark.sql import SparkSession

from pyspark.streaming import StreamingContext

from pyspark.streaming.kafka import KafkaUtils# 创建Spark会话

spark = SparkSession.builder.appName("SparkKafkaIntegration").getOrCreate()# 添加Kafka依赖库

spark.sparkContext.addPyFile("/path/to/spark-streaming-kafka-0-10-xxx.jar")# 创建StreamingContext

ssc = StreamingContext(spark.sparkContext, batchDuration=5)# 定义Kafka参数

kafkaParams = {"bootstrap.servers": "localhost:9092", # Kafka集群地址"group.id": "my-group" # 消费者组ID

}# 创建Kafka流

kafkaStream = KafkaUtils.createDirectStream(ssc, ["my-topic"], kafkaParams)# 处理Kafka流数据

def process_stream(stream):# 在这里编写流数据处理逻辑# 处理完的结果数据processed_data = ...# 将结果数据写入HDFSprocessed_data.write \.format("parquet") \.mode("append") \.save("/path/to/hdfs/output")kafkaStream.foreachRDD(process_stream)# 启动StreamingContext

ssc.start()# 等待StreamingContext终止

ssc.awaitTermination()

在这个示例中,完成了Spark与Kafka的集成,定义了Kafka连接参数,处理了Kafka流数据,并将处理后的数据写入HDFS。

总结

通过集成Spark与Kafka,可以充分利用这两个强大的工具来进行流数据处理。本文深入介绍了如何集成Spark与Kafka,并提供了示例代码,以帮助大家更好地理解这一过程。同时,我们也提供了性能优化的建议,以确保在集成过程中获得良好的性能表现。