文章目录

- 文章信息

- 摘要

- Background

- Graph convolutional recurrent networks (GCRN)

- Semi-implicit variational inference (SIVI)

- Variational graph recurrent neural network (VGRNN)

- VGRNN model

- Semi-implicit VGRNN (SI-VGRNN)

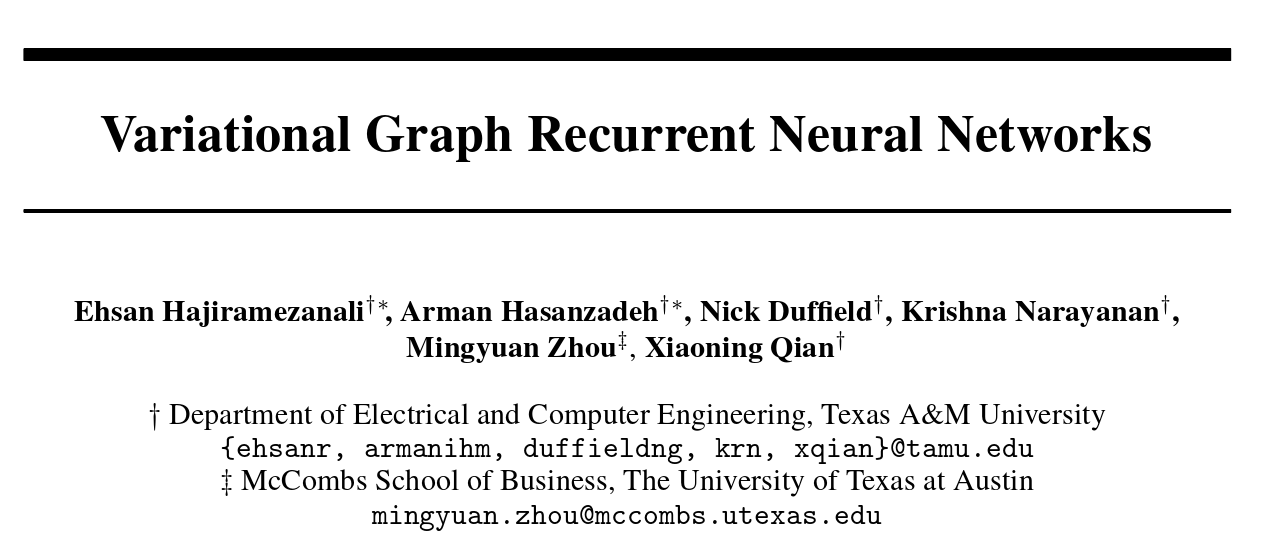

文章信息

Variational Graph Recurrent Neural Networks(VGRNN)

原文地址:Variational Graph Recurrent Neural Networks(VGRNN):https://arxiv.org/abs/1908.09710

源码: https://github.com/VGraphRNN/VGRNN

摘要

Representation learning over graph structured data has been mostly studied in static graph settings while efforts for modeling dynamic graphs are still scant. In this paper, we develop a novel hierarchical variational model that introduces additional latent random variables to jointly model the hidden states of a graph recurrent neural network (GRNN) to capture both topology and node attribute changes in dynamic graphs. We argue that the use of high-level latent random variables in this variational GRNN (VGRNN) can better capture potential variability observed in dynamic graphs as well as the uncertainty of node latent representation. With semi-implicit variational inference developed for this new VGRNN architecture (SI-VGRNN), we show that flexible non-Gaussian latent representations can further help dynamic graph analytic tasks. Our experiments with multiple real-world dynamic graph datasets demonstrate that SI-VGRNN and VGRNN consistently outperform the existing baseline and state-of-the-art methods by a significant margin in dynamic link prediction.

对图结构化数据的表示学习主要在静态图设置中进行研究,而对动态图进行建模的努力仍然很少。在本文中,我们开发了一种新颖的分层变分模型,该模型引入了额外的随机变量来联合建模图递归神经网络(GRNN)的隐藏状态,以捕获拓扑和节点属性变化的非动态图。我们认为,在这个变分GRNN(VGRNN)中使用高级潜在随机变量可以更好地捕获动态图中观察到的潜在变异性以及节点潜在表示的不确定性。通过为这种新的VGRNN架构(SI-VGRNN)开发的半隐式变分推理,我们表明灵活的非高斯潜在表示可以进一步帮助动态图分析任务。我们使用多个真实世界动态图数据集的实验表明,SI-VGRNN 和 VGRNN 在动态链接预测方面始终优于现有的基线和最先进的方法。

Background

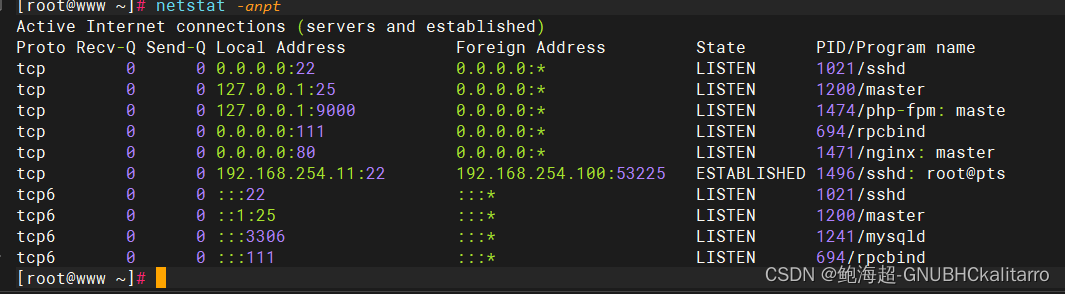

Graph convolutional recurrent networks (GCRN)

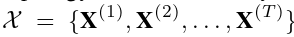

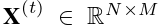

GCRN用于对静态图节点上定义的时间序列数据进行建模。视频中的一系列帧和传感器网络上的时空测量是此类数据集的两个示例。GCRN将图卷积网络(GCN)与循环神经网络(RNN)相结合,以捕获数据中的空间和时间特征。更准确地说,给定一个具有 N 个节点的图 G,其拓扑由邻接矩阵 A 确定,节点属性序列  ,GCRN 读取 M 维节点属性

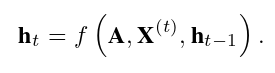

,GCRN 读取 M 维节点属性 并对每个时间步 t 更新其隐藏状态 ht:

并对每个时间步 t 更新其隐藏状态 ht:

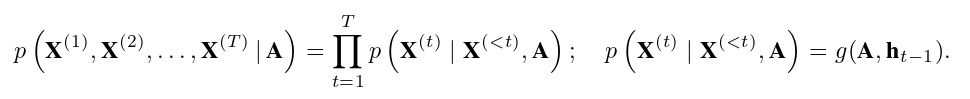

这里 f 是一个非概率深度神经网络。它可以是任何递归网络,包括门控激活函数,如长短期记忆(LSTM)或门控循环单元(GRU),其中它们内部的深层被图卷积层取代。GCRN 通过将联合概率分布的因式分解参数化为条件概率的乘积来对节点属性序列进行建模。

由于转移函数f的确定性,这里映射函数g的选择有效地定义了联合概率分布

由于转移函数f的确定性,这里映射函数g的选择有效地定义了联合概率分布 可以用标准GCRN表示。对于高度可变的序列,这可能会有问题。更具体地说,当 X 的变异性很高时,模型试图在隐藏状态 h 中映射这种变异性,从而导致 h 的潜在高变异,进而导致训练数据的过度拟合。因此,GCRN并不完全能够对具有高变异的序列进行建模。自回归模型的这一基本问题已通过向模型引入随机隐藏状态来解决非图结构数据集。

可以用标准GCRN表示。对于高度可变的序列,这可能会有问题。更具体地说,当 X 的变异性很高时,模型试图在隐藏状态 h 中映射这种变异性,从而导致 h 的潜在高变异,进而导致训练数据的过度拟合。因此,GCRN并不完全能够对具有高变异的序列进行建模。自回归模型的这一基本问题已通过向模型引入随机隐藏状态来解决非图结构数据集。

在本文中,我们将GCN和RNN集成到一个图RNN(GRNN)框架中,这是一个动态图自动编码器模型。虽然GCRN旨在对静态图上定义的动态节点属性进行建模,但GRNN可以在不同的时间快照获得不同的邻接矩阵,并通过在隐藏状态ht上采用内积解码器在时间t重建图。更具体地说,ht可以看作是动态图在时间t的节点嵌入。为了进一步提高GRNN的表达能力,我们通过结合GRNN和变分图自动编码器(VGAE)来引入随机潜在变量。这样,我们不仅可以在不假设平滑性的情况下捕获图之间的时间依赖关系,而且每个节点都用潜在空间中的分布表示。此外,VGRNN中设计的先前构造使其能够预测未来时间步中的链接。

Semi-implicit variational inference (SIVI)

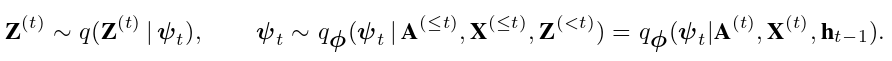

SIVI已被证明可以有效地学习具有偏度、峰度、多模态和其他特征的后验分布,而现有的变分推理方法无法捕捉到这些特征。为了表征潜在的后验q(z|x),SIVI在原始后验分布的参数上引入了混合分布,以扩展具有分层结构的变分族: 。φ表示要推断的分布参数。虽然原始后验q(z|ψ)需要具有解析形式,但其混合分布不受这种约束,因此边际后验分布通常是隐含的,没有解析密度函数更具表现力。层次结构的边缘是隐式的也很常见,即使后验分布和混合分布都是显式的。我们将SIVI集成到我们的新模型中,为动态图推断更灵活和可解释的节点嵌入。

。φ表示要推断的分布参数。虽然原始后验q(z|ψ)需要具有解析形式,但其混合分布不受这种约束,因此边际后验分布通常是隐含的,没有解析密度函数更具表现力。层次结构的边缘是隐式的也很常见,即使后验分布和混合分布都是显式的。我们将SIVI集成到我们的新模型中,为动态图推断更灵活和可解释的节点嵌入。

Variational graph recurrent neural network (VGRNN)

我们考虑一个动态图 ,其中

,其中 是时间步长t的图,

是时间步长t的图, 分别是相应的节点和边集。在本文中,我们旨在开发一个与节点和边缘集中的潜在变化普遍兼容的模型。

分别是相应的节点和边集。在本文中,我们旨在开发一个与节点和边缘集中的潜在变化普遍兼容的模型。 和

和 之间的关系没有约束,即新节点可以加入动态图并创建现有节点的边,或者以前的节点可以从图中消失。

之间的关系没有约束,即新节点可以加入动态图并创建现有节点的边,或者以前的节点可以从图中消失。

另一方面,快照之间可以形成新的边,而现有边可以消失。设 Nt 表示节点的数量,即  在时间步长 t 的基数。因此,VGRNN可以将可变长度邻接矩阵序列

在时间步长 t 的基数。因此,VGRNN可以将可变长度邻接矩阵序列 作为输入。此外,在考虑节点属性时,可以在不同的快照上观察到不同的属性,具有可变长度节点属性序列

作为输入。此外,在考虑节点属性时,可以在不同的快照上观察到不同的属性,具有可变长度节点属性序列  。请注意,

。请注意, 分别是 Nt × Nt 和 Nt × M 矩阵,其中 M 是节点属性的维度,该维度随时间变化是恒定的。受变分递归神经网络(VRNN)的启发,我们通过集成GRNN和VGAE来构建VGRNN,以便充分和同时地对拓扑和节点属性动力学之间的复杂依赖关系进行建模。此外,每个节点在每个时间都用分布表示,因此在VGRNN中也对节点潜在表示的不确定性进行了建模。

分别是 Nt × Nt 和 Nt × M 矩阵,其中 M 是节点属性的维度,该维度随时间变化是恒定的。受变分递归神经网络(VRNN)的启发,我们通过集成GRNN和VGAE来构建VGRNN,以便充分和同时地对拓扑和节点属性动力学之间的复杂依赖关系进行建模。此外,每个节点在每个时间都用分布表示,因此在VGRNN中也对节点潜在表示的不确定性进行了建模。

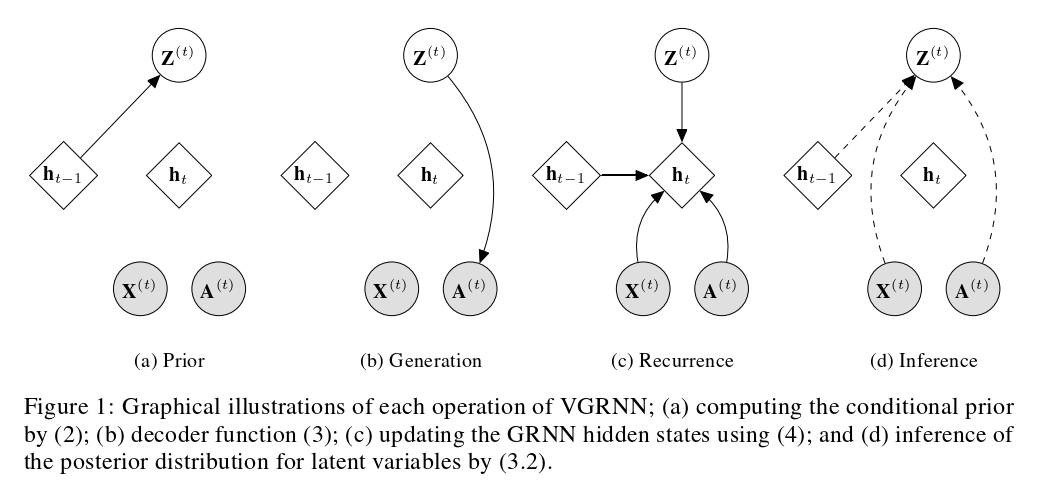

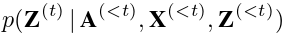

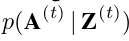

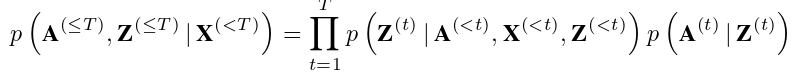

VGRNN model

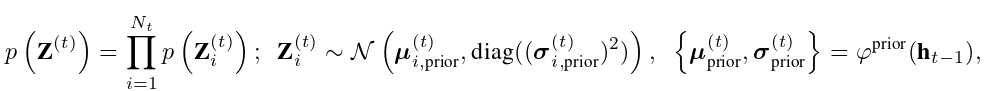

VGRNN 模型采用 VGAE 对每个图形快照进行建模。VGAEs在时间范围内以状态变量ht−1为条件,由GRNN建模。这样的架构设计将帮助每个VGAE考虑动态图的时间结构。更重要的是,与标准VGAE不同,VGRNN中的VGAE通过允许分布参数通过前一个时间步的信息的显式或隐式复杂函数进行建模,从而在潜在随机变量上采用新的先验。更具体地说,VGRNN 中的 VGAE 不是强加具有确定性参数的标准多元高斯分布,而是根据先前时间步中的隐藏状态学习先验分布参数。因此,我们的VGRNN允许更灵活的潜在表示,具有更大的表达能力,可以捕获拓扑和节点属性演化过程之间和内部的依赖关系。特别是,我们可以将实验中采用的先验分布的构造写成如下:

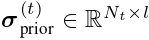

其中,

其中, 和

和

表示条件先验分布的参数。

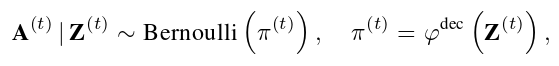

此外,生成分布将以 为条件:

为条件:

其中π(t)表示生成分布的参数;φprior和φdec可以是任何高度灵活的函数,例如神经网络。

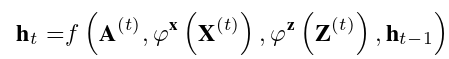

另一方面,骨干GRNN可以灵活地对复杂的依赖关系进行建模,包括图拓扑动力学和节点属性动力学。GRNN 使用递归方程更新其隐藏状态:

其中 f 最初是方程 (1) 的转移函数。与GRNN不同,图拓扑可以在不同的时间步长中发生变化,就像在现实世界的动态图中一样,并且邻接矩阵A(t)在VGRNN中是时间相关的。为了进一步增强表达能力,φx和φz为深度神经网络,它们在每个节点上独立运行,并分别从X(t)和Z(t)中提取特征。这些特征提取器对于学习复杂的图形动力学至关重要。基于 (4),ht 是  的函数。因此,方程 (2) 和 (3) 中的先验分布和生成分布分别定义了分布

的函数。因此,方程 (2) 和 (3) 中的先验分布和生成分布分别定义了分布 和

和 。生成模型可以分解为

。生成模型可以分解为

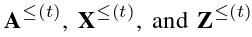

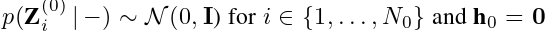

其中第一个快照的先验被认为是标准多元高斯分布,即

其中第一个快照的先验被认为是标准多元高斯分布,即 。此外,如果在快照 t 处将一个以前未观察到的节点添加到图中,我们认为该节点在快照 t − 1 处的隐藏状态为零,因此该节点在时间 t 处的先验状态为 N (0, I)。如果发生节点删除,我们假设节点的标识可以保持,因此删除一个节点,相当于删除了与其连接的所有边,不会影响下一步的先前构造。更具体地说,A和X的大小可以随时间变化,而它们的潜在空间会随时间而保持。

。此外,如果在快照 t 处将一个以前未观察到的节点添加到图中,我们认为该节点在快照 t − 1 处的隐藏状态为零,因此该节点在时间 t 处的先验状态为 N (0, I)。如果发生节点删除,我们假设节点的标识可以保持,因此删除一个节点,相当于删除了与其连接的所有边,不会影响下一步的先前构造。更具体地说,A和X的大小可以随时间变化,而它们的潜在空间会随时间而保持。

Semi-implicit VGRNN (SI-VGRNN)

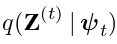

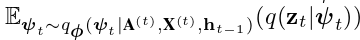

为了进一步提高VGRNN变分后验的表达能力,我们引入了aSI-VGRNN动态节点嵌入模型。我们对 (8) 中的变分分布参数施加了混合分布,以使用半隐式分层结构对 VGRNN 的后验进行建模:

虽然变分分布

虽然变分分布  需要显式,但混合分布 qφ 不受这种约束,导致相当灵活的

需要显式,但混合分布 qφ 不受这种约束,导致相当灵活的  。更具体地说,SI-VGRNN 通过图形神经网络转换随机噪声 t 从 qφ 中提取样本,这通常会导致 qφ 的隐式分布。

。更具体地说,SI-VGRNN 通过图形神经网络转换随机噪声 t 从 qφ 中提取样本,这通常会导致 qφ 的隐式分布。