🐲本文背景

近年来,随着深度学习技术的迅猛发展,大模型已经成为学术界和工业界的热门话题。大模型具有数亿到数十亿的参数,这使得它们在处理复杂任务时表现得更为出色,但同时也对计算资源和数据量提出了更高的要求。

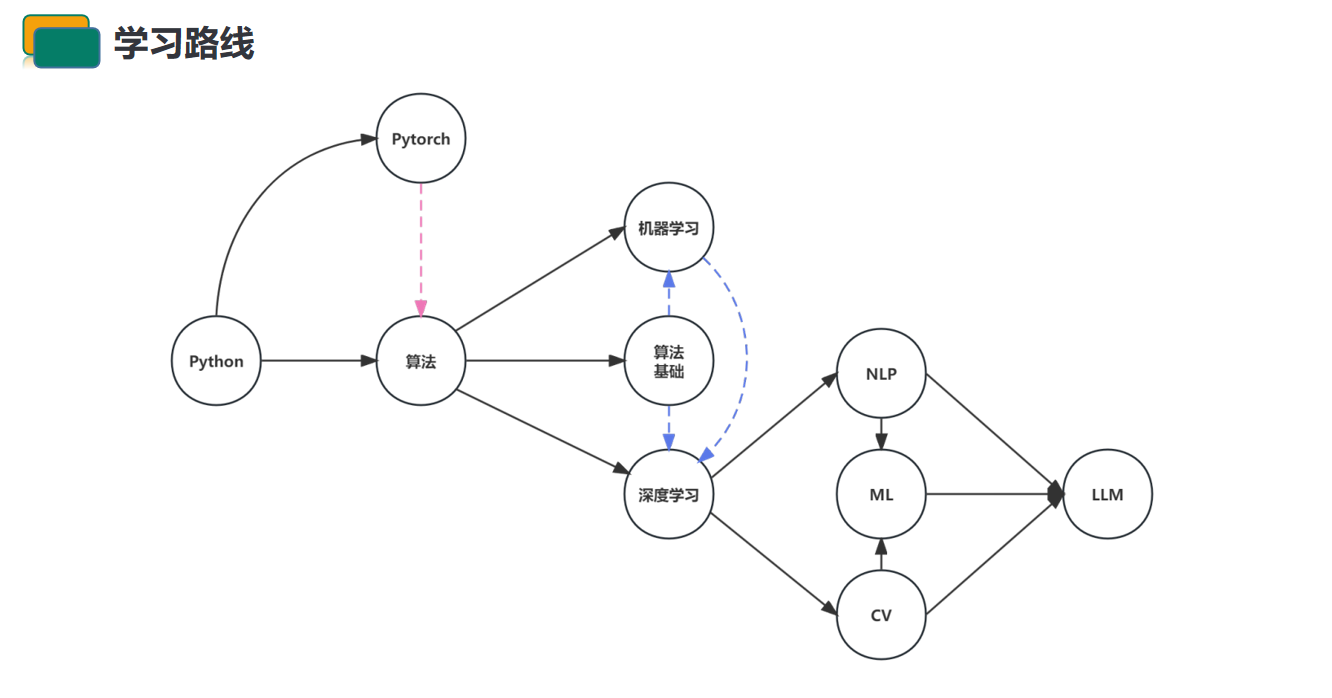

学习大模型的路线图通常需要一系列的基础知识、进阶技能以及实际应用经验。以下是一些相关的背景信息:

1. 深度学习基础: 学习大模型之前,对深度学习的基本概念、神经网络的原理、激活函数、损失函数等基础知识有一定的了解是必要的。

2. 编程技能: 大多数深度学习框架使用Python作为主要编程语言,因此熟悉Python编程语言是学习大模型的基础。

3. 深度学习框架: 了解并熟练使用深度学习框架,如TensorFlow或PyTorch,这是实际搭建、训练和优化大模型所必需的技能。

4. 特定领域知识: 大模型的应用领域广泛,包括自然语言处理、计算机视觉、语音识别等。在选择学习路线时,可以根据兴趣和目标选择特定领域进行深入学习。

5. 理论基础: 阅读相关领域的研究论文,了解大模型的理论基础和最新进展,这对深入理解模型原理和设计思想非常重要。

6. 实践经验: 通过参与项目、实际应用场景的实践,将理论知识转化为实际能力,提高解决实际问题的能力。

7. 持续学习: 大模型领域的发展速度较快,保持持续学习的习惯,关注新的研究成果和技术趋势。

🍁大模型的概念

大模型是深度学习中指参数数量庞大的模型。这些模型通常具有数亿到数十亿的参数,拥有深层的神经网络结构。大模型的出现主要得益于两个方面的发展:

数据的丰富性: 随着互联网的普及,大规模的数据集变得更加容易获取。这使得在训练深度神经网络时可以使用更大规模的数据,有助于提高模型的泛化能力。

计算资源的提升: 随着硬件和计算技术的进步,特别是图形处理单元(GPU)和专用深度学习加速器(如TPU),训练大规模模型的计算需求得到了满足。这使得研究人员和工程师能够设计更庞大的网络结构,并利用更多的参数进行训练。

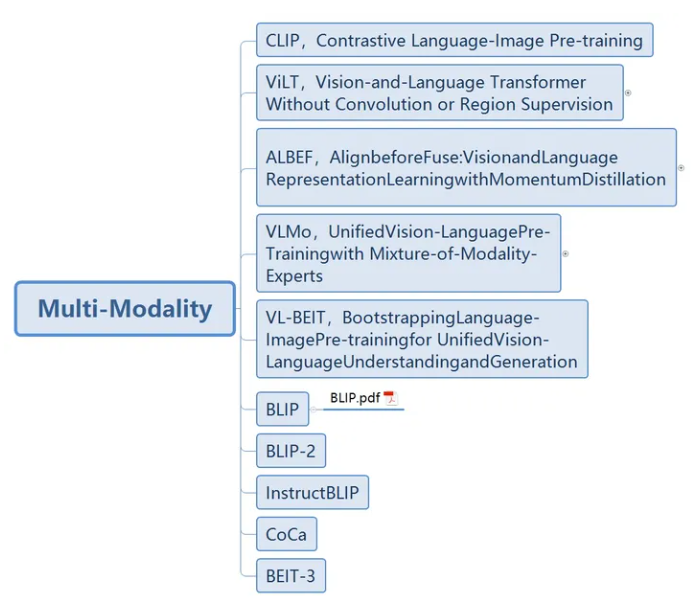

多模态大模型如下

多模态很容易理解,就是文、图、视频、音频之间相互转换。下图中仅仅列出一些有代表性的多模态大模型,例如经典双塔模型CLIP(BERT+ViT),ALBEF—将BERT的6层网络拿出来做文本和图像的编码融合。

大模型在各种任务上表现出色,如自然语言处理、计算机视觉、语音识别等。它们能够从海量的数据中学到更为复杂的模式和表示,从而提高模型对任务的理解和泛化能力。一些著名的大模型包括:

● ERT(Bidirectional Encoder Representations from Transformers):用于自然语言处理任务的预训练模型,采用Transformer结构。

● PT(Generative Pre-trained Transformer):一系列用于自然语言生成任务的模型,以及其变体如GPT-3,具有非常大的参数规模。

● esNet(Residual Network):用于计算机视觉任务,通过残差学习解决了深度神经网络训练时的梯度消失问题。

● lphaGo Zero:使用深度神经网络的强化学习模型,通过自我对弈不断提升水平,最终超越人类棋手。

大模型的成功也带来了一些挑战,其中包括训练时间的增加、计算资源的需求以及对大规模数据集的依赖。然而,它们在许多领域中的卓越表现使得大模型成为深度学习领域一个备受关注的方向。

🌴大模型的定义

在深度学习领域,"大模型"通常指的是模型参数数量庞大、拥有深层结构的神经网络。这些模型的规模通常表现为网络中的参数数量,即模型中需要学习的权重和偏置的数量。具体来说,大模型可能包含数百万到数十亿的参数。

定义要点:

1. 参数数量: 大模型的显著特征是其庞大的参数数量。这些参数用于捕获输入数据的复杂模式和表示。

2. 深层结构: 大模型往往有深层的神经网络结构,包括多个隐藏层。深层结构使得模型能够学习更复杂、抽象的特征表示。

3. 计算需求: 由于大模型拥有众多参数,训练和推理过程需要更多的计算资源,这可能包括高性能的GPU或专用的深度学习加速器。

4. 任务广泛: 大模型在多个领域表现出色,如自然语言处理、计算机视觉、语音识别等。它们能够适应各种复杂任务并提供出色的性能。

5. 泛化能力: 大模型通过在大量数据上训练,具有较强的泛化能力,可以在未见过的数据上表现良好。

🌞大模型的发展现状

大模型的参数规模不断扩大,性能也在不断提升。随着模型参数从百万级、千万级、亿级到千亿级、万亿级的不断增加,大模型的性能如研究者预期一样,一直在不断接近人类水平。这种发展趋势表明,大模型正在逐渐具备更强的泛化能力和自我进化能力,从而在多个领域得到广泛应用。

大模型正在走向多领域通用。大模型的初心是让训练出来的模型具备不同领域的认知力,既能有泛化的能力,又能有自我进化的能力。例如,NLP领域内的大模型已经成功复用到CV领域,得到了极有效的证实;GPT-3也展现出了从海量未标记数据中学习的通用能力。近期兴起的多模态预训练大模型就是最好的证明。未来,大模型将致力于构建通用的人工智能算法底层架构,将模型的认知力从单领域泛化到多领域融合,在不同场景中自我生长,向可持续、可进化的方向发展。

大模型正变得越来越易于使用。随着大模型的开源和开放,越来越多的机构和个人可以方便地使用这些模型进行研究和开发。许多机构致力于提供易于使用的平台和工具,使得非专业人士也能轻松地使用大模型进行各种应用。

大模型的发展仍然面临着一些挑战和问题。尽管大模型在很多任务上已经取得了显著的成果,但仍存在一些局限性,如数据集的规模和质量、模型的泛化能力、训练的效率和稳定性等。此外,大模型的训练和运行需要大量的计算资源和能源消耗,也引发了一些环保和可持续性的问题。

🌏华为盘古大模型

华为盘古大模型是华为旗下的AI大模型,包括NLP大模型、CV大模型和科学计算大模型等多个领域。其中,盘古NLP大模型是业界首个超千亿参数的中文预训练大模型,被认为是最接近人类中文理解能力的AI大模型。

盘古大模型采用了Encoder-Decoder架构,兼顾NLP理解与生成的能力,在预训练阶段学习了超40TB文本数据,并通过行业数据的小样本调优,提升模型在场景中的应用性能。

华为盘古大模型具有强大的AI能力和优秀的性能表现,可应用于多个领域,如智能客服、智能语音助手、智能推荐等。

🌋华为盘古大模型和自然语言处理的关系

华为盘古大模型被设计用于各种自然语言处理任务,如语言生成、语言理解和对话系统等。它采用了深度学习和自然语言处理技术,并使用了大量的中文语料库进行训练。盘古大模型拥有超过1千亿个参数,可以支持多种自然语言处理任务,包括文本生成、文本分类、问答系统等等。

与GPT等外国AI模型相比,盘古大模型更注重针对中文语言的优化,使用了大量的中文语料库进行训练,可以更好地理解中文语言的语法和语义。此外,盘古大模型还融入了华为在5G、云计算、物联网等领域的技术优势,可以更好地应用于这些领域的实际场景。

华为盘古大模型在自然语言处理领域具有广泛的应用前景,可以为自然语言处理领域带来更加智能化的技术支持。

🌌华为盘古大模型的应用场景

华为盘古大模型的应用场景非常广泛,主要包括以下几个方面:

1. 智能客服:利用盘古大模型的自然语言处理能力,可以构建智能客服系统,自动回答用户的问题和解决用户的问题,提高客户满意度和效率。

2. 智能语音助手:盘古大模型可以应用于智能语音助手的构建,通过自然语言处理技术,实现对用户语音的识别和理解,提供更加智能化的服务和支持。

3. 智能推荐:利用盘古大模型的推荐算法,可以实现对用户兴趣和需求的精准推荐,如个性化音乐推荐、电影推荐等。

4. 智能翻译:盘古大模型可以应用于多语种翻译,支持不同语言之间的互译,提高翻译的准确性和效率。

5. 智能风控:利用盘古大模型的识别能力,可以构建智能风控系统,实现对欺诈行为、恶意用户的快速识别和防范。

华为盘古大模型具有强大的AI能力和优秀的性能表现,可应用于多个领域,如智能客服、智能语音助手、智能推荐等。如需了解更多关于华为盘古大模型的信息,建议访问华为官网或咨询相关技术人员。

盘古大模型_panguLM_大模型_华为云 (huaweicloud.com)

🌘分类及应用领域

大模型,泛指参数很多的机器学习模型,根据场景不同,大部分大模型公司把大模型分为大语言模型、计算机视觉(包含图像和视频)、音频、多模态大模型四大类。

大型模型在计算机科学和人工智能领域有广泛的分类和应用领域。以下是一些主要的大型模型分类和应用领域:

大型模型的分类:

1. 语言模型:

● PT(生成预训练)模型:如GPT-3,是一类基于Transformer架构的语言生成模型,可以用于各种自然语言处理任务。

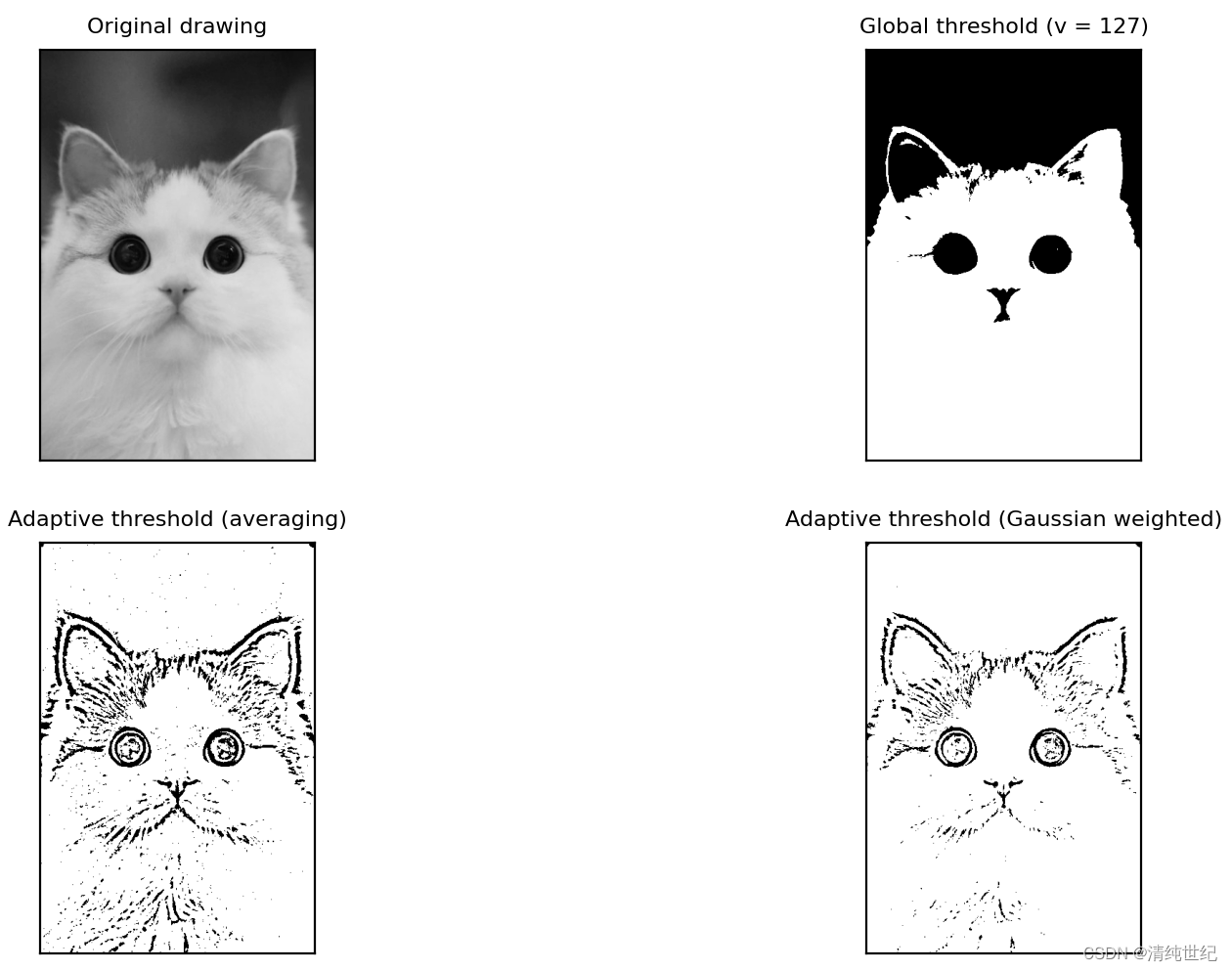

2. 图像模型:

● NN(卷积神经网络):用于图像识别、分类和目标检测。

● AN(生成对抗网络):用于生成逼真的图像,训练生成模型。

3. 强化学习模型:

● 度Q网络(DQN):用于解决强化学习问题,如游戏玩法优化和机器人控制。

4. 推荐系统模型:

● 同过滤模型:用于推荐系统,根据用户历史行为和相似用户的行为推荐物品。

5. 转移学习模型:

● ERT(双向编码器表示转换):用于自然语言处理任务,通过在大规模文本上进行预训练,然后在特定任务上进行微调。

大型模型的应用领域:

如今大模型主要应用于自然语言处理、计算机视觉、语音识别、自动驾驶等领域,同时在科技、艺术、商业、教育、医疗等行业也被广泛应用。

包含下面领域:

自然语言处理(NLP):

● 文本生成: 生成文章、摘要或对话。

● 机器翻译: 提高翻译质量和效率。

● 情感分析: 分析文本中的情感。

计算机视觉:

● 图像分类: 对图像进行分类。

● 目标检测: 检测图像中的对象。

● 图像生成: 生成逼真的图像。

强化学习:

● 游戏: 控制游戏角色进行优化游戏玩法。

● 机器人控制: 控制机器人执行任务。

推荐系统:

● 个性化推荐: 根据用户偏好提供个性化的推荐。

医疗领域:

● 图像诊断: 分析医学图像进行疾病诊断。

● 自然语言处理: 处理医学文本,如病历和文献。

金融领域:

● 风险分析: 分析金融数据以识别潜在风险。

● 交易预测: 预测金融市场的交易趋势。

应用举例:

1.AI聊天社交应用:

Call Annie:

Call Annie是一款人工智能聊天服务,旨在为用户提供随时可用的虚拟助手。它可以用于查询天气、设定闹钟、发送短信、播放音乐等日常活动,也可以用于学习、工作和生活中的各种问题解答。Call Annie的用法包括开启应用、唤醒应用和提问等步骤。用户可以通过这款应用,和一个名叫Annie的虚拟女性进行视频通话,Call Annie是由OpenAI旗下的ChatGPT模型驱动的,它可以听懂各种各样的语言,实时进行翻译;你还可以设置早上叫醒服务,这可比普通的闹钟铃声好听多了,单身男性的一大福祉呀。

NewBing

New Bing是微软推出的全新搜索引擎。

2023年2月7日,微软宣布推出由ChatGPT支持的最新版本Bing搜索引擎和Edge浏览器。新版Bing带有一个扩展的聊天框,可以回答有关各种主题的问题,并具有更好的零任务学习能力,能够进行跨主题的对话转移。新Bing从2月7日开始向“符合条件的”访问者开放。

2.AI辅助文章创作:

Chibi AI

一款创新的写作工具,可以快速创作出优秀的文章内容。它提供许多创作需要用到的工具,如重写、缩短、扩展和更改所选文本的语气,同时能够帮助你专注于写作以及解决创作过程中遇到的困难。

Chibi AI是一款AI写作工具,专为那些希望能够专注于写作,但在遇到困难时得到一点帮助的作家而设计。它包括作家需要的有用工具,例如重写、缩短、扩展和更改所选文本的语气。你可以选择一种“创意模式”,在这种模式下,生成内容的整体基调会发生变化。此外,Chibi AI也提供创意激发、无缝编辑和专家建议等功能,帮助作家创作出最佳的文章、最优秀的文案和最精彩的故事。

此外,还有一种观点认为Chibi AI是帮助用户为其网站或应用程序创建引人入胜的个性化聊天机器人的工具。

迅捷AI写作

迅捷AI写作是一款智能化的写作软件,提供了多种功能来帮助用户快速生成高质量的文本内容。

它支持全能AI写作,可以满足各领域内容的写作创作需求。其次,它还具有AI文字识别功能,可以通过拍照识别文字内容,并以文本的形式输出。此外,迅捷AI写作还提供了新媒体震惊标题、商品种草文案和高赞优秀回答等创作与构思功能,可以帮助用户快速生成吸引人的文案和标题。

除了写作功能,迅捷AI写作还支持格式转换、阅读、压缩等功能,非常适合日常使用。此外,迅捷AI写作还提供了证件照制作、计数和测量等实用工具,让用户在处理文档时更加方便快捷。迅捷AI写作是一款非常实用的写作软件,可以帮助用户快速生成高质量的文本内容,提高工作效率。

3.AI办公智能助手:

Gramma AI

Gramma AI是一款基于人工智能技术的PPT制作软件,可以帮助用户快速生成具有专业水准的PPT演示文稿。该软件具有以下特点:

基于人工智能技术,可以自动识别用户提供的主题和内容,并快速生成相应的PPT幻灯片。

提供丰富的模板和素材,用户可以根据需要选择适合自己的模板和素材,并对其进行个性化的修改和调整。

支持多种导出格式,如PDF、PPTX等,方便用户在不同场合下使用。

操作简单易用,用户无需具备专业的PPT制作技能,即可快速制作出高质量的PPT演示文稿。

Gramma AI是一款非常实用的PPT制作软件,可以帮助用户快速生成高质量的PPT演示文稿,提高工作效率。

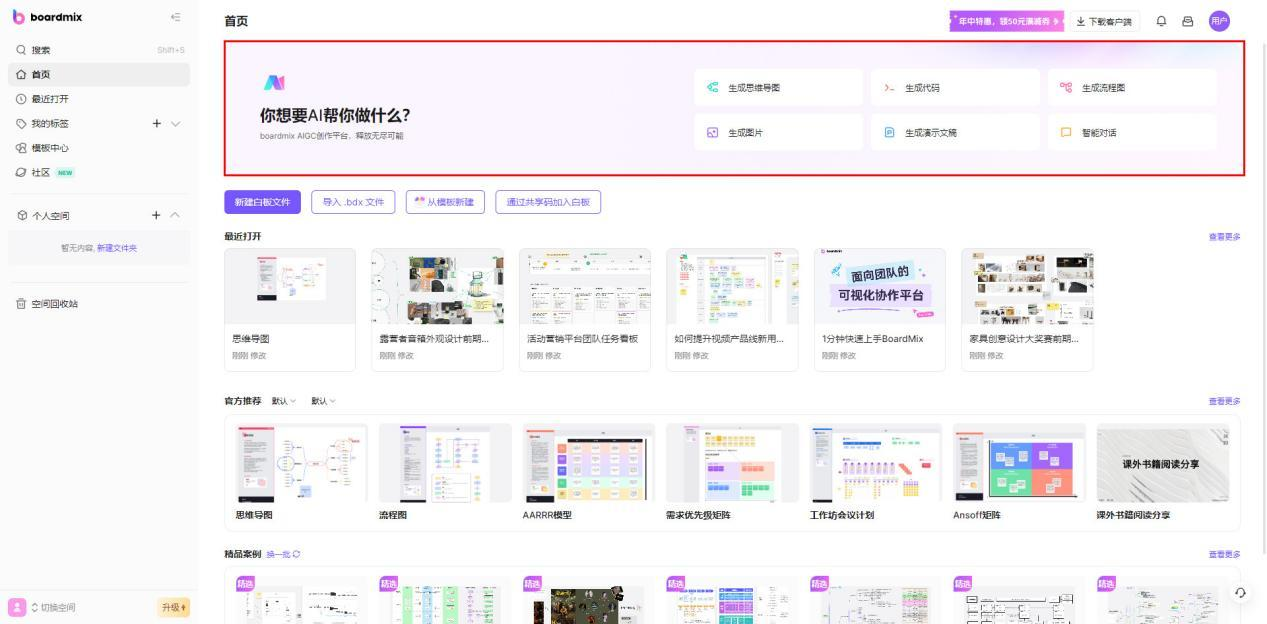

boardmix

BoardMix是一款在线协作白板工具,提供了无限画布、画笔、橡皮擦、文字等工具,支持多人在线编辑和实时互动。

用户可以在BoardMix上自由地绘制、标注、添加文本和形状等,支持导入图片、文档、表格、幻灯片等各类课件讲义,方便用户进行备课、教学、讨论等活动。同时,BoardMix还提供了多种实用功能,如AI助手、思维导图、流程图、表格等,可帮助用户高效地完成各种工作任务。

BoardMix适用于各种场景,如团队协作、在线会议、教育培训等,方便用户随时随地进行沟通和协作。它支持接入音频/视频会议软件,如腾讯会议、飞书会议、钉钉会议等,可与各种应用集成,为用户提供更加便捷的在线协作体验。

总的来说,BoardMix是一款功能强大、易于使用的在线协作白板工具,可帮助用户高效地完成各种工作任务,提高团队协作效率。

🍃大型模型的未来趋势

总结:

1. 🌐 大模型将成为数字系统标配,无处不在,开创全新的产业格局。

2. 🚀 开源大模型将爆发,催生“小模型”涌现,覆盖更多终端应用。

3. 💡 大模型助力产业升级,企业级市场崛起,Agent智能体成为超级生产力工具。

大型模型的未来趋势可以从以下几个方面进行预测:

● 更大规模的模型:随着计算资源和算法的不断发展,未来会有更大规模的大型模型出现,例如百亿级、千亿级的模型。这些大规模模型将能够处理更加复杂的问题,提供更加精细和准确的结果。

● 更加专业的领域模型:随着大型模型应用的不断深入,未来将会出现更加专业的领域模型,例如医学、法律、金融等领域的专业模型。这些专业模型将能够提供更加专业和精准的服务,满足特定领域的需求。

● 模型可解释性的提高:目前的大型模型往往难以解释,未来随着技术的不断发展,大型模型的解释性将会得到提高,人们将能够更好地理解模型的工作原理和决策依据。这将有助于提高模型的透明度和信任度,促进大型模型在各个领域的应用。

● 更加注重隐私和安全:随着大型模型应用的广泛化,隐私和安全问题也日益突出。未来大型模型将会更加注重隐私和安全,例如采用差分隐私技术、加密技术等保护用户隐私和数据安全。

● 更加智能化和自适应:大型模型将会更加智能化和自适应,能够自动地学习和适应新任务和新环境,而不需要人工干预或重新训练。同时,大型模型也将会更加智能化地与人类进行交互,更好地理解人类的需求和意图,提供更加智能化的服务和支持。

大型模型的未来趋势将朝着更大规模、更专业化、更高解释性、更注重隐私和安全以及更智能化的方向发展。这些发展趋势将为大型模型的应用带来更加广阔的前景和机会。

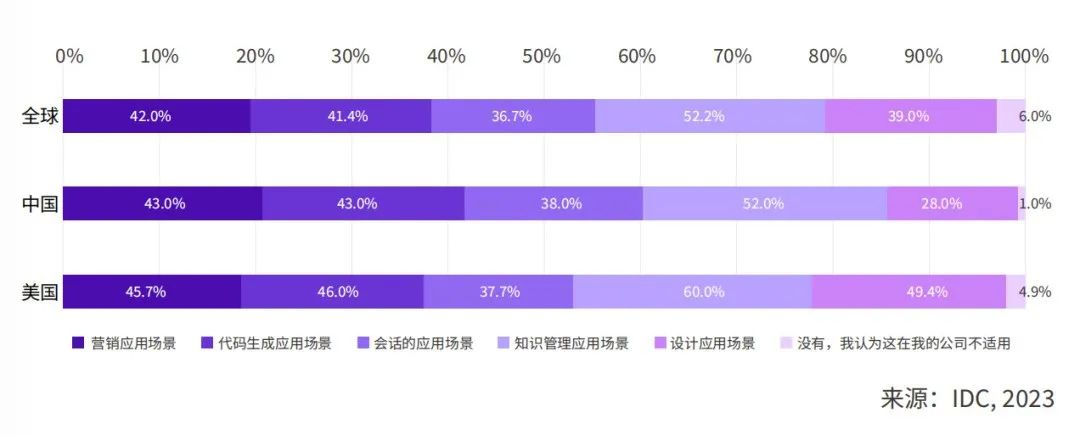

关于未来趋势,我们来参考IDC的观点:

IDC认为,2024年,AIGC必然会通过应用创新过程融入到企业业务中,并构建出大量的新场景;同时,AIGC也会借助应用价值链的延伸,改变行业运行业态,对商业模式和利益格局产生深远影响。

因此,围绕AIGC的应用层创新将成就一大批未来创新型企业,应用层创新将成为2024 AIGC产业发展的确定方向。

IDC就AIGC应用对诸多行业用户展开调研,所有受访企业均表示或多或少都开始了对AIGC相关应用的投入与尝试。

一方面,在即将到来的通用人工智能时代,智能化应用将出现爆发式增长的态势,无处不在的应用开发有助于企业以业务场景为切入点快速满足智能创新需求。

IDC预测,到2024年,数字经济的发展将在全球范围内孕育出超过5亿个新应用,相当于过去40年间出现的应用数量的总和。

另一方面,随着通用智能化能力的实践推广,AIGC会优先在企业端用户中实现场景的落地,企业首先考虑的将会是与生产力和办公相关的场景。

与此相对应地,面向消费端用户推出的AIGC应用往往结合着对商业模式的探索和对市场教育的投入,这会延长其构建商业闭环的时间周期。

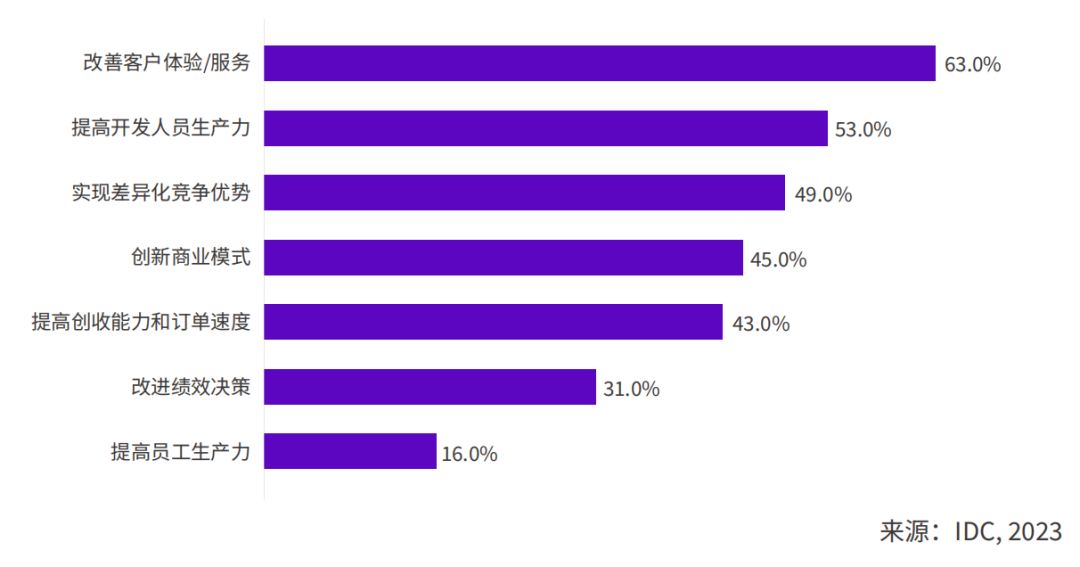

AIGC正在工具化,从“赶时髦”变“真有用”

随着大模型的快速迭代成熟,许多行业开始期望大模型能够解决现实问题,带来可持续价值。

IDC调研结果显示,当前企业就AIGC项目择选供应商合作时,最看重的是项目能否在短期内为企业带来价值。在这样的目标指引下,越来越多的未来场景被描绘出来,大模型应用厂商也在积极开拓行业用户,试图快速打造优质客户的行业领先实践。

从个人视角看,AIGC正在工具化,而掌握优秀工具的员工将事半功倍,未来对不同环节工作效率的固有认知与评价标准也会有较为明显的改变。

IDC的调研显示,企业当前最希望通过AIGC来实现的商业目标包括:改善客户体验/服务、提高开发人员生产力、实现差异化竞争优势以及创新商业模式等。

IDC预测,到2026年,AIGC将承担42%的传统营销琐事,如搜索引擎优化、内容和网站优化、客户数据分析、细分、潜在客户评分和超个性化等。

🌀大模型学习线路

大模型学习线路可以分为以下几个步骤:

1. 学习基础知识:了解机器学习、深度学习、自然语言处理等基础知识,掌握常用的数学、编程和算法知识。

2. 学习深度学习框架:熟悉至少一种深度学习框架,如TensorFlow、PyTorch等,掌握其基本原理和使用方法。

3. 学习模型优化技术:了解常见的模型优化技术,如剪枝、量化、分片等,掌握相应的实现方法。

4. 学习硬件加速技术:了解常见的硬件加速技术,如GPU、FPGA、ASIC等,了解它们的特点、优缺点和使用方法。

5. 学习模型并行化技术:掌握模型并行化的基本原理和实现方法,了解模型并行化在大模型推理加速中的应用。

6. 学习分布式计算技术:学习分布式计算的基本原理和实现方法,了解分布式计算在大模型推理加速中的应用。

7. 实践和项目经验:通过实践和参与实际项目,加深对大模型的理解和应用能力,积累实际经验。

在整个学习过程中,需要注意保持学习的持续性和系统性,不断学习和探索新技术、新方法,以适应快速发展的机器学习和自然语言处理领域。同时,也需要注重实践和应用,将所学知识应用到实际项目中,提升自己的实际能力和经验。

🐮大模型学习资源

课程:

Google的生成式AI课程

Full Stack的大模型训练营,免费并且受到众多大佬推荐;

LLM University,可以学习大模型和NLP相关知识;

部署GPT和大语言模型,Oreilly的资源;

Edx的大语言模型课程,能够获得证书哦;

普林斯顿大学大语言模型课程,只有课件和阅读材料,暂时没有视频;

斯坦福大语言模型课程,内容比较浅,暂时也没有视频;

HuggingFace的Transformer课程;

Class Central的大语言模型课程;

Rycolab的大语言模型课程;

DeepLearning.AI的系列课程,深入浅出,内容也比较全面,吴恩达老师出品;

Langchain 例子;

阅读资料:

Understanding Large Language Models-A Transformative Reading List;

The Annotated Transformer;

The Illustrated Transformer;

Large Language Model Cheat Sheet;

🎨总结

大模型是深度学习领域的一种重要模型,具有参数数量庞大、泛化能力强等特点。大模型在自然语言处理、计算机视觉、语音识别等领域取得了显著的成果,并在多个行业得到了广泛的应用。

大模型的学习线路可以分为以下几个步骤:

1. 学习基础知识:了解机器学习、深度学习、自然语言处理等基础知识,掌握常用的数学、编程和算法知识。

2. 学习深度学习框架:熟悉至少一种深度学习框架,如TensorFlow、PyTorch等,掌握其基本原理和使用方法。

3. 学习模型优化技术:了解常见的模型优化技术,如剪枝、量化、分片等,掌握相应的实现方法。

4. 学习硬件加速技术:了解常见的硬件加速技术,如GPU、FPGA、ASIC等,了解它们的特点、优缺点和使用方法。

5. 学习模型并行化技术:掌握模型并行化的基本原理和实现方法,了解模型并行化在大模型推理加速中的应用。

6. 学习分布式计算技术:学习分布式计算的基本原理和实现方法,了解分布式计算在大模型推理加速中的应用。

7. 实践和项目经验:通过实践和参与实际项目,加深对大模型的理解和应用能力,积累实际经验。

在整个学习过程中,需要注意保持学习的持续性和系统性,不断学习和探索新技术、新方法,以适应快速发展的机器学习和自然语言处理领域。同时,也需要注重实践和应用,将所学知识应用到实际项目中,提升自己的实际能力和经验。

以下是一些学习大模型的建议:

● 选择合适的学习资源:大模型的学习资源非常丰富,可以从书籍、博客、论文、课程等多种渠道获取。在选择学习资源时,要注意资源的质量和适合性。

● 制定学习计划:大模型的学习内容非常多,需要制定一个合理的学习计划,循序渐进地学习。

● 加入学习社区:加入学习社区可以与其他同学交流学习经验,共同进步。

● 积极参与实践:积极参与实践可以加深对大模型的理解,提升自己的应用能力。

大模型是人工智能领域的重要研究方向,具有广阔的应用前景。通过系统的学习,可以掌握大模型的相关知识和技能,为未来的人工智能发展做出贡献。