摘要

在理解机器学习机制的过程中,我们探讨了在合成数据集上训练简单线性回归模型的过程。整个过程要解决的问题是算法如何通过迭代优化来学习输入和输出变量之间的基本关系。

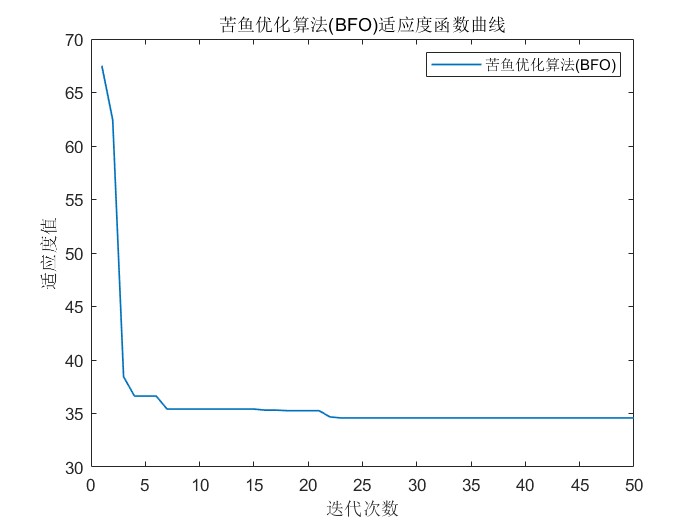

我们的方法包括生成一个合成线性数据集,实施梯度下降进行参数估计,并使用均方误差评估模型的性能。结果表明,模型成功地学习了线性关系,这体现在迭代时损失呈下降趋势,且均方误差较低。

本练习展示了机器学习的基本学习机制,说明了算法如何调整参数以尽量减少误差并准确预测结果。

**关键词:**机器学习基础;线性回归示例;梯度下降算法;合成数据集训练;参数估计技术。

简介

学习机制,尤其是在机器学习算法的背景下,是一个多层面的话题,包括了解算法如何从数据中学习,将学习重构为使用微分和梯度下降进行参数估计,从头开始开发一个简单的学习算法,以及探索 PyTorch 如何通过其自动微分机制 autographed 来支持学习。本文将深入探讨每个组成部分,以全面了解学习机制。

学习不仅是一种获取行为,也是一个适应过程,在这个过程中,知识不仅是收集来的,也是由经验的轮廓塑造出来的。

了解算法如何从数据中学习

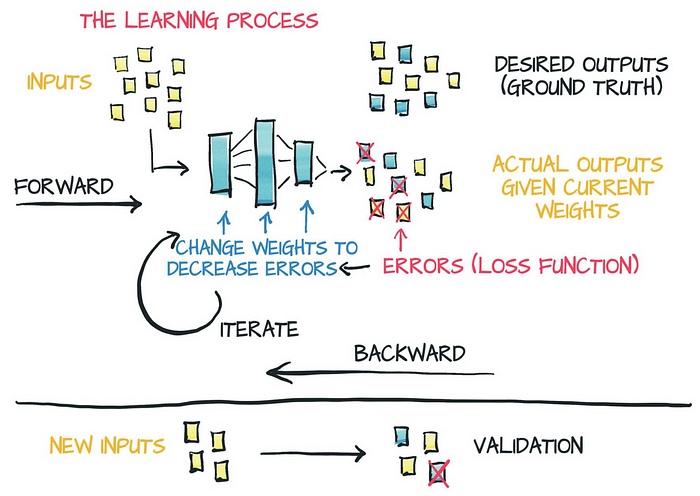

机器学习的核心是算法从数据中学习的能力。在这种情况下,学习指的是算法通过接触数据提高任务性能的过程。这种性能的提高是通过调整算法的内部参数来实现的,以应对其处理的数据。例如,在监督学习中,算法在包含输入-输出对的数据集上进行训练,目的是学习从输入到输出的映射。算法根据输入数据进行预测,并根据预测结果与实际结果之间的差异调整参数,从而随着时间的推移将差异最小化。

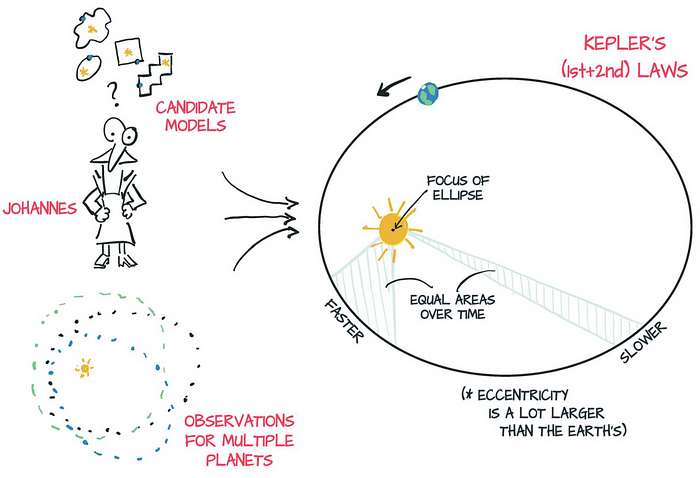

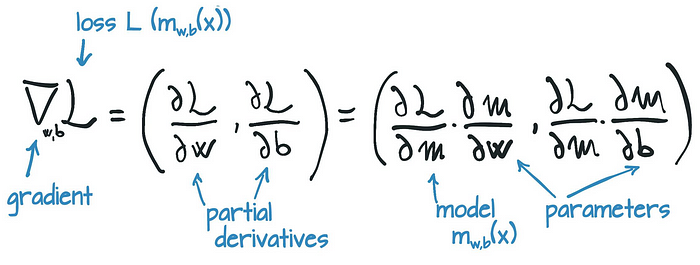

将学习重构为参数估计

学习可以重构为参数估计问题,其目标是找到最能解释观测数据的参数集。这一过程通常涉及微分和梯度下降。微分法决定如何调整参数,以尽量减小算法预测与实际数据之间的误差。梯度下降是一种优化算法,通过迭代将参数向误差最小的方向移动。通过反复计算与参数有关的误差梯度,并以梯度的相反方向更新参数,该算法会逐渐收敛到误差最小的参数集。

从零开始学习简单的学习算法

要具体理解学习的机制,从头开始学习一个简单的学习算法很有启发。考虑一个线性回归模型,其目标是找到一组数据点的最佳拟合线。该模型有两个参数:斜率和直线截距。学习过程包括计算损失(通常是预测值与实际值之间的均方误差),计算损失与每个参数的梯度,并根据梯度更新参数。模型通过反复执行这些步骤来学习最适合数据的参数。

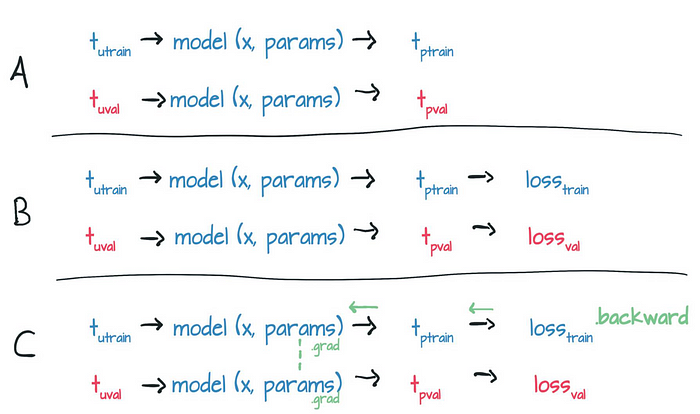

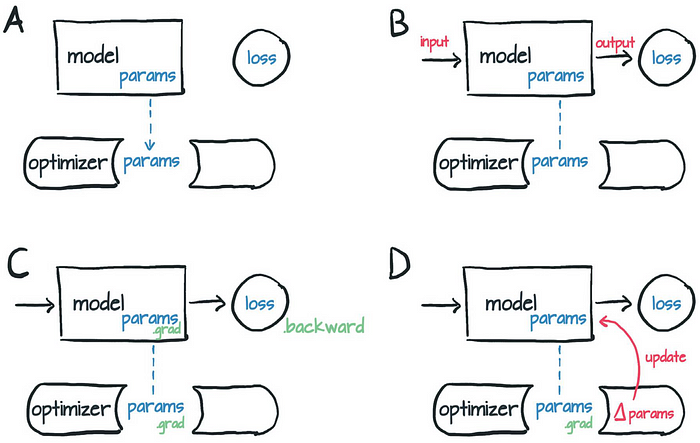

PyTorch 和 Autograd

PyTorch 是一个流行的开源机器学习库,为开发和训练机器学习模型提供了丰富的生态系统。PyTorch 的关键功能之一是 autograd,即自动微分机制。Autograd 可自动计算导数,这对实现梯度下降至关重要。有了 Autograd,开发人员就可以专注于设计模型和定义前向传递(模型如何进行预测)。PyTorch 会在后向(模型学习的步骤)过程中自动计算梯度,从而简化学习算法的实施过程。

代码

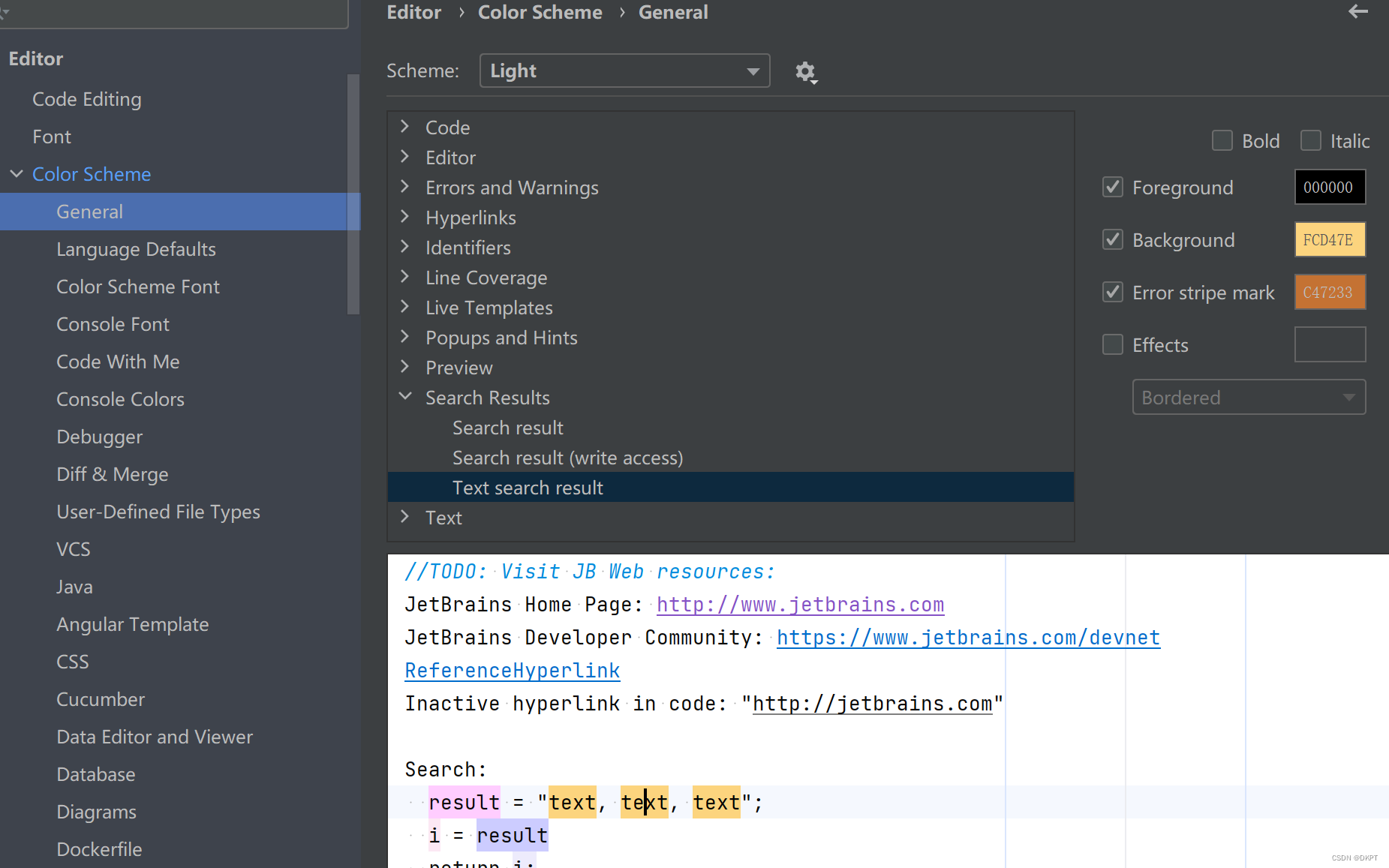

为了说明学习机制,让我们用一个合成数据集来看一个完整的 Python 示例。我们将创建一个简单的线性回归模型,对其进行训练,评估其性能并绘制结果图。这将包括生成一个人工数据集、执行一个基本的学习算法、测量其性能并解释结果。

首先,我们需要导入必要的库来设置环境:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.metrics import mean_squared_error

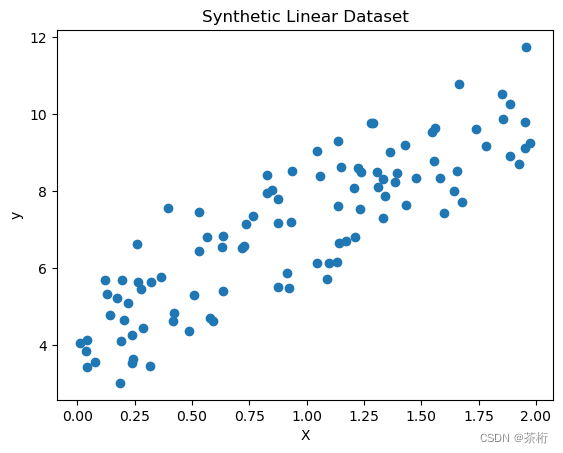

生成合成数据集

我们将创建一个合成数据集,该数据集遵循线性关系,并添加了一些噪声。

# Set the random seed for reproducibility

np.random.seed(0)# Generate synthetic data

X = 2 * np.random.rand(100, 1)

y = 4 + 3 * X + np.random.randn(100, 1)# Plot the synthetic data

plt.scatter(X, y)

plt.title("Synthetic Linear Dataset")

plt.xlabel("X")

plt.ylabel("y")

plt.show()

实施简单的学习算法

我们将使用梯度下降学习算法来实现一个基本的线性回归模型。

# Initialize parameters

w = np.random.randn(1, 1) # Weight

b = np.random.randn() # Bias# Learning rate

learning_rate = 0.01# Number of iterations

iterations = 1000# Training using Gradient Descent

for i in range(iterations):# Predictionsy_pred = X.dot(w) + b# Compute the loss (Mean Squared Error)loss = np.mean((y_pred - y) ** 2)# Compute the gradientsw_grad = 2/len(X) * X.T.dot(y_pred - y)b_grad = 2/len(X) * np.sum(y_pred - y)# Update parametersw -= learning_rate * w_gradb -= learning_rate * b_grad# Print the loss every 100 iterationsif i % 100 == 0:print(f"Iteration {i}: Loss {loss}")---

Iteration 0: Loss 81.0287983452256

Iteration 100: Loss 1.3412078261208689

Iteration 200: Loss 1.1664378082856437

Iteration 300: Loss 1.0837415754330317

Iteration 400: Loss 1.0403492394094551

Iteration 500: Loss 1.0175794060119359

Iteration 600: Loss 1.0056310904780545

Iteration 700: Loss 0.999361292996188

Iteration 800: Loss 0.9960712593213872

Iteration 900: Loss 0.9943448364803573

评估模型

训练模型后,我们使用均方误差 (MSE) 评估其性能。

# Calculate the predictions with the trained model

y_pred = X.dot(w) + b# Calculate and print the MSE

mse = mean_squared_error(y, y_pred)

print(f"Mean Squared Error: {mse}")---

Mean Squared Error: 0.9934389078119494

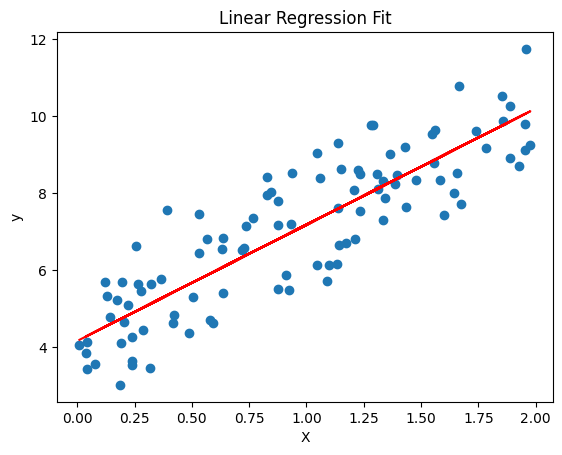

绘制结果图

最后,我们可以直观地看出模型与数据的拟合程度。

# Plot the original data and the regression line

plt.scatter(X, y)

plt.plot(X, y_pred, color='red')

plt.title("Linear Regression Fit")

plt.xlabel("X")

plt.ylabel("y")

plt.show()

释义

该图显示了我们的线性回归模型与合成数据的拟合情况。如果直线紧跟数据点的趋势,则说明我们的模型已经成功地学习到了潜在的关系。MSE 是衡量模型预测数据效果的数值。MSE 越低,表示拟合效果越好。

本示例演示了简单线性回归背景下的学习机制,包括生成数据、实施学习算法、评估其性能和解释结果。

您提供的图是线性回归模型应用于数据集的图示。蓝点代表单个数据点,它们在 X(自变量)轴和 y(因变量)轴之间具有某种形式的线性关系。红线代表通过数据点的最佳拟合线,即线性回归模型在给定 X 的情况下对 y 的预测。

这条线通过数据分布的 “中心”,与数据拟合良好,表明模型很可能捕捉到了潜在的趋势。线性回归算法的目标是最小化该直线与所有数据点之间的距离,通常是通过减小各点与直线垂直距离的平方和(最小二乘法)。

从图中可以看出,线性模型已经成功地掌握了两个变量之间的关系,并能根据自变量 X 预测因变量 y,准确度相当高。然而,为了定量评估模型的性能,我们需要检查均方误差或 R 平方值等指标,而这些指标并没有在图中显示。

结论

机器学习中的学习机制涉及理解算法如何处理数据和从数据中学习,将学习视为通过微分和梯度下降进行参数估计的过程,通过开发简单的学习算法,以及利用 PyTorch autographed 等工具高效地实现这些算法。这种研究学习机制的综合方法为开发高级机器学习模型和理解驱动其性能的基本原理奠定了坚实的基础。

参考

-

“Unraveling Meta-Learning: Understanding Feature Representations for Few-Shot Tasks”. [Online]. Available at: DOI: 10.48550/arXiv.2002.06753.

-

“How Do Transformers Learn Topic Structure: Towards a Mechanistic Understanding”. [Online]. Available at: DOI: 10.48550/arXiv.2303.04245.

-

“Power of Quantum Generative Learning”. [Online]. Available at: DOI: 10.48550/arXiv.2205.04730.

-

“The Modern Mathematics of Deep Learning”. [Online]. Available at: DOI: 10.1017/9781009025096.002.

-

“Deciphering and integrating invariants for neural operator learning with various physical mechanisms”. [Online]. Available at: DOI: 10.1093/nsr/nwad336.

-

“Understanding the Mechanics of Some Localized Protocols by Theory of Complex Networks”. [Online]. Available at: DOI: 10.48550/arXiv.1410.8007.

-

“Recent Advances and Applications of Machine Learning in Experimental Solid Mechanics: A Review”. [Online]. Available at: DOI: 10.1115/1.4062966.