目录

前言

准备工作

简单爬虫实现

注意事项

爬虫伦理与合法性

总结

前言

在互联网时代,数据是宝贵的资源。然而,当需要从海量网站中抓取数据时,手动操作显然不切实际。这时,爬虫技术应运而生,成为我们获取数据的重要工具。本文将带你走进Python爬虫的世界,通过编写一个简单的爬虫程序,学会如何从网站上爬取文章内容,并将其保存到本地文件中。

准备工作

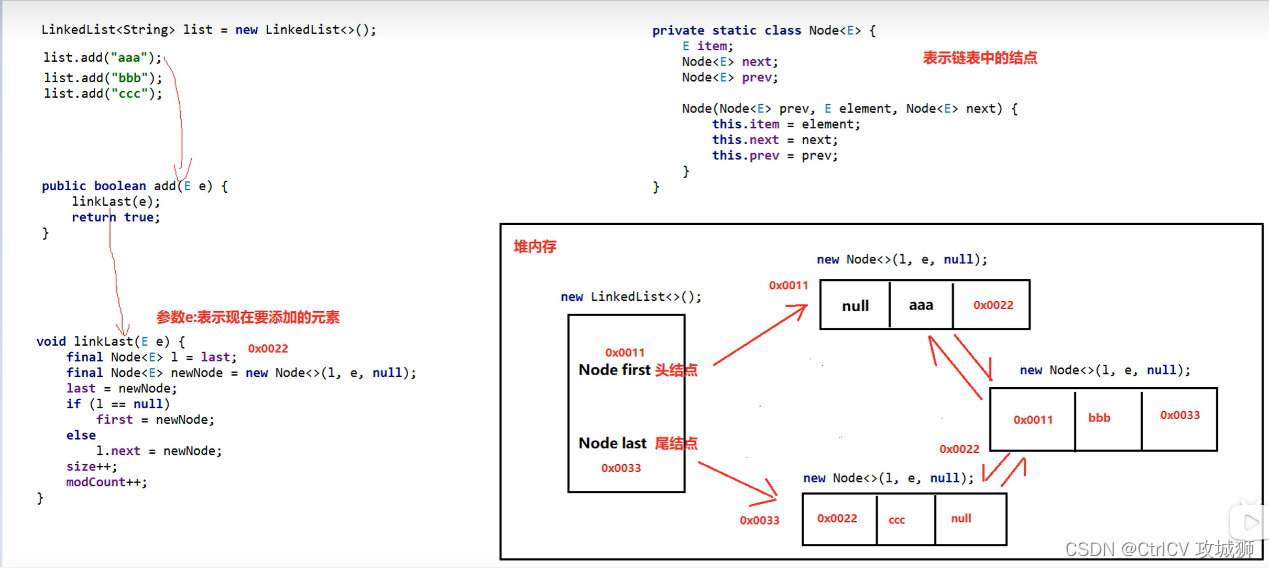

在开始编写爬虫程序之前,我们需要准备两个关键的Python库:requests和BeautifulSoup。requests库用于发送HTTP请求获取网页内容,而BeautifulSoup库则用于解析HTML内容并提取所需数据。你可以通过以下命令安装这两个库:

pip install requests

pip install beautifulsoup4简单爬虫实现

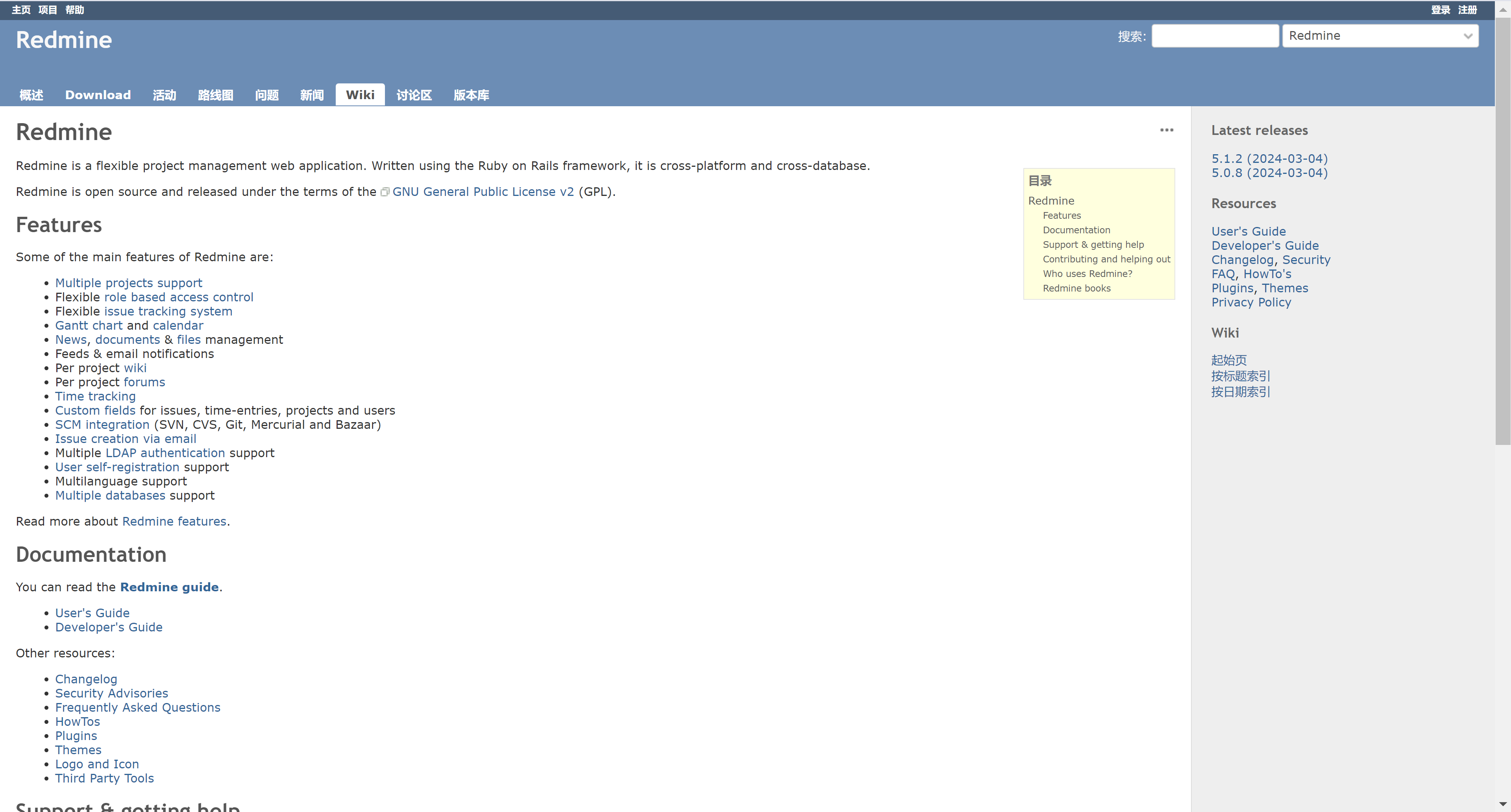

接下来,我们将编写一个简单的爬虫程序来演示如何爬取网站上的文章内容。假设我们要爬取的网站URL为https://example.com/articles。

import requests

from bs4 import BeautifulSoup # 设置目标网站的URL

url = 'https://example.com/articles' # 发送HTTP GET请求获取网页内容

response = requests.get(url)

response.encoding = 'utf-8' # 设置网页内容的编码格式 # 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser') # 查找文章列表所在的HTML元素

articles = soup.find_all('div', class_='article') # 遍历文章列表,提取标题和内容

for article in articles: title = article.find('h2').text.strip() # 提取标题并去除空白字符 content = article.find('p').text.strip() # 提取内容并去除空白字符 # 打印提取到的标题和内容 print(f"标题:{title}") print(f"内容:{content}\n") # 将文章内容保存到本地文件

with open('articles.txt', 'w', encoding='utf-8') as file: for article in articles: title = article.find('h2').text.strip() content = article.find('p').text.strip() # 将标题和内容写入文件,并在每篇文章之间添加空行分隔 file.write(f"标题:{title}\n内容:{content}\n\n")

上面首先通过requests库发送HTTP GET请求获取目标网页的内容。然后,使用BeautifulSoup库解析HTML内容,并找到包含文章的HTML元素。接下来,遍历这些元素,提取每篇文章的标题和内容,并打印到控制台。最后,将提取到的文章内容保存到名为articles.txt的本地文件中。

注意事项

虽然上面的示例代码展示了基本的爬虫实现过程,但实际的爬虫程序可能会更加复杂。因为不同的网站可能有不同的HTML结构,需要针对具体情况进行调整。此外,在进行爬取时,务必遵守网站的爬取规则,尊重对方的服务器资源,避免对网站造成过大的访问压力。

爬虫伦理与合法性

在使用爬虫技术时,我们需要遵循爬虫伦理,确保我们的行为合法合规。这包括尊重网站的robots.txt文件、设置合理的爬取频率、避免对网站造成过大的负担等。同时,我们也要尊重数据的版权和隐私,不要将爬取到的数据用于非法用途。

总结

通过本文的介绍,相信你对Python爬虫有了更深入的了解。爬虫技术为我们提供了一种高效的数据采集方式,能够帮助我们从海量的网络数据中快速获取所需信息。但请记住,在使用爬虫技术时,务必遵守相关规则和伦理准则,确保我们的行为合法合规。希望你在未来的学习和实践中能够运用爬虫技术实现更多的数据采集需求。