去年,AutoGPT的出现让我们见识到了AI代理强大的自动化能力,并开创了一个全新的AI代理赛道。但在子任务调度、资源分配以及AI之间协作还有不少的难题。

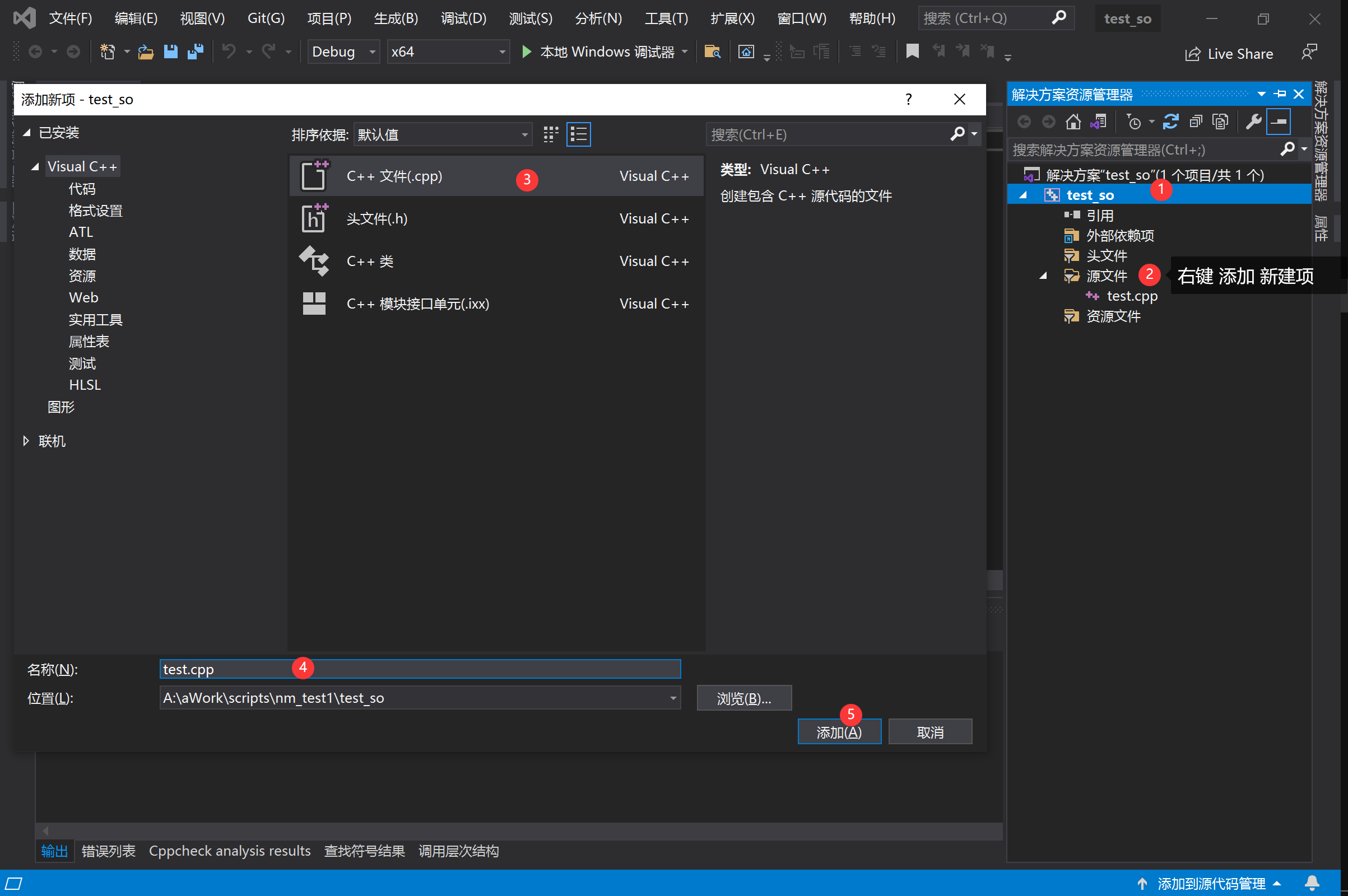

因此,罗格斯大学的研究人员开源了AIOS,这是一种以大模型为核心的AI代理操作系统。可有效解可决随着AI代理的增加,资源调用率低的难题,同时能促进代理之间的上下文切换、实现并发执行代理并维护代理的访问控制。

开源地址:https://github.com/agiresearch/AIOS

论文地址:https://arxiv.org/abs/2403.16971

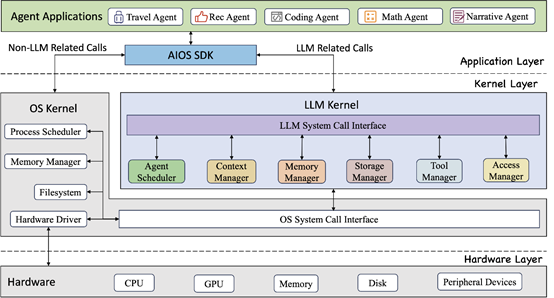

AIOS的架构和我们使用的PC操作系统差不多,主要分为应用层、内核层和硬件层三大块。唯一不同的是,AIOS在内核层中构建了一个专门管理与大模型相关任务的内核管理器。

应用层,主要由代理应用程序构成(例如,旅行代理、数学代理、代码代理等);内核层由传统OS系统和大模型相结合开发,OS系统主要用于文件管理,大模型则用于AI代理的调度和管理;

硬件层由CPU、GPU、内存和外设等硬件设备构成,但是大模型的内核无法与硬件直接交互,而是通过内核层提供的调用来间接管理硬件资源,以确保系统完整性和效率。

AI代理调度器

AI代理调度器主要负责对大模型的代理请求进行合理调度和优化,以充分利用大模型的计算资源。当多个代理同时向大模型发起请求时,调度器需根据特定调度算法对请求进行排序,避免单一代理长时间占用大模型而导致其他代理长时间等待。

此外,AIOS的设计还支持更复杂的调度策略,例如,考虑代理请求间的依赖关系,以实现更优化的资源分配。

在没有调度指令时,代理需按顺序逐一执行任务,后续代理需等待较长时间;而采用调度算法后,各代理的请求能够交错并行执行,显著降低了整体等待时间和响应延迟。

上下文管理器

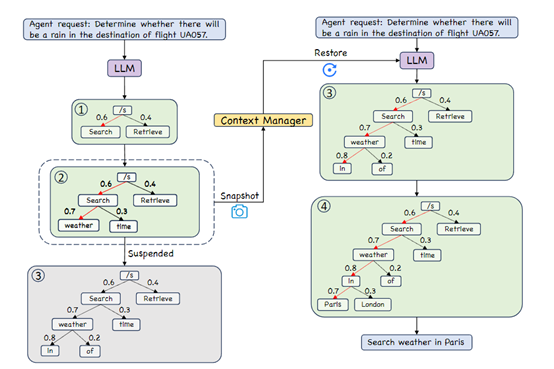

由于大模型生成过程普遍采用Beam Search等启发式搜索,会逐步构建搜索树并评估不同路径最终给出结果。

但在生成过程中大模型若被调度器中断,为避免所有中间状态丢失而浪费之前的计算,上下文管理器会对当前的Beam Search树状态(包括各路径概率等)进行快照保存。

当大模型重新获得执行资源后,上下文管理器能够准确地从中断处恢复之前的Beam Search状态,继续生成剩余部分,确保最终结果的完整性和准确性。

此外,多数大模型存在上下文长度限制,而实际场景中的输入上下文往往会超出该限制。为解决这一难题,上下文管理器集成了文本摘要等功能,能够对过长的上下文进行压缩或分块处理,使大模型能够高效理解并处理长上下文信息。

内存管理器

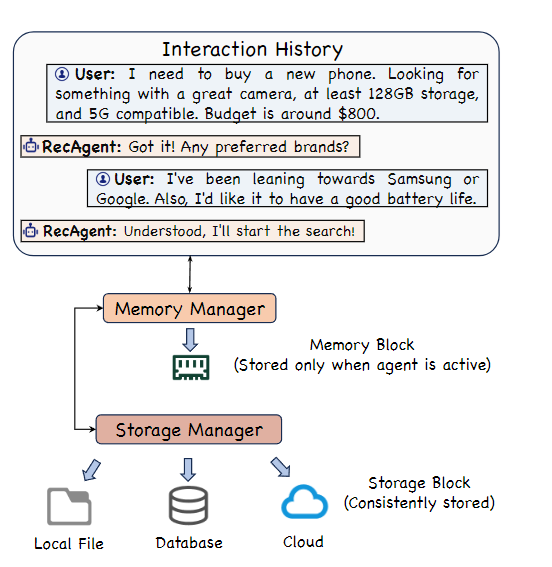

内存管理器主要负责管理短期内存资源,为每个AI代理的交互日志和中间数据提供高效的临时存储。

当AI代理处于等待执行或正在运行状态时,其所需的数据将被保存在由内存管理器分配的内存块中。一旦代理任务结束,相应的内存块也会被系统回收,以确保内存资源的高效利用。

AIOS会为每个AI代理分配独立的内存,并通过访问管理器来实现不同代理之间内存隔离。未来,AIOS会引入更复杂的内存共享机制和层级缓存策略,以进一步优化AI代理的整体性能。

本文素材来源AIOS论文,如有侵权请联系删除

END