书接上文——《数据探险家的终极指南:用Python挖掘机器学习的奥秘》

前文我们在这段精彩的机器学习探险之旅中,从基础概念出发,深入探索了使用Python和scikit-learn库进行数据分析和模型构建的全过程。

我们首先了解了机器学习的基本原理,包括监督学习、无监督学习以及强化学习,并为探险准备了必要的工具——安装和配置了scikit-learn库。

数据预处理是探险的重要环节,我们学习了如何加载和查看数据,处理缺失值,进行数据转换和标准化,以及类别变量编码。随后,我们掌握了特征选择与提取的技巧,包括特征重要性分析和主成分分析(PCA)。

在分类算法的篇章中,我们接触了线性模型如逻辑回归和支持向量机(SVM),非线性模型如决策树和随机森林,以及过拟合问题和交叉验证的解决方案~

文章目录

- 6. 聚类算法

- 6.1 K-means聚类

- 6.2 层次聚类

- 7. 降维技术

- 7.1 主成分分析(PCA)深入

- 7.2 t-SNE

- 8. 模型评估与选择

- 8.1 评估指标

- 8.2 模型选择与调优

- Grid Search与Randomized Search

- 9. 结论

- sklearn库学习总结

- 机器学习实践中的注意事项

- 参考文献

- 在线资源

6. 聚类算法

聚类算法在机器学习中就像是一群探险队员围坐在篝火旁,分享他们一天的发现。通过交流,他们开始意识到,尽管森林广阔,但可以根据树木的种类、地形的起伏,将森林划分成不同的区域。在数据科学中,聚类算法帮助我们发现数据内在的结构,将数据点分组成相似的簇。

6.1 K-means聚类

K-means聚类是聚类算法中的“老马识途”,它通过迭代地移动“质心”来将数据点划分为K个簇。这就像是你根据地图上的标记,将森林划分为几个区域,每个区域都有其独特的特征。

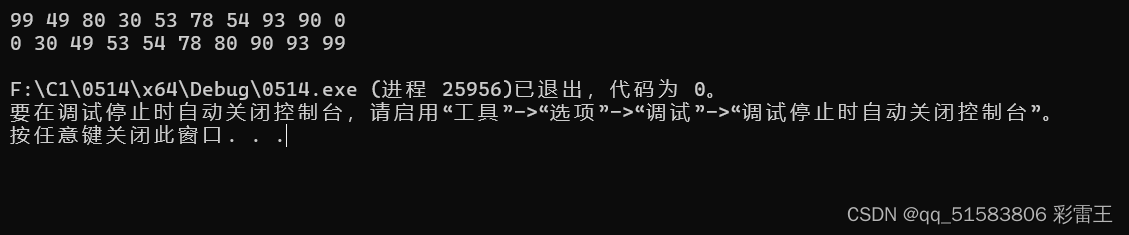

下面是一个使用K-means聚类的例子:

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt# 创建K-means聚类对象,假设我们想要分成3个簇

kmeans = KMeans(n_clusters=3)# 训练模型

kmeans.fit(X)# 预测每个点的簇标签

labels = kmeans.predict(X)# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis')

plt.scatter(kmeans.cluster_centers_[:, 0], kmeans.cluster_centers_[:, 1], s=300, c='red', marker='x')

plt.title('K-means Clustering')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.show()

在这个例子中,X 是我们的数据集,我们使用K-means算法将其分成3个簇,并通过散点图展示了聚类结果。

6.2 层次聚类

层次聚类则像是一群探险队员根据亲疏关系逐渐形成不同的小团体。层次聚类通过构建一个聚类树(称为“谱系图”或“树状图”)来组织数据点,从而不需要预先指定簇的数量。

以下是使用层次聚类的一个简单示例:

from sklearn.cluster import AgglomerativeClustering

import matplotlib.pyplot as plt

from sklearn import datasets# 使用scikit-learn内置的鸢尾花数据集

iris = datasets.load_iris()

X = iris.data# 创建层次聚类对象,这里我们没有指定簇的数量

hierarchical = AgglomerativeClustering(n_clusters=None)# 训练模型

hierarchical.fit(X)# 可视化聚类树状图

plt.figure(figsize=(12, 8))

plt.title('Hierarchical Clustering Dendrogram')

plt.xlabel('Sample index')

plt.ylabel('Distance')

plt.show()

在这个例子中,我们使用了鸢尾花数据集,并让层次聚类算法自动决定簇的数量,通过树状图展示了聚类的过程。

聚类算法不仅帮助我们理解数据的内在结构,还能揭示数据中可能未被注意到的模式和关联。在下一章,我们将学习降维技术,这就像是用望远镜观察星空,虽然星星繁多,但我们可以通过降维技术将它们分组,更清晰地看到星座的轮廓。准备好了吗?让我们继续我们的探险,揭开数据的神秘面纱吧!

7. 降维技术

在机器学习的旅途中,降维技术就像是一副神奇的眼镜,它帮助我们在复杂的数据星系中,找到那些最亮的星星。通过降维,我们可以简化数据的复杂性,同时保留最重要的信息,让数据的模式和结构更加清晰可见。

7.1 主成分分析(PCA)深入

主成分分析(PCA)是我们在第3章初步探索过的技术,现在让我们更深入地了解它。PCA就像是一张星系地图,它通过找到数据中最重要的方向(主成分),来简化我们的数据星系。

举个例子,我们可以使用PCA来降低鸢尾花数据集的维度,从四个特征降到两个,以便进行可视化:

from sklearn.decomposition import PCA

from sklearn import datasets

import matplotlib.pyplot as plt# 加载鸢尾花数据集

iris = datasets.load_iris()

X = iris.data# 创建PCA对象,将数据降到2维

pca = PCA(n_components=2)# 对数据进行降维

X_pca = pca.fit_transform(X)# 可视化降维后的数据

plt.figure(figsize=(8, 6))

plt.scatter(X_pca[:, 0], X_pca[:, 1], c=iris.target, cmap='viridis')

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.colorbar()

plt.title('PCA of IRIS dataset')

plt.show()

在这个例子中,我们首先加载了鸢尾花数据集,然后使用PCA将其降到了两个主成分,并通过散点图展示了降维后的数据。

7.2 t-SNE

t-SNE(t-分布随机邻域嵌入)是另一种强大的降维技术,尤其擅长将高维数据降到二维或三维,用于可视化。t-SNE就像是一台高分辨率的望远镜,它能够让我们在复杂的数据星系中,看到更多细节。

下面是一个使用t-SNE的例子:

from sklearn.manifold import TSNE# 使用PCA降维后的数据

X_pca = pca.fit_transform(X)# 创建t-SNE对象

tsne = TSNE(n_components=2, random_state=0)# 对数据进行降维

X_tsne = tsne.fit_transform(X_pca)# 可视化t-SNE的结果

plt.figure(figsize=(8, 6))

plt.scatter(X_tsne[:, 0], X_tsne[:, 1], c=iris.target, cmap='viridis')

plt.xlabel('t-SNE Feature 1')

plt.ylabel('t-SNE Feature 2')

plt.colorbar()

plt.title('t-SNE Visualization of IRIS dataset')

plt.show()

在这个例子中,我们首先使用PCA将数据降到了两个主成分,然后使用t-SNE进一步将数据降到了两个维度,并通过散点图展示了t-SNE的结果。

通过降维技术,我们不仅能够更直观地理解数据,还能够提高机器学习模型的效率和性能。在下一章,我们将学习如何评估和选择模型,这就像是在探险结束后,回顾我们的路线,评估哪些决策是正确的,哪些可以改进。准备好了吗?让我们继续前进,成为更优秀的数据探险家!

8. 模型评估与选择

在机器学习的探险旅程中,评估和选择模型就像是我们在探险结束后,围坐在篝火旁回顾一天的经历。我们需要确定哪些策略有效,哪些不太行,以便为下一次探险做出更好的准备。在这一章,我们将探讨如何评估模型的性能,并选择最适合我们数据的模型。

8.1 评估指标

评估指标就像是我们探险队的成绩单,它告诉我们每个模型的表现如何。不同的任务需要不同的评估指标:

- 准确率:这是最直观的指标,告诉我们模型正确预测的比例。

- 召回率:特别适用于分类问题,它衡量了模型识别所有正类样本的能力。

- F1分数:是准确率和召回率的调和平均,给我们一个平衡两者的指标。

在scikit-learn中,我们可以使用相应的函数来计算这些指标:

from sklearn.metrics import accuracy_score, recall_score, f1_score# 假设我们有一些真实标签y_true和模型预测的标签y_pred

y_true = [0, 1, 0, 1]

y_pred = [0, 1, 1, 0]# 计算准确率

accuracy = accuracy_score(y_true, y_pred)

print(f"Accuracy: {accuracy}")# 计算召回率

recall = recall_score(y_true, y_pred)

print(f"Recall: {recall}")# 计算F1分数

f1 = f1_score(y_true, y_pred)

print(f"F1 Score: {f1}")

8.2 模型选择与调优

模型选择和调优就像是在探险前精心挑选装备和规划路线。我们希望找到最合适的工具和路径来达到目的地。在机器学习中,这通常涉及到模型超参数的选择。

Grid Search与Randomized Search

- Grid Search:这是一种通过遍历给定的参数网格,来寻找最佳的参数组合的方法。就像是我们尝试不同的装备组合,看看哪一组在实际探险中表现最好。

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier# 定义参数网格

param_grid = {'n_estimators': [10, 50, 100],'max_depth': [None, 10, 20, 30]

}# 创建随机森林分类器和GridSearchCV对象

forest = RandomForestClassifier()

grid_search = GridSearchCV(forest, param_grid, cv=5)# 训练模型并进行参数调优

grid_search.fit(X_train, y_train)# 输出最佳参数

print(f"Best parameters: {grid_search.best_params_}")

- Randomized Search:与Grid Search不同,Randomized Search不是遍历所有可能的参数组合,而是随机选择参数进行搜索。这就像是我们随机尝试一些装备组合,看看是否有意外的好表现。

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import randint# 定义参数分布

param_dist = {'n_estimators': randint(10, 200),'max_depth': [None] + list(randint(1, 50).rvs(size=100))

}# 创建随机森林分类器和RandomizedSearchCV对象

rand_search = RandomizedSearchCV(forest, param_dist, cv=5, n_iter=100)# 训练模型并进行参数调优

rand_search.fit(X_train, y_train)# 输出最佳参数

print(f"Best parameters: {rand_search.best_params_}")

通过这些方法,我们可以找到最适合数据的模型和参数,从而提高模型的性能。

在下一章,我们将总结我们学到的所有知识,并讨论在机器学习实践中应注意的事项。这就像是在探险结束后,分享我们的经验和教训,为未来的旅程做好准备。准备好了吗?让我们继续前进,成为更出色的数据探险家!

9. 结论

在这段机器学习的探险旅程中,我们经历了从数据预处理到模型评估的每一个环节,就像在森林中寻找宝藏一样,我们学会了如何使用各种工具和技术来解读大自然的密码。现在,我们来到了旅程的终点,是时候回顾一下我们所学到的宝贵经验,并且思考如何将这些知识应用到未来的探险中。

sklearn库学习总结

scikit-learn库是机器学习领域的瑞士军刀,它为我们提供了从数据加载到模型训练、评估的一站式解决方案。通过这个库,我们学会了:

- 如何使用pandas加载和探索数据。

- 应用数据清洗技术,比如处理缺失值和标准化特征。

- 掌握特征选择和降维技术,比如PCA和t-SNE。

- 实施分类算法,包括线性模型和非线性模型,以及如何处理过拟合问题。

- 应用回归算法,从简单的线性回归到岭回归和Lasso回归。

- 探索聚类算法,发现数据的内在结构。

- 评估模型性能,使用不同的指标和调优技术,如Grid Search和Randomized Search。

机器学习实践中的注意事项

在实际应用机器学习时,有几点需要特别注意:

-

理解业务和数据:在开始任何机器学习项目之前,先花时间理解业务需求和数据特性。这有助于你选择合适的算法和评估指标。

-

数据质量:垃圾进,垃圾出。确保你的数据是准确和完整的,这对于模型的性能至关重要。

-

避免过拟合:通过交叉验证、正则化等技术,确保你的模型具有良好的泛化能力。

-

迭代和实验:机器学习是一个迭代的过程。不要期望第一次就能得到完美的模型。不断尝试不同的算法和参数,直到找到最佳解决方案。

-

模型解释性:一个好的模型不仅要准确,还要可解释。理解模型是如何做出预测的,这对于建立信任和透明度至关重要。

-

持续学习:机器学习是一个快速发展的领域。持续学习最新的技术和理论,可以帮助你保持竞争力。

通过本教程,我们不仅学习了如何使用scikit-learn库,还了解了机器学习项目的整个流程。现在,你已经准备好开始你自己的机器学习项目了。记住,每一次探险都是一次学习的机会,不断尝试,不断进步,你将成为一个出色的数据探险家!

在接下来的旅程中,愿你的模型总是准确的,你的预测总是靠谱的,你的机器学习之路充满发现和成功!如果你想要继续深入学习,或者在实践中遇到任何问题,记得查阅我们的参考文献,那里有丰富的资源和社区支持。祝你好运,数据探险家!

参考文献

在线资源

-

Scikit-Learn官方文档

- https://scikit-learn.org/stable/documentation.html

- 官方文档是学习scikit-learn的最佳起点,提供了丰富的教程和API文档。

-

Kaggle

- https://www.kaggle.com/

- Kaggle是数据科学竞赛的著名平台,提供大量的数据集和学习资源。

-

Coursera Machine Learning课程

- https://www.coursera.org/learn/machine-learning

- Andrew Ng的这门课程是机器学习领域的经典入门课程,适合初学者。

-

GitHub机器学习项目

- https://github.com/topics/machine-learning

- GitHub上有大量的开源机器学习项目,是学习和参考的好地方。

-

arXiv Machine Learning论文

- https://arxiv.org/list/cs/recent

- 对于想要跟踪机器学习领域最新研究的读者,arXiv是一个很好的资源。

回归算法让我们能够预测连续数值,我们学习了线性回归、岭回归和Lasso回归,并了解了如何处理多重共线性问题。

聚类算法帮助我们发现数据的内在结构,我们探讨了K-means聚类和层次聚类。降维技术如PCA和t-SNE,让我们能够简化数据,更清晰地看到数据的模式。

模型评估与选择是探险的关键,我们学习了如何使用不同的评估指标来衡量模型性能,并通过Grid Search和Randomized Search进行超参数调优。最后,我们总结了学习要点,并讨论了在机器学习实践中应注意的事项。

通过本教程,我们不仅学习了如何使用scikit-learn库,还了解了机器学习项目的整个流程。现在,你已经准备好开始你自己的机器学习项目了。记住,每一次探险都是一次学习的机会,不断尝试,不断进步,你将成为一个出色的数据探险家!