一 、 设置SSH免密登录

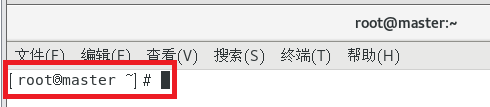

1、修改主机名

(1)打开 /etc/hostname 修改为:master

(2) 重启

在终端输入reboot

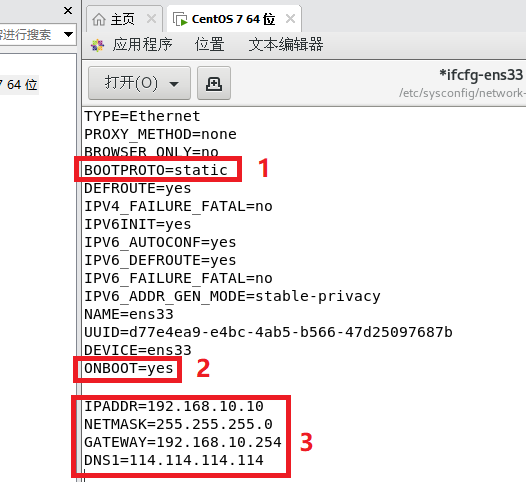

2、配置网卡

(1)改写网卡配置文件 /etc/sysconfig/network-scripts/ifcfg-ens33

#BOOTPROTO="dhcp" #注释

BOOTPROTO="static" #添加

#ONBOOT="no"

ONBOOT="yes"

#添加以下IP地址

IPADDR=192.168.10.10

NETMASK=255.255.255.0

GATEWAY=192.168.10.254

DNS1=114.114.114.114

重启网卡 systemctl restart network

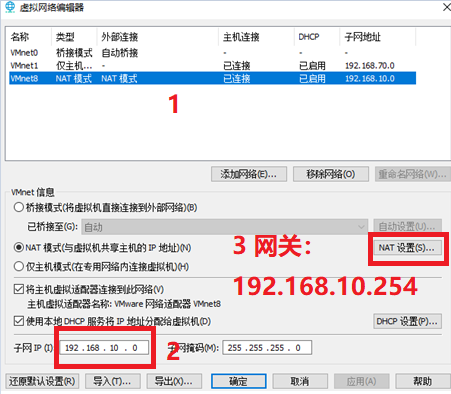

(2)编辑网络编辑器

(3)重启 reboot

查找ip ip addr

(4)网络连接

启动VMware Network Adapter VMnet8

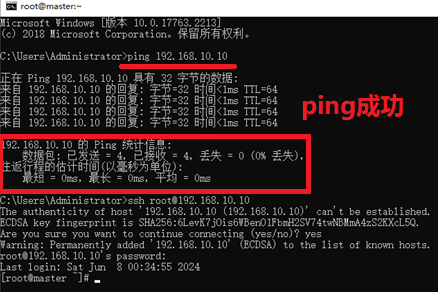

(5)在Windows的命令行窗口验证是否能够ping通

Ping 192.168.10.10

3、设置SSH免密登录

(1)验证虚拟机是否已经安装了SSH.

验证命令为 rpm -qa | grep ssh

命令输⼊后回⻋,如果出现下图的画⾯则说明SSH未安装,

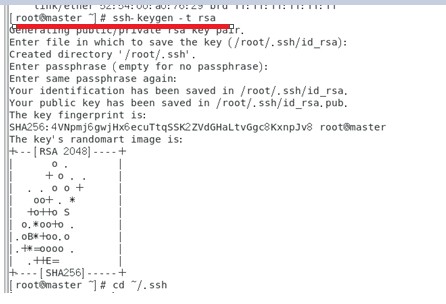

(2)⽣成SSH密钥

① 设置SSH免密登录前,需要⽣成密钥,⽣成SSH密钥的命令为:

ssh-keygen -t rsa

② 查看⽣成的密钥

cd ~/.ssh

ll

③ 然后将公玥(id_rsa.pub)拷⻉到当前⽬录的 /authorized_keys列表中,并修改authorized_keys的权限为600。

cat id_rsa.pub >> authorized_keys

chmod 600 authorized_keys

④ 验证是否真的可以免密登录虚拟机。

ssh master

二、 安装JDK。

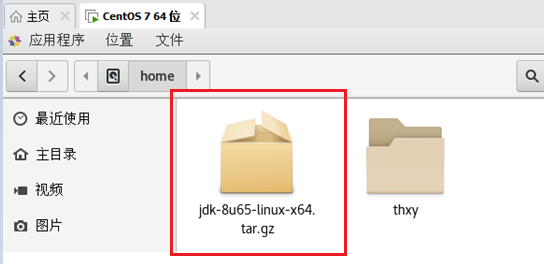

1、将“jdk-8u65-linux-x64.tar.gz”上传⾄当前⽤户的路径下。

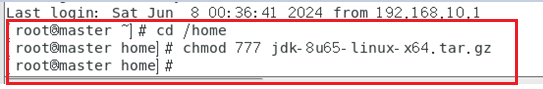

① 修改权限

在/home路径下,给jdk-8u65-linux-x64.tar.gz⽂件修改权限。

chmod 777 jdk-8u231-linux-x64.tar.gz

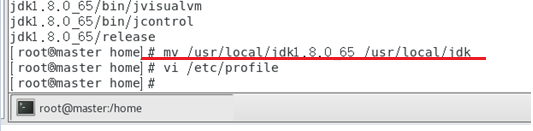

② 解压并重命名为jdk

tar -zxvf jdk-8u65-linux-x64.tar.gz -C /usr/local

mv /usr/local/jdk1.8.0_65 /usr/local/jdk

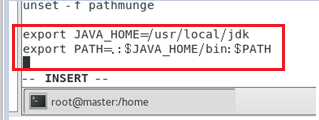

③ 配置环境变量

vi /etc/profile

配置内容:

export JAVA_HOME=/usr/local/jdk

export PATH=.:$JAVA_HOME/bin:$PATH

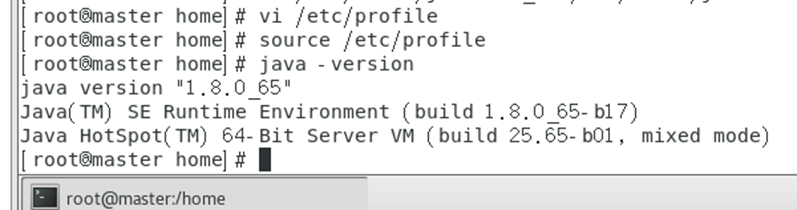

④ 执⾏source /etc/profile后⽣效

source /etc/profile

⑤ 测试

java -version

(看到java的版本说明成功了)

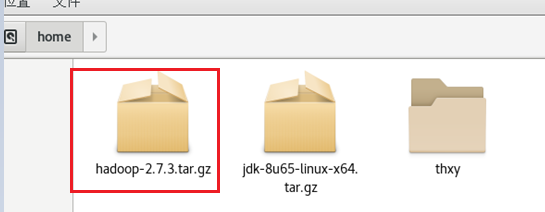

三、 Hadoop安装与配置。

1、Hadoop安装

(1)上传

上传安装包到虚拟机/home路径下

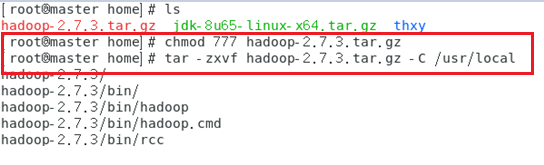

(2)修改权限

在/home执⾏

chmod 777 hadoop-2.7.3.tar.gz

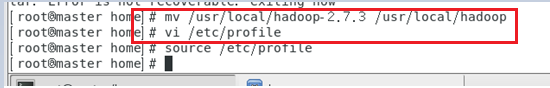

(3)解压并重命名为hadoop

tar -zxvf hadoop-2.7.3.tar.gz -C /usr/local

mv /usr/local/hadoop-2.7.3 /usr/local/Hadoop

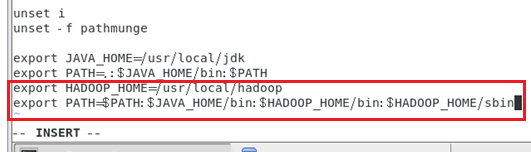

(4)配置环境变量

vi /etc/profile

配置内容:

export HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

(5)执⾏source /etc/profile后⽣效

source /etc/profile

2、Hadoop配置

Hadoop的配置⽂件有多个,包括

hadoop-env.sh

yarn-env.sh

core-site.xml

hdfs-site.xml

mapred-site.xml

yarn-site.xml

所有的配置⽂件均处于同⼀个⽬录(/usr/local/hadoop/etc/hadoop)下,下⾯依次介绍每个配置⽂件如何修改。

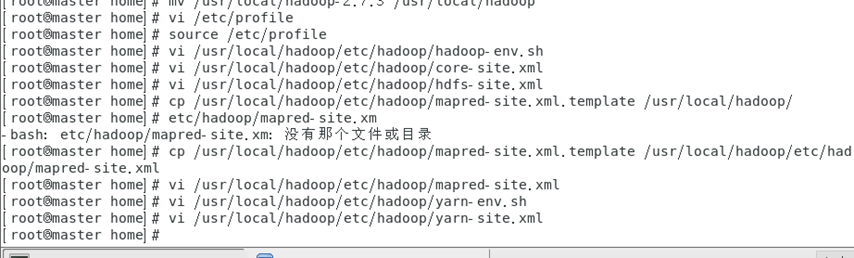

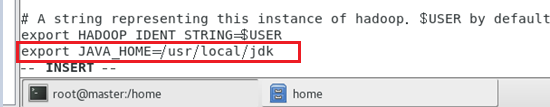

(1)修改hadoop-env.sh⽂件

在此配置⽂件中修改JDK的路径信息,将原来的值改为JDK的具体安装路径

vi /usr/local/hadoop/etc/hadoop/hadoop-env.sh

export JAVA_HOME=/usr/local/jdk

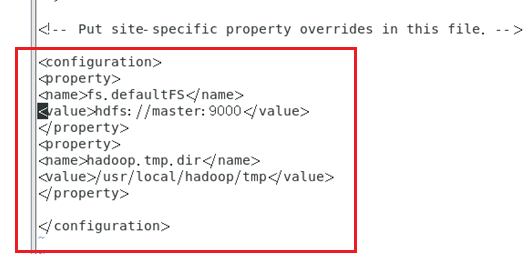

(2)修改core-site.xml⽂件

在此⽂件是Hadoop的核⼼配置⽂件,需要指定HDFS的NameNode的地址以及Hadoop运⾏时产⽣临时⽂件的保存⽬录

vi /usr/local/hadoop/etc/hadoop/core-site.xml

配置如下:

<configuration><property><name>fs.defaultFS</name><value>hdfs://master:9000</value></property><property><name>hadoop.tmp.dir</name><value>/usr/local/hadoop/tmp</value></property> </configuration>

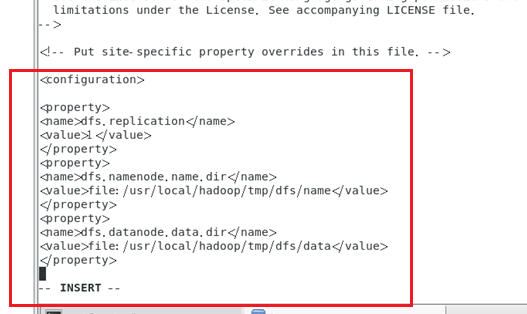

(3)修改hdfs-site.xml⽂件

此⽂件是HDFS相关的配置⽂件,

其中属性dfs.replication配置了HDFS保存数据的副本数量,默认值是3,伪分布式设置为1。属性dfs.namenode.name.dir和dfs.datanode.data.dir分别配置了NameNode元数据和DataNode元数据的存储位置。

vi /usr/local/hadoop/etc/hadoop/hdfs-site.xml

配置如下:

<configuration><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.namenode.name.dir</name><value>file:/usr/local/hadoop/tmp/dfs/name</value></property><property><name>dfs.datanode.data.dir</name><value>file:/usr/local/hadoop/tmp/dfs/data</value></property>

</configuration>

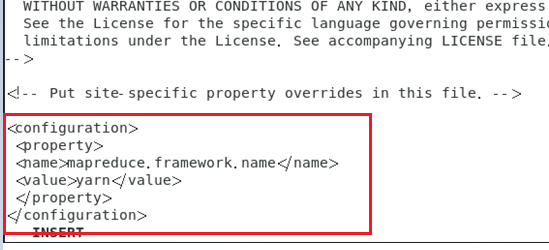

(4)修改mapred-site.xml

这是MapReduce的相关配置⽂件,因为Hadoop2.x版本引进了YARN资源管理器,故需指定Mapreduce运⾏是在YARN上。此⽂件在Hadoop的解压⽬录“/usr/local/hadoop/etc/Hadoop”下是不存在的,

但是存在⼀个⽂件名为mapred-site.xml.template的⽂件,可以通过此template⽂件复制⼀份。执⾏命令:

cp/usr/local/hadoop/etc/hadoop/mapred-site.xml.template/usr/local/hadoop/etc/hadoop/mapred-site.xml

再通过下⾯命令修改此⽂件内容

vi /usr/local/hadoop/etc/hadoop/mapred-site.xml

新增的内容, 配置如下:

<configuration><property><name>mapreduce.framework.name</name> <value>yarn</value></property> </configuration>

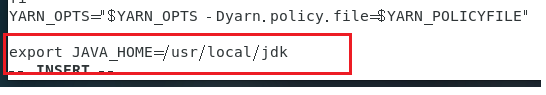

(5)修改yarn-env.sh⽂件

该⽂件是YARN框架运⾏环境的配置,同样需要修改JDK的路径信息,修改⽅式同hadoop-env.sh⽂件。

vi /usr/local/hadoop/etc/hadoop/yarn-env.sh

配置如下:

export JAVA_HOME=/usr/local/jdk

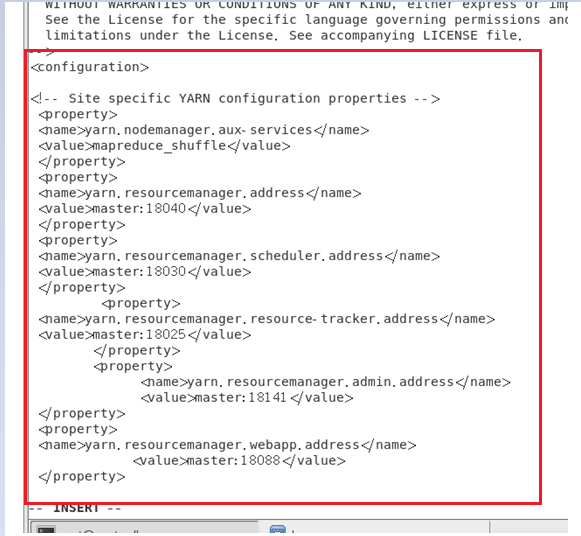

(6)修改yarn-site.xml⽂件

此⽂件是YARN框架的配置⽂件,需配置YARN进程及YARN相关属性。

⾸先要指明ResourceManager守护进程的主机和监听的端⼝,其主机为master,默认端⼝为8032,其次需要指定ResourceManager使⽤的scheduler以及NodeManager的辅助服务等信息。

vi /usr/local/hadoop/etc/hadoop/yarn-site.xml

配置如下:

<configuration><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.resourcemanager.address</name><value>master:18040</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>master:18030</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>master:18025</value></property><property><name>yarn.resourcemanager.admin.address</name><value>master:18141</value></property><property><name>yarn.resourcemanager.webapp.address</name><value>master:18088</value></property></configuration>

完成以上六个配置⽂件的配置后,Hadoop的环境基本配置完毕

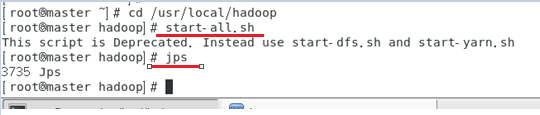

(7)启动Hadoop进⾏验证

start-all.sh

jps