引言

数据分析 Agent 是现代企业数据栈中的重要组件,它能够自动化数据分析流程,提供智能化的数据洞察。

1. 数据处理工具链设计

数据处理工具链是整个分析系统的基础设施,它决定了系统处理数据的能力和效率。一个优秀的工具链设计应该具备:

- 良好的可扩展性:能够轻松添加新的数据源和处理方法

- 高度的可配置性:通过配置而非代码修改来调整处理逻辑

- 稳定的容错能力:能够优雅处理各种异常情况

- 完善的监控机制:对处理过程进行全方位监控

1.1 数据接入层设计

数据接入层负责与各种数据源进行交互,将原始数据安全、高效地引入系统。下面是核心实现代码:

from typing import Dict, List, Union

from abc import ABC, abstractmethodclass DataConnector(ABC):"""数据源连接器基类为不同类型的数据源提供统一的接口规范:- 数据库(MySQL、PostgreSQL等)- 数据仓库(Snowflake、Redshift等)- 文件系统(CSV、Excel等)- API接口"""@abstractmethodasync def connect(self) -> bool:"""建立与数据源的连接Returns:bool: 连接是否成功"""pass@abstractmethodasync def fetch_data(self, query: str) -> pd.DataFrame:"""从数据源获取数据Args:query: 数据查询语句/参数Returns:pd.DataFrame: 查询结果数据框"""passclass DataProcessor:def __init__(self):# 存储各类数据源连接器的实例self.connectors: Dict[str, DataConnector] = {}# 预处理步骤pipelineself.preprocessing_pipeline = []async def process_data(self,source: str, # 数据源标识符query: str, # 查询语句preprocessing_steps: List[Dict] = None # 预处理步骤配置) -> pd.DataFrame:"""数据处理主函数完整的数据处理流程包括:1. 从指定数据源获取原始数据2. 执行配置的预处理步骤3. 返回处理后的数据框Args:source: 数据源标识符query: 查询语句preprocessing_steps: 预处理步骤配置列表Returns:pd.DataFrame: 处理后的数据框"""# 获取原始数据raw_data = await self.connectors[source].fetch_data(query)# 应用预处理步骤processed_data = raw_datafor step in (preprocessing_steps or []):processed_data = await self._apply_preprocessing(processed_data, step)return processed_dataasync def _apply_preprocessing(self,data: pd.DataFrame,step: Dict) -> pd.DataFrame:"""应用单个预处理步骤支持的预处理类型:- missing_value: 缺失值处理- outlier: 异常值处理- normalization: 数据标准化- encoding: 特征编码Args:data: 输入数据框step: 预处理步骤配置Returns:pd.DataFrame: 处理后的数据框"""step_type = step["type"]params = step["params"]if step_type == "missing_value":return await self._handle_missing_values(data, **params)elif step_type == "outlier":return await self._handle_outliers(data, **params)# ... 其他预处理类型return data

💡 最佳实践

实现数据源连接器的自动重试和故障转移

- 设置最大重试次数和重试间隔

- 实现优雅的降级策略

- 添加熔断机制防止连锁故障

使用连接池管理数据库连接

- 预先创建连接池提高性能

- 自动管理连接的生命周期

- 实现连接的健康检查

实现数据预处理步骤的可配置化

- 通过配置文件定义处理流程

- 支持动态加载新的处理器

- 提供处理步骤的依赖管理

添加数据质量检查机制

- 数据完整性验证

- 数据类型检查

- 业务规则验证

- 异常数据标记

1.2 数据清洗与转换

数据清洗与转换是数据分析中最重要的环节之一,它直接影响后续分析的质量。以下是核心实现:

class DataTransformer:def __init__(self, llm_service):self.llm = llm_service # LLM服务用于智能化的数据转换self.transformation_cache = {} # 缓存常用转换结果async def transform_data(self,data: pd.DataFrame,transformation_rules: List[Dict]) -> pd.DataFrame:"""数据转换主函数按照规则列表顺序执行数据转换:1. 数据类型转换2. 特征工程3. 数据聚合Args:data: 输入数据框transformation_rules: 转换规则配置列表Returns:pd.DataFrame: 转换后的数据框"""transformed_data = data.copy()for rule in transformation_rules:transformed_data = await self._apply_transformation(transformed_data,rule)return transformed_dataasync def _apply_transformation(self,data: pd.DataFrame,rule: Dict) -> pd.DataFrame:"""应用单个转换规则支持的转换类型:- type_conversion: 数据类型转换- feature_engineering: 特征工程- aggregation: 数据聚合Args:data: 输入数据框rule: 转换规则配置Returns:pd.DataFrame: 转换后的数据框"""rule_type = rule["type"]if rule_type == "type_conversion":return await self._convert_types(data, rule["params"])elif rule_type == "feature_engineering":return await self._engineer_features(data, rule["params"])elif rule_type == "aggregation":return await self._aggregate_data(data, rule["params"])return data

💡 数据转换最佳实践

类型转换

- 自动识别和修正数据类型

- 处理特殊格式(如日期时间)

- 保留原始数据备份

特征工程

- 使用 LLM 辅助特征创建

- 自动化特征选择

- 特征重要性评估

数据聚合

- 多维度聚合支持

- 灵活的聚合函数配置

- 结果正确性验证

2. SQL 生成和优化

在数据分析 Agent 中,SQL 生成和优化是连接用户意图和数据查询的关键环节。我们需要构建一个智能的 SQL 生成器,能够将自然语言转换为高效的 SQL 查询。

2.1 智能 SQL 生成器

from typing import Dict, List, Optional

from dataclasses import dataclass@dataclass

class TableSchema:"""表结构定义"""name: strcolumns: List[Dict[str, str]] # 列名和数据类型primary_key: List[str]foreign_keys: Dict[str, str] # 外键关系class SQLGenerator:def __init__(self, llm_service, schema_manager):self.llm = llm_serviceself.schema_manager = schema_managerself.query_templates = self._load_query_templates()async def generate_sql(self,user_intent: str,context: Dict = None) -> str:"""根据用户意图生成SQLArgs:user_intent: 用户查询意图context: 上下文信息(如时间范围、过滤条件等)Returns:str: 生成的SQL语句"""# 1. 解析用户意图parsed_intent = await self._parse_intent(user_intent)# 2. 识别相关表和字段relevant_tables = await self._identify_tables(parsed_intent)# 3. 构建SQL语句sql = await self._construct_sql(parsed_intent, relevant_tables, context)# 4. SQL优化optimized_sql = await self._optimize_sql(sql)return optimized_sqlasync def _parse_intent(self, user_intent: str) -> Dict:"""解析用户意图使用LLM将自然语言转换为结构化的查询意图:- 查询类型(聚合/明细/统计等)- 目标度量- 维度字段- 过滤条件- 排序要求"""prompt = f"""将以下数据分析需求转换为结构化格式:{user_intent}请提供:1. 查询类型2. 需要的指标3. 分析维度4. 筛选条件5. 排序规则"""response = await self.llm.generate(prompt)return self._parse_llm_response(response)

2.2 SQL 优化机制

class SQLOptimizer:def __init__(self, db_engine):self.db_engine = db_engineself.optimization_rules = self._load_optimization_rules()async def optimize_sql(self, sql: str) -> str:"""SQL优化主函数优化策略包括:1. 索引优化2. 表连接优化3. 子查询优化4. 聚合优化"""# 1. 解析SQLparsed_sql = self._parse_sql(sql)# 2. 获取执行计划execution_plan = await self._get_execution_plan(sql)# 3. 应用优化规则optimizations = []for rule in self.optimization_rules:if rule.should_apply(parsed_sql, execution_plan):optimization = await rule.apply(parsed_sql)optimizations.append(optimization)# 4. 重写SQLoptimized_sql = self._rewrite_sql(parsed_sql, optimizations)return optimized_sqlasync def _get_execution_plan(self, sql: str) -> Dict:"""获取SQL执行计划"""explain_sql = f"EXPLAIN ANALYZE {sql}"return await self.db_engine.execute(explain_sql)

💡 SQL优化最佳实践

索引优化

- 自动识别需要创建的索引

- 评估索引的使用情况

- 定期清理无效索引

查询重写

- 优化JOIN顺序

- 化简复杂子查询

- 使用临时表优化大量数据处理

性能监控

- 记录慢查询

- 分析执行计划

- 资源使用监控

3. 可视化集成方案

数据可视化是数据分析的重要输出形式,需要根据数据特征和分析目的自动选择合适的可视化方案。

3.1 智能图表推荐

class ChartRecommender:def __init__(self, llm_service):self.llm = llm_serviceself.chart_templates = self._load_chart_templates()async def recommend_chart(self,data: pd.DataFrame,analysis_goal: str) -> Dict:"""推荐合适的图表类型Args:data: 待可视化数据analysis_goal: 分析目标Returns:Dict: 图表配置信息"""# 1. 分析数据特征data_profile = await self._analyze_data(data)# 2. 匹配图表类型chart_type = await self._match_chart_type(data_profile,analysis_goal)# 3. 生成图表配置chart_config = await self._generate_chart_config(chart_type,data,analysis_goal)return chart_config

3.2 可视化渲染引擎

class VisualizationEngine:def __init__(self):self.renderers = {'plotly': PlotlyRenderer(),'echarts': EChartsRenderer(),'matplotlib': MatplotlibRenderer()}async def render_chart(self,data: pd.DataFrame,chart_config: Dict,renderer: str = 'plotly') -> str:"""渲染图表Args:data: 数据chart_config: 图表配置renderer: 渲染器类型Returns:str: 渲染后的图表(HTML或图片URL)"""renderer = self.renderers.get(renderer)if not renderer:raise ValueError(f"Unsupported renderer: {renderer}")return await renderer.render(data, chart_config)

4. 分析流程编排

分析流程编排是将各个分析步骤组织成一个完整工作流的关键环节。我们需要构建一个灵活且可靠的流程编排系统。

4.1 工作流引擎

from enum import Enum

from typing import Dict, List, Callable

from dataclasses import dataclassclass TaskStatus(Enum):PENDING = "pending"RUNNING = "running"COMPLETED = "completed"FAILED = "failed"@dataclass

class AnalysisTask:"""分析任务定义"""id: strname: strtype: strparams: Dictdependencies: List[str]status: TaskStatus = TaskStatus.PENDINGresult: Dict = Noneclass WorkflowEngine:def __init__(self):self.tasks: Dict[str, AnalysisTask] = {}self.task_handlers: Dict[str, Callable] = {}self.execution_history = []async def register_task_handler(self,task_type: str,handler: Callable):"""注册任务处理器"""self.task_handlers[task_type] = handlerasync def create_workflow(self,tasks: List[AnalysisTask]) -> str:"""创建分析工作流Args:tasks: 任务列表Returns:str: 工作流ID"""workflow_id = self._generate_workflow_id()# 验证任务依赖关系if not self._validate_dependencies(tasks):raise ValueError("Invalid task dependencies")# 注册任务for task in tasks:self.tasks[task.id] = taskreturn workflow_idasync def execute_workflow(self, workflow_id: str):"""执行工作流1. 构建任务执行图2. 并行执行无依赖任务3. 按依赖顺序执行后续任务4. 处理任务失败和重试"""execution_graph = self._build_execution_graph()try:# 获取可执行任务ready_tasks = self._get_ready_tasks(execution_graph)while ready_tasks:# 并行执行任务results = await asyncio.gather(*[self._execute_task(task) for task in ready_tasks],return_exceptions=True)# 更新任务状态for task, result in zip(ready_tasks, results):if isinstance(result, Exception):await self._handle_task_failure(task, result)else:await self._handle_task_success(task, result)# 获取下一批可执行任务ready_tasks = self._get_ready_tasks(execution_graph)except Exception as e:await self._handle_workflow_failure(workflow_id, e)raiseasync def _execute_task(self, task: AnalysisTask):"""执行单个任务"""handler = self.task_handlers.get(task.type)if not handler:raise ValueError(f"No handler for task type: {task.type}")task.status = TaskStatus.RUNNINGtry:result = await handler(**task.params)task.result = resulttask.status = TaskStatus.COMPLETEDreturn resultexcept Exception as e:task.status = TaskStatus.FAILEDraise

4.2 任务编排配置

@dataclass

class WorkflowConfig:"""工作流配置"""name: strdescription: strtasks: List[Dict]schedule: Optional[str] = None # cron表达式retry_policy: Dict = Noneclass WorkflowBuilder:def __init__(self, engine: WorkflowEngine):self.engine = engineasync def build_from_config(self,config: WorkflowConfig) -> str:"""从配置构建工作流示例配置:{"name": "销售数据分析","description": "每日销售数据分析流程","tasks": [{"id": "data_fetch","type": "sql","params": {"query": "SELECT * FROM sales"}},{"id": "data_process","type": "transform","dependencies": ["data_fetch"],"params": {"operations": [...]}},{"id": "visualization","type": "chart","dependencies": ["data_process"],"params": {"chart_type": "line","metrics": [...]}}],"schedule": "0 0 * * *","retry_policy": {"max_attempts": 3,"delay": 300}}"""tasks = []for task_config in config.tasks:task = AnalysisTask(id=task_config["id"],name=task_config.get("name", task_config["id"]),type=task_config["type"],params=task_config["params"],dependencies=task_config.get("dependencies", []))tasks.append(task)workflow_id = await self.engine.create_workflow(tasks)# 设置调度策略if config.schedule:await self._setup_schedule(workflow_id, config.schedule)return workflow_id

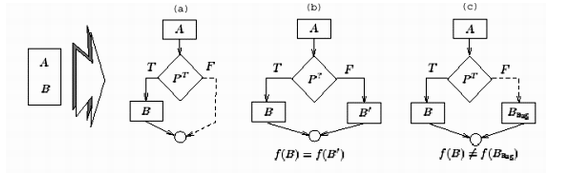

5. 结果验证机制

结果验证机制确保分析结果的准确性和可靠性,包括数据质量检查、结果一致性验证和异常检测。

5.1 验证框架

from abc import ABC, abstractmethod

from typing import Any, Listclass Validator(ABC):"""验证器基类"""@abstractmethodasync def validate(self, data: Any) -> bool:pass@abstractmethodasync def get_validation_report(self) -> Dict:passclass ResultValidator:def __init__(self):self.validators: List[Validator] = []self.validation_history = []async def add_validator(self, validator: Validator):"""添加验证器"""self.validators.append(validator)async def validate_result(self,result: Any,context: Dict = None) -> bool:"""验证分析结果执行所有注册的验证器:1. 数据质量验证2. 业务规则验证3. 统计显著性检验4. 异常值检测"""validation_results = []for validator in self.validators:try:is_valid = await validator.validate(result)validation_results.append({'validator': validator.__class__.__name__,'is_valid': is_valid,'report': await validator.get_validation_report()})except Exception as e:validation_results.append({'validator': validator.__class__.__name__,'is_valid': False,'error': str(e)})# 记录验证历史self.validation_history.append({'timestamp': datetime.now(),'context': context,'results': validation_results})# 所有验证都通过才返回Truereturn all(r['is_valid'] for r in validation_results)

5.2 具体验证器实现

class DataQualityValidator(Validator):"""数据质量验证器"""def __init__(self, rules: List[Dict]):self.rules = rulesself.validation_results = []async def validate(self, data: pd.DataFrame) -> bool:"""验证数据质量检查项目包括:1. 空值比例2. 异常值检测3. 数据类型一致性4. 值域范围检查"""for rule in self.rules:result = await self._check_rule(data, rule)self.validation_results.append(result)return all(r['passed'] for r in self.validation_results)async def get_validation_report(self) -> Dict:return {'total_rules': len(self.rules),'passed_rules': sum(1 for r in self.validation_results if r['passed']),'results': self.validation_results}class StatisticalValidator(Validator):"""统计验证器"""def __init__(self, confidence_level: float = 0.95):self.confidence_level = confidence_levelself.test_results = []async def validate(self, data: Any) -> bool:"""统计验证包括:1. 显著性检验2. 置信区间计算3. 样本代表性检验4. 分布检验"""# 实现统计检验逻辑pass

💡 验证最佳实践

数据质量验证

- 设置关键指标的阈值

- 监控数据趋势变化

- 记录异常数据样本

结果一致性验证

- 与历史结果对比

- 交叉验证

- 业务规则验证

异常检测

- 统计方法检测异常

- 时序数据趋势分析

- 多维度交叉验证

这样,我们就完成了一个完整的企业级数据分析 Agent 系统的设计和实现。系统具有以下特点:

- 模块化设计,各组件职责明确

- 可扩展的架构,支持添加新的功能

- 完善的错误处理和验证机制

- 灵活的配置和调度能力

- 全面的监控和日志记录