前言 为了解决这一问题,360人工智能研究院在人工智能顶会NeurIPS2024上提出了布局可控AI绘画模型HiCo,并将于近期开源。基于HiCo模型,使用者可以对生成画面中的不同主体的布局进行自由控制和调整,实现“指哪打哪”的生成效果。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

本文转载自我爱计算机视觉

仅用于学术分享,若侵权请联系删除

CV方向的准研究生们,未来三年如何度过?

招聘高光谱图像、语义分割、diffusion等方向论文指导老师

AI绘画模型一直以来被概括为“文生图”模型,究其原因,是因为当前的主流图像生成模型基本都只提供了基于文本条件生成图像的能力,各家的AI绘画产品也主要在生成画质和文本理解能力上进行竞争。但对于专业的使用者来说,文本能提供的画面控制能力非常有限,导致当前的AI绘画产品还达不到作为专业生产力工具来使用的标准。

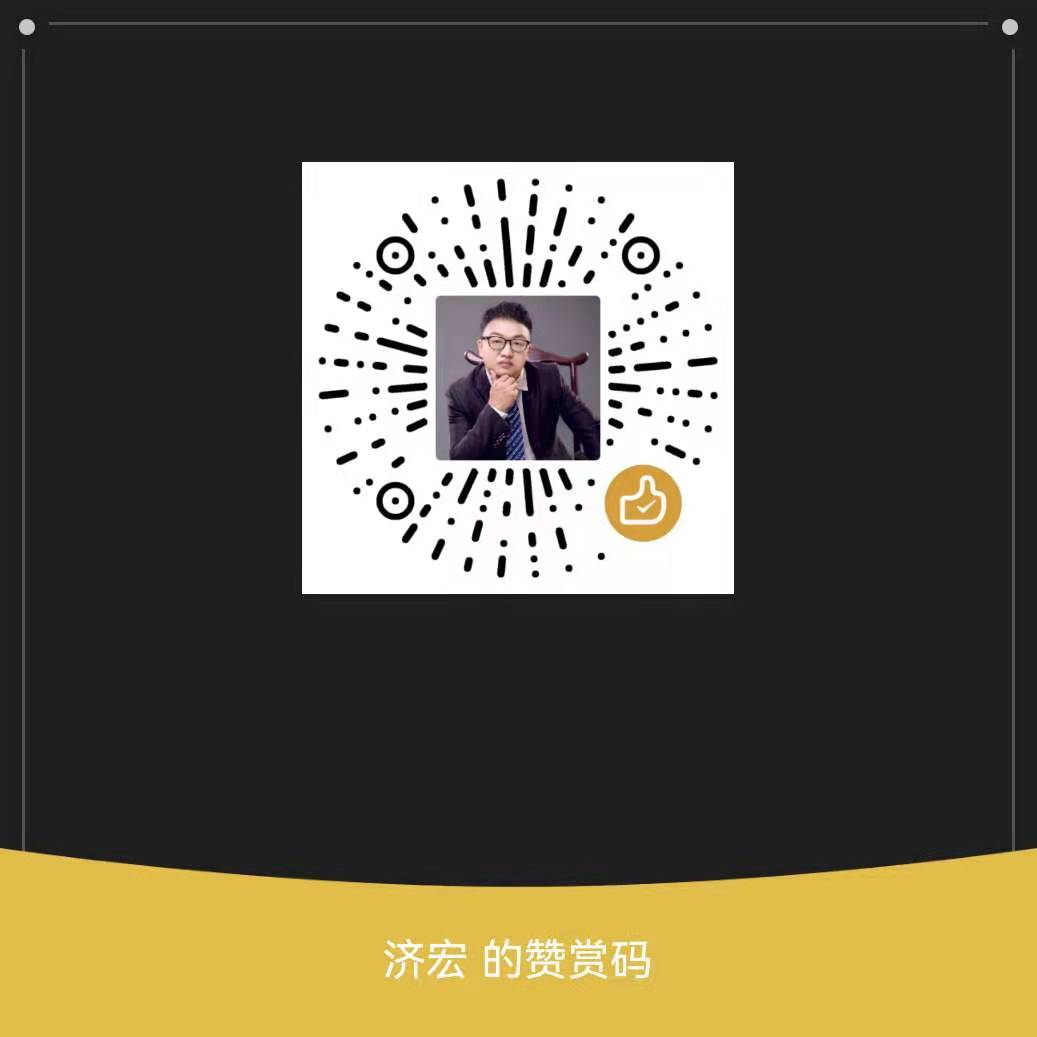

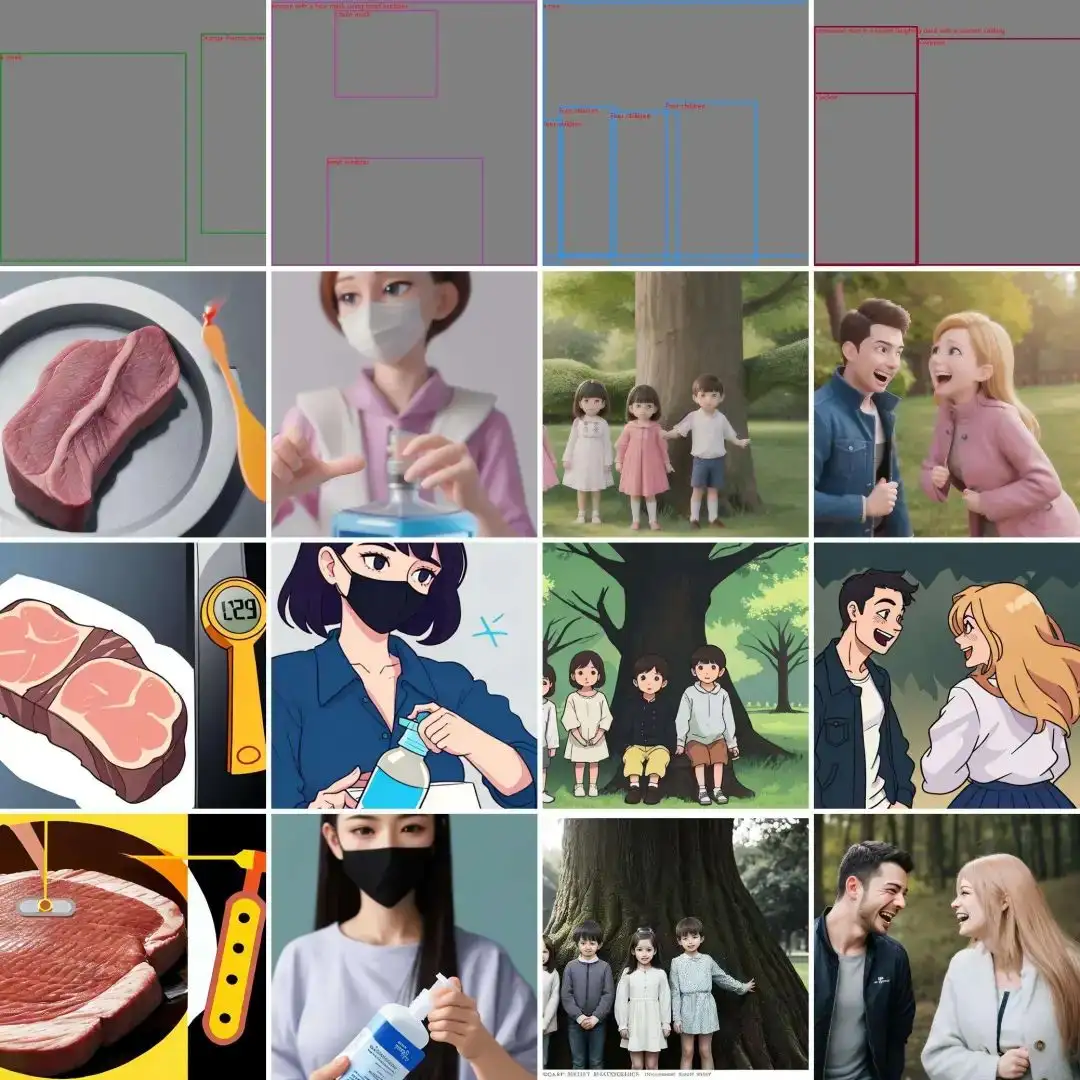

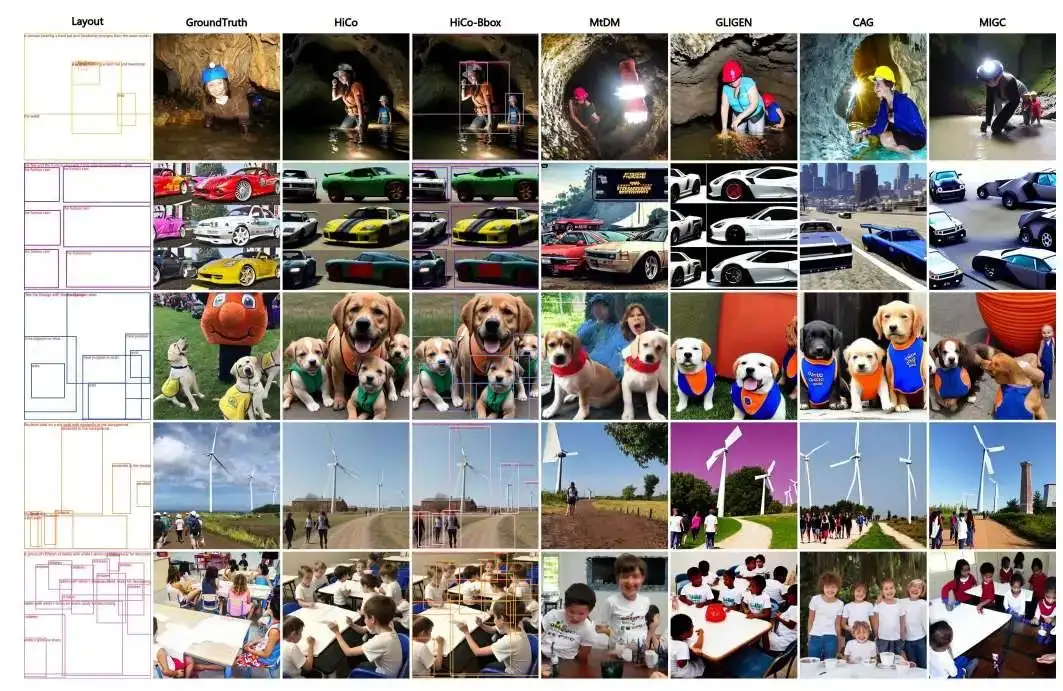

话不多说,先让我们来看一组生成效果(使用者基于不同的矩形框和对应的文本描述,来控制在画面的不同位置生成指定的内容):

接下来是HiCo工作的详细原理解读:

- 论文标题:HiCo: Hierarchical Controllable Diffusion Model for Layout-to-image Generation

- 论文链接:https://arxiv.org/abs/2410.14324

- 项目主页:https://360cvgroup.github.io/HiCo_T2I/

1.摘要

布局到图像生成的任务是AIGC领域一项重要研究方向,通常指根据实例对象的文本描述及其空间位置合成目标图像。

现有的方法仍然难以生成复杂的布局,常见的不良情况包括对象丢失、光影不一致、视角冲突、重叠区域的目标交互等。

为了有效地解决这些问题,我们提出了一个层次可控(HiCo)扩散模型,具有对象分离的条件分支结构。

我们的主要观点是通过布局的层次化建模来实现空间分离。我们使用多分支结构来表示层次内容,并将它们聚合到融合模块中。

2.动机

主流的布局可控生成是采用新设计网络结构或特殊的交叉注意力机制,来实现目标的位置可控,然而在复杂场景下这些方法存在目标丢失、指令遵循能力下降、生成图像失真、推理资源消耗过大以及开源社区生态适配等问题。

如何在保证原始扩散模型能力的不变的同时,引入布局子区域的位置可控能力是我们面临的首要挑战。典型的引入外部可控条件进行图像生成的方法,如ControlNet、IP-Adapter等,其外部可控条件不限于人体姿态、关键点、参考图。

为了解决上述挑战,本文提出了层次可控扩散模型,本方法通过权值共享的分支分别提取层次化布局特征,并用融合网络进行精细聚合。

3.方法

3.1 模型整体架构

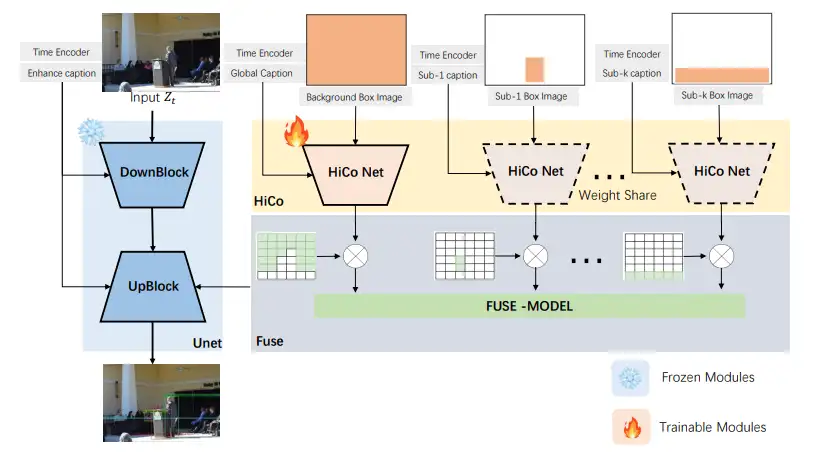

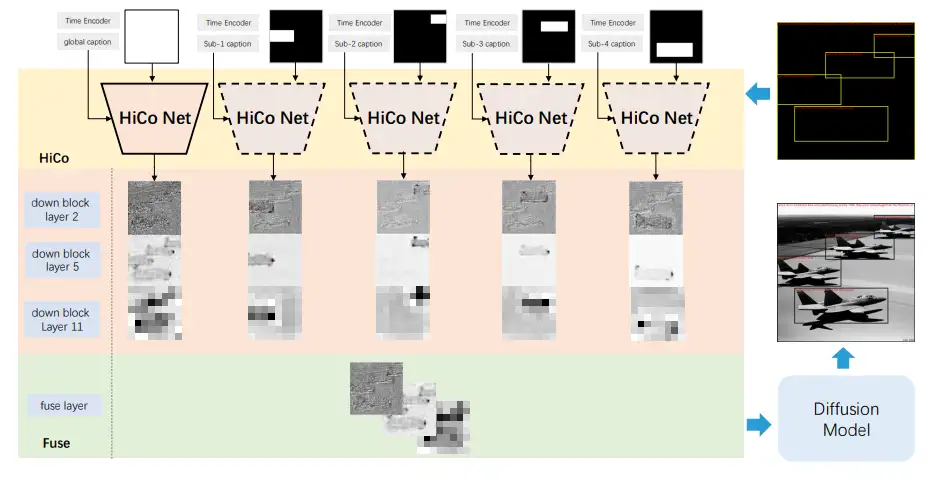

针对上述问题挑战,结合目前扩散模型外部控制条件引入的常用方法,本文提出一种名为HiCo的分层可控扩散模型(Hierarchical Controllable Diffusion Model),用于从布局生成高质量和逼真的图像。HiCo的整体架构如图1所示,包括主干SD基础模型、权重共享的旁支网络HiCo以及融合模块FuseNet。

3.2 层次化建模及融合模块

为了兼具扩散模型的能力,同时引入布局可控的能力,研究者提出了HiCo方法。该方法通过层次化建模解耦不同目标的空间布局,并动态整合背景信息和不同前景目标的内容及交互。

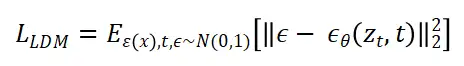

朴素的扩散模型的目标函数如下式:

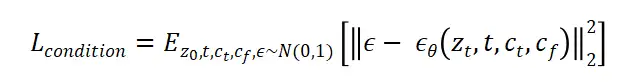

引入外部控制条件的扩散模型目标函数如下式,给定输入图片,通过渐进式扩散加噪到,其中为加噪步数,为文本控制条件,为特定控制条件,θ为可学习的网络来预测不同阶段的噪声。

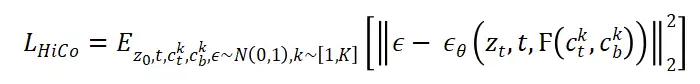

相对于包含常规控制条件的扩散模型,本方法新增额外的权重共享的HiCo Net来生成全局背景和不同布局区域内容,由于增加了多个不同的控制条件,则训练目标为:

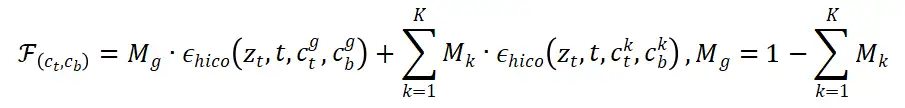

融合模块主要实现对前背景的有效融合,可根据具体的场景选择适合的融合方式,包括平均、求和、掩码加权等。本文采用基于mask融合方式如下式,其中 表示第 个实例的掩码信息, 表示背景区域的掩码信息。

3.3 分层特征可视化

HiCo在整体结构上采用了一种创新的权重共享机制,该机制能够根据文本描述和空间布局信息,分别解耦不同的前景实例和背景图像生成独立的特征,在上采样阶段对这些特性进行了战略性集成。图2展示了四个实例布局的HiCo模型的生成过程。

3.4 训练数据及策略

HiCo模型可以采用不同类型场景的Grounding数据训练来获取相应的布局可控生成能力。本文在开集的细粒度描述数据(GRIT-20M)以及闭集的粗粒度类别数据(COCO)上均进行了实验验证。其中我们对GRIT-20M的子集数据进行清洗筛选出1.2M的训练数据,并构建了细粒度的评估集HiCo-7K。

HiCo结构支持不同版本扩散模型,包括但不限于SD1.5、SDXL、SD3、Flux等。同时我们支持SD模型的快速生成插件或者底模,如LoRA、LCM、SDXL-Lighting等。详细训练及推理细节可参考原文。

4.实验评估

4.1 效果评估

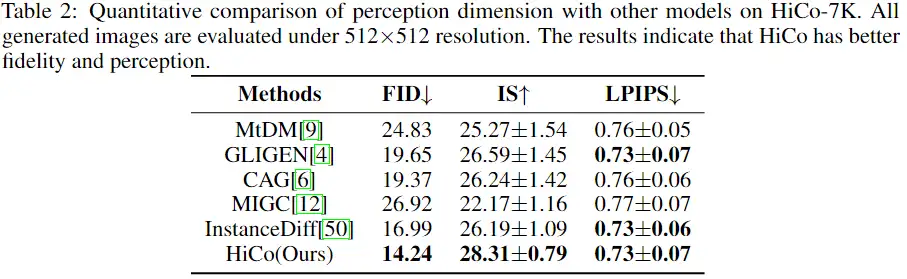

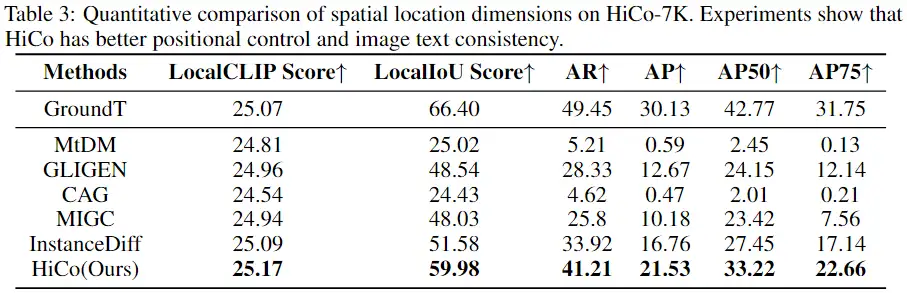

细粒度描述定量评估。在细粒度测试集HiCo-7K上,对图片生成质量及布局可控两个维度进行了定量评估。HiCo模型均取得显著的效果,同时不同目标数量的复杂场景图片生成效果也非常理想。

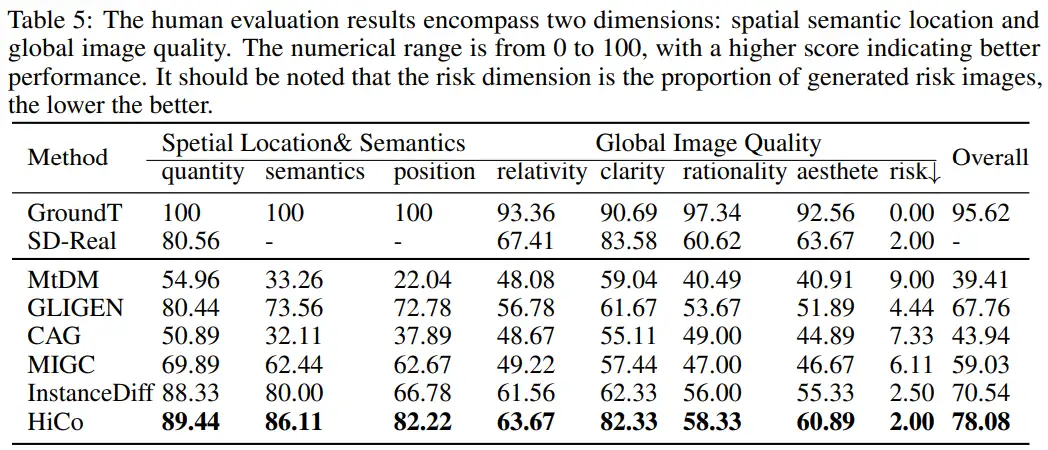

人工评估。我们采用多轮、多参与者交叉评价的方法,从目标数量、空间位置、全局图像质量等方面对人类偏好进行评价。下表为不同对比方法的人工评估指标,结果表明在空间位置和语义维度方面,HiCo方法优于其他模型。此外,在全局图像质量的细粒度维度上,它的性能接近RealisticVisionV51模型(SDReal),表明尽管增强了可控性,但我们的模型的生成能力仍然是鲁棒和有效的。

4.2 消融实验

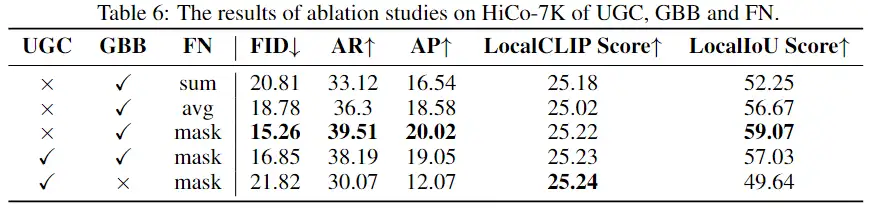

本文对HiCo结构、融合策略等进行了一系列消融实验,具体结果可以看下面的表格。

4.3 推理效率

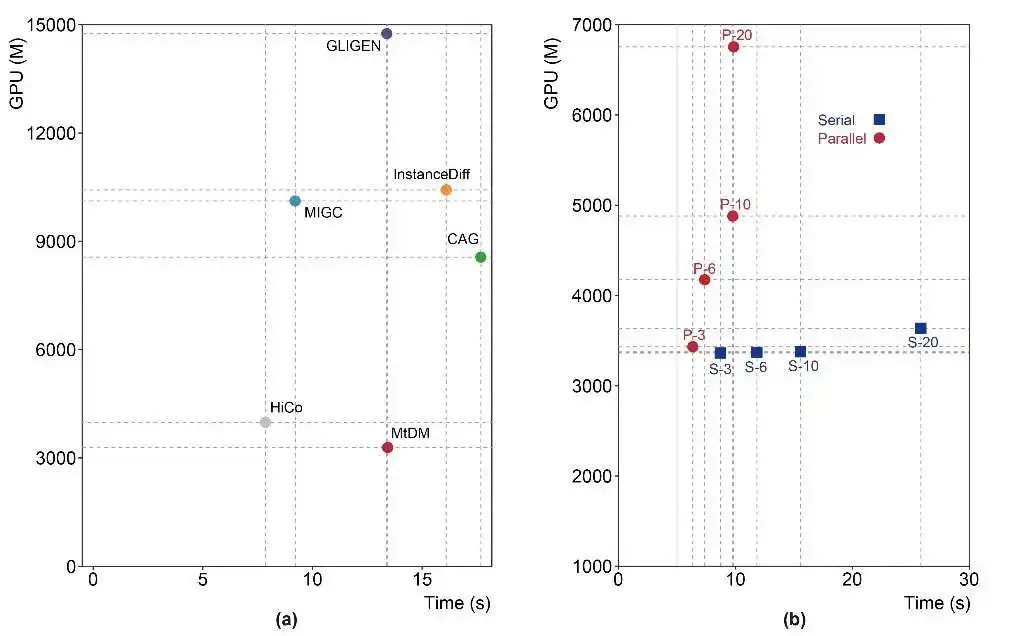

对于推断运行时间和内存使用,我们进行了两个维度比较,详细数据图4。横向比较不同方法的性能差异,我们评估了使用24GB VRAM 3090 GPU在HiCo-7K上直接生成512×512分辨率图像的推断时间和GPU内存使用情况。

HiCo的多分支有两种推理模式:“并行模式”和“串行模式”。为了验证HiCo在对象数量增加时的性能优势,纵向比较HiCo不同推理模式的性能差异,我们评估了在HiCo-7K上生成512×512分辨率图像的推理时间和GPU内存使用情况。结果表明HiCo模型推理方式灵活,在推理耗时和显存占用方面均具有明显优势。

5.总结与展望

复杂的目标交互和重叠区域的遮挡顺序是HiCo模型乃至布局可控领域对图像生成的重要挑战。HiCo通过将每个对象的位置和外观信息解耦为不同的分支,同时通过具有全局提示的背景分支和融合网络控制它们之间的整体交互,从而实现层次化的生成。

HiCo能够通过融合模块处理重叠区域的复杂相互作用。重叠对象的遮挡顺序也通过文本描述的全局提示指定。但由于缺少相应的遮挡顺序训练数据,成功率远未达到最优。对于目前的HiCo,确实缺乏更明确的遮挡顺序控制机制。

HiCo是一种基于扩散模型,以多分支结构为导向的可控布局生成模型。通过对自然场景中不同粒度的数据进行训练和测试,并进行算法度量评价和主观人为评价,证明了该方法的优越性。然而,仍有进一步改进的潜力,特别是在图像内容编辑和集成多种样式概念方面。通过结合当前可控生成功能,可以提高AI生成艺术品的整体可玩性。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

计算机视觉入门1v3辅导班

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

分享一个CV知识库,上千篇文章、专栏,CV所有资料都在这了

明年毕业,还不知道怎么做毕设的请抓紧机会了

LSKA注意力 | 重新思考和设计大卷积核注意力,性能优于ConvNeXt、SWin、RepLKNet以及VAN

CVPR 2023 | TinyMIM:微软亚洲研究院用知识蒸馏改进小型ViT

ICCV2023|涨点神器!目标检测蒸馏学习新方法,浙大、海康威视等提出

ICCV 2023 Oral | 突破性图像融合与分割研究:全时多模态基准与多交互特征学习

听我说,Transformer它就是个支持向量机

HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

南科大提出ORCTrack | 解决DeepSORT等跟踪方法的遮挡问题,即插即用真的很香

1800亿参数,世界顶级开源大模型Falcon官宣!碾压LLaMA 2,性能直逼GPT-4

SAM-Med2D:打破自然图像与医学图像的领域鸿沟,医疗版 SAM 开源了!

GhostSR|针对图像超分的特征冗余,华为诺亚&北大联合提出GhostSR

Meta推出像素级动作追踪模型,简易版在线可玩 | GitHub 1.4K星

CSUNet | 完美缝合Transformer和CNN,性能达到UNet家族的巅峰!

AI最全资料汇总 | 基础入门、技术前沿、工业应用、部署框架、实战教程学习

计算机视觉入门1v3辅导班

计算机视觉交流群

![[Linux]缓冲区的理解](https://img2023.cnblogs.com/blog/3328328/202411/3328328-20241127105430294-1663534376.png)