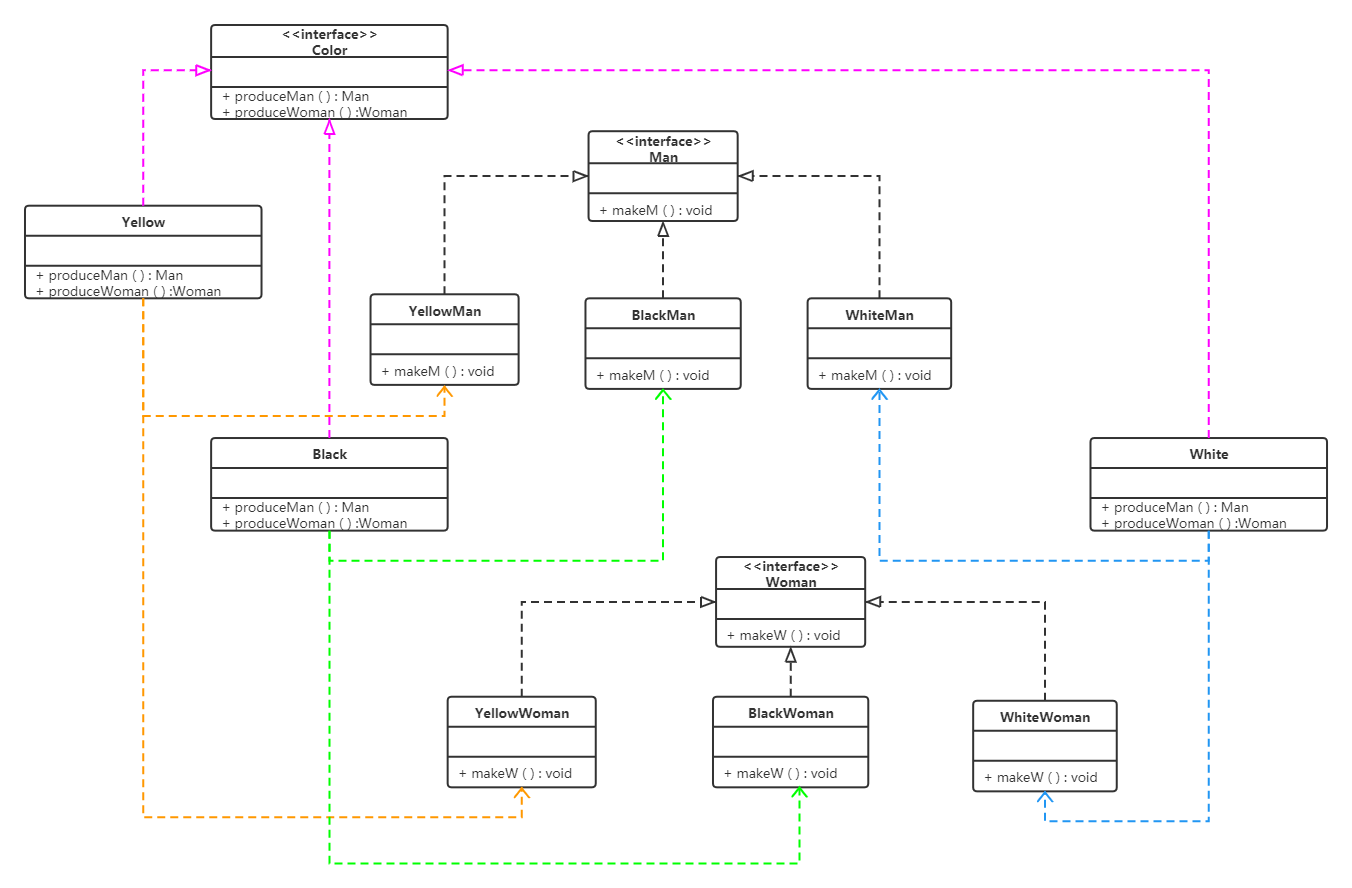

1. GAN的具体架构

大语言模型(LLM)与生成式人工智能(GenAI)指南

GAN 主要由两部分构成:生成网络和判别网络。每个网络都可以是任何神经网络,比如普通的人工神经网络(artificialneuralnetwork,ANN)、卷积神经网络(convolutionalneural networkCNN)循环神经网络(recurrentneuralnetwork,RNN)或者长短期记忆(long short term memory,LSTM)网络。判别网络则需要一些全连接层,并且以分类器收尾。

全连接层的功能

全连接层(Fully Connected Layer),也称为密集层(Dense Layer)或线性层(Linear Layer),是神经网络中的一种层类型,其中每个输入节点都与该层的每个输出节点相连。在全连接层中,每个连接都有一个权重,并且每个节点还可能有一个偏置项。全连接层的主要功能是将输入数据转换为输出数据,这个过程通常涉及到以下数学操作:

-

权重乘法:每个输入值乘以其对应的权重。

-

求和:将所有加权输入值相加。

-

偏置加法:将偏置项加到求和结果上。

-

激活函数:将激活函数应用于加权求和的结果,以引入非线性特性。

全连接层的输出可以是原始的加权求和结果,也可以是经过激活函数处理后的结果。激活函数是全连接层的关键组成部分,它允许神经网络学习复杂的模式。常见的激活函数包括:

- Sigmoid:将输出压缩到0和1之间,适用于二分类问题。

- Tanh(双曲正切):将输出压缩到-1和1之间,比Sigmoid函数有更好的数值稳定性。

- ReLU(Rectified Linear Unit):输出输入值如果为正,则保持不变;如果为负,则输出0。ReLU在实践中非常流行,因为它可以加速训练过程并提高模型性能。

- Softmax:将输出转换为概率分布,常用于多分类问题的输出层。

全连接层在神经网络中的作用包括:

- 特征组合:将前一层的特征进行组合,形成新的特征。

- 分类:在网络的输出层,用于分类任务。

- 回归:在网络的输出层,用于回归任务,通常不使用激活函数或使用线性激活函数。

全连接层是构建深度神经网络的基础,但它们也可能导致一些缺点,如参数数量大、计算成本高、容易过拟合等。为了解决这些问题,可以采用正则化技术、dropout、权重初始化策略等方法。

(batch_size,100)的张量是什么意思

在机器学习和深度学习中,张量(Tensor)是一种多维数组,用于表示数据。当你看到形如 (batch_size, 100) 的张量时,这通常指的是一个二维张量,其中:

-

batch_size:表示这批数据中包含的样本数量。在训练神经网络时,通常不会一次性处理整个数据集,而是将数据集分成多个小批量(batches)进行处理,这样做可以提高内存效率并有助于模型的泛化能力。 -

100:表示每个样本的特征数量。在这个张量中,每个样本都由100个特征组成。

所以,一个 (batch_size, 100) 形状的张量可以这样理解:

- 如果

batch_size是32,那么这个张量就包含了32个样本,每个样本有100个特征。 - 这个张量可以用于神经网络的输入层,其中100个特征对应于输入层的100个神经元。

- 在深度学习的上下文中,这样的张量通常用于前向传播过程中,将数据从输入层传递到隐藏层或输出层。

在PyTorch或TensorFlow等深度学习框架中,张量是构建和训练模型的核心数据结构。例如,在PyTorch中,你可以这样创建一个形状为 (batch_size, 100) 的张量:

import torchbatch_size = 32

features = 100

tensor = torch.randn(batch_size, features)

这将创建一个形状为 (32, 100) 的张量,其中包含了随机生成的数值。

同理,可得(batch_size,28,28)的张量的含义

一个形状为 (batch_size, 28, 28) 的张量在深度学习和机器学习中通常用于表示图像数据。具体来说:

-

batch_size:这是一个可变的维度,表示在一次训练迭代中同时处理的图像数量。与之前的例子一样,batch_size可以是任何正整数,比如32、64或128,取决于你希望一次处理多少个图像。 -

28:这表示图像的高度,以像素为单位。 -

28:这表示图像的宽度,以像素为单位。

所以,一个 (batch_size, 28, 28) 形状的张量可以这样理解:

- 如果

batch_size是64,那么这个张量就包含了64个28x28像素的图像。 - 每个图像都是一个28x28的二维数组,其中每个元素代表一个像素的强度或颜色值。

- 这种张量形状常见于处理手写数字识别等任务,如MNIST数据集,其中包含了大量28x28像素的手写数字图像。

在深度学习框架中,这样的张量通常用于卷积神经网络(CNN)的输入层。卷积层能够从这些图像中提取特征,用于分类或其他任务。例如,在PyTorch中,你可以这样创建一个形状为 (batch_size, 28, 28) 的张量:

import torchbatch_size = 64

height = 28

width = 28

tensor = torch.randn(batch_size, height, width)

这将创建一个形状为 (64, 28, 28) 的张量,其中包含了随机生成的数值,模拟了64个28x28像素的灰度图像。如果是彩色图像,张量的形状会是 (batch_size, channels, height, width),其中 channels 通常为3(代表RGB三个颜色通道)。

2. GAN中KL、JS的定义

在生成对抗网络(GAN)中,KL散度(Kullback-Leibler Divergence)和JS散度(Jensen-Shannon Divergence)是衡量两个概率分布差异的度量方法,它们在GAN的优化过程中扮演着重要角色。

KL散度是一种非对称的度量,用于衡量一个概率分布相对于另一个概率分布的差异。在GAN的上下文中,KL散度可以用来衡量生成器产生的分布与真实数据分布之间的差异。然而,KL散度在处理零概率事件时存在问题,即当一个分布中某个事件发生的概率为零,而另一个分布中该事件的概率非零时,KL散度会变得非常大或无法定义。这可能导致训练过程中的不稳定性。

JS散度是KL散度的一种对称化版本,它通过计算两个分布与它们平均分布之间的KL散度的平均值来得到。JS散度解决了KL散度的非对称性问题,并且能够更好地处理零概率事件。JS散度的值域在0到1之间,当两个分布完全相同时,JS散度为0;当两个分布完全不同时,JS散度接近1。在GAN中,JS散度可以用来评估生成器产生的分布与真实数据分布之间的相似度。

在GAN的训练过程中,判别器的目标是最大化对真实数据和生成数据的分类准确性,这可以被理解为最小化JS散度的过程。而生成器的目标是生成尽可能接近真实数据分布的样本,这涉及到最小化生成数据分布与真实数据分布之间的KL散度或JS散度。

总的来说,KL散度和JS散度在GAN中提供了一种量化生成数据与真实数据之间差异的方法,有助于指导生成器的训练过程,使其产生更加逼真的数据样本。

3. GAN的模型塌陷问题

针对不同的峰训练不同的GAN模型;使用多样化的数据训练GAN

生成对抗网络(GAN)中的模型塌陷(Mode Collapse)是指在训练过程中,生成器(Generator)开始产生重复或高度相似的输出,而忽略了数据的真实分布。这种现象通常发生在判别器(Discriminator)网络过于强大或训练数据集非常复杂时,导致生成器不能学习到真实数据的多样性。

模式塌陷的影响包括生成多样性的丧失,即生成的数据缺乏多样性,无法覆盖真实数据分布,以及训练收敛困难,因为由于模式塌陷,GAN难以收敛到一个好的均衡状态,导致训练失败。

为了解决模式塌陷问题,研究人员提出了多种方法,包括:

- 使用噪声输入:为生成器提供随机性,使其能够探索更广泛的模式。

- 使用正则化技术:例如最大均值差异(MMD),鼓励生成器生成更具多样性的样本。

- 使用对抗性训练:迫使判别器区分生成样本和真实样本,从而提高生成器的多样性。

- 引入历史信息:使用判别器的历史信息来指导生成器的训练,帮助生成器学习到更广泛的模式。例如,最小二乘GAN(LSGAN)通过最小化真实样本和生成样本距离判别器输出之间的差异来缓解模式塌陷。

- 梯度惩罚:WGAN-GP(Wasserstein GAN with Gradient Penalty)通过在判别器中引入梯度惩罚项,改善了GAN的训练稳定性,并有效防止了模式塌陷。

这些策略的有效运用对于开发高质量的GAN模型至关重要,它们有助于提升模型的训练效果和稳定性能。

4. 在反向传播过程中,梯度从最后一层反向流动到第一层,并且会越来越小,有时梯度过小会导致前几层的学习速度非常慢,或者根本无法学习

这句话形象化的解释

这种现象被称为梯度消失(Vanishing Gradient Problem),是深度学习中一个常见的问题,尤其是在训练深层神经网络时。让我们通过一个形象化的比喻来解释这个问题:

想象一下,你正在建造一个多层的金字塔,每一层都代表着神经网络中的一层。建造这个金字塔需要很多工人(可以想象成神经网络中的权重),他们需要根据老板(损失函数)的指示来调整自己的工作。老板站在金字塔的顶端,他通过喊话来告诉下面的工人需要如何调整他们的工作。

-

梯度流动:当老板喊话时,他的声音(梯度信息)会从金字塔的顶端一层一层地传达到底部。这就像在神经网络中,损失函数的梯度从输出层反向传播到输入层。

-

梯度变小:随着声音从一层传到另一层,声音会逐渐变小,因为空气会吸收声音的能量。在神经网络中,这意味着梯度在每一层的传播过程中会逐渐减小。

-

学习速度慢:如果声音太小,底部的工人几乎听不见老板的指示,他们就无法有效地调整自己的工作。同样,在神经网络中,如果梯度太小,前几层的权重更新就会非常缓慢,导致学习过程变得非常慢。

-

无法学习:如果声音完全消失,底部的工人就完全听不到老板的指示,他们就无法进行任何调整。在神经网络中,如果梯度消失到接近零,前几层就几乎不会更新,这意味着这些层根本无法学习。

-

解决方案:为了解决这个问题,可以采取一些措施,比如使用ReLU激活函数代替sigmoid或tanh,因为ReLU在正区间内梯度恒定,不会导致梯度消失。另外,可以使用批量归一化(Batch Normalization)来稳定网络的学习过程,或者使用残差网络(ResNet)结构,它通过跳跃连接(skip connections)直接将信息传递到网络的更深层,从而绕过梯度消失的问题。

通过这些方法,可以确保金字塔底部的工人能够清晰地听到老板的指示,从而有效地建造金字塔,这在神经网络中相当于确保前几层能够学习到有效的特征。