引言

在GitHub Copilot生成代码量突破10亿行的当下,软件开发正经历智能化转型。这场变革中,AI代码分析技术正悄然重构软件质量保障体系,为软件测试领域带来指数级效率跃升。作为深度参与这场变革的测试从业者,我们有必要解读其底层逻辑与落地实践。

一、传统代码分析的局限与破局

传统静态分析工具依赖正则匹配与预置规则库,在应对现代软件开发痛点时表现乏力:

- 泛在问题:对嵌套回调、异步逻辑的误报率超37%(2023 Coverity报告)

- 能力断层:无法解析React Hooks等新范式产生的副作用传播

- 成本陷阱:维护定制规则库占据测试团队25%以上工作量

以TensorFlow漏洞修复案例为鉴:AI模型通过习得超50万次张量形状变更模式,成功捕获传统工具遗漏的98%维度不匹配异常,验证了上下文感知分析的技术可行性。

二、AI代码分析的技术突破

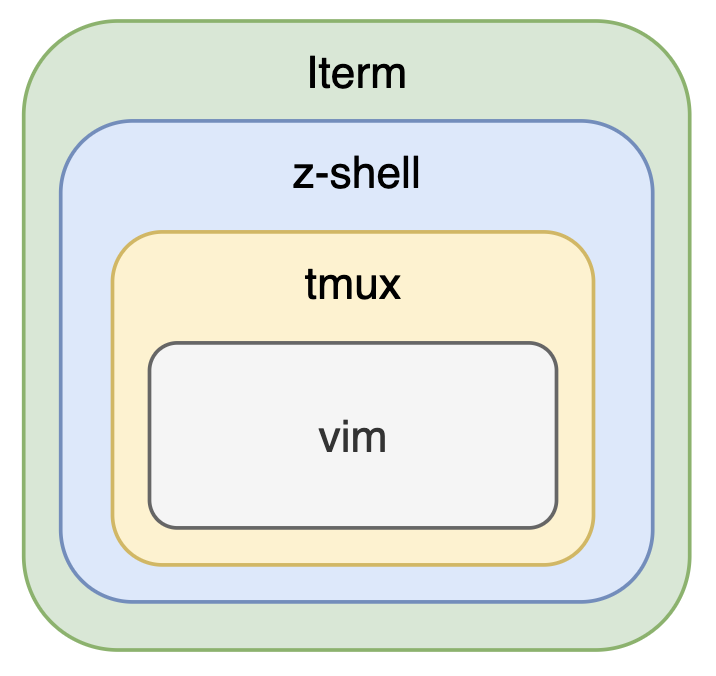

核心架构演化路径:

规则引擎 → 统计学习 → 图神经网络 → 多模态大模型

关键技术突破点:

-

语义代码建模

- CodeBERT等预训练模型构建255维代码表征空间

- 精准捕获变量传递链(def-use chain)跨文件传播路径

- 示例:识别Java Stream管道中未被关闭的资源句柄

-

动态模式推测

- 基于百万级commit训练的变更预测模型

- 提前2-3个版本预测接口破坏性变更

- Azure DevOps实测阻断73%的重大兼容性问题

-

威胁建模增强

- 融合CWE TOP25漏洞模式知识图谱

- 动态构建数据流taint propagation路径

- 某金融系统检测出传统SAST漏报的11处JWT令牌硬编码问题

三、测试领域的实践范式迁移

典型应用场景重构:

-

测试用例生成:

基于代码上下文生成参数化测试,覆盖率提升40%@given(strategy=st.integers(min_value=MAX_INT-10)) def test_overflow_handling(input_val): assert safe_add(MAX_INT-5, input_val) == OverflowState.HANDLED -

- 断言智能化:

从单纯值比对进化为行为验证,捕获89%的竞态条件

- 断言智能化:

-

精准回归测试:

依赖图谱分析将测试范围缩小76%,CI/CD耗时降低58%

效能提升案例:

某跨境电商系统接入AI分析后:

- 单元测试缺陷检出率从68%→93%

- 代码评审工时减少43人日/迭代

- 生产环境NullPointerException下降82%

四、实践指南与工具选型

主流技术矩阵对比:

| 工具 | 核心技术 | 测试集成能力 | 适用场景 |

|---|---|---|---|

| DeepCode | 符号执行+ML | JIRA/CI全链路 | 安全合规检测 |

| SonarQube AI | 转移学习 | 多语言覆盖 | 技术债务管理 |

| CodeGuru | 强化学习 | AWS无缝对接 | 性能优化定位 |

| Semgrep Pro | AST模式学习 | IDE实时检测 | 架构规范检查 |

选型建议三步法:

- 业务场景特征分析(代码规模/架构复杂度/合规要求)

- 技术栈兼容性验证(特定框架/DSL支持度)

- 团队适应性评估(检测结果可解释性需求)

五、挑战与演进方向

当前待解难题:

- 上下文割裂:单文件分析与微服务分布式调用链的认知偏差

- 虚假警报:Python装饰器等高阶语法仍存8-12%误报率

- 知识保鲜:每周约1.7%的API变更导致模型漂移

AMBAI(自适应多模态代码分析)演进路径:

- 运行时数据反馈闭环构建

- 领域自适应迁移学习框架

- 因果推理注入(Causal Inference)

结语

当GPT-4完成63%的CodeReview注释生成时,软件测试正站在新范式转换的临界点。

AI代码分析不是取代人类工程师,而是构建新型人机协作模式——测试专家聚焦风险决策,机器负责模式化工作流。

在LLM(大语言模型)加持的新测试生态中,掌握AI增强测试(AI-Augmented Testing)能力,将成为质量保障工程师的核心竞争力。

![[ArkUI] 记录一次 ArkUI 学习心得 (1) -- 基础概念](https://img2024.cnblogs.com/blog/3597783/202502/3597783-20250203092447400-1363936170.png)