在 DeepSeek 模型中,多头潜在注意力(Multi-Head Latent Attention,MLA) 是一种关键技术,旨在通过低秩压缩方法优化注意力机制的计算效率和内存使用。MLA 通过对键(Key)和值(Value)进行低秩联合压缩,显著减少了推理过程中的键值缓存(KV Cache),在保持模型性能的同时降低了内存占用。

MLA 的核心思想是将传统多头注意力机制中的键和值矩阵进行低秩分解,以减少计算和存储需求。具体而言,MLA 引入了低秩矩阵分解,将高维的键和值矩阵分解为低秩表示,从而降低计算复杂度。此外,MLA 还采用了矩阵吸收技术,将位置编码与注意力计算相结合,进一步提高计算效率。

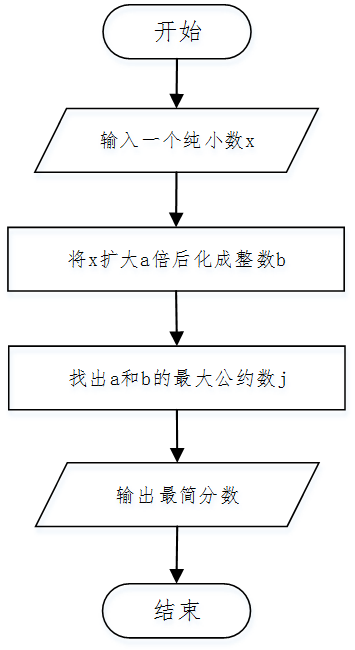

MLA 的实现过程包括以下步骤:

-

低秩分解:对键和值矩阵进行低秩分解,得到低维的表示。这一步骤通过矩阵分解技术,将高维矩阵表示为低秩矩阵的乘积,从而降低计算复杂度。

-

矩阵吸收:将位置编码与注意力计算相结合,通过矩阵吸收技术,将位置编码融入到注意力计算中,减少计算量。

-

注意力计算:使用低秩表示和吸收了位置编码的矩阵,进行注意力计算,得到最终的注意力输出。

通过上述步骤,MLA 在保持模型性能的同时,显著降低了计算复杂度和内存占用,提高了模型的推理效率。

需要注意的是,MLA 的实现涉及复杂的数学推导和矩阵运算,具体的公式和详细推导过程可以参考相关的技术报告和论文。