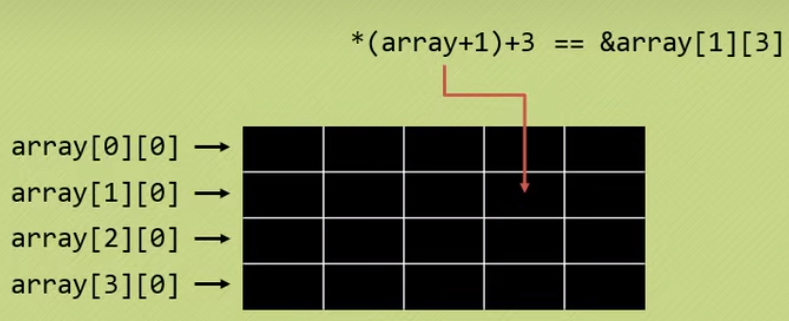

刚刚学到一项非常硬核的“黑”科技,只要几个关键词,就能实现 Ollama 自由。

全世界几万台高性能带显卡的电脑供你使用。

添加图片注释,不超过 140 字(可选)

看看这个页面,美国,中国,德国,英国....一个独立 IP 背后就是一台电脑,有些可能还是服务器。

我实测了,随便找一个都可以使用,几乎是百发百中!

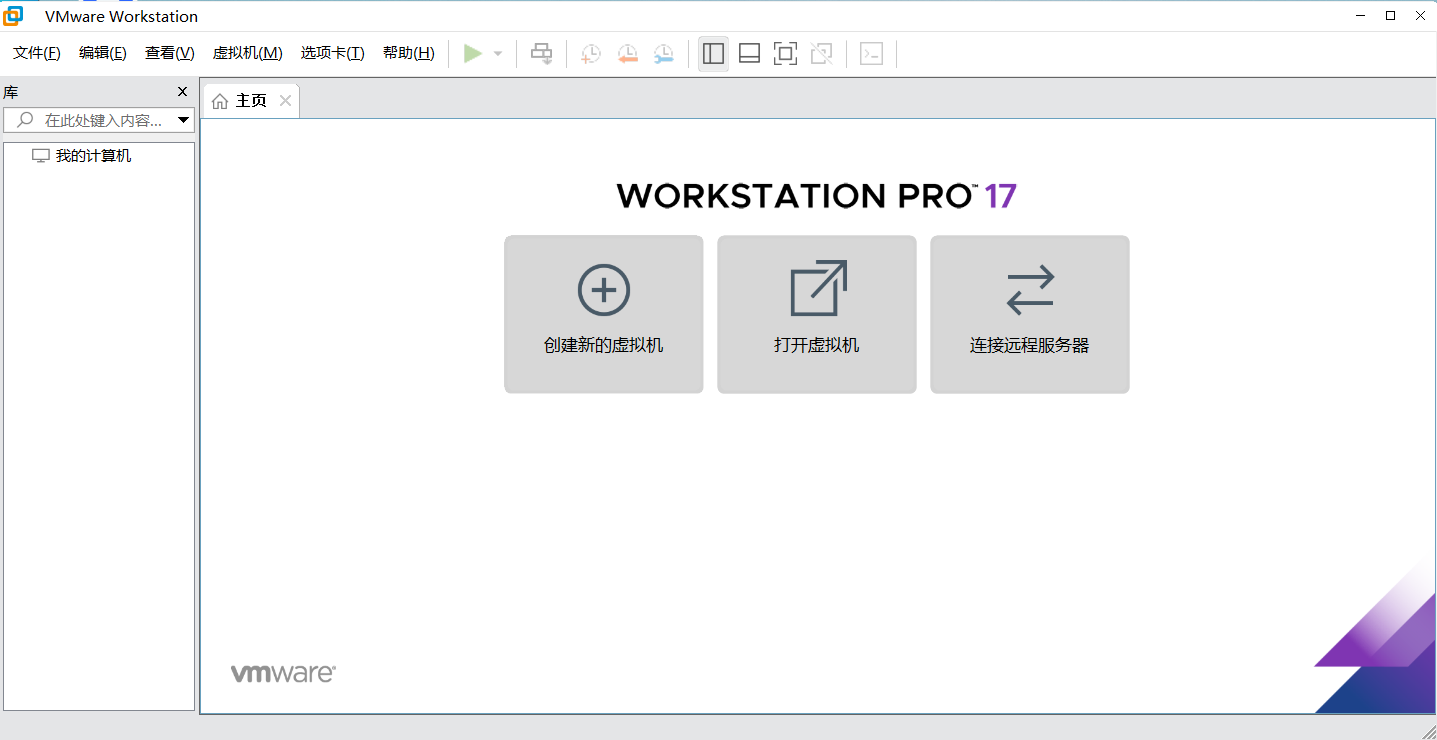

快速测试的方法。

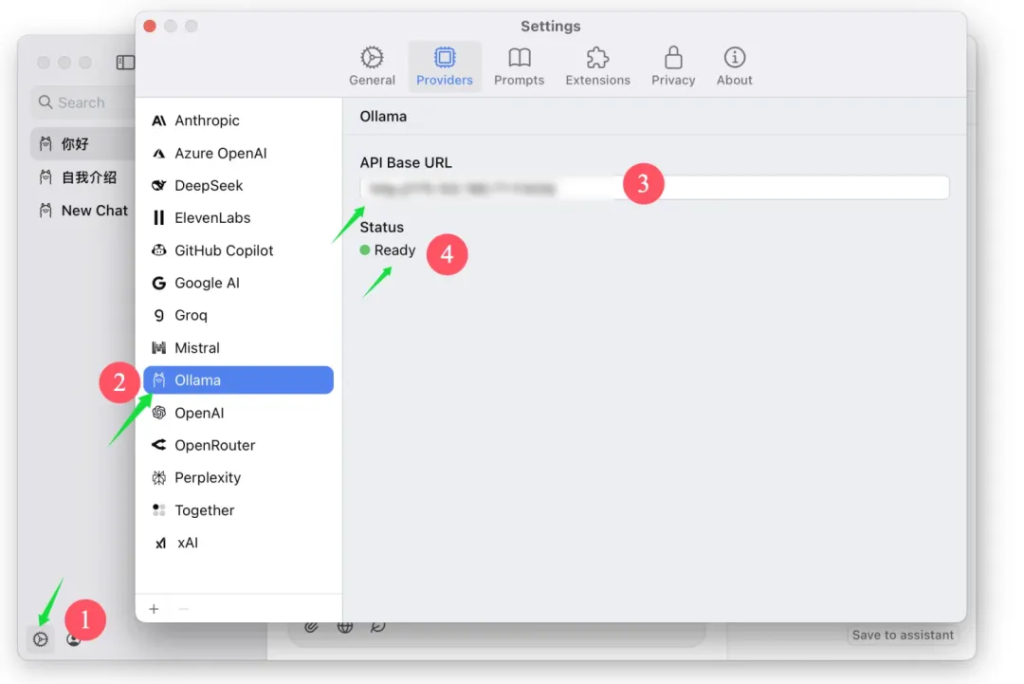

打开 ChatWise 在设置->Ollama->Providers,直接粘贴 IP 地址就可以了。

添加图片注释,不超过 140 字(可选)

IP 地址输入之后,软件会自动检查是否可用。如果显示 Ready 就证明可以使用。

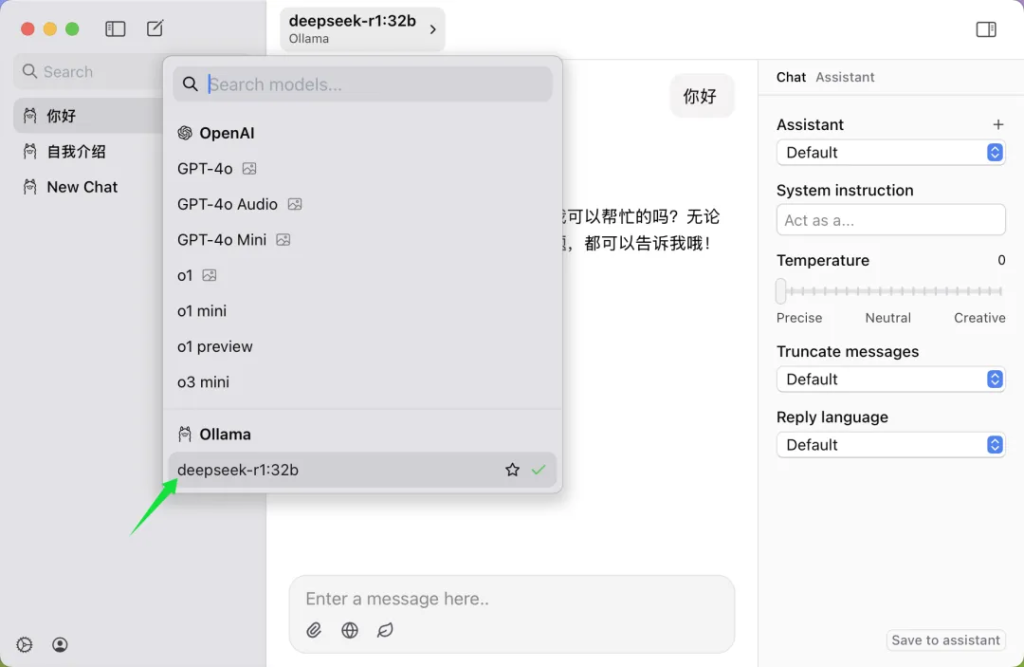

回到主界面,切换模型,就可以看到具体的模型了。

添加图片注释,不超过 140 字(可选)

我手气好,一上来就抽到了 32B的 DeepSeek R1,这起码是 RTX3090 或者 RTX4090 的机器。

添加图片注释,不超过 140 字(可选)

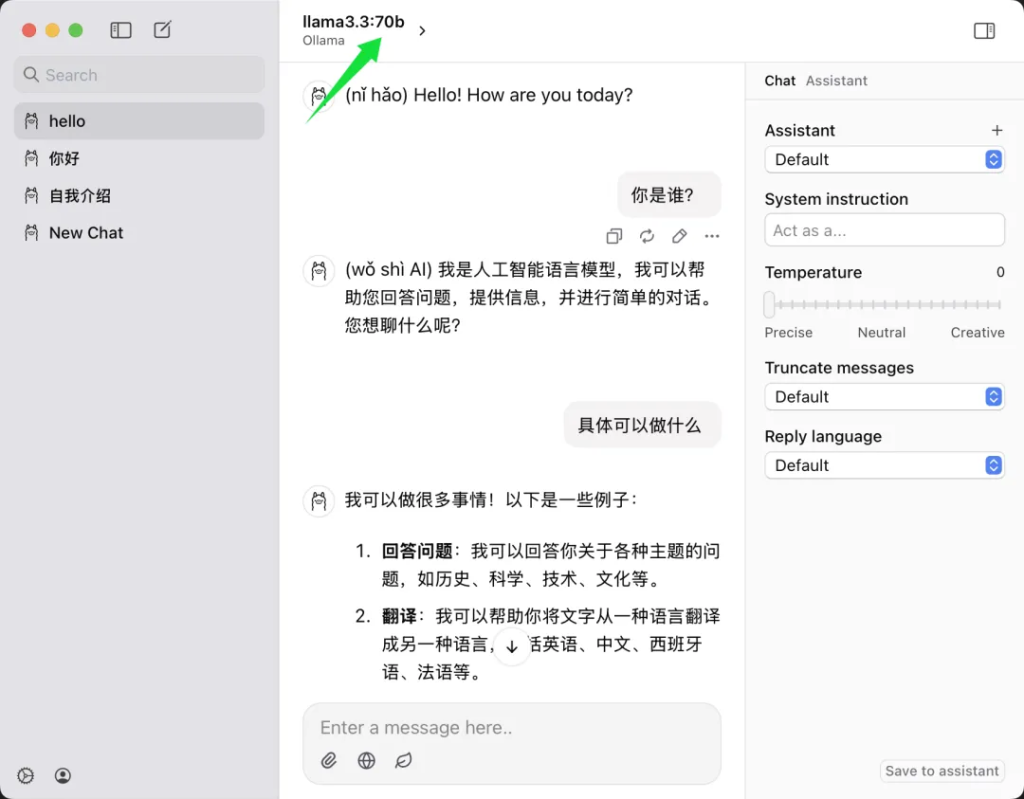

还有一位台湾的朋友在跑70B的 Llama3.3。这个模型的大小大概 43GB 左右,他这台电脑肯定也价值不菲了。

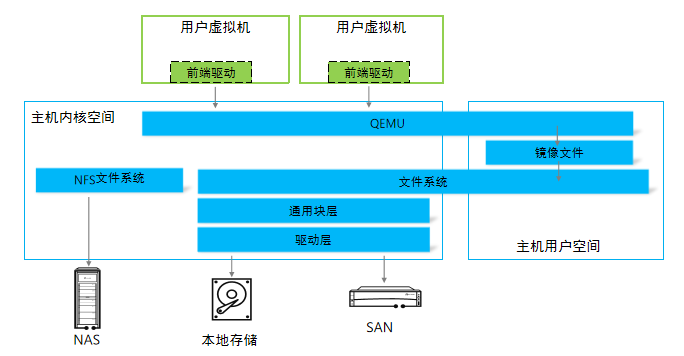

为什么会这样,其实原理很简单。

如果你配置了远程使用 Ollama。

那么,只要别人拿到你电脑的IP 地址,就能使用你的Ollama,也就是燃烧你的显卡GPU,为别人干活。

默认情况下,也无需其他授权。

这个时候刚好有一个程序在疯狂扫描IP和端口,然后记录这些信息,并提供了一个搜索功能。

你只要输入准确的关键词,就可以找到一堆开了 Ollama 的电脑。

所以,如果你配置了 Ollama 的环境变量,允许所有 IP 访问,就要小心点咯!

你的宝贝显卡,可能偷偷被别人玩了。

万幸的是,中国人独立IP少。

内网开的服务,一般不会被扫描到。

使用了公网IP 和在服务器上跑的要注意了!!!

所有Ollama用户请注意!!!你的IP可能已泄露 - 托尼不是塔克