文章学习笔记:AI大模型危机-多维对抗时代的网络安全与隐私困局

AI发展引发的安全风险与日俱增,加剧了网络安全形式的复杂性。本文剖析了大模型全生命周期安全威胁图谱,揭示数据资源枯竭、隐私泄露、监管滞后等风险问题。

AI大模型驱动网络安全风险”多维裂变“

AI大模型的发展,也随之带来了深度伪造、恶意AI机器人及自动化攻击工具等问题,推动安全对抗从传统”二维平面“到现在的”多维立体“模式。

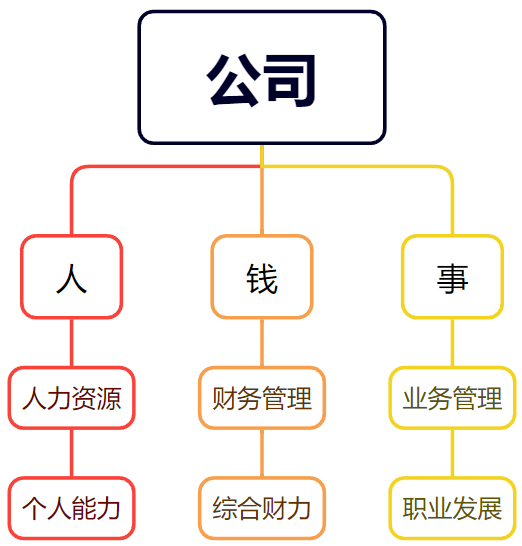

AI大模型内生安全风险贯穿人工智能大模型全生命周期,分为:

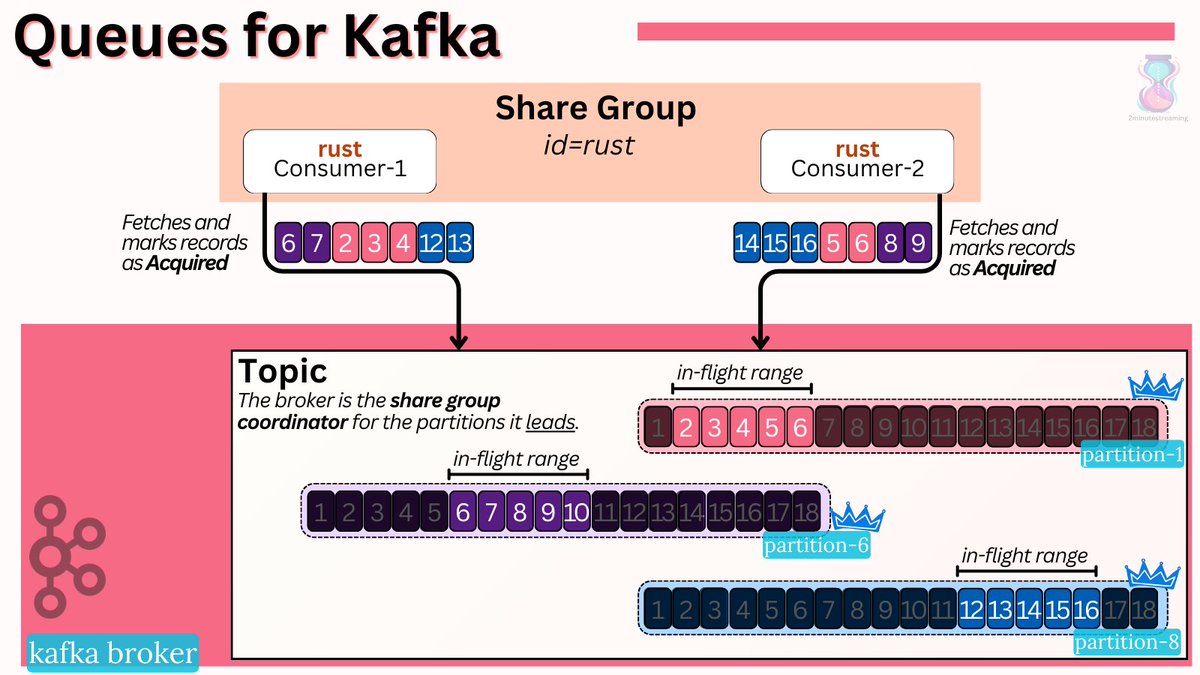

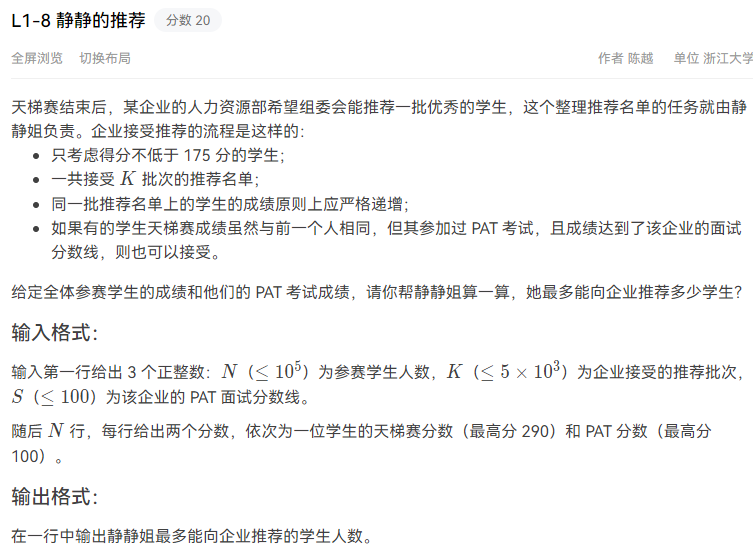

- 开发层供应链安全危机

开源生态因缺少安全验证机制,容易成为攻击者渗透的对象,如:

- 数据层污染与泄露双重压力

模型训练时可能遭受数据投毒攻击(通过植入污染样本扰乱模型决策),及弱口令暴露引发的数据泄露危机(权限管理不善,导致敏感数据泄露)。

- 应用层对抗性攻击升级

攻击手段:提示注入、模型逆向工程等,破坏模型输出,损害模型预测精度和可信度。

- 基础设施层的风险暴露呈现泛化趋势

威胁:API接口过度开放、传统设备漏洞等,攻击者实施横向渗透攻击。如:

AI大模型驱动网络攻击范式跃迁

AI大模型发展使得网络攻击从传统的“工具驱动型”向“智能驱动型”跃迁。

- AI重塑网络攻击生产力

大模型可能会被引导生成钓鱼网络、漏洞利用代码、社会工程学剧本等有害信息,以及生成多模态的虚假信息,生产成本极低,可迅速传播。

- AI持续输送网络攻击弹药

由于网络中数据量剧增,数据海洋成为新型弹药库,攻击者可利用弹药训练更为精准、更为高效的攻击模型。

- AI显著增强网络攻击效率

基于AI的攻击工具迭代速度极快,传统特征匹配检测机制几乎失效。

网络攻击形式在多个维度上呈现特征:

- 空间维度上:攻击范围从传统的IT系统扩展至物理与数字融合空间,如智能电网和自动驾驶等领域,展现多域协同的新趋势。

- 时间维度上:攻击的生命周期从探测、入侵、潜伏、爆发的线性模式,演变为具备自主决策能力的实时动态博弈过程。

- 认知维度上:攻击者突破传统社会工程学的限制,利用AI进行实现个性化心理操控,编写钓鱼信息更具迷惑性,点击率远高于人工编写的版本。

【技术没有好坏,只是用的人坏了】

AI大模型发展面临隐私与监管的复合性挑战

- ChatGPT数据泄露事件等典型案例充分凸显了AI大模型隐私保护和数据安全问题。

- 隐私泄露本质源于数据要素流动和隐私权益保护之间的根本冲突

- 存在敏感数据识别与关联推理的风险

当训练数据集中包含个人身份信息、健康医疗记录及金融交易等敏感数据时,能通过特征交叉推理,精确描述用户的详细画像。

- 多模态数据的结合放大了隐私泄露的严重性

结构化数据(电子健康档案)和非结构化数据(诊疗对话)结合训练,极大增强隐私信息的可追溯性。

如:患者用药记录与问诊文本的关联分析,可精确推断出遗传病史等敏感信息。

据欧盟数据显示,此类泄露事件以每年均两位数百分比速率激增。

- 模型记忆引发的持续泄露效应

模型参数对训练数据的记忆特性,导致隐私泄露风险持续存在模型整个生命周期。

- AI大模型在监管方面面临制度供给与技术迭代间的结构性矛盾

一方面,我国虽出台了《生成式人工智能服务管理暂行办法》和《人工智能生成合成内容标识办法》等法律法规,但针对大模型特有风险的专项立法仍显不足。较于欧盟《人工智能法案》建立的全面监管框架,现有法规体系在算法透明度、责任认定等领域上存在一定的制度空白。

另一方面,模型技术迭代速度和监管完善进程存在差距。随着AI大模型应用快速渗透到社会各领域,如监管技术体系在算力支撑、风险监测、动态评估等关键环节存在明显代际落查,很容易形成“监管滞后、风险累积、被动应对”的恶性循环。

- 高质量语料资源供给影响产业发展