摘要

在本报告中,我们介绍了Qwen2.5-Omni,这是一种端到端的多模态模型,旨在感知包括文本、图像、音频和视频在内的多种模态,并同时以流式方式生成文本和自然语音响应。为了实现多模态信息输入的流式处理,音频和视觉编码器采用了分块处理方法。该策略有效地分离了对多模态数据长序列的处理,将感知责任分配给多模态编码器,而将长序列的建模任务交给大型语言模型。这种分工通过共享注意力机制增强了不同模态的融合。为了同步视频输入的时间戳与音频,我们以交错的方式组织音频和视频,并提出了一种新的位置嵌入方法,即TMRoPE(时间对齐多模态RoPE)。为了同时生成文本和语音并避免两种模态之间的干扰,我们提出了Thinker-Talker架构。在这个框架中,Thinker作为大型语言模型,负责文本生成,而Talker是一个双轨自回归模型,直接利用Thinker的隐藏表示来生成音频标记作为输出。Thinker和Talker模型均设计为可以端到端地训练和推理。为了以流式方式解码音频标记,我们引入了一个滑动窗口DiT,以限制感受野,旨在减少初始包延迟。Qwen2.5-Omni与相同规模的Qwen2.5-VL相当,并且优于Qwen2-Audio。此外,Qwen2.5-Omni在多模态基准测试如Omni-Bench中取得了最先进的性能。值得注意的是,Qwen2.5-Omni在端到端语音指令跟随方面的表现与其处理文本输入的能力相当,这一点在MMLU和GSM8K等基准测试中得到了验证。至于语音生成,Qwen2.5-Omni的流式Talker在鲁棒性和自然度方面优于大多数现有的流式和非流式替代方案。

引言

在日常生活中,人类能够同时感知周围环境的视觉和听觉信息。经过大脑处理这些信息后,他们通过书写、语言表达或使用工具(和身体动作)进行反馈,从而与世界上的各种生物进行信息交流,展示出智能。近年来,通用人工智能变得越来越引人注目,这主要归功于大型语言模型(LLMs)的发展(Brown et al., 2020;OpenAI, 2023;2024;Gemini 团队, 2024;Anthropic, 2023a;2023b;2024;Bai et al., 2023a;Yang et al., 2024a;Touvron et al., 2023a;2023b;Dubey et al., 2024a)。这些模型在大量文本数据上进行训练,代表了人类创造的高度抽象的离散表示,展示了解决复杂问题和快速学习的能力。此外,在理解领域,语言-音频-语言模型(LALMs)(OpenAI, 2024;Tang et al., 2024;Chu et al., 2023b;2024b)和语言-视觉-语言模型(LVLMs)(Li et al., 2023;Liu et al., 2023b;Dai et al., 2023;Zhu et al., 2023;Huang et al., 2023;Bai et al., 2023b;Liu et al., 2023a;Wang et al., 2023b;OpenAI., 2023;Gemini 团队, 2024)帮助LLMs进一步扩展了听觉和视觉能力,实现了端到端的集成。然而,有效统合所有这些不同的理解模式,利用尽可能多的数据,并以文本和语音流的形式提供响应,以模仿人类通信,仍然是一个重大挑战。

开发一个统一且智能的多模态模型需要仔细考虑几个关键因素。首先,实施一种系统的方法来联合训练各种模态(包括文本、图像、视频和音频),以促进它们之间的相互增强至关重要。这种对齐尤其重要对于视频内容,其中音频和视觉信号的时间同步是必要的。其次,必须管理不同模态输出之间的潜在干扰,确保文本和语音标记的训练过程不会相互干扰。最后,需要探索能够实现实时多模态信息理解和高效音频输出流的架构设计,从而减少初始延迟。

在本报告中,我们介绍了Qwen2.5-Omni,这是一个统一的单模型,能够处理多种模态,并以流的形式同时生成文本和自然语音响应。为了应对第一个挑战,我们提出了一种新的位置嵌入方法,称为TMRoPE(时间对齐多模态RoPE)。我们将音频和视频帧以交错结构组织,以时间顺序表示视频序列。对于第二个挑战,我们提出了思考者-说话者架构(Thinker-Talker Architecture),其中思考者负责文本生成,而说话者则专注于生成流式语音标记。说话者直接从思考者接收高级表示。这种设计受到人类利用不同器官产生各种信号的启发,同时通过相同的神经网络协调这些信号。因此,思考者-说话者架构是端到端联合训练的,每个组件都专门生成不同的信号。为了应对流式处理的挑战,并促进多模态信号的实时理解所需的预填充,我们对所有多模态编码器提出了采用分块流处理方法的修改。为了支持流式语音生成,我们实现了一个双轨道自回归模型,该模型生成语音标记,同时采用DiT模型将这些标记转换为波形,从而实现流式音频生成并减少初始延迟。此设计旨在使模型能够实时处理多模态信息,有效进行预填充,从而实现实时文本和语音信号的并发生成。

Qwen2.5-Omni在图像和音频能力方面分别可以与同样大小的Qwen2.5-VL(Wang et al., 2024c)和Qwen2-Audio(Chu et al., 2024b)相媲美。此外,Qwen2.5-Omni在多模态基准测试如OmniBench(Li et al., 2024b)和AV-Odyssey Bench(Gong et al., 2024)中也达到了最先进的性能。特别是,Qwen2.5-Omni在端到端语音指令跟随方面的表现与文本输入的能力相当,这在MMLU(Hendrycks et al., 2021a)和GSM8K(Cobbe et al., 2021)等基准测试中得到了验证。在语音生成方面,Qwen2.5-Omni在seed-tts-eval(Anastassiou et al., 2024)的test-zh、test-en和test-hard数据集上分别取得了1.42%、2.33%和6.54%的WER,优于MaskGCT(Wang et al., 2024e)和CosyVoice 2(Du et al., 2024)。

Qwen2.5-Omni的关键特性可以总结为:

- 我们推出了Qwen2.5-Omni,这是一个可以感知所有模态并以流的形式同时生成文本和自然语音响应的统一模型。

- 我们提出了一种新的位置嵌入算法,称为TMRoPE,该算法显式地包含时间信息以同步音频和视频。

- 我们提出了思考者-说话者架构,以促进实时理解和语音生成。

- Qwen2.5-Omni在与同样大小的单模态模型进行比较时,在所有模态方面表现出色。它显著增强了跟随语音指令的能力,达到了与纯文本输入相当的性能水平。对于涉及多种模态的任务,如OmniBench(Li et al., 2024b)中评估的任务,Qwen2.5-Omni实现了最先进的性能。值得注意的是,Qwen2.5-Omni在seed-tts-eval(Anastassiou et al., 2024)中表现出色,展示了强大的语音生成能力。

架构

概述

如图2所示,Qwen2.5-Omni 采用了 Thinker-Talker 架构。Thinker 类似于大脑,负责处理和理解来自文本、音频和视频模态的输入,生成高层次表示和相应的文本。Talker 则像人的嘴巴,以流式方式接收 Thinker 生成的高层次表示和文本,并流畅地输出离散的语音令牌。Thinker 是一个 Transformer 解码器,配有一个负责信息提取的音频和图像编码器。相比之下,Talker 被设计为双轨自回归 Transformer 解码器架构,灵感来源于 Mini-Omni(Xie & Wu, 2024)。在训练和推理过程中,Talker 直接接收来自 Thinker 的高维表示,并共享 Thinker 的所有历史上下文信息。因此,整个架构作为一个整体模型运行,支持端到端的训练和推理。在接下来的部分中,我们首先介绍 Qwen2.5-Omni 如何感知各种输入信号,并介绍我们提出的新型位置编码算法 TMRoPE。随后,详细阐述文本和语音生成的过程。最后,我们强调在理解和生成模块中所做出的改进,以促进高效的流式推理。

感知

文本、音频、图像和视频(无音频)。Thinker 通过将文本、音频、图像和视频(不包括音频轨)转换为一系列隐藏表示来处理这些输入。对于文本分词,我们使用 Qwen 的分词器(Yang 等,2024a),该分词器采用字节级字节对编码,词汇表包含 151,643 个常规令牌。对于音频输入和视频中的音频,我们将其重采样至 16kHz 频率,并将原始波形转换为 128 通道的梅尔频谱图,窗口大小为 25ms,步长为 10ms。我们采用 Qwen2-Audio(Chu 等,2024b)的音频编码器,使每帧音频表示大致对应于原始音频信号的 40ms 段。此外,我们使用 Qwen2.5-VL(Bai 等,2025)的视觉编码器,该编码器基于具有约 6.75 亿参数的 Vision Transformer (ViT) 模型,能够有效处理图像和视频输入。视觉编码器采用了结合图像和视频数据的混合训练方案,确保了图像理解和视频理解的熟练度。为了尽可能完整地保留视频信息,同时适应音频采样率,我们采用动态帧率进行视频采样。此外,为了保持一致性,每个图像被视为两个相同的帧。

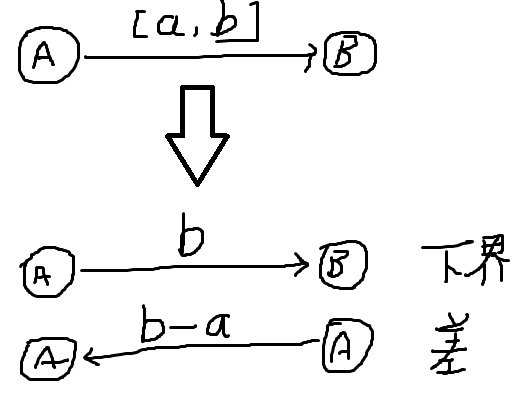

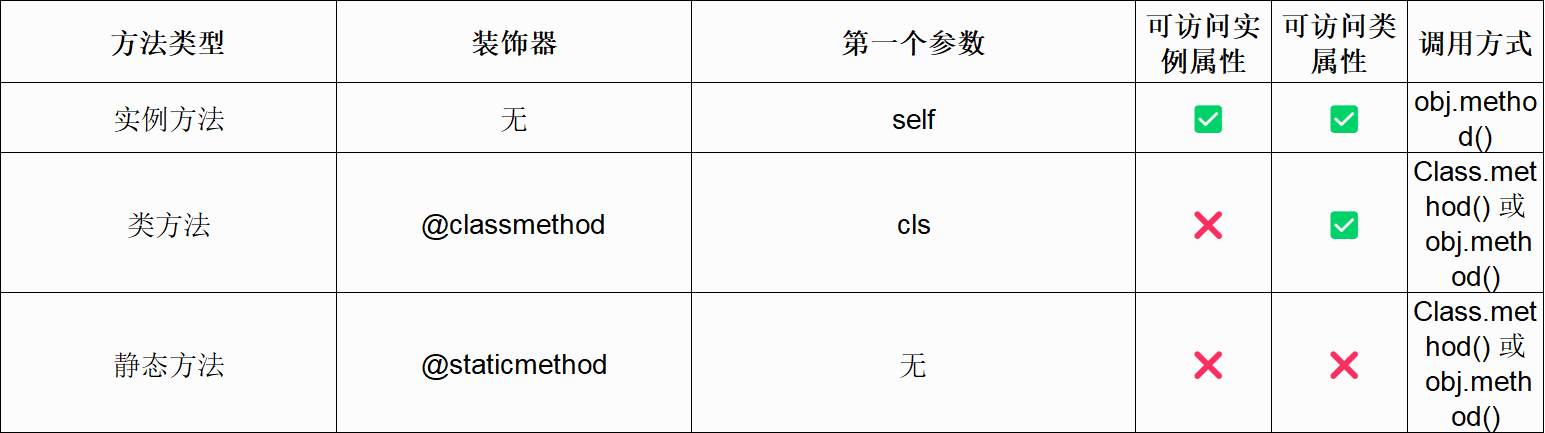

视频和 TMRoPE。我们提出了一种音频和视频的时间交错算法,以及一种新的位置编码方法。如图 3 所示,TMRoPE 编码多模态输入的三维位置信息,即具有绝对时间位置的多模态旋转位置嵌入(M-RoPE)(Bai 等,2023b)。这是通过将原始旋转嵌入分解为三个部分:时间、高度和宽度来实现的。对于文本输入,这些部分使用相同的位置 ID,使 M-RoPE 功能上等同于 1D-RoPE。类似地,对于音频输入,我们同样使用相同的位置 ID,并引入绝对时间位置编码,每个时间 ID 对应 40ms。在处理图像时,每个视觉令牌的时间 ID 保持不变,而高度和宽度组件的 ID 则根据令牌在图像中的位置分配。当输入为带有音频的视频时,音频仍以每帧 40ms 的相同位置 ID 进行编码,视频则被视为一系列图像,每帧的时间 ID 递增,高度和宽度组件的 ID 分配模式与图像相同。由于视频的帧率不固定,我们根据每帧对应的实际时间动态调整时间 ID,以确保每个时间 ID 对应 40ms。当模型输入包含多种模态时,每种模态的位置编号通过前一个模态的最大位置 ID 递增一来初始化。TMRoPE 增强了位置信息建模,最大限度地整合了各种模态,使 Qwen2.5-Omni 能够同时理解并分析来自多种模态的信息。

在将位置信息融入每种模态后,我们按顺序排列这些表示。为了使模型能够同时接收视觉和听觉信息,如图 3 所示,我们为带有音频的视频设计了一种特殊的时间交错方法,根据实际时间将视频中的音频表示分成每 2 秒一个的块。然后在 2 秒内,我们将视觉表示放在前面,音频表示放在后面,交错排列带有音频的视频的表示。

生成

文本生成。 文本由思考者直接生成。文本生成的逻辑与广泛使用的大型语言模型(LLM)的生成逻辑基本相同,这些模型通过基于词汇表的概率分布进行自回归采样来生成文本。生成过程中可能会采用重复惩罚和 top-p 采样等技术以提高多样性。

语音。说话者接收由思考者采样的文本标记的高级表示和嵌入。在这种情况下,高维表示和离散采样标记的结合是至关重要的。作为流式算法,语音生成在完整文本生成之前必须预先预测内容的语调和态度。思考者提供的高维表示隐含地传达了这些信息,从而使得流式生成过程更加自然。此外,思考者的表示在表征空间中主要表达语义相似性,而不是语音相似性。因此,即使语音上不同的词语也可能具有非常相似的高级表示,需要采样离散标记作为输入以消除此类不确定性。

我们设计了一种高效的语音编解码器 qwen-tts-tokenizer。qwen-tts-tokenizer 能够高效地表示语音的关键信息,并且可以通过因果音频解码器实时解码为语音流。接收信息后,说话者开始自回归地生成音频标记和文本标记。语音生成不需要与文本的词级和时间戳级对齐,这大大简化了训练数据和推理过程的要求。

流媒体设计

在流媒体音频和视频交互的背景下,初始数据包延迟是系统流媒体性能的关键指标。这种延迟受多个因素影响:1) 多模态信息输入处理的延迟;2) 从接收到第一个文本输入到输出第一个语音标记的延迟;3) 将第一段语音转换为音频的延迟;4) 与模型大小、计算量(FLOPs)等相关的架构自身延迟。本文将随后讨论在上述四个维度上减少这些延迟的算法和架构改进。

支持预填充。分块预填充是现代推理框架中广泛使用的一种机制。为了在多模态交互中支持它,我们修改了音频和视觉编码器,以支持时间维度上的分块注意力机制。具体而言,音频编码器从整体注意力机制转变为每2秒一个块的分块注意力机制。视觉编码器利用闪注意力(Flash Attention)进行高效的训练和推理,通过一个简单的多层感知机(MLP)层将相邻的2×2标记合并为一个标记。补丁大小设置为14,这允许不同分辨率的图像被打包成一个序列。

流媒体编解码生成。为了便于音频流,尤其是长时间序列的流媒体传输,我们提出了一种滑动窗口块注意力机制,该机制限制了当前标记对上下文的访问范围。具体而言,我们使用了流匹配(Lipman 等)DiT模型。输入代码通过流匹配转换为梅尔频谱图,然后通过修改后的BigVGAN(Lee 等)将生成的梅尔频谱图重建为波形。

如图4所示,为了从代码生成波形,我们将相邻的代码分组成块,并使用这些块作为我们的注意力掩码。我们将DiT的接受域限制为4个块,包括2个回溯块和1个前视块。在解码过程中,我们使用Flow Matching方法按片段生成mel谱,确保每个代码片段都能访问到必要的上下文块。这种方法通过保持上下文信息,提升了流式输出的质量。我们还使用这种分段方法来适应BigVGAN的固定接受域,以促进流式波形生成。

预训练

Qwen2.5-Omni 包含三个训练阶段。在第一阶段,我们锁定大语言模型(LLM)的参数,专注于训练视觉编码器和音频编码器,利用大量的音频-文本和图像-文本对,增强大语言模型的语义理解能力。在第二阶段,我们解冻所有参数,使用更广泛的多模态数据进行训练,以实现更全面的学习。在最后阶段,我们使用序列长度为32k的数据,以增强模型对复杂长序列数据的理解能力。

模型在多样化的数据集上进行预训练,数据集包括图像-文本、视频-文本、视频-音频、音频-文本和纯文本语料等多种类型。我们用自然语言提示替代层次标签,这一方法借鉴了Qwen2-Audio(Chu et al., 2024a),可以提高模型的泛化能力和指令遵循能力。

在初始预训练阶段,Qwen2.5-Omni 的 LLM 组件使用 Qwen2.5(Yang et al., 2024b)的参数进行初始化,视觉编码器与 Qwen2.5-VL 相同,音频编码器则使用 Whisper-large-v3(Radford et al., 2023)进行初始化。两个编码器在固定的 LLM 上分别进行训练,最初重点是训练各自的适配器,然后再训练编码器。这种基础训练对于模型掌握核心的视觉-文本和音频-文本关联和对齐至关重要。

预训练的第二阶段标志着一个重大进展,通过增加8000亿个与图像和视频相关的数据标记、3000亿个与音频相关的数据标记以及1000亿个与视频和音频相关的数据标记。这一阶段引入了更大规模的混合多模态数据和更多样化的任务,增强了听觉、视觉和文本信息之间的互动和理解。多模态多任务数据集的引入对于模型同时处理多种任务和模态的能力至关重要,这对于管理复杂的真实世界数据集至关重要。此外,纯文本数据在保持和提高语言能力方面发挥着重要作用。

为了提高训练效率,我们在先前的阶段中将最大标记长度限制为8192个标记。然后,我们引入长音频和长视频数据,并将原始文本、音频、图像和视频数据扩展到32,768个标记进行训练。实验结果表明,我们的数据在支持长序列数据方面表现出显著的改进。

后训练

数据格式

思考者

在后训练阶段,我们使用 ChatML (OpenAI, 2022) 格式的指令跟随数据进行指令微调。我们的数据集包括纯文本对话数据、视觉模态对话数据、音频模态对话数据和混合模态对话数据。

说话者

我们为 Talker 设计了三阶段训练过程,使 Qwen2.5-Omni 能够同时生成文本和语音响应。在第一阶段,我们训练 Talker 学习上下文延续。第二阶段利用 DPO (Rafailov et al., 2023) 提高语音生成的稳定性。第三阶段,我们应用多说话人指令微调,以提高语音响应的自然度和可控性。在情境学习 (ICL) 训练阶段,除了使用与 Thinker 类似的文本监督,我们还通过下一个标记预测执行语音延续任务,利用包含多模态上下文和口语响应的大型对话数据集。Talker 学会建立从语义表示到语音的单调映射,同时获得在语境中适当表达多样化属性(如语调、情感和口音)的能力。此外,我们实施了音色解耦技术,以防止模型将特定声音与不频繁出现的文本模式相关联。

为了扩大说话人和场景的覆盖范围,预训练数据不可避免地包含标签噪声和发音错误,导致模型产生幻觉。为了解决这一问题,我们引入了强化学习阶段以提高语音生成的稳定性。具体而言,对于每个请求和响应文本配对的参考语音,我们构建了一个包含三元组数据 (x, yw, yl) 的数据集 D,其中 x 是带有输入文本的输入序列,yw 和 yl 分别是好的和坏的生成语音序列。我们根据与单词错误率 (WER) 和标点停顿错误率相关的奖励分数对这些样本进行排名。

最后,我们对上述基础模型进行了说话人微调,使 Talker 能够采用特定的声音并提高其自然度。

评估

我们对Qwen2.5-Omni进行了全面评估。该模型分为两大类:理解(X→Text)和语音生成(X→Speech)。

X→Text的评估

在本节中,我们评估Qwen2.5-Omni对多种模态输入(文本、音频、图像和视频)的理解能力以及生成文本响应的能力。

文本→文本 我们对Qwen2.5-Omni在文本→文本方面的评估主要集中在一般评估、数学与科学能力和编程能力上。具体而言,我们使用MMLU-Pro(Wang等,2024f)、MMLU-redux(Gema等,2024)和Livebench0803(White等,2024)进行一般评估,使用GPQA(Rein等,2023)、GSM8K(Cobbe等,2021)和MATH(Hendrycks等,2021b)评估数学与科学能力,使用HumanEval(Chen等,2021)、MBPP(Austin等,2021)、MultiPL-E(Cassano等,2023)和LiveCodeBench 2305-2409(Jain等,2024)评估编程能力。

音频→文本 我们对Qwen2.5-Omni在音频→文本方面的评估包括音频理解、音频推理和语音聊天。具体而言,我们对自动语音识别(ASR)、语音转文本翻译(S2TT)、语音实体识别(SER)、声音分类(VSC)和音乐等方面进行了全面评估,这些评估涵盖了Qwen2.5-Omni在广泛音频理解任务上的表现。我们使用MMAU(Sakshi等,2024)进行音频推理任务评估,使用VoiceBench(Chen等,2024b)和自编语音指令基准进行语音聊天任务评估。

图像→文本 我们对Qwen2.5-Omni在图像→文本方面的评估主要集中在大学水平的问题、数学、一般视觉问答和OCR相关任务上。具体而言,我们使用MMMU(Yue等,2023)和MMMU-Pro(Yue等,2024)评估大学水平问题,使用MathVista(Lu等,2024b)和MathVision(Wang等,2024b)评估数学能力。对于一般视觉问答,我们在基准数据集上进行评估,例如MMBench-V1.1(Liu等,2023c)、MMVet(Yu等,2024)、MMStar(Chen等,2024a)、MME(Fu等,2023)、MuirBench(Wang等,2024a)、CRPE(Wang等,2024d)、RealWorldQA(X.AI.,2024)、MMERealWorld(Zhang等,2024)和MM-MT-Bench(Agrawal等,2024)。此外,我们还在多个OCR基准上评估Qwen2.5-Omni,如AI2D(Kembhavi等,2016)、TextVQA(Singh等,2019)、DocVQA(Mathew等,2021)、ChartQA(Masry等,2022)和OCRBench_v2(Fu等,2024b)。此外,我们还在指代表达理解基准(Kazemzadeh等,2014;Mao等,2016)、野外目标检测(Li等,2022)和自编点定位基准上评估了模型的视觉定位能力。

视频(无音频)→文本 我们在几个具有代表性的视频理解任务上评估了我们的模型,如Video-MME(Fu等,2024a)、MVBench(Li等,2024a)和EgoSchema(Mangalam等,2023)。

多模态→文本 我们在OmniBench(Li等,2024b)上展示了模型对于混合模态(图像、音频和文本)提示的能力。

文本到文本的性能

我们将Qwen2.5-Omni与同等规模(7B)的其他领先大语言模型进行对比。如表1所示,Qwen2.5-Omni的性能总体上介于Qwen2-7B和Qwen2.5-7B之间。在MMLU-Pro、MMLU-redux、MATH、GSM8K、MBPP、MultiPL-E和LiveCodeBench等大多数基准测试中,我们的模型均优于Qwen2-7B,这表明我们的模型在文本到文本的任务中表现出色。

表1:7B+纯文本模型和Qwen2.5-Omni的文本到文本性能

| 数据集 | Gemma2-9B | Llama3.1-8B | Qwen2-7B | Qwen2.5-7B | Qwen2.5-Omni-7B |

|---|---|---|---|---|---|

| 通用任务 | |||||

| MMLU-Pro | 52.1 | 48.3 | 44.1 | 56.3 | 47.0 |

| MMLU-redux | 72.8 | 67.2 | 67.3 | 75.4 | 71.0 |

| LiveBench0831 | 30.6 | 26.7 | 29.2 | 35.9 | 29.6 |

| 数学与科学任务 | |||||

| GPQA | 32.8 | 32.8 | 34.3 | 36.4 | 30.8 |

| MATH | 44.3 | 51.9 | 52.9 | 75.5 | 71.5 |

| GSM8K | 76.7 | 84.5 | 85.7 | 91.6 | 88.7 |

| 编码任务 | |||||

| HumanEval | 68.9 | 72.6 | 79.9 | 84.8 | 78.7 |

| MBPP | 74.9 | 69.6 | 67.2 | 79.2 | 73.2 |

| MultiPL-E | 53.4 | 50.7 | 59.1 | 70.4 | 65.8 |

| LiveCodeBench2305-2409 | 18.9 | 8.3 | 23.9 | 28.7 | 24.6 |

音频→文本性能

我们在多样化的音频理解、音频推理和语音聊天基准上,将Qwen2.5-Omni与其他领先的专家模型或通用模型进行了比较。如表2和表3所示,Qwen2.5-Omni在音频理解方面提供了与现有其他最先进方法相当或更好的性能。例如,在Fleurs_zh、CommonVoice_en、CommonVoice_zh、CoVoST2_en-de 和 CoVoST2_zh-en 测试集中,Qwen2.5-Omni在自动语音识别(ASR)和语音到文本翻译(S2TT)任务上取得了优越的成绩,超过了Whisper-large-v3、Qwen2Audio、MinMo及其他Omni模型等之前的最先进模型。Qwen2.5-Omni在音乐和视觉声音分类(VSC)等一般音频理解任务上也取得了最前沿的成绩。

此外,Qwen2.5-Omni在音频推理中表现出色,尤其在MMAU基准的音效、音乐和语音子集上取得了最优秀的表现。这些结果展示了Qwen2.5-Omni在广泛音频理解和推理方面的强大能力。此外,在VoiceBench上,Qwen2.5-Omni实现了74.12的平均得分,超过了其他类似规模的音频语言模型和多模态模型。这展示了我们的模型在语音交互方面的强大能力。为了进一步探索多样化的语音交互性能,我们将几个纯文本基准中的文本指令转换为语音,并在内部语音聊天基准上评估Qwen2.5-Omni、Qwen2-Audio和Qwen2-7B。约90%的文本指令被使用。我们为Qwen2.5-Omni和Qwen2-Audio使用语音指令,而为Qwen2-7B使用文本指令。如表4所示,与Qwen2-Audio相比,Qwen2.5-Omni显著缩小了与使用文本指令的Qwen2-7B之间的差距。这反映了我们的模型在多样化端到端语音交互中取得了显著进步。

图像 → 文本性能

为了全面评估图像 → 文本任务的能力,我们将 Qwen2.5-Omni 与最近的最先进的大型视觉语言模型 Qwen2.5-VL-7B 以及其他表现最佳的全模态模型进行了比较。如表 5 所示,Qwen2.5-Omni 在性能上与 Qwen2.5-VL-7B 相当,并在 MMMU、MathVision、MMBench-V1.1-EN、TextVQA、DocVQA 和 ChartQA 上比其他任何开源全模态模型都取得了更好的结果。此外,Qwen2.5-Omni 在大多数基准测试中也超越了 GPT4o-mini。这些结果揭示了我们模型在图像理解方面的卓越能力。

为了进行视觉定位的比较,我们将Qwen2.5-Omni与Qwen2.5-VL-7B以及其他领先的多模态语言模型(LVLMs)如Gemini和Grounding-DINO(Liu et al., 2024)进行了对比。如表6所示,我们的模型在从框定位到点定位的大多数基准测试中均优于其他模型,并在开放词汇对象检测中取得了42.2mAP的良好性能,这显示了我们模型的强大视觉定位能力。

表6:Qwen2.5-Omni和其他模型的 grounding 性能

| 数据集 | Gemini 1.5 Pro | Grounding DINO | Qwen2.5-VL-7B | Qwen2.5-Omni-7B |

|---|---|---|---|---|

| Refcocoval | 73.2 | 90.6 | 90.0 | 90.5 |

| RefcocotextA | 72.9 | 93.2 | 92.5 | 93.5 |

| RefcocotextB | 74.6 | 88.2 | 85.4 | 86.6 |

| Refcoco+val | 62.5 | 88.2 | 84.2 | 85.4 |

| Refcoco+textA | 63.9 | 89.0 | 89.1 | 91.0 |

| Refcoco+textB | 65.0 | 75.9 | 76.9 | 79.3 |

| Refcocogval | 75.2 | 86.1 | 87.2 | 87.4 |

| Refcocogtest | 76.2 | 87.0 | 87.2 | 87.9 |

| ODinW | 36.7 | 55.0 | 37.3 | 42.2 |

| PointGrounding | - | - | 67.3 | 66.5 |

视频→文本的性能

类似于图像→文本,我们将Qwen2.5-Omni与Qwen2.5-VL-7B及其他全模态模型进行了比较。如表7所示,Qwen2.5-Omni在所有其他开源全模态模型和GPT-4o-Mini中表现出色,且与Qwen2.5-VL-7B相比,取得了更好的或具有竞争力的结果,这表明其在视频理解方面具有优越的性能。

多模态→文本的性能

如表8所示,Qwen2.5-Omni在OmniBench上的表现达到了最先进水平,远超其他全模态模型,这表明我们的模型在多模态理解方面具有显著优势。

X→Speech 评估

在本节中,我们评估Qwen2.5-Omni的语音生成能力。由于缺乏相关评估,语音生成的评估主要集中在给定文本的语音生成能力上,类似于文本到语音(TTS),评估集中在两个方面:零样本语音生成能力和单讲者语音生成能力。

• 零样本语音生成

我们在SEED(Anastassiou等,2024)数据集上评估了模型在零样本语音生成中的内容一致性(WER)和讲者相似度(SIM)。

• 单讲者语音生成

我们在SEED(Anastassiou等,2024)数据集上评估了讲者精细化模型的稳定性,并在自创建的数据集上评估了生成语音的主观自然度(NMOS)。

零样本语音生成评估

我们将Qwen2.5-Omni与最先进的零样本TTS系统进行了比较。如表9所示,Qwen2.5-Omni展示了极具竞争力的性能,突显了其通过上下文学习(ICL)发展出的强大的语音理解和生成能力。此外,经过强化学习(RL)优化后,Qwen2.5-Omni在生成稳定性方面有了显著提升,特别是在具有挑战性的测试困难数据集上,显著减少了注意力错位、发音错误和不适当的停顿。

单讲者语音生成评估

我们比较了Qwen2.5-Omni模型在讲者精细化前后的表现,以及与人类录音的表现。如表10所示,经过讲者精细化的Qwen2.5-Omni更准确地捕捉到了目标讲者的细微韵律风格,同时保持了基础模型提供的稳定性,其性能在主观和客观指标上均达到了接近人类水平的质量。

结论

Qwen2.5-Omni 是一个统一的模型,旨在理解和生成多种模态,包括文本和实时语音。为了增强视频集成,我们引入了一种新的位置嵌入方法,称为 TMRoPE,用于对齐音频和视频时间。我们的 Thinker-Talker 框架支持实时语音生成,同时尽量减少不同模态之间的干扰。此外,我们采用了块状音频/视觉编码和滑动窗口机制等技术进行从代码到波形的生成。这一创新模型在复杂的视听交互和语音对话的情感上下文中表现出色。全面的评估表明,Qwen2.5-Omni 在遵循语音指令等方面超越了同样大小的单模态模型,并在多模态任务中达到了最先进的性能。在模型开发过程中,我们识别了先前学术研究中经常被忽视的几个关键问题,例如视频 OCR 和音频-视频协同理解。解决这些挑战需要学术界和工业界的协作,特别是在构建全面的评估基准和研究数据集方面。我们相信 Qwen2.5-Omni 代表了向通用人工智能(AGI)迈出的重要一步。未来的目标包括开发一个更强大、速度更快的模型,并扩展在图像、视频和音乐等各种模态上的输出能力。