部署Dashboard|部署Prometheus|HPA集群

- Dashboard

- 部署Dashboard

- 上传镜像到私有仓库

- 安装服务

- 发布服务

- 创建管理用户

- 查看登录的Token信息

- Prometheus

- 步骤一:导入所有后续需要的镜像到私有镜像仓库(在master主机操作操作)

- 步骤二:修改资源文件部署各种容器服务(在master主机操作操作)

- 步骤三:对外发布grafana服务(在master主机操作)

- 步骤四:配置grafana

- 步骤一:配置grafana(在任意主机操作)

- HPA

- 步骤一:部署一个弹性集群(在master主机操作)

- 步骤二:查看动态扩容效果

Dashboard

部署Dashboard

上传镜像到私有仓库

# 上传dashboard

[root@master dashboard]# docker load -i dashboard.tar.gz

[root@master dashboard]# docker tag kub../dashboard:v2.0.0 192.168....

[root@master dashboard]# docker push 192...:v2.0.0

# 上传metrics-scraper镜像

[root@master dashboard]# docker load -i metrics-scraper.tar.gz

[root@master dashboard]# docker tag kub../metrics-scraper:v2.0.0 192.168....

[root@master dashboard]# docker push 192...:v2.0.0

安装服务

[root@master dashboard]# kubectl apply -f recommended.yaml

[root@master dashboard]# kubectl -n kubernetes-dashboard get pods

NAME READY STATUS RESTARTS AGE

dashboard-metrics-scraper-844d8585c9-w26m4 1/1 Running 0 10s

kubernetes-dashboard-6c58946f65-4bdtb 1/1 Running 0 10s

发布服务

ClusterIP 只能在集群内部访问

NodePort 和 Ingress 可以在外部访问

[root@master dashboard]# kubectl -n kubernetes-dashboard get service

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

dashboard-metrics-scraper ClusterIP 10.245.205.236 <none> 8000/TCP 13s

kubernetes-dashboard ClusterIP 10.245.215.40 <none> 443/TCP 14s[root@master dashboard]# sed -n '30,45p' recommended.yaml >dashboard-svc.yaml

[root@master dashboard]# vim dashboard-svc.yaml

---

kind: Service

apiVersion: v1

metadata:labels:k8s-app: kubernetes-dashboardname: kubernetes-dashboardnamespace: kubernetes-dashboard

spec:type: NodePortports:- port: 443nodePort: 30443targetPort: 8443selector:k8s-app: kubernetes-dashboard[root@master dashboard]# kubectl apply -f dashboard-svc.yaml

service/kubernetes-dashboard configured

[root@master dashboard]# kubectl -n kubernetes-dashboard get service

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

dashboard-metrics-scraper ClusterIP 10.245.205.236 <none> 8000/TCP 5m50s

kubernetes-dashboard NodePort 10.245.215.40 <none> 443:30443/TCP 5m51s

浏览器访问任意节点IP的30443端口(http://任意节点:30443 端口

创建管理用户

[root@master dashboard]# cat admin-token.yaml #查看、学习资源文件

---

apiVersion: v1

kind: ServiceAccount

metadata:name: admin-usernamespace: kubernetes-dashboard

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:name: admin-user

roleRef:apiGroup: rbac.authorization.k8s.iokind: ClusterRolename: cluster-admin

subjects:

- kind: ServiceAccountname: admin-usernamespace: kubernetes-dashboard

[root@master dashboard]# kubectl create -f admin-token.yaml #创建资源

查看登录的Token信息

先通过get screts查看名称,该名称是随机的,然后再通过查询到的名称继续查询对应的Token信息。

[root@master ~]# kubectl -n kubernetes-dashboard get secrets

NAME TYPE

admin-user-token-xxx kubernetes.io/service-account-token ... ...

[root@master ~]# kubectl -n kubernetes-dashboard describe secrets \

... ...

token: eyJhbGciOiJSUzI1NiIsImtpZCI6IjJyTE9nZWpWLWFhTXV6cnJla3U4aX

NngxVTZjV2M5Y0FYOWR0ancifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9 ... ...

再次使用浏览器访问任意节点IP的30090端口(http://任意节点:30090 端口)即可查看Web页面,输入Token,效果如图-2所示。

Prometheus

镜像及资源文件

步骤一:导入所有后续需要的镜像到私有镜像仓库(在master主机操作操作)

所有镜像文件在云盘第四阶段kubernetes/v1.17.6/prometheus/images目录下,各位同学需要提前下载。

需要导入的镜像包括:

prometheus.tar.gz

prometheus-operator.tar.gz

prometheus-config-reloader.tar.gz

prometheus-adapter.tar.gz

node-exporter.tar.gz

kube-rbac-proxy.tar.gz

kube-metrics.tar.gz

grafana.tar.gz

configmap-reload.tar.gz

alertmanager.tar.gz

注意:tab修改标签时,只需要修改服务器即可,禁止修改镜像原来的名称与标签。

[root@master ~]# docker load -i prometheus.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag 旧名称 192.168.1.100:5000/prometheus:v2.11.0

[root@master ~]# docker push 192.168.1.100:5000/prometheus:v2.11.0

[root@master ~]# docker load -i prometheus-operator.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/prometheus-operator:v0.35.1

[root@master ~]# docker push 192.168.1.100:5000/prometheus-operator:v0.35.1

[root@master ~]# docker load -i prometheus-config-reloader.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/prometheus-config-reloader:v0.35.1

[root@master ~]# docker push \

192.168.1.100:5000/prometheus-config-reloader:v0.35.1

[root@master ~]# docker load -i prometheus-adapter.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/prometheus-operator:v0.35.1

[root@master ~]# docker push 192.168.1.100:5000/prometheus-operator:v0.35.1

[root@master ~]# docker load -i node-exporter.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/node-exporter:v1.0.0

[root@master ~]# docker push 192.168.1.100:5000/node-exporter:v1.0.0

[root@master ~]# docker load -i kube-rbac-proxy.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/kube-rbac-proxy:v0.4.1

[root@master ~]# docker push 192.168.1.100:5000/kube-rbac-proxy:v0.4.1

[root@master ~]# docker load -i kube-metrics.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/kube-state-metrics:v1.9.2

[root@master ~]# docker push 192.168.1.100:5000/kube-state-metrics:v1.9.2

[root@master ~]# docker load -i alertmanager.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/grafana:6.4.3

[root@master ~]# docker push 192.168.1.100:5000/grafana:6.4.3

[root@master ~]# docker load -i configmap-reload.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/configmap-reload:v0.3.0

[root@master ~]# docker push 192.168.1.100:5000/configmap-reload:v0.3.0

[root@master ~]# docker load -i alertmanager.tar.gz

[root@master ~]# docker images #查看镜像的名称

[root@master ~]# docker tag \

旧名称 192.168.1.100:5000/alertmanager:v0.18.0

[root@master ~]# docker push 192.168.1.100:5000/alertmanager:v0.18.0

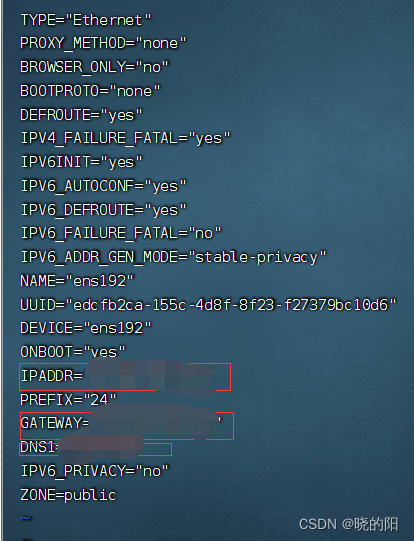

步骤二:修改资源文件部署各种容器服务(在master主机操作操作)

1)安装operator

需要修改资源文件,默认资源文件制定的是从官网下载镜像启动容器,我们需要修改为自己的192.168.1.100私有镜像仓库的路径。

[root@master prometheus]# vim setup/prometheus-operator-deployment.yaml

27 - --config-reloader-image=192.168.1.100:5000/configmap-reload:v0.3.0

28 - --prometheus-config-reloader=192.168.1.100:5000/prometheus-config-reloader:v0.35.1

29 image: 192.168.1.100:5000/prometheus-operator:v0.35.1

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f setup/

2)安装Prometheus server

需要修改资源文件,默认资源文件制定的是从官网下载镜像启动容器,我们需要修改为自己的192.168.1.100私有镜像仓库的路径。

[root@master prometheus]# vim prom-server/prometheus-prometheus.yaml

14 baseImage: 192.168.1.100:5000/prometheus

34 version: v2.11.0

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f prom-server/

3)安装prom-adapter

需要修改资源文件,默认资源文件制定的是从官网下载镜像启动容器,我们需要修改为自己的192.168.1.100私有镜像仓库的路径。

[root@master prometheus]# vim prom-adapter/prometheus-adapter-deployment.yaml

28 image: 192.168.1.100:5000/k8s-prometheus-adapter-amd64:v0.5.0

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f prom-adapter/

4)安装metrics-state

需要修改资源文件,默认资源文件制定的是从官网下载镜像启动容器,我们需要修改为自己的192.168.1.100私有镜像仓库的路径。

[root@master prometheus]# vim metrics-state/kube-state-metrics-deployment.yaml

24 image: 192.168.1.100:5000/kube-rbac-proxy:v0.4.1

41 image: 192.168.1.100:5000/kube-rbac-proxy:v0.4.1

58 image: 192.168.1.100:5000/kube-state-metrics:v1.9.2

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f metrics-state/

5)安装node-exporter

需要修改资源文件,默认资源文件制定的是从官网下载镜像启动容器,我们需要修改为自己的192.168.1.100私有镜像仓库的路径。

[root@master prometheus]# vim node-exporter/node-exporter-daemonset.yaml

27 image: 192.168.1.100:5000/node-exporter:v1.0.0

57 image: 192.168.1.100:5000/kube-rbac-proxy:v0.4.1

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f node-exporter/

6)安装alertmanager

需要修改资源文件,默认资源文件制定的是从官网下载镜像启动容器,我们需要修改为自己的192.168.1.100私有镜像仓库的路径。

[root@master prometheus]# vim alertmanager/alertmanager-alertmanager.yaml

09 baseImage: 192.168.1.100:5000/alertmanager

18 version: v0.18.0

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f alertmanager/

7)安装grafana

[root@master prometheus]# vim grafana/grafana-deployment.yaml

19 - image: 192.168.1.100:5000/grafana:6.4.3

#提示:上面这些镜像的链接路径如果不知道,可以使用docker images查看。

[root@master prometheus]# kubectl apply -f grafana/

步骤三:对外发布grafana服务(在master主机操作)

相关资源文件共享在云盘第四阶段kubernetes/v1.17.6/prometheus/ grafana/grafana-service.yaml。

下面使用使用nodePort发布服务将容器的3000端口映射到真机节点的30000端口。

[root@master prometheus]# vim grafana/grafana-service.yaml

... ...

spec:type: NodePortports:- name: httpport: 3000nodePort: 30000targetPort: http

... ...

[root@master prometheus]# kubectl apply -f grafana/grafana-service.yaml

使用浏览器访问任意节点的30002端口,即可访问到Web网页,效果如图所示。

步骤四:配置grafana

步骤一:配置grafana(在任意主机操作)

1)登录

登录的默认用户和密码:admin/admin

第一次登录需要修改密码

2)修改数据源地址

我们添加的数据为prometheus

数据源就是 Prometheus service 的地址

可以填写prometheus的Service内部的DNS名称

http://prometheus-k8s.monitoring.svc.cluster.local:9090

如何查看到这个DNS的域名呢?可以执行如下的命令即可。

[root@master ~]# kubectl -n monitoring get service

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S)

grafana NodePort 10.254.169.248 <none> 3000:30002/TCP

prometheus-k8s NodePort 10.254.44.72 <none> 9090:30001/TCP

... ...

# 找到这里的prometheus-k8s名称后

# 在它的后面附加一个固定的monitoring.svc.cluster.local:9090

# 连接在一起就是:http://prometheus-k8s.monitoring.svc.cluster.local:9090

修改数据源。

添加数据源Prometheus,名字随意,URL需要填写Prometheus内部的DNS名称,

默认端口号 9090。

3)导入模板

导入模板,需要正确配置后点击保存和测试后开始添加仪表盘

点开import,输入模板ID,

最后查看监控效果

HPA

步骤一:部署一个弹性集群(在master主机操作)

[root@master ~]# vim myhpa.yaml

---

apiVersion: apps/v1

kind: Deployment

metadata:name: myweb

spec:selector:matchLabels:app: apachereplicas: 1template:metadata:labels:app: apachespec:containers:- name: apacheimage: 192.168.1.100:5000/myos:httpdports:- containerPort: 80resources:requests:cpu: 200mrestartPolicy: Always

---

apiVersion: v1

kind: Service

metadata:name: web-service

spec:ports:- protocol: TCPport: 80targetPort: 80selector:app: apachetype: ClusterIP

---

apiVersion: extensions/v1beta1

kind: Ingress

metadata:name: my-appannotations:kubernetes.io/ingress.class: "nginx"

spec:backend:serviceName: web-serviceservicePort: 80

---

apiVersion: autoscaling/v1

kind: HorizontalPodAutoscaler

metadata:name: myweb

spec:minReplicas: 1 # 最小资源maxReplicas: 3 # 最大资源 scaleTargetRef:apiVersion: apps/v1kind: Deploymentname: myweb # 监视资源targetCPUUtilizationPercentage: 50 # 警戒线 大于50%扩容

[root@master ~]# kubectl apply -f hpa-example.yaml

[root@master ~]# kubectl get hpa

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE

myweb Deployment/myweb 0%/50% 1 3 1 15m

步骤二:查看动态扩容效果

[root@master ~]# kubectl get hpa

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE

myweb Deployment/myweb 287%/50% 1 3 3 16m

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

myweb-7f89fc7b66-kzhj5 1/1 Running 0 16m

myweb-7f89fc7b66-nh4kn 1/1 Running 0 21s

myweb-7f89fc7b66-q2jnf 1/1 Running 0 21s

#当容器CPU占用过高时,集群可以自动扩容

-----------------------------------------------------------------------------

[root@master ~]# kubectl get hpa

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE

myweb Deployment/myweb 1%/50% 1 3 3 20m

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

myweb-7f89fc7b66-kzhj5 1/1 Running 0 22m

# 当容器CPU占用率恢复正常时,容器可以自动缩减