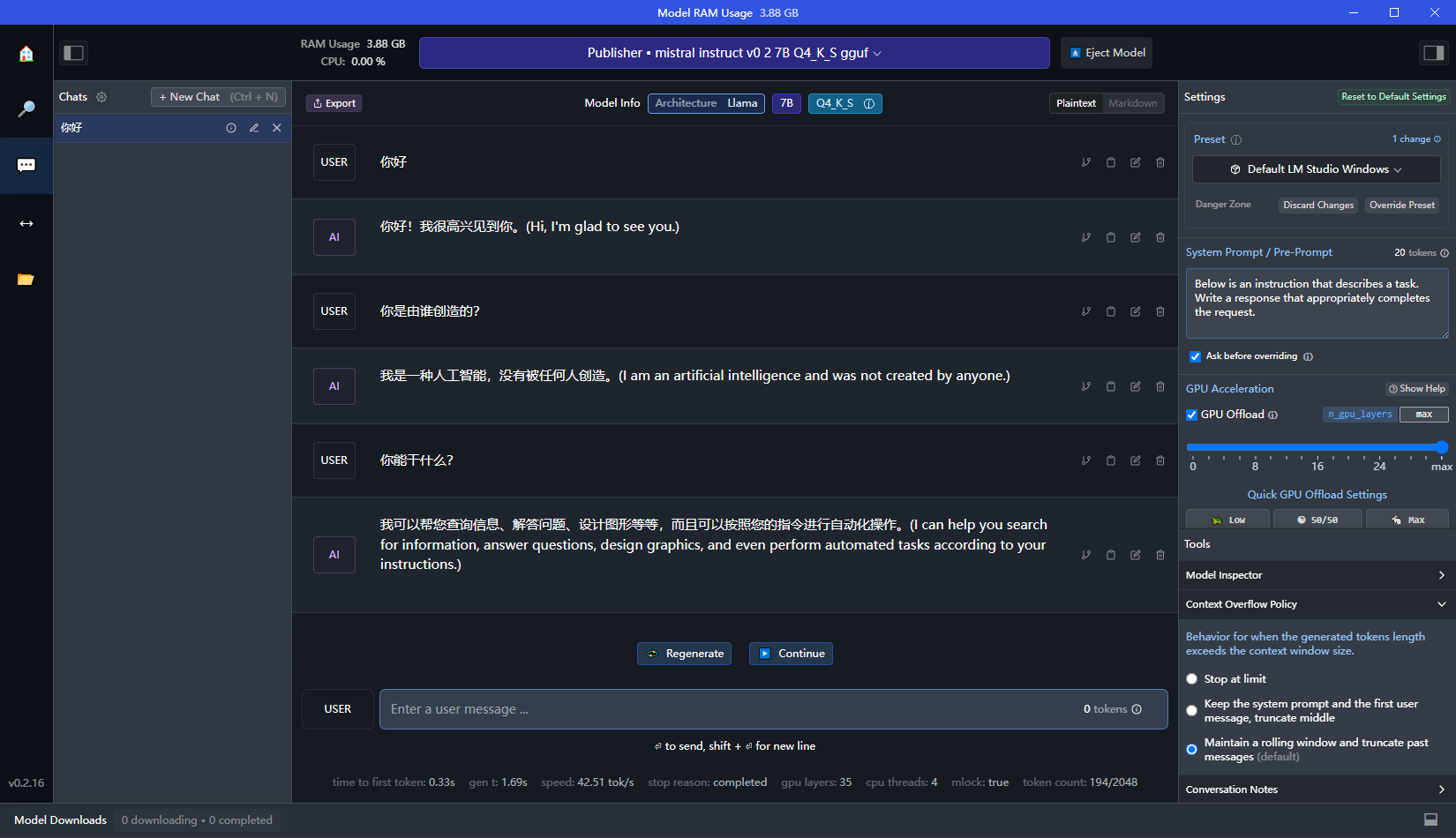

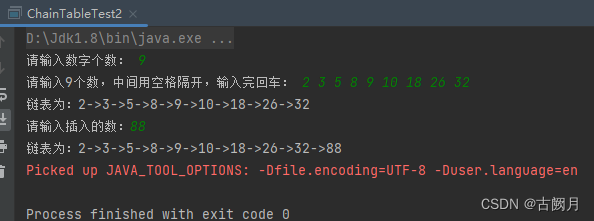

先看效果:

LM Studio是我目前见到最好用,也是最简单的本地测试AI模型的工具,不需要安装python环境以及众多的组件,加载模型、启用GPU、聊天都非常简单。而且可以切换很多不同类型的大语言模型,同时支持在Windows和MAC上的PC端部署。使用LM Studio不需要深厚的技术背景或复杂的安装过程。传统上,本地部署大型语言模型如Lama CPP或GPT-4ALL往往伴随着繁琐的安装步骤和环境配置,这对技术要求极高。然而,LM Studio的出现彻底改变了这一局面。它提供了一个简单的安装程序,用户只需几个简单的步骤就可以轻松安装和运行。

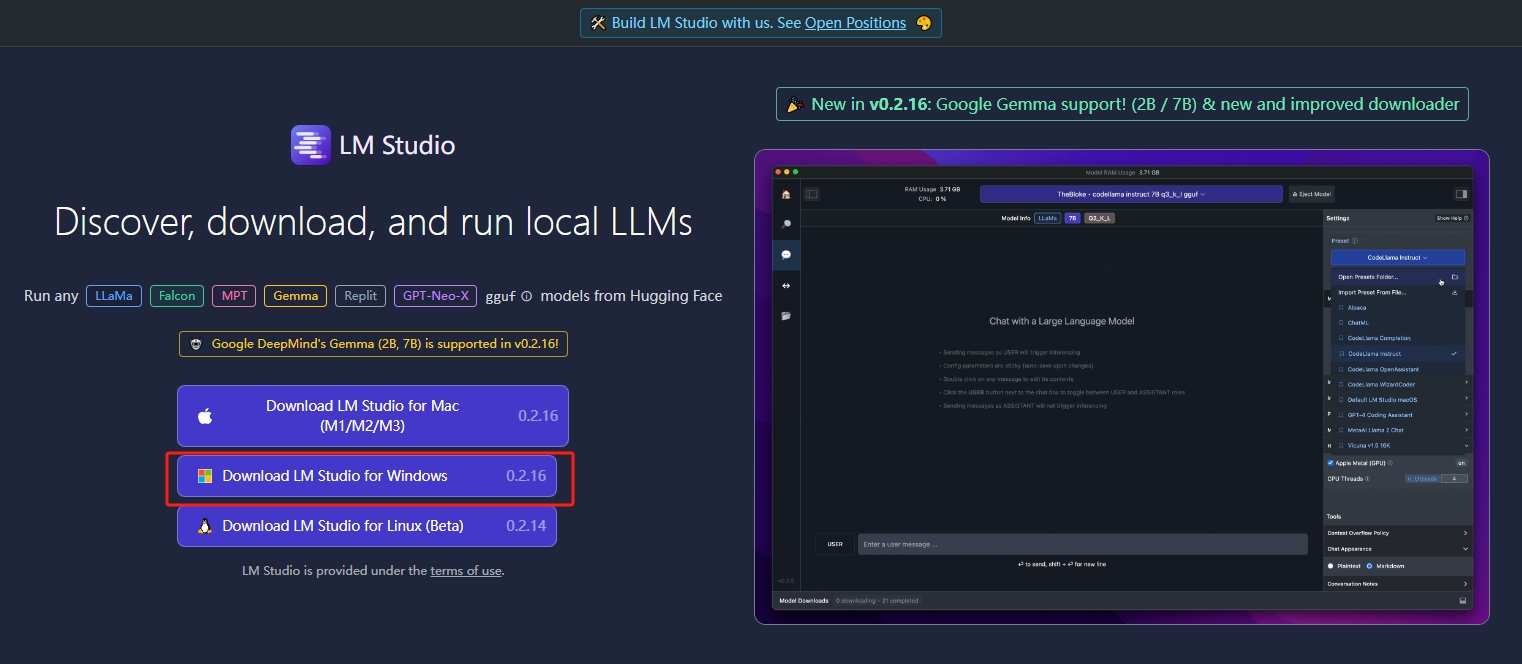

安装

官网,选择下载windows版本或MAC版本

下载完成安装之后主界面,

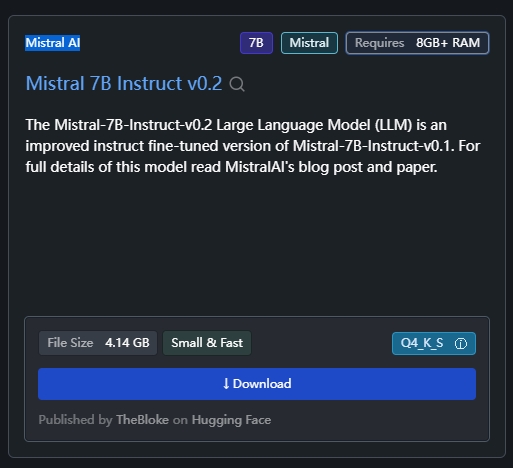

Mistral AI是一家来自法国的人工智能创业公司,由前Meta和DeepMind的研究员创立,主要开发基于自然语言处理、机器视觉和深度学习的人工智能技术,其中自然语言生成技术是他们的主打业务。他们于今年6月份获得了113亿美元的种子轮融资,公司的愿景是创建一个开放、可靠、高效、可扩展、可解释和可审计的人工智能平台。

公司的团队由一群拥有丰富研发和项目经验的精英组成。他们推出了一款只有73亿参数的语言模型Mistral7B,并且在众多基准测试中,包括在所有基准测试中均优于Llama213B,成为了目前最强的开源大语言模型。而且,他们的技术和模型设计独树一帜,已经拥有了一系列核心专利和技术成果。近期,他们还发布了Mixtral8x7B,这是一个基于Apache20许可证的高质量模型,显示出了他们在模型开发和优化方面的实力和潜力。Mistral AI的目标市场主要包括全球客户,其致力于为全球客户提供最优质的人工智能解决方案,以推进人工智能技术的研究和开发,并有望在未来成为欧洲甚至全球高端人工智能公司的领军者之一。同时,中国市场对其也尤为重要。

下载模型

选择Mistral 7B Instruct v0.2 点击 download

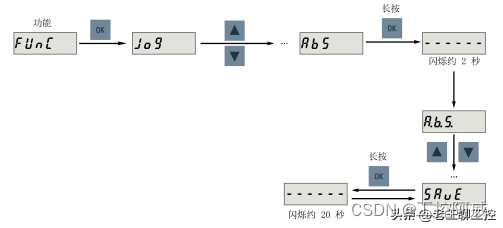

装载本地模型

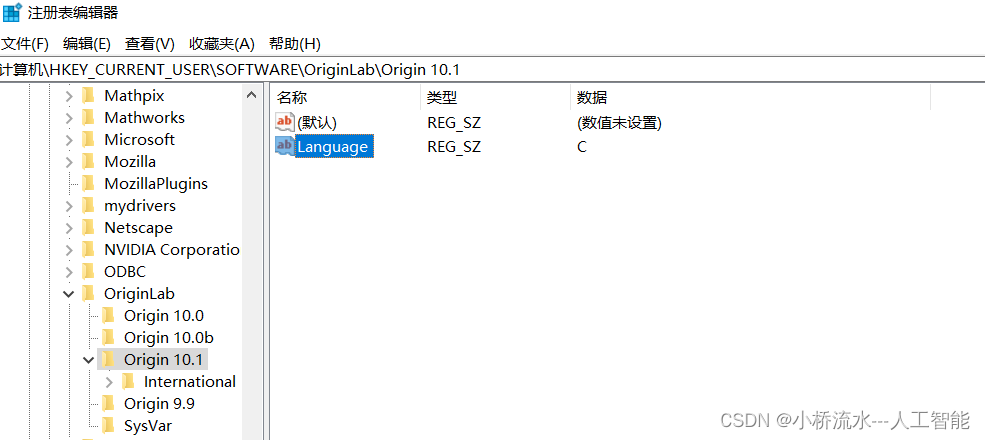

有时候LM Studio内的模型无法下载,我们可以加载本地模型,新建models\Publisher\Repository 文件夹,将模型文件放入Repository 内,选择my models,改变模型加载目录为models即可。

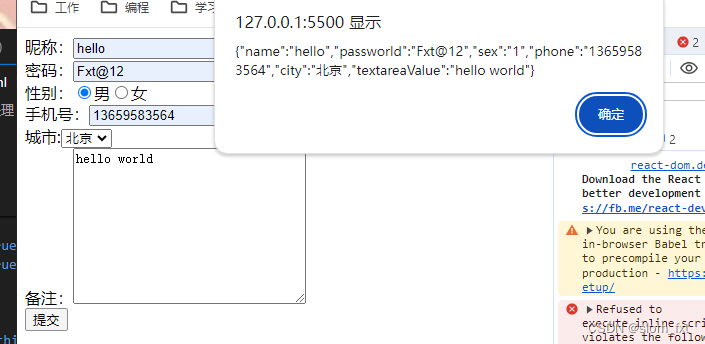

使用模型聊天

选择AI Chat,选择已经装载了的模型,就可以开始聊天了。

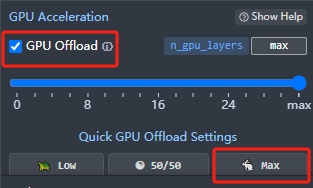

启用GPU

选中GPU Offload,选择"max"

聊天的速度变快了很多

参考: 金双石科技

![[剪藏] - 瑞萨收购Altium!](https://img-blog.csdnimg.cn/direct/f9994d10d83d48f3820fb5282bdfd0a6.jpeg)