论文网址:BrainVGAE: End-to-End Graph Neural Networks for Noisy fMRI Dataset | IEEE Conference Publication | IEEE Xplore

英文是纯手打的!论文原文的summarizing and paraphrasing。可能会出现难以避免的拼写错误和语法错误,若有发现欢迎评论指正!文章偏向于笔记,谨慎食用

目录

1. 省流版

1.1. 心得

1.2. 论文总结图

2. 论文逐段精读

2.1. Abstract

2.2. Introduction

2.3. Related Work

2.3.1. Deep Neural Networks (DNNs) for fRMI analysis

2.3.2. Variational Graph Auto-Encoders (VGAE)

2.4. Brainvgae

2.4.1. Preliminaries

2.4.2. BrainVGAE

2.5. Experimental Setup and Results

2.5.1. ABIDE Dataset

2.5.2. Experimental Setup

2.5.3. Results

2.6. Conclusion

3. 知识补充

3.1. Margin Sampling

3.2. Top-k sparsification

3.3. Graph Diffuse Convolution

4. Reference List

1. 省流版

1.1. 心得

(1)完了疑问都夹在笔记里面了啊

1.2. 论文总结图

2. 论文逐段精读

2.1. Abstract

①People pays little attention on node connectivity (edges), which causing performance decreasing in dealing with noisy dataset

②They designed a Variational Graph Auto-Encoders (VGAE)-based end-to-end framework

2.2. Introduction

①By adopting the time series as feature, deep learning (DL) and machine learning (ML) can be used to classify patients and healthy controls (HC). Also, modelling brain as graph can also used for classification

②⭐作者直接否认了选择绝对值top 10%节点的做法,但没有解释原因,只是说“可能会损害嘈杂数据集的性能”

③A plug-and-play edge predictor, BrainVGAE:

(作者说左边是输入图。为什么是不对称的,是有向图吗?后面说根据概率添加或删除边,得到了“邻接矩阵”,仍然是不对称的。所以是有向??)

④“我们建议 BrainVGAE 可以用作基于 GNN 的 fMRI 分析的通用框架,而不是试图超越 SOTA。”

2.3. Related Work

2.3.1. Deep Neural Networks (DNNs) for fRMI analysis

①CNN, RNN, AE are all be used in fMRI analysis

②They adopt each ROI as node

2.3.2. Variational Graph Auto-Encoders (VGAE)

①Edge augmentation enhances the performance on node classification tasks

②Do not change the number of "connectives" of each node(什么意思啊,边数目?上面那个图明明改了啊。对,下面说了边集合就是连接集合。你意思每个图的总数不变?有必要吗)

2.4. Brainvgae

2.4.1. Preliminaries

(1)Brain-to-Graph construction

①Atlas: e.g. CC200(你都无向图了你到底为什么不对称啊!!)

②Defining the graph , where

denotes the number of nodes

③ is the feature matrix,

denotes the feature dimension

④ denotes adjacency matrix

⑤Node feature: Pearson correlation

⑥Edge feature: partial correlation among vertices

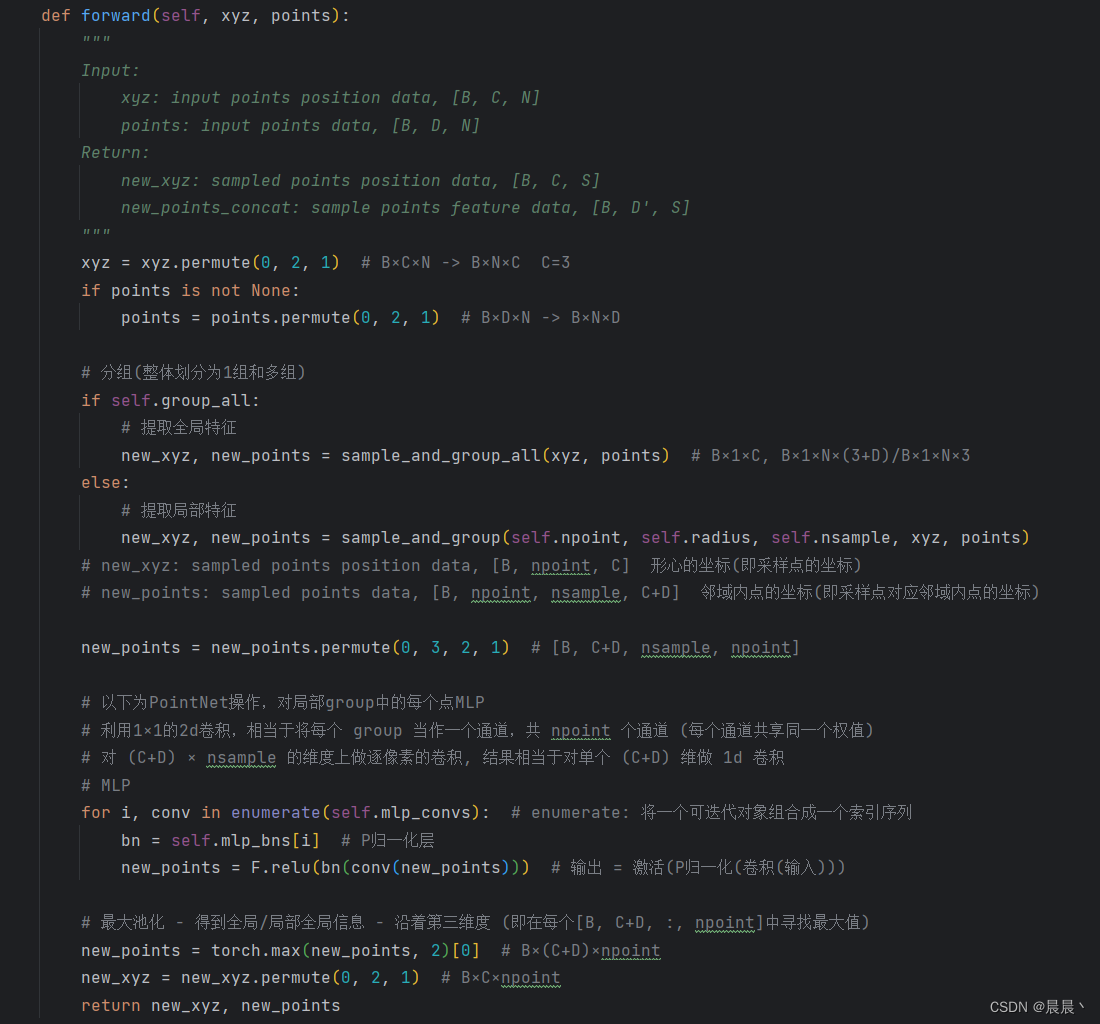

(2)Graph Convolutional Network (GCN)

①They choose GCN as the GNN:

2.4.2. BrainVGAE

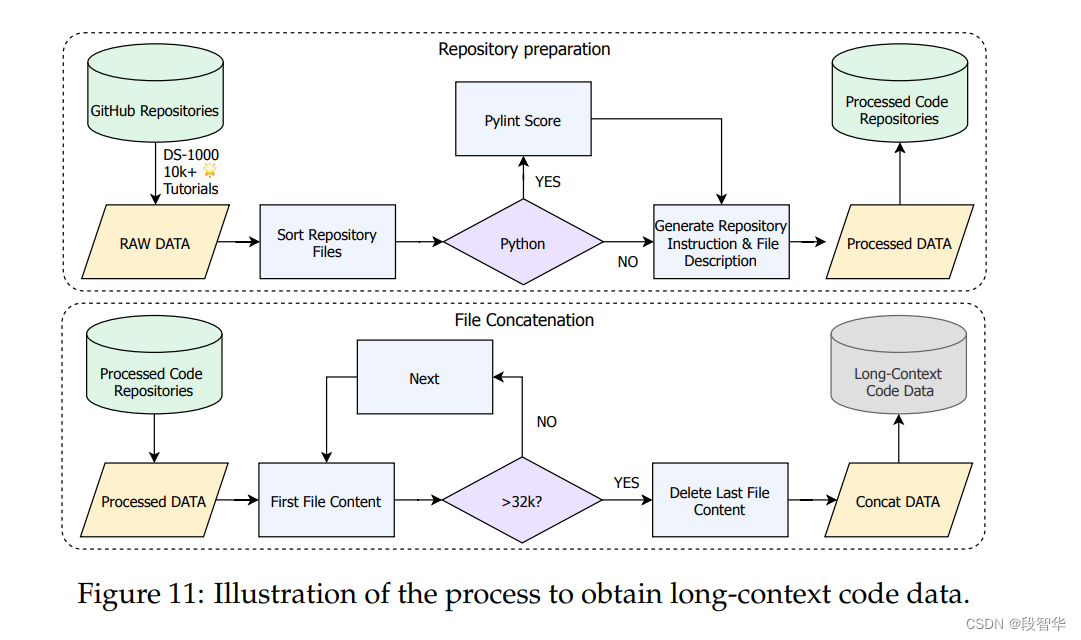

Overall framework:

(1)VGAE-based Edge Predictor

①Given original adjacency matrix and feature matrix

, the outputs construct the prediction result:

where the latent variable:

②They apply Binary Cross Entropy (BCE) loss on edge prediction loss:

⭐which can eliminate potential distribution shift

③"The predicted inter-ROIs connectivity is then further sampled to improve out-of-distribution robustness:"(为什么邻接矩阵也要pred?)

④⭐The number of edges need to be added or removed is a hyperparameter. Also, the edge number of each ROI keeps the same

⑤Training edge predictor by unsupervised method:

where denotes the Gaussian prior

;

represents the adjacency matrix likelihood conditioned on the latent variable(可能前面有Log吧)

(2)GNN-based Feature Extractor

①Convolutional layer: GCN

②Node pooling layer: top-k pooling with . What is more, the pooling loss can be:

where denotes the total score of

remaining nodes;

denotes the total nodes at

-th layer

③Applying global average pooling and global max pooling in readout layer:

and the final aggregation vector is sumed up by all the readout layer:

④Overview: 2 conv-pool-read layers

⑤Schematic feature extractor:

(3)Label Classifier

①The label prediction loss:

②The final weighted sum loss:

2.5. Experimental Setup and Results

2.5.1. ABIDE Dataset

①Dataset: ABIDE I

②Samples: 1035

2.5.2. Experimental Setup

(1)Graph Construction

①Atlas: Craddock 200

②⭐Graph sparsification: top-k sparsification by Graph Diffuse Convolution with (top 10% nodes)

(2)Experimental Setup

①Dimension:

| 0-th layer | 1-th layer | |

| VGAE | 64×200 | 200×64 |

| GCN-feature extractor | 64×200 | 64×64 |

②MLP dimension: 512→1024→2

③Loss coefficients:

④Epoch: 500 with patience of 100

⑤Learning rate:0.001, halving in every 20 epochs

⑥Weight decay:0.0005

⑦Batch size: 100(好难得见到不是2的倍数的)

⑧Epoch of unsupervised edge predictor: 100 with learning rate 0.0005

2.5.3. Results

①Comparison table:

2.6. Conclusion

They proposed a novel framework BrainVGAE

3. 知识补充

3.1. Margin Sampling

(1)定义:

Margin Sampling(边界采样)是一种主动学习策略,主要用于选择模型分类边界附近的样本进行标记。这些样本对于模型来说更具挑战性,因为它们位于不同类别之间的边界区域,模型对这些样本的分类往往具有较高的不确定性。通过选择这些样本进行标记并加入训练集,可以帮助模型更好地学习分类边界,从而提高模型的分类性能。

具体来说,Margin Sampling通常通过计算模型对每个未标记样本的预测概率或得分来实现。然后,选择那些预测概率或得分最接近模型分类阈值(通常是0.5)的样本,这些样本就是位于分类边界附近的样本。将它们标记并加入训练集后,模型可以通过学习这些样本的特征来更好地确定分类边界。

在实际应用中,Margin Sampling可以与其他主动学习策略结合使用,以实现更高效的样本选择。例如,可以先使用不确定性采样策略选择一批具有高不确定性的样本,然后在这些样本中进一步使用Margin Sampling来选择位于分类边界附近的样本进行标记。这样可以确保选择的样本既具有代表性又具有挑战性,从而提高模型的训练效果。

需要注意的是,Margin Sampling的效果受到模型性能和数据分布的影响。如果模型本身性能较差或数据分布不均匀,可能会导致选择的样本不具有代表性或过于集中在某些特定区域。因此,在使用Margin Sampling时,需要结合实际情况进行调整和优化,以确保其有效性。

(2)公式:

3.2. Top-k sparsification

Top-K稀疏化(Top-K sparsification)是一种优化技术,旨在从大量数据中选择最重要的K个元素或特征,同时忽略其他不重要的元素。这种方法在多个领域中都有应用,特别是在机器学习和数据科学中,用于减少数据的维度和复杂性,同时保持数据的主要信息。

在Top-K稀疏化中,“K”表示选择的元素数量,这些元素通常是基于其重要性或权重进行选择的。重要性的度量可以根据不同的算法和应用场景来定义,比如基于权重、频率、相关性或其他度量标准。

稀疏化后的数据具有几个优点。首先,它减少了计算和存储的需求,因为处理的数据量减少了。其次,它可能有助于减轻过拟合问题,因为通过减少特征数量,模型可以更专注于最重要的信息。最后,稀疏化还可以提高模型的解释性,因为更容易理解和解释少量的重要特征。

然而,Top-K稀疏化也可能带来一些挑战。例如,如何确定最佳的K值是一个重要的问题,这通常需要通过实验或交叉验证来确定。此外,稀疏化可能会丢失一些有用的信息,特别是当K值设置得过小时。

在联邦学习(Federated Learning)的上下文中,Top-K稀疏化可能用于减少通信开销或提高模型训练的效率。例如,通过仅传输最重要的更新或梯度,可以减少在分布式系统中的通信成本。同时,稀疏化也有助于减轻节点之间的异构性问题,因为每个节点可以专注于其最具代表性的数据部分。

3.3. Graph Diffuse Convolution

参考学习:图扩散卷积:Graph_Diffusion_Convolution-CSDN博客

论文:[1911.05485] 扩散改进了图形学习 (arxiv.org)

4. Reference List

Mai, Q., Nakarmi, U. & Huang, M. (2022) 'BrainVGAE: End-to-End Graph Neural Networks for Noisy fMRI Dataset', 2022 IEEE International Conference on Bioinformatics and Biomedicine (BIBM). doi: 10.1109/BIBM55620.2022.9994963