近日,在Memcon 2024大会上,三星推出了一款名为CXL Memory Module-Hybrid for Tiered Memory(CMM-H TM),这款扩展卡配备了高速DRAM和NAND闪存,允许CPU和加速器远程访问额外的RAM和闪存资源。

那么,这个CMM-H TM到底是什么产品呢?本文我们进行简单解读分析,供各位存储粉丝参考哈!开始阅读本文内容前,建议先了解CXL相关背景,可以阅览:

扩展阅读:

-

CXL崛起:2024启航,2025年开启新时代

-

浅析CXL P2P DMA加速数据传输的原理

-

是谁?阻止CXL在AI场景大展身手~

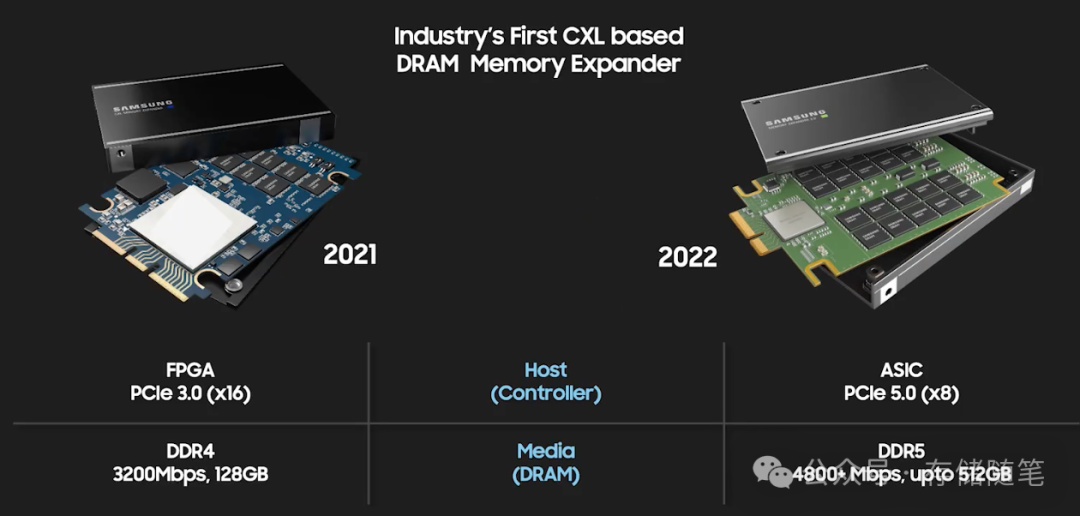

三星在2021年5月推出了行业内首款CXL DRAM产品——CMM-D(CXL Memory Module DRAM),这款产品支持CXL 2.0标准,配备128GB CXL DRAM,利用PCIe 5.0接口,实现了高达35GB每秒的显著带宽。一年后,也就是2022年5月,三星又发布了下一代产品CMM-D 2.0,率先推出512GB的内存模块,且具备更高的带宽和更低的延迟。

随着AI领域尤其是像GPT这样的大型语言模型的快速发展,对内存容量的需求急剧扩大。然而,简单增加内存容量并不能有效解决问题,因为内存性能并不随容量线性提升。现有的内存模块难以匹配处理器和加速器不断提升的速度,导致频繁的数据迁移,消耗大量电能并增加总拥有成本(TCO)。这个问题的核心在于现代数据中心传统的以处理器为中心的架构配置无法兼顾低系统性能、高TCO以及带宽、延迟、容量和高功耗等方面的挑战。

通过CXL技术缩短了存储与计算资源的距离,实现了更紧密的耦合,使存储资源仿佛就在CPU旁边一样,几乎消除了内存层级之间的延迟。这一特性为降低固态硬盘(SSDs)的成本创造了机会,因为在“近内存”架构下,可以采用成本较低的存储介质,同时依然保证较高的性能水平,通过更好的资源搭配和层级设计,达到性价比最优的存储解决方案。

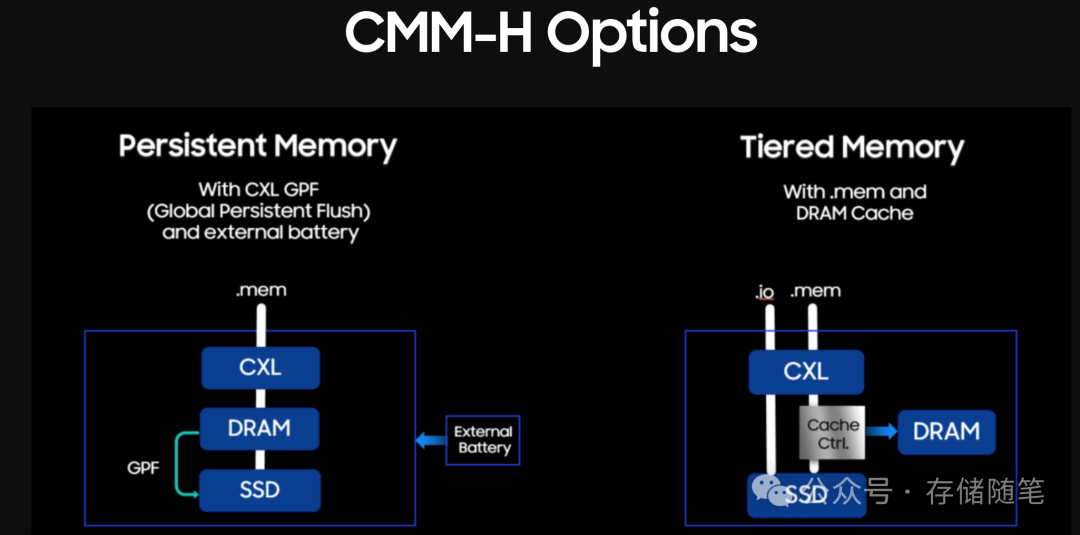

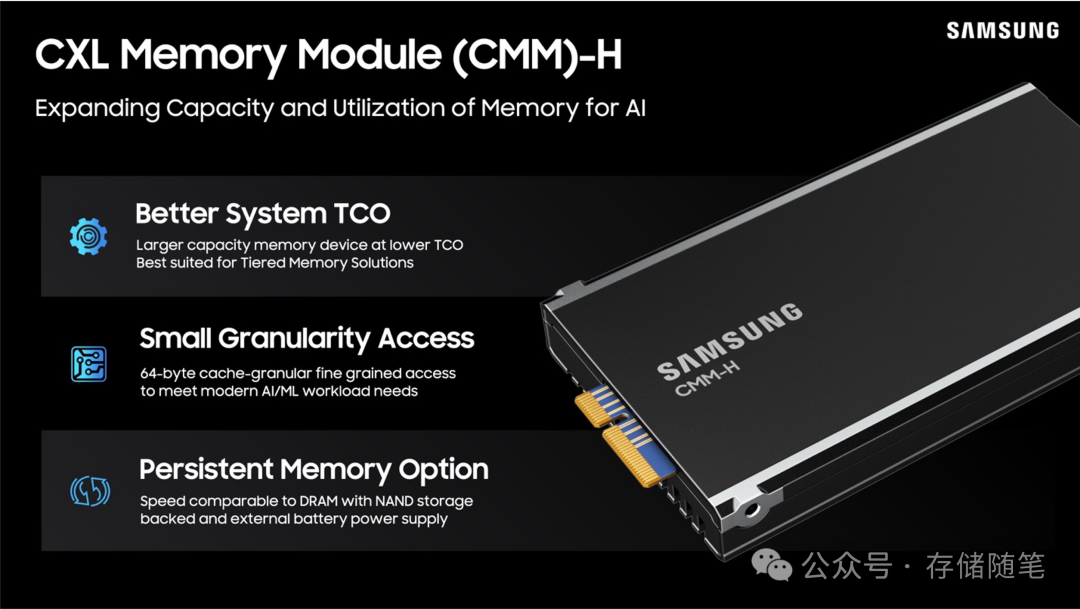

在资源过载的服务器环境中,由于物理空间或成本限制,往往无法轻易增加DDR5内存。CMM-H TM的主要目的是提供一种经济高效的途径,以增强服务器的内存容量,而无需依赖本地安装的DDR5内存。CMM-H作为一种面向分层内存系统的下一代内存解决方案,集成了DRAM与NAND闪存,并通过基于PCIe Gen 5.0接口的CXL接口提供经济有效的内存扩展。

CMM-H TM是CMM-H CXL内存解决方案的一个分支。三星声称这是世界上首款基于FPGA的分层CXL内存解决方案,旨在解决内存管理难题,减少停机时间,优化分层内存调度,最大化性能,同时大幅度降低总体拥有成本(TCO)。

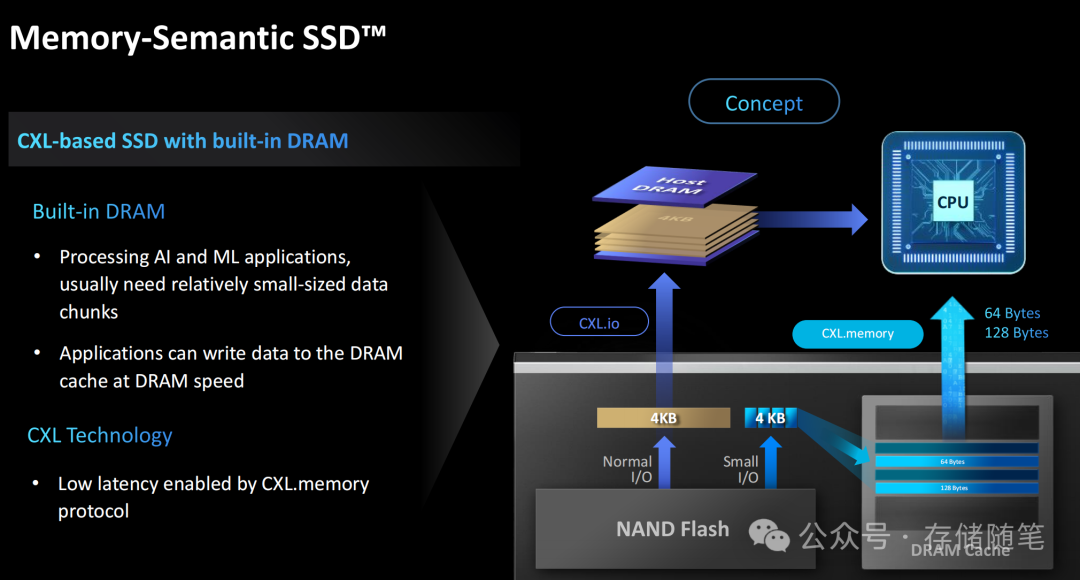

另外补充下,其实这个CMM-H就是之前三星Memory-Semantic SSD产品修改命名后的产品,也就是跟之前推出的MS SSD是一个东西!

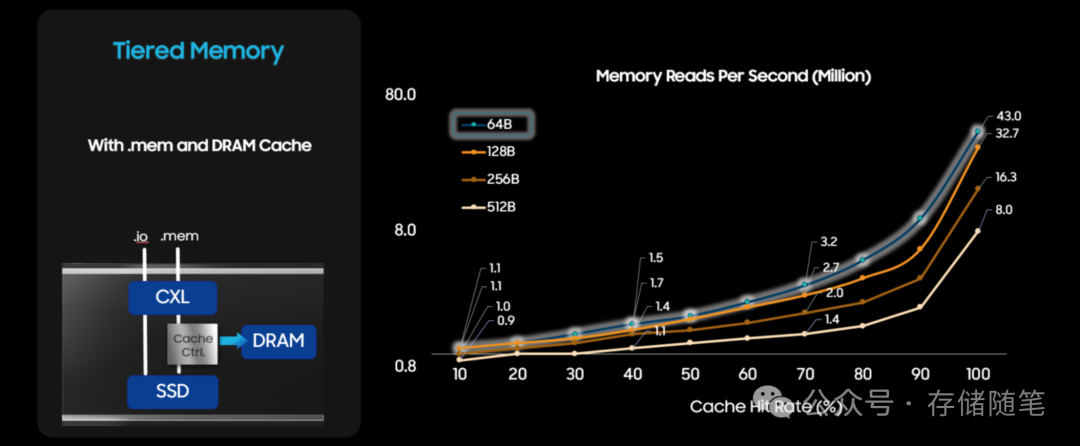

新款CMM-H虽然不如DRAM那样快速,但它通过闪存增加了大量的容量,并通过扩展卡内置的智能内存缓存功能隐藏了大部分延迟。热门数据会被自动移动到卡片上的DRAM芯片中以加快访问速度,而较少使用的数据则存储在NAND存储中。对于缓存数据会引入一定延迟,这对于依赖严格性能延迟的应用场景并非理想选择,特别是那些大型语言模型等高度依赖内存资源的应用。

CMM-H关键要素是其内置的DRAM缓存,旨在缓解与NAND闪存相关的长延迟问题。如同现代数据处理系统中每个处理器都有自己的缓存来存储常用数据以提高速度一样,CMM-H内置的DRAM缓存能够高效缓存常用数据,实现与主机DRAM相似的性能,在100%缓存命中率下提供高速响应。CMM-H通过采用64字节的缓存粒度访问方式,利用革命性的CXL.mem协议进一步凸显优势,这对于AI应用程序来说是一项重大革新。

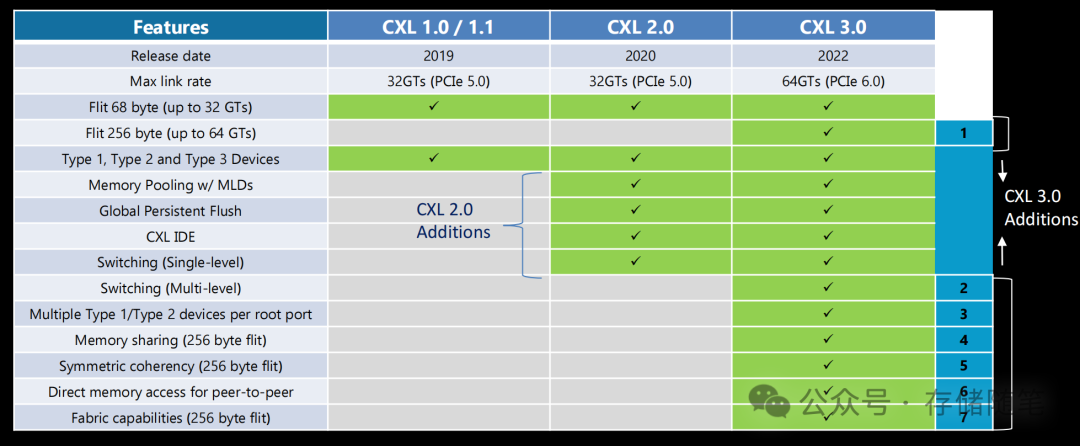

不同于传统的NVMe设备需要进行数据交换,将数据在SSD与主机DRAM之间来回移动,CMM-H能够直接访问数据,提高数据处理效率,通过提供更高效的I/O栈降低了延迟,并通过更小的数据访问粒度增加了有效带宽。这得益于CXL技术(CXL.mem)提供的缓存一致性(这个需要支持CXL 3.0)。过去,缓存一致性仅限于主内存或处理器主内存缓存之间,而现在CXL设备也支持缓存一致性,确保所有共享同一内存空间的处理器都能看到最新版本的数据。

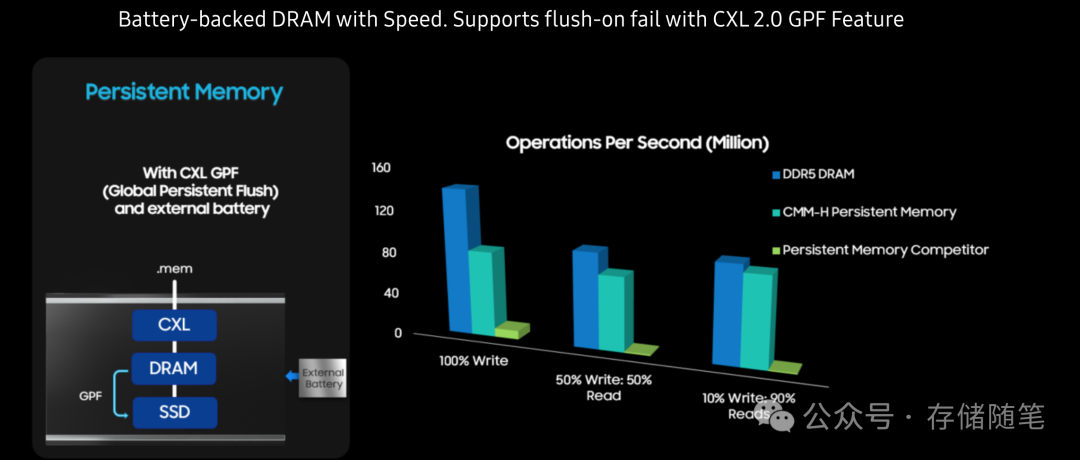

另外,CMM-H的多功能性值得一提。它不仅可作为满足分层内存系统需求的内存扩展设备,还可作为持久性内存(PMem)设备服务于持久性存储需求。通过将数据转储至NAND闪存实现持久性特性,并且CMM-H支持CXL 2.0 GPF(全局故障保护)下的故障时刷新功能。

CXL协议允许服务器系统跨越多个设备进行内存池化和内存扩展,从而实现更大范围内的内存资源统一管理和高效利用。CMM-H TM插卡通过整合DRAM和NAND闪存,不仅扩展了内存总量,而且利用了不同类型的存储介质的优势。DRAM提供快速、低延迟的随机访问,而NAND闪存则提供大容量、非易失性存储,适合用于长期存储或热数据缓存。

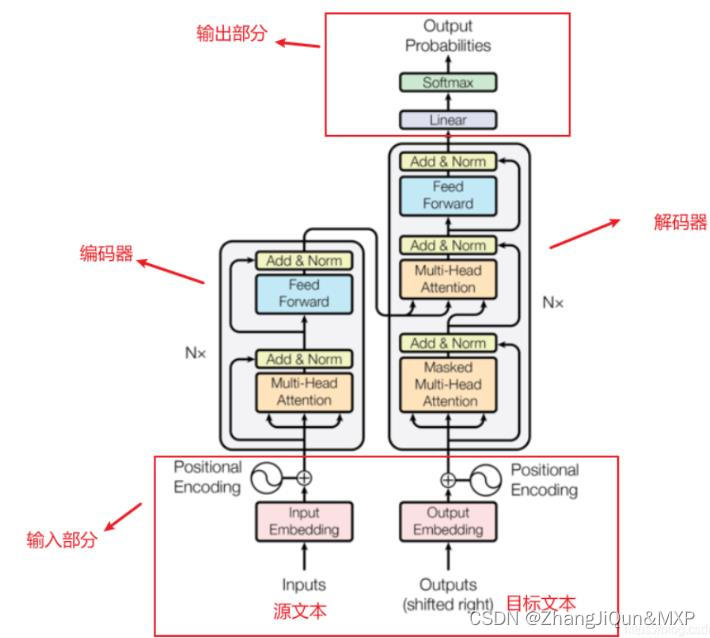

CXL规范支持三种类型的设备:Type 1设备是没有本地内存的加速器,Type 2设备是有自己内存的加速器(如GPU、FPGA和带有DDR或HBM内存的ASIC),而Type 3设备则由内存设备组成。三星的这款设备属于Type 3类别。

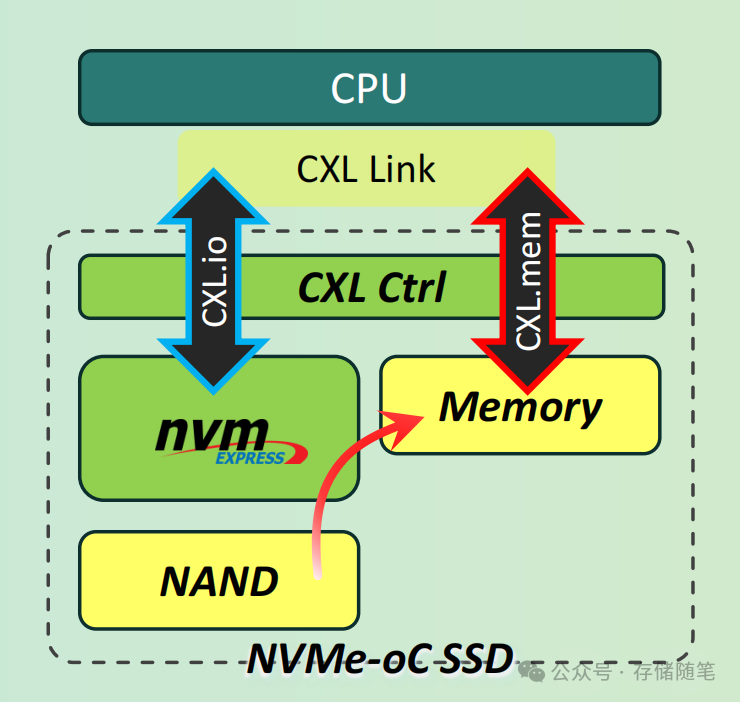

此外,之前有一家做SCM(存储级内存)ASIC控制器的厂商Wolly提出过一种NVMe over CXL (NVMe-oC)的架构,核心概念是利用CXL(Compute Express Link)接口优化主机与设备之间的数据移动。这个跟三星的CMM-H TM类似。

在NVMe-oC中,设备使用CXL.io来访问NVMe SSD,并使用CXL.mem来访问主机数据内存(HDM)。CXL HDM的主要优势在于它可以实现高速、可缓存的数据读写,这是在传统的Controller Memory Buffer (CMB)中无法达到的。

扩展阅读:

-

NVMe over CXL技术如何加速Host与SSD数据传输?

除了CMM-H,三星还介绍了诸如内存内处理(PIM)和临近内存处理(PNM)等技术,并开发出HBM-PIM和CXL-PNM作为概念验证,将数据传输和处理更紧密地靠近内存,以避免在处理大型AI模型时DRAM成为瓶颈。

此外,三星还在开发多款CXL方案,比如CXL DRAM (CMM-D)、CXL-PNM (CMM-DC)、内存语义SSD (CMM-H) 以及Smart SSD + CXL接口(I/F)计算(CMM-HC)均为CXL内存扩展和计算解决方案,这些都是三星内存实验室预测的产品。

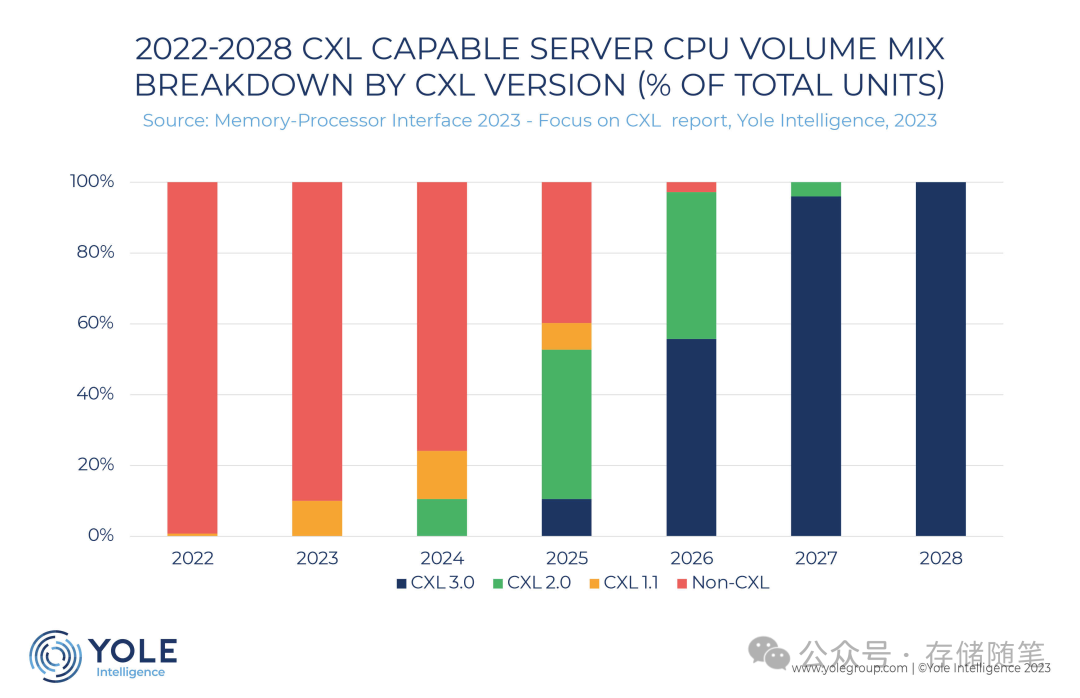

从2019年的CXL 1.0,CXL协议目前已经发展了CXL 3.0。

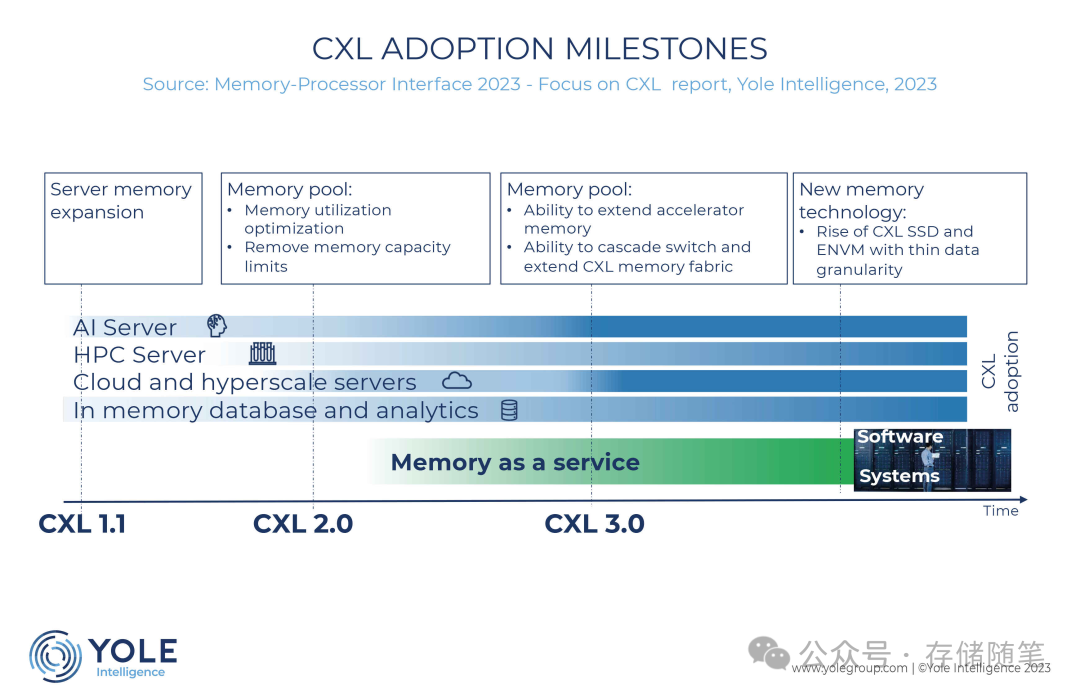

根据Yole机构分析数据显示,CXL在2024年开始爬坡,在2025年将会大规模上量,也就是代表着CXL的时代从2025年开始正式到来,2026年迎来大爆发!

服务器目前正面临着内存性能挑战,而CXL部署提供了短期和长期的解决方案。从CXL 1.1开始,AI云服务器可以从内存扩展中受益,而CXL 3.0有可能为GPU、DPU、FPGA和ASIC等加速器提供直接访问内存池的权限。预计云服务提供商和超大规模企业将对由CXL 2.0发起的内存池和可组合服务器表现出浓厚的兴趣。同时,数据库服务器将利用运行更大的内存数据库以加快分析速度的能力。

如果您看完有所受益,欢迎点击文章底部左下角“关注”并点击“分享”、“在看”,非常感谢!

精彩推荐:

-

PCIe 7.0|不要太卷,劝你先躺平

-

3D DRAM虽困难重重,最快明年到来

-

字节跳动入局存储内存SCM

-

解读“CFMS中国闪存市场峰会”存储技术看点

-

首个业内DNA存储技术规范发布

-

如何突破SSD容量提升的瓶颈?

-

固态存储是未来|浅析SSD架构的演进与创新技术

-

论文解读:NAND闪存中读电压和LDPC纠错码的高效设计

-

华为新发布磁电存储“王炸”,到底是什么?

-

SSD LDPC软错误探测方案解读

-

关于SSD LDPC纠错能力的基础探究

-

存储系统如何规避数据静默错误?

-

PCIe P2P DMA全景解读

-

深度解读NVMe计算存储协议

-

对于超低延迟SSD,IO调度器已经过时了吗?

-

浅析CXL P2P DMA加速数据传输的原理

-

NVMe over CXL技术如何加速Host与SSD数据传输?

-

浅析LDPC软解码对SSD延迟的影响

-

为什么QLC NAND才是ZNS SSD最大的赢家?

-

SSD在AI发展中的关键作用:从高速缓存到数据湖

-

浅析不同NAND架构的差异与影响

-

SSD基础架构与NAND IO并发问题探讨

-

字节跳动ZNS SSD应用案例解析

-

CXL崛起:2024启航,2025年开启新时代

-

NVMe SSD:ZNS与FDP对决,你选谁?

-

浅析PCI配置空间

-

浅析PCIe系统性能

-

存储随笔《NVMe专题》大合集及PDF版正式发布!

如果您也想针对存储行业分享自己的想法和经验,诚挚欢迎您的大作。

投稿邮箱:Memory_logger@163.com (投稿就有惊喜哦~)

《存储随笔》自媒体矩阵

更多存储随笔科普视频讲解,请移步B站账号:

如您有任何的建议与指正,敬请在文章底部留言,感谢您不吝指教!如有相关合作意向,请后台私信,小编会尽快给您取得联系,谢谢!