为什么需要任务编排?

想象一下这个场景:用户要求 Agent 完成一篇市场调研报告。这个任务需要:

- 收集市场数据

- 分析竞争对手

- 生成图表

- 撰写报告

这就是一个典型的需要任务编排的场景。

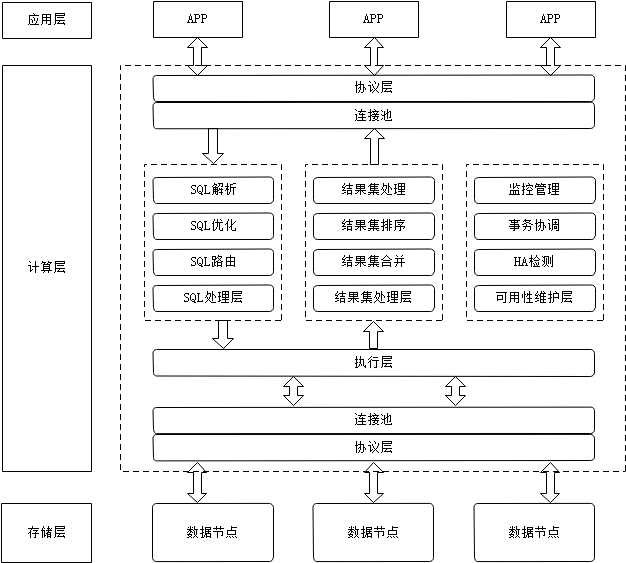

核心架构设计

1. 任务分解策略

使用 LLM 进行智能任务分解:

from typing import List, Dict

import asyncioclass TaskDecomposer:def __init__(self, llm_service):self.llm = llm_serviceasync def decompose_task(self, task_description: str) -> Dict:"""智能任务分解"""prompt = f"""任务描述:{task_description}请将该任务分解为子任务,输出格式:{{"subtasks": [{{"id": "task_1","name": "子任务名称","description": "详细描述","dependencies": [],"estimated_time": "预计耗时(分钟)"}}]}}要求:1. 子任务粒度适中2. 明确任务依赖关系3. 便于并行处理"""response = await self.llm.generate(prompt)return self._validate_and_process(response)def _validate_and_process(self, decomposition_result: dict) -> dict:"""验证和处理分解结果"""# 验证任务依赖关系是否合法self._check_circular_dependencies(decomposition_result["subtasks"])# 构建任务执行图return self._build_execution_graph(decomposition_result["subtasks"])

2. 并行处理架构

使用异步任务池管理并行执行:

class TaskExecutor:def __init__(self, max_workers: int = 5):self.max_workers = max_workersself.task_queue = asyncio.Queue()self.results = {}self.semaphore = asyncio.Semaphore(max_workers)async def execute_tasks(self, task_graph: Dict):"""执行任务图"""# 创建工作者池workers = [self._worker(f"worker_{i}") for i in range(self.max_workers)]# 添加可执行的任务到队列ready_tasks = self._get_ready_tasks(task_graph)for task in ready_tasks:await self.task_queue.put(task)# 等待所有任务完成await asyncio.gather(*workers)async def _worker(self, worker_id: str):"""工作者协程"""while True:try:async with self.semaphore:task = await self.task_queue.get()if task is None:break# 执行任务result = await self._execute_single_task(task)self.results[task["id"]] = result# 检查并添加新的可执行任务new_ready_tasks = self._get_ready_tasks(task_graph)for new_task in new_ready_tasks:await self.task_queue.put(new_task)except Exception as e:logger.error(f"Worker {worker_id} error: {str(e)}")

3. 中间结果管理

使用 Redis 存储中间结果:

class ResultManager:def __init__(self):self.redis_client = redis.Redis()async def save_result(self, task_id: str, result: Any):"""保存任务结果"""key = f"task_result:{task_id}"try:# 序列化结果serialized_result = self._serialize_result(result)# 存储到Redis,设置24小时过期await self.redis_client.set(key, serialized_result,ex=86400)except Exception as e:logger.error(f"Failed to save result for task {task_id}: {e}")raiseasync def get_result(self, task_id: str) -> Any:"""获取任务结果"""key = f"task_result:{task_id}"result = await self.redis_client.get(key)if result is None:raise KeyError(f"No result found for task {task_id}")return self._deserialize_result(result)def _serialize_result(self, result: Any) -> bytes:"""序列化结果"""if isinstance(result, (dict, list)):return json.dumps(result).encode()elif isinstance(result, bytes):return resultelse:return pickle.dumps(result)

4. 任务编排模式

实现不同的任务编排模式:

class TaskOrchestrator:def __init__(self):self.decomposer = TaskDecomposer()self.executor = TaskExecutor()self.result_manager = ResultManager()async def execute_pipeline(self, tasks: List[Dict]):"""流水线模式执行"""for task in tasks:result = await self.executor.execute_single_task(task)await self.result_manager.save_result(task["id"], result)async def execute_parallel(self, tasks: List[Dict]):"""并行模式执行"""results = await asyncio.gather(*[self.executor.execute_single_task(task)for task in tasks])for task, result in zip(tasks, results):await self.result_manager.save_result(task["id"], result)async def execute_dag(self, task_graph: Dict):"""DAG模式执行"""return await self.executor.execute_tasks(task_graph)

5. 性能优化技巧

class PerformanceOptimizer:def __init__(self):self.cache = LRUCache(maxsize=1000)async def optimize_task(self, task: Dict) -> Dict:"""任务优化"""# 1. 资源评估required_resources = self._estimate_resources(task)# 2. 缓存检查if cached_result := self.cache.get(task["id"]):return cached_result# 3. 批处理优化if self._can_batch(task):task = self._batch_similar_tasks(task)# 4. 资源分配task["resources"] = self._allocate_resources(required_resources)return taskdef _estimate_resources(self, task: Dict) -> Dict:"""估算任务资源需求"""return {"cpu": self._estimate_cpu_usage(task),"memory": self._estimate_memory_usage(task),"io": self._estimate_io_usage(task)}def _can_batch(self, task: Dict) -> bool:"""判断任务是否可以批处理"""return (task["type"] in ["data_processing", "llm_inference"] andtask["size"] < self.batch_size_threshold)

实战案例:市场调研报告生成系统

class MarketResearchSystem:def __init__(self):self.orchestrator = TaskOrchestrator()self.optimizer = PerformanceOptimizer()async def generate_report(self, topic: str):# 1. 任务分解tasks = await self.orchestrator.decomposer.decompose_task(f"生成关于 {topic} 的市场调研报告")# 2. 任务优化optimized_tasks = await asyncio.gather(*[self.optimizer.optimize_task(task)for task in tasks["subtasks"]])# 3. 执行任务图results = await self.orchestrator.execute_dag({"tasks": optimized_tasks})# 4. 生成最终报告return await self._compile_report(results)async def _compile_report(self, results: Dict) -> str:"""编译最终报告"""sections = []for task_id, result in results.items():if task_id.startswith("data_collection"):sections.append(self._format_data_section(result))elif task_id.startswith("competitor_analysis"):sections.append(self._format_analysis_section(result))elif task_id.startswith("chart_generation"):sections.append(self._format_chart_section(result))return self._combine_sections(sections)

最佳实践

-

任务分解原则

- 保持任务粒度适中

- 明确定义依赖关系

- 考虑并行执行可能性

-

资源管理策略

- 动态调整并行度

- 实现任务优先级

- 合理分配计算资源

-

错误处理机制

- 实现任务重试

- 提供回滚机制

- 保存执行状态

-

监控和日志

- 记录详细执行日志

- 监控系统资源

- 追踪任务状态

常见问题和解决方案

-

任务依赖死锁

- 问题:循环依赖导致任务无法执行

- 解决:实现依赖检测和超时机制

-

资源竞争

- 问题:并行任务争抢资源

- 解决:实现资源池和调度算法

-

状态一致性

- 问题:分布式环境下状态不一致

- 解决:使用分布式锁和事务

总结

一个好的任务编排系统应该具备:

- 灵活的任务分解能力

- 高效的并行处理架构

- 可靠的中间结果管理

- 多样的任务编排模式

- 优秀的性能优化能力