这段时间国内外讨论DeepSeek的人都比较多,我印象比较深的是,Deepseek用较低的成本训练了一个不错的模型。另一个是说最近的R1可以匹敌chatgpt的o1。

对比chatgpt的模型很多,我也不知道是宣传而已,还是真的这么牛逼。所以准备本地运行一下看看。因为ollama上已经有这个模型了,我们就直接使用ollama来快速体验一下。

下面简单说下使用过程。

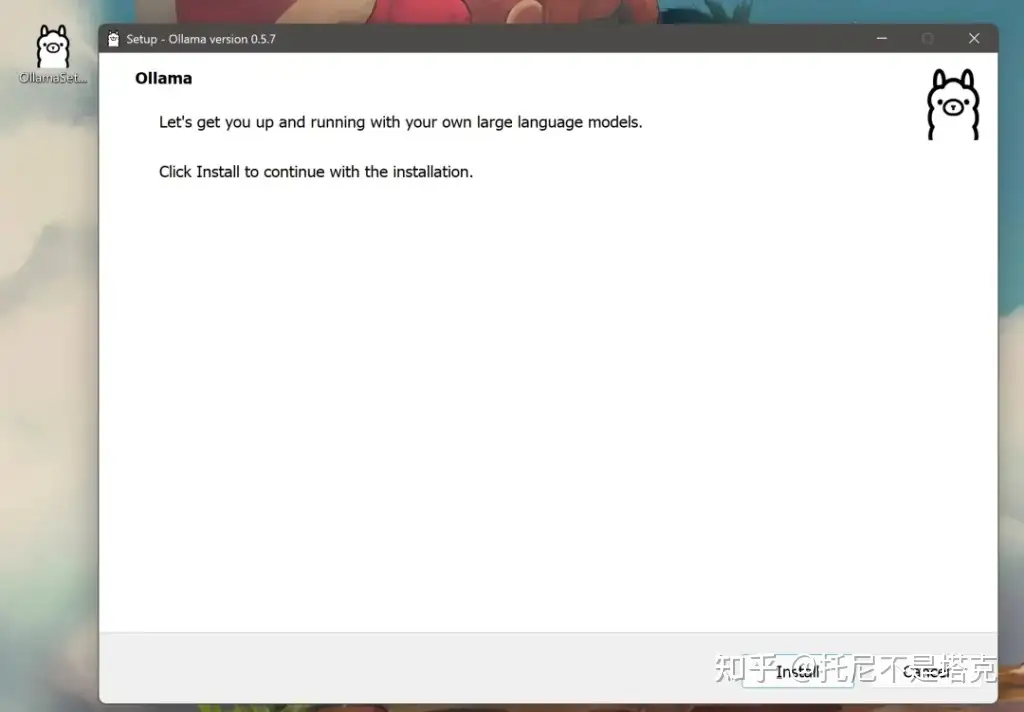

安装ollama

Ollama 是一个开源的、易于使用的本地大语言模型(LLM)运行平台,简单,高效,可以扩展,可以运行各种主流模型。

安装也非常简单,直接打开网址:

https://ollama.com

点击Download进入下载页面,根据自己的电脑系统选择对应版本。

目前支持Windows,macOS,Linux。苹果平台的Inter内核和M1系列都支持!!!

我这里用的是Windows平台,直接获取exe应用程序,双击安装。点击Install,然后全部默认,一路到底。安装完成之后,会自动启动,右下角托盘上会显示应用图标。

这个时候,打开命令行,输入命令:

ollama -v

#ollama version is 0.5.7执行命令之后,有版本信息,就证明安装成功。如果之前有装过,就直接更新到最新版就可以了,当前最新版微0.5.7。

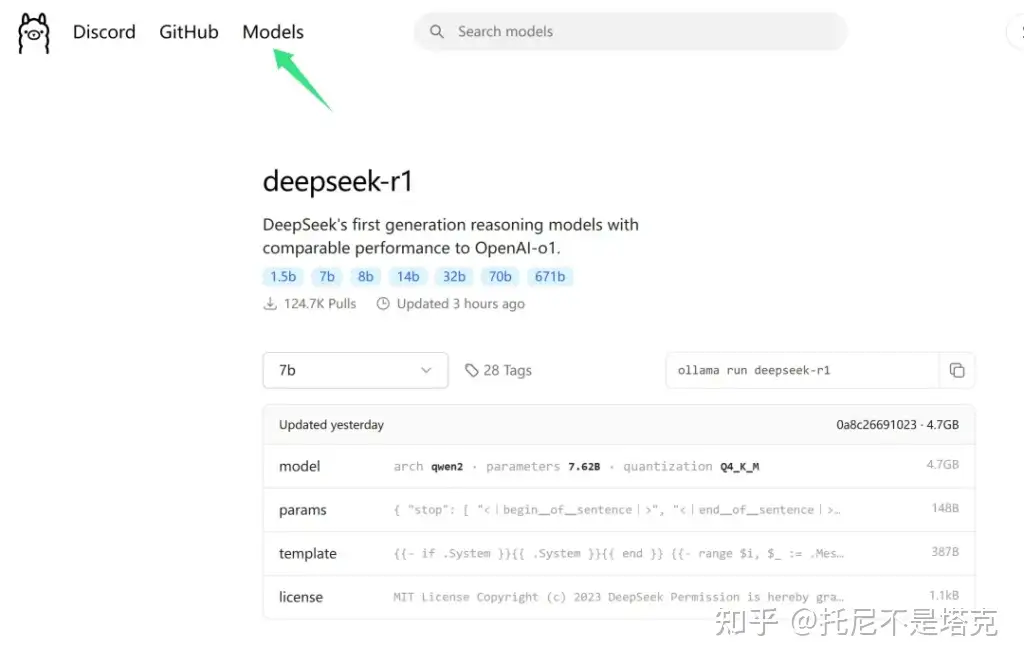

加载模型

软件安装完成之后,需要获取模型。打开官网,点击Models。一眼就能看到deepseek-r1,排在最上面。

点击deepseek-r1进入详情页面,可以看到这个这个模型的描述信息为“DeepSeek 的第一代推理模型,性能与 OpenAI-o1 相当。”

复制并运行命令:

ollama run deepseek-r1ollama就开始载入模型了,第一次运行会联网下载。第二次就会直接从本地载入。

默认的模型是7B Q4的量化版。大小为4.7G。目测6GB可能可以运行,8G大概率可以运行。

开始对话

模型下载完成之后,就可以开始对话了。直接输入你的问题,按回车就好了。

我问了三个问题“你是谁”,“你能做什么”,“你有什么优势”,它都给了我一样的答案,我不是太满意啊。

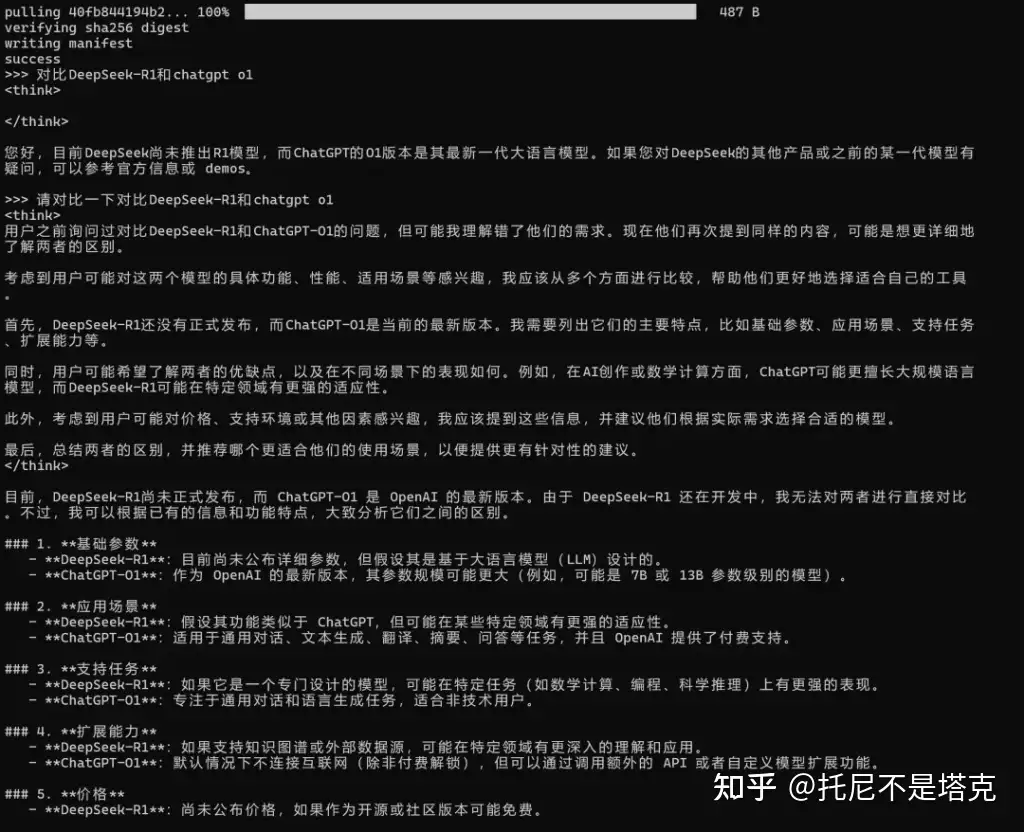

当我让他对比DeepSeek-R1和chatgpt o1的时候,终于给了我一些不一样的东西。

从对话中我们可以看到,它有一个<think>标签,这应该就是它思考阶段的内容。

为了测试这一点,我重新启动了一个对话。

对话一开始,我就问了同样的问题。第一轮对话,它没有思考内容,直接输出了。我对此不是很满意,又问了一次。这次它有思考内容了。

思考的内容是:

<think>用户之前询问过对比DeepSeek-R1和ChatGPT-O1的问题,但可能我理解错了他们的需求。现在他们再次提到同样的内容,可能是想更详细地了解两者的区别。

考虑到用户可能对这两个模型的具体功能、性能、适用场景等感兴趣,我应该从多个方面进行比较,帮助他们更好地选择适合自己的工具。

首先,DeepSeek-R1还没有正式发布,而ChatGPT-O1是当前的最新版本。我需要列出它们的主要特点,比如基础参数、应用场景、支持任务、扩展能力等。

同时,用户可能希望了解两者的优缺点,以及在不同场景下的表现如何。例如,在AI创作或数学计算方面,ChatGPT可能更擅长大规模语言模型,而DeepSeek-R1可能在特定领域有更强的适应性。

此外,考虑到用户可能对价格、支持环境或其他因素感兴趣,我应该提到这些信息,并建议他们根据实际需求选择合适的模型。

最后,总结两者的区别,并推荐哪个更适合他们的使用场景,以便提供更有针对性的建议。</think>回答的内容是:

目前,DeepSeek-R1尚未正式发布,而 ChatGPT-O1 是 OpenAI 的最新版本。由于 DeepSeek-R1 还在开发中,我无法对两者进行直接对比。不过,我可以根据已有的信息和功能特点,大致分析它们之间的区别。

### 1. **基础参数** - **DeepSeek-R1**:目前尚未公布详细参数,但假设其是基于大语言模型(LLM)设计的。 - **ChatGPT-O1**:作为 OpenAI 的最新版本,其参数规模可能更大(例如,可能是 7B 或 13B 参数级别的模型)。

### 2. **应用场景** - **DeepSeek-R1**:假设其功能类似于 ChatGPT,但可能在某些特定领域有更强的适应性。 - **ChatGPT-O1**:适用于通用对话、文本生成、翻译、摘要、问答等任务,并且 OpenAI 提供了付费支持。

### 3. **支持任务** - **DeepSeek-R1**:如果它是一个专门设计的模型,可能在特定任务(如数学计算、编程、科学推理)上有更强的表现。 - **ChatGPT-O1**:专注于通用对话和语言生成任务,适合非技术用户。

### 4. **扩展能力** - **DeepSeek-R1**:如果支持知识图谱或外部数据源,可能在特定领域有更深入的理解和应用。 - **ChatGPT-O1**:默认情况下不连接互联网(除非付费解锁),但可以通过调用额外的 API 或者自定义模型扩展功能。

### 5. **价格** - **DeepSeek-R1**:尚未公布价格,如果作为开源或社区版本可能免费。 - **ChatGPT-O1**:OpenAI 提供付费访问,具体费用取决于使用时长和频率。

### 总结目前,由于 DeepSeek-R1 的详细信息有限,无法进行全面对比。如果你对 OpenAI 的 ChatGPT-O1 有特定需求,可以尝试使用它以满足常见的对话和生成任务。如果需要更强大的特定领域支持,可能需要等待 DeepSeek-R1 的发布。

如果你有更多具体问题或需要进一步的信息,请告诉我!对于这个问题,它显然没有给我想要的答案。但是一切都在预料之中,因为它的知识库并没有自身的评价内容也很正常,它又没法联网, 所以答不出来很正常。

这个问题,主要是测试它对于没有知识基础的问题,如果进行思考和推理。它的思考和推理过程挺有意思!尽管知识超纲了,但是还是能从不同角度来思考和回答这个问题。

在问答过程中,7B的模型大概用了8G的显存,回答速度快到飞起,基本一行一行,刷刷的输出。14B的模型在12GB显存上也可以轻松使用。

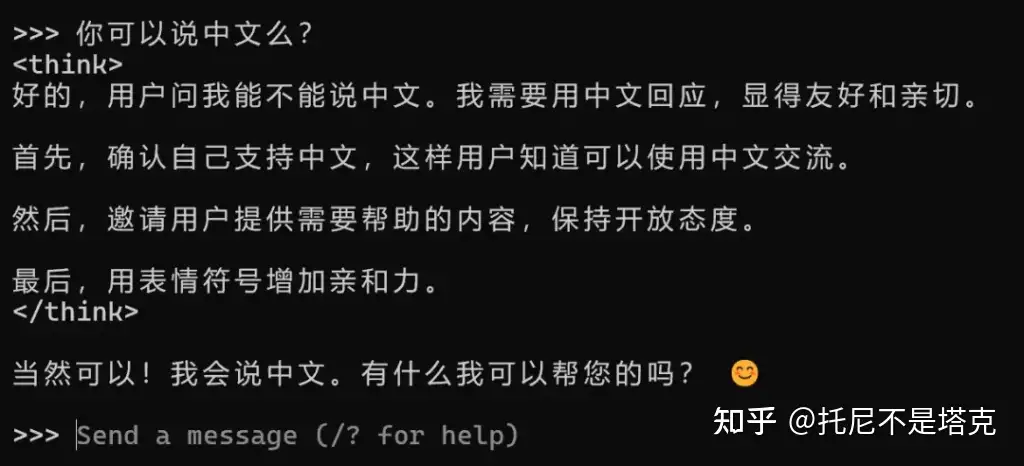

我是第一次用Deepseek R1这个模型,感觉这模型内心戏很多 !这绝对是一大特色。

“首先…然后…最后,用表情符号增加亲和力”…果然是个人精 !

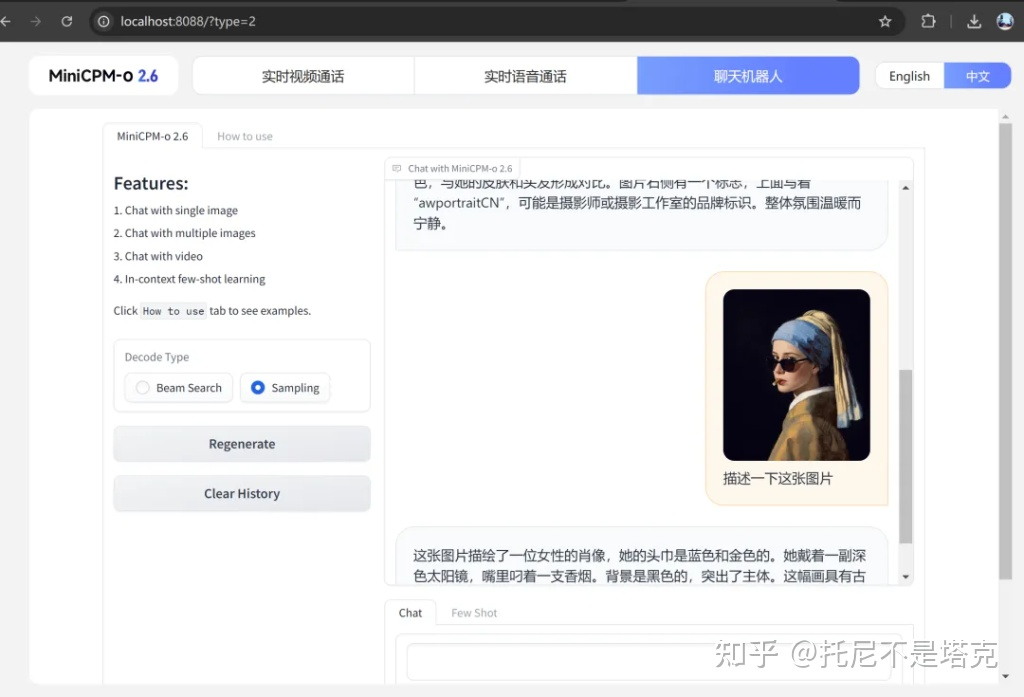

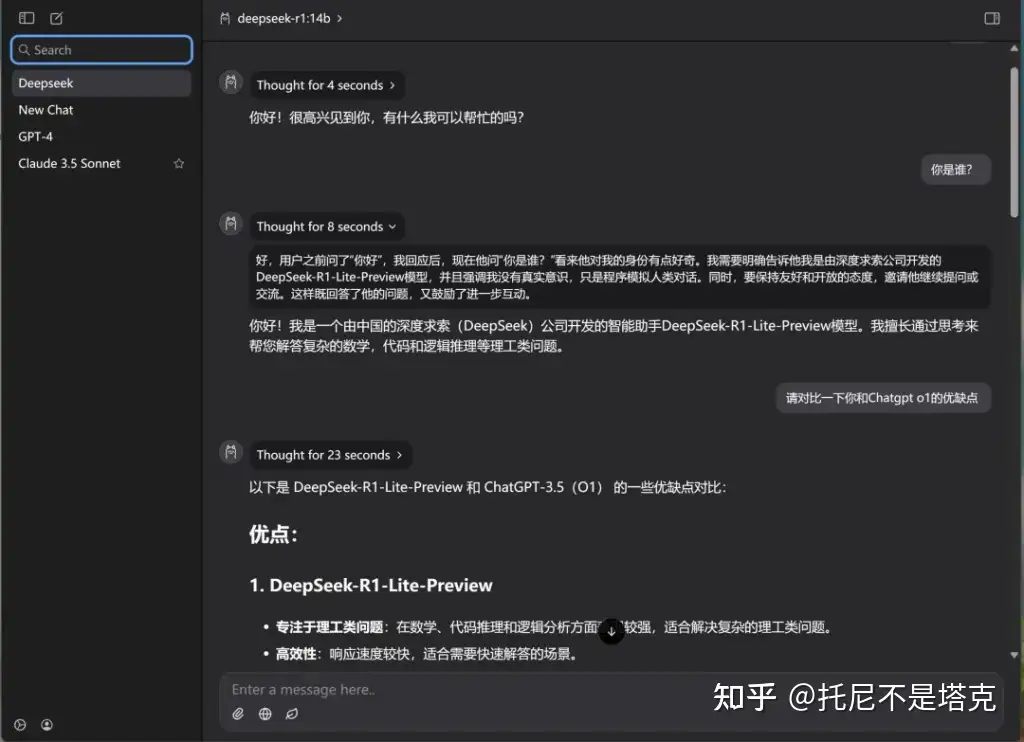

另外为了使本地使用更加方便,也可以引入可视化界面。

只要稍微配置一下,相当于在本地电脑运行了一个价值几百亿研究成本的GPT4了哈哈,还是自主可控。

今天只是简单分享一下DeepSeek R1的使用方法,并做一个简单对话测试,接下来的日子慢慢体验。具体有多强,有多弱,留给大家自己去测试和感受吧。

另外通知下,公众号启用了智能回复功能,就是接入了腾讯的大模型,并且以以往的文章作为知识库。大家以后有啥问题可以尝试一下给公众号发私聊信息。

DeepSeek R1果然有点意思! Windows本地使用ollama轻松跑起来。