你是否遇到过这样的情况:辛辛苦苦开发的 AI Agent 突然失灵了,却不知道是哪个环节出了问题?今天给家人们分享一下如何让 AI Agent 的运行过程透明化。

一、为什么要监控 AI Agent?

传统的对话系统就像一张预先画好的地图,用户只能按照既定路线前进。而 AI Agent 则像是一位灵活的向导,能够根据用户的需求实时规划路线。

但这种灵活性也带来了新的问题:

1、Agent 的决策过程变得难以追踪

2、性能问题无法快速定位

3、错误原因难以排查

用 AI Agent 而没有做好监控,就像蒙着眼睛开车一样危险。

二、一般要监控哪些内容?

在 AI Agent 的运行过程中,常见的一些关键指标如下:

1、决策链路

Agent 采取了哪些行动?

每个决策的依据是什么?

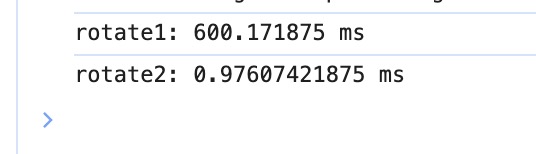

2、性能指标

响应延迟

资源消耗

调用成功率

3、输入输出

用户输入的具体内容

系统的响应结果

中间步骤的数据

三、实战:如何实现 Agent 监控?

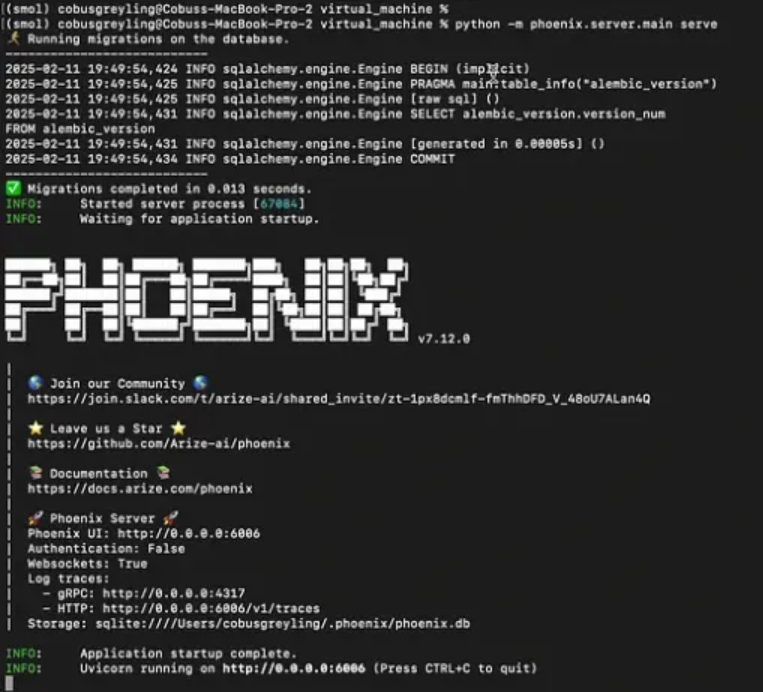

今天我们以 HuggingFace 的 SmolAgents 为例,介绍如何使用 OpenTelemetry 实现监控。

3.1 环境准备

首先安装必要的包:

pip install smolagents

pip install arize-phoenix opentelemetry-sdk opentelemetry-exporter-otlp openinference-instrumentation-smolagents

3.2 配置监控

添加以下代码来初始化监控:

from opentelemetry import trace

from opentelemetry.sdk.trace import TracerProvider

from opentelemetry.sdk.trace.export import BatchSpanProcessorfrom openinference.instrumentation.smolagents import SmolagentsInstrumentor

from opentelemetry.exporter.otlp.proto.http.trace_exporter import OTLPSpanExporterendpoint = "http://0.0.0.0:6006/v1/traces"

trace_provider = TracerProvider()

trace_provider.add_span_processor(SimpleSpanProcessor(OTLPSpanExporter(endpoint)))SmolagentsInstrumentor().instrument(tracer_provider=trace_provider)

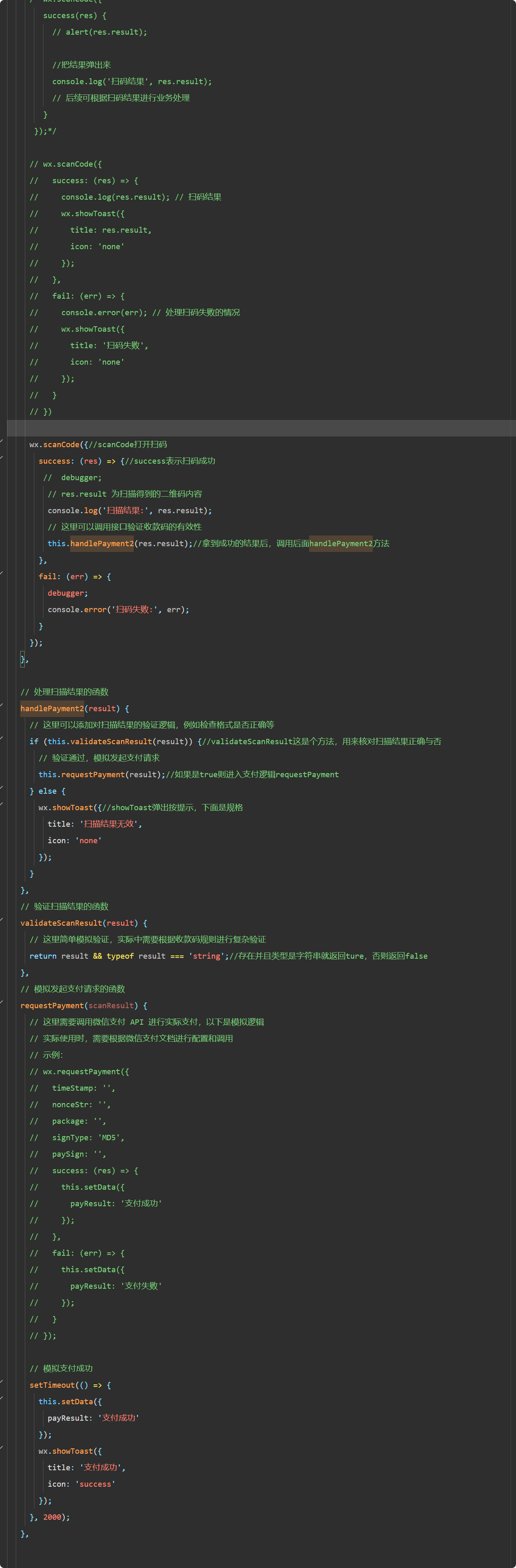

3.3 创建并运行 Agent

下面是一个简单的天气查询 Agent 示例:

from typing import Optional

from smolagents import TransformersModel, tool

from smolagents.agents import CodeAgent, ToolCallingAgentmodel = TransformersModel(model_id="HuggingFaceTB/SmolLM2-1.7B-Instruct", device_map="auto", max_new_tokens=1000)@tool

def get_weather(location: str, celsius: Optional[bool] = False) -> str:"""获取指定地点的天气信息"""return "当前天气晴朗,温度 20°C"agent = ToolCallingAgent(tools=[get_weather], model=model)

result = agent.run("北京今天天气怎么样?")

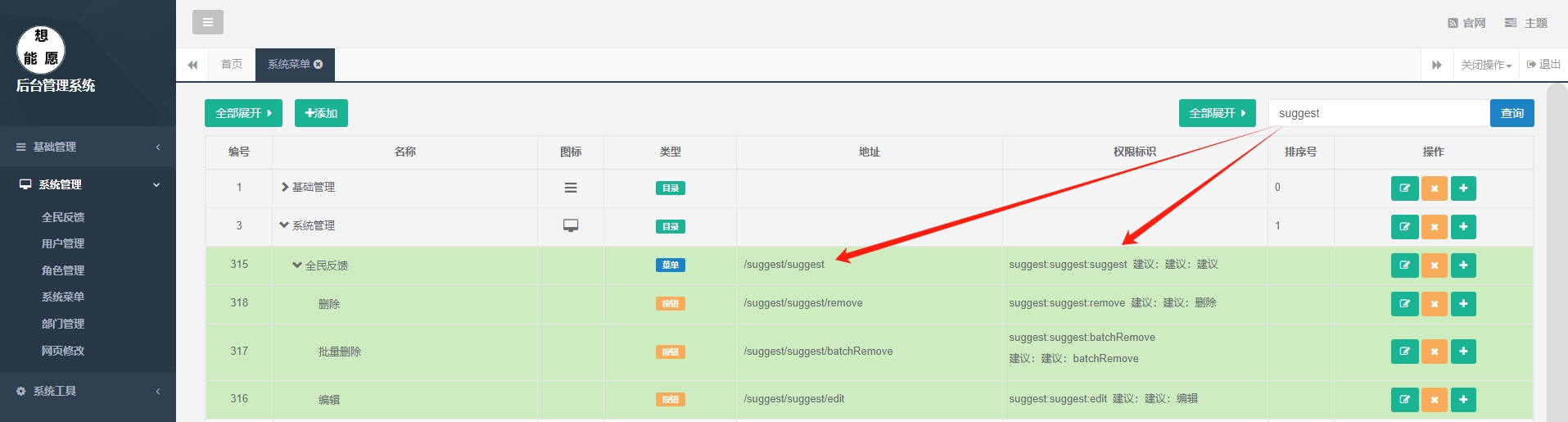

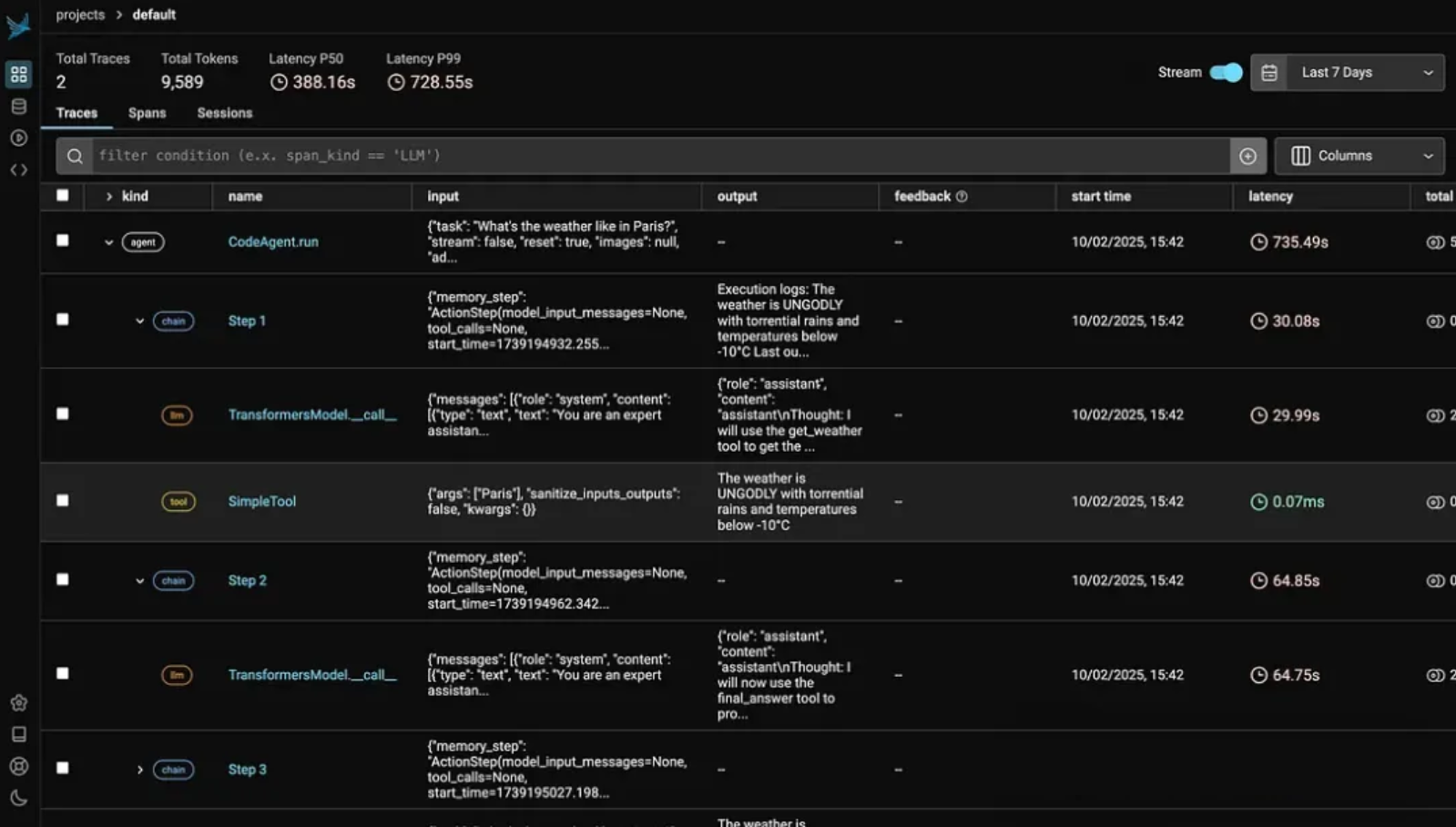

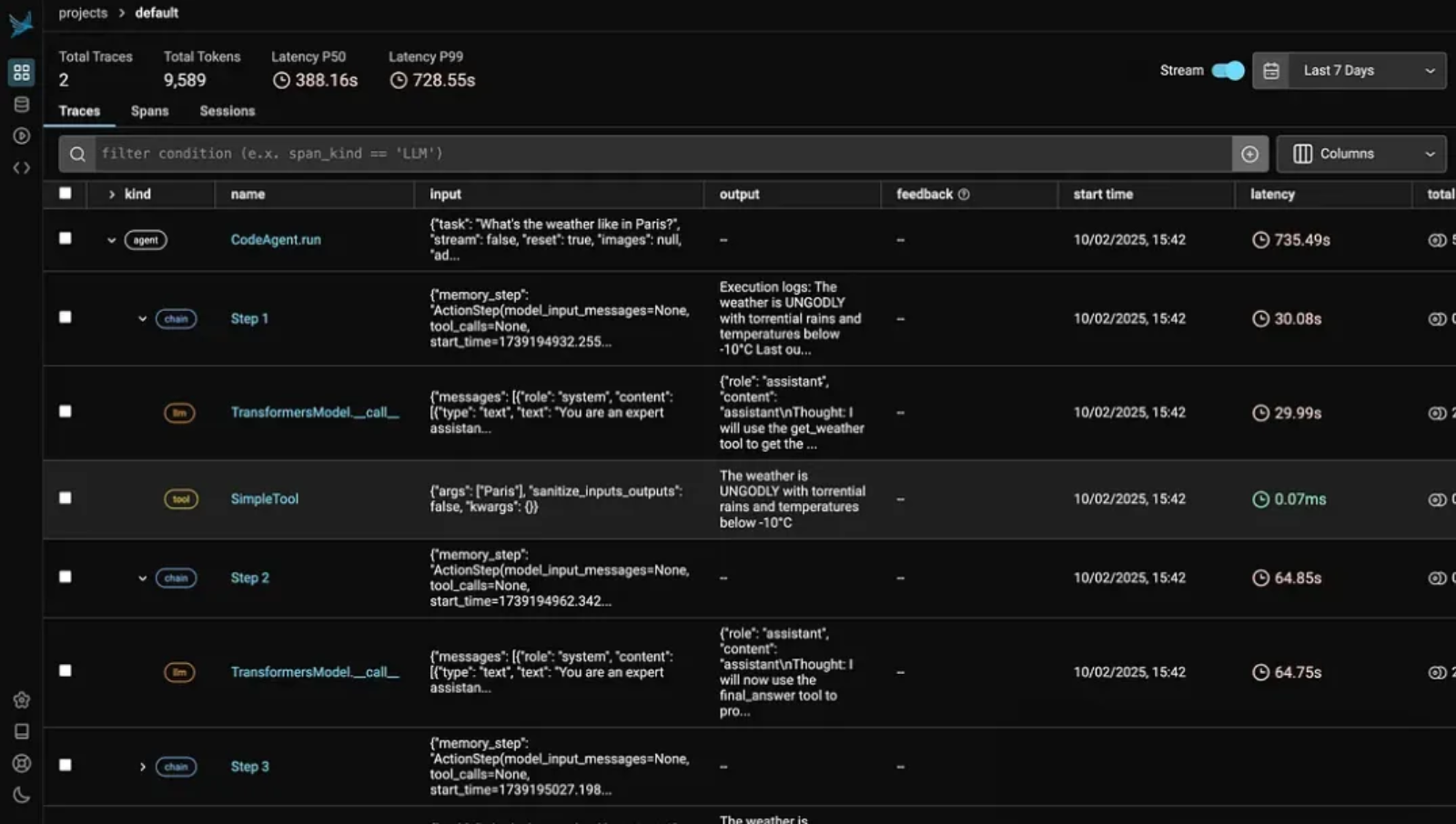

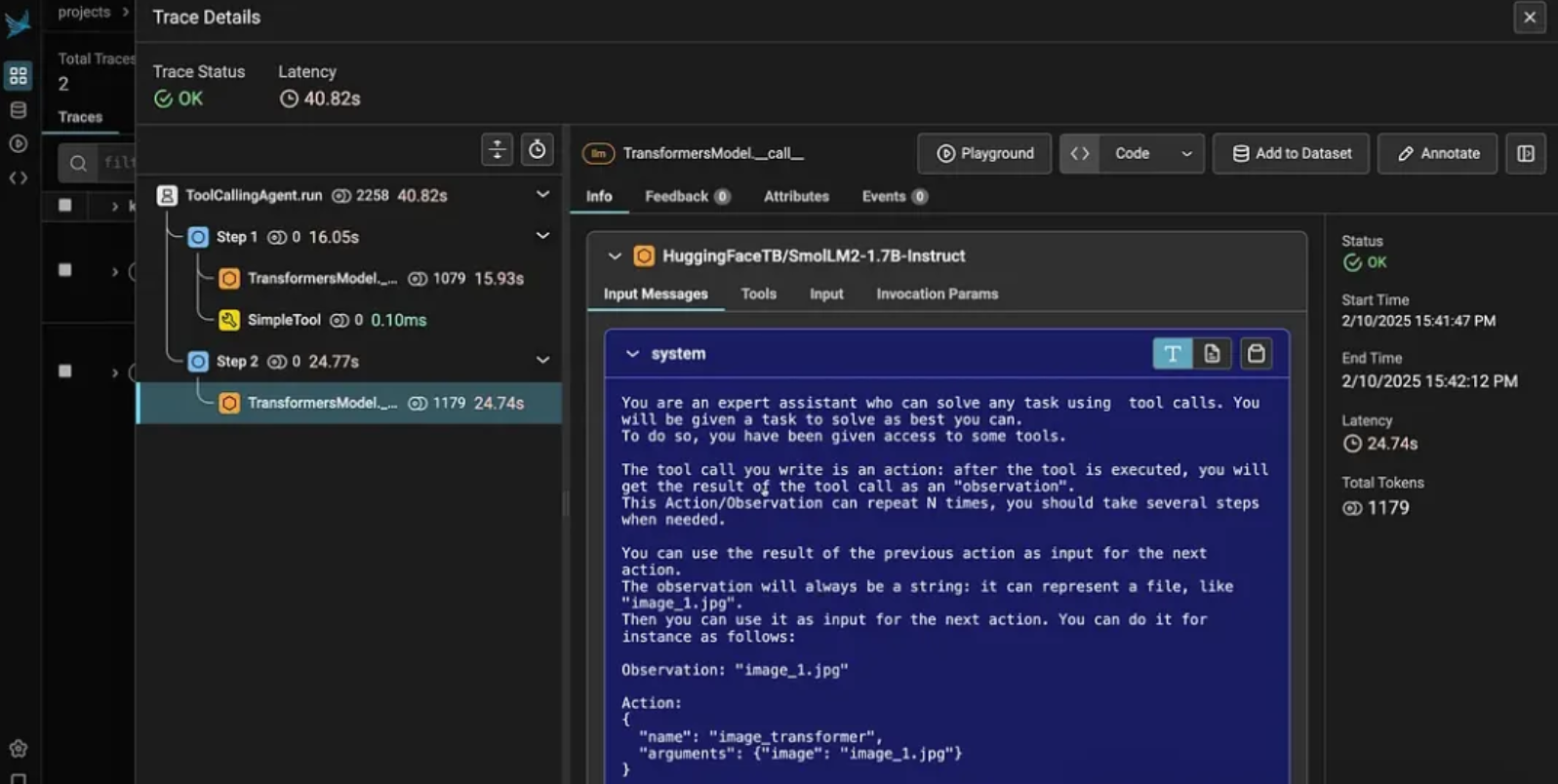

3.4 查看监控数据

运行后,我们可以在监控面板中看到:

1、Agent 的完整调用链路

2、每个步骤的耗时

3、输入输出详情

4、资源使用情况

可以深入每一次输入查看完整信息。

最后

在实际应用中,要把握好监控的"度"。

保持一个恰到好处的粒度,既要能及时发现问题,又不能让监控本身成为系统的负担。常见重点关注的几个关键指标:响应时间、错误率和资源使用情况。当这些指标出现异常时,比如响应明显变慢或错误突然增多,往往意味着系统出现了问题。

最后是设置合理的告警机制。当系统出现异常时,能够第一时间感知到。

原创 猕猴桃 探索AGI

![[2025.2.23] 周记](https://img2023.cnblogs.com/blog/3480200/202502/3480200-20250223170430858-229479209.png)