参考博客

第一代图卷积网络:图的频域网络与深度局部连接网络 - 知乎 (zhihu.com)

论文解读一代GCN《Spectral Networks and Locally Connected Networks on Graphs》 - 别关注我了,私信我吧 - 博客园 (cnblogs.com)

论文核心

卷积神经网络得益于所处理的数据具有局部平移不变性,在图像和音频任务当中极其高效。因此,本文考虑将其推广到更为一般且不具有平移不变性的数据领域。作者提出了两种构建方式:

(1)基于空域的层次聚类

(2)基于频域的图拉普拉斯

上述两种方式,在低维的图中,均可以学习到参数量与输入大小无关的卷积层。

平移不变性(Translation Invariance):在图像分类任务中,不变性意味着,当所需要识别的目标出现在图像的不同位置时,模型对其识别所得到的标签应该相同。即当输出进行变换后,还能得到相同的输出。

平移同(等)变性(Translation Equivariance):指在目标检测任务中,如果输入的图像中,对应的目标发生了平移,那么最终检测出的候选框也应发生相应的变化。即对输入进行变换后,输出也会发生相应的变换。

对于平移同变性而言,基本上是有卷积操作带来的:

卷积具有局部连接和参数共享的特性,当移动输入图像中的目标时,由于局部连接和参数共享的特点,对于移动后的目标,经过卷积操作后,也能得到同样的特征输出。

对于平移不变性而言,基于不同的情景下,分别考虑:

平移不变性由池化操作带来,但这个得基于具体的公式进行分析。当shift大小与pooling操作的步长相等时,可以做到平移相等性。同时,全局池化操作,也可以做到平移相等性。

引言

在规则的网格数据上,CNN能够有效减少参数的数量,其原因有:

(1) 平移结构利于滤波器的使用,进而实现权重共享

(2) 网格的度量结构,利于紧支集滤波器的使用,这类滤波器的支集通常远小于输入信号的规模

(3) 网格的多尺度二分聚类,使得下采样得以实现,(下采样)是通过步幅卷积和池化操作来完成的

但是在非规则数据结构上,由于缺少几何结构假设,很难直接运用卷积操作。因此,本文作者提出两种方法在非规则网格上的图上构建深度神经网络。

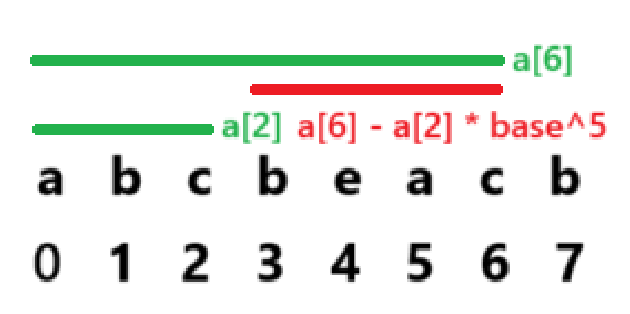

空域构建

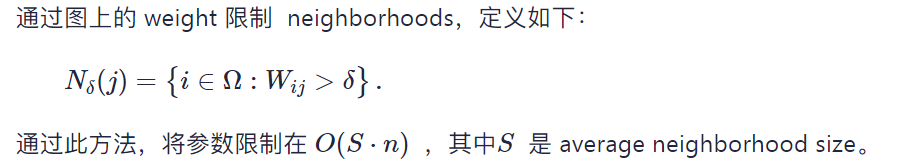

实质是通过加权图来替代网格数据: G=(Ω,W)

Ω是一个离散的节点集合,大小为 m , W 是一个对称半正定矩阵,大小为 m×m,也就是加权邻接矩阵。

后面,也就是将不同的节点坍缩为一个结点。

具体的过程如图。

这种架构的优点在于不需要很强的 regularity assumptions on the graph,只需要图具备低维邻域结构即可,甚至不需要很好的 global embedding。但是缺点在于没办法进行参数共享,对于每一层的每一个节点都要有单独的参数进行卷积而不能像CNN那样使用同一个卷积核在数据网格上进行平移。

谱构建

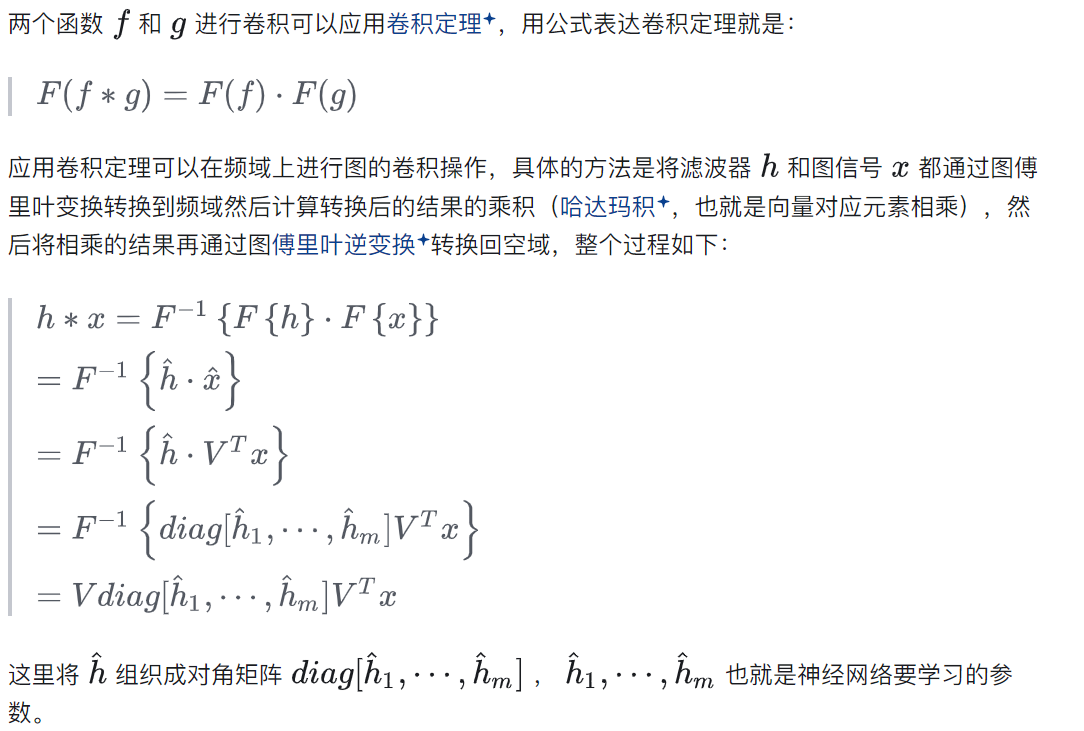

该方法的核心是通过图傅里叶变换将图信号从空域转换到频域,最后再将之使用图傅里叶逆变换转换回空域:

**群不变性(Group Invariance)**:若图结构在某种变换群(如平移、旋转)下保持不变,则称该图具有**群不变性**

进而,作者提出了类似上述空域操作中的构造方式:

在这里,对于拉普拉斯矩阵而言,只有前d个特征向量才有实际作用。因此,我们可以调整V为Vd,来近似于下采样。同时,对于d的调整,也能够使得参数复杂度近似于O(Ω)。

但是,作者在这里也提出了相关问题:

- 大部分的图是不规则的,缺乏群不变性

- 忽略了群体高频特征向量的潜在价值,对角化导致向量之间彼此独立,忽视其相关性

实验

实验的数据集主要是Subsampled MNIST和MNIST-sphere dataset