在自动驾驶系统中,感知技术是核心基础之一。感知技术为车辆提供环境信息,使其能够实现对周围环境的理解、分析与决策,从而保证安全性和高效性。通常大家对感知的介绍停留在“眼睛”的作用,但这样的解释太宽泛了例如感知到底是什么?由哪些模块组成?输入输出有什么含义?数据怎么流转的?会经历哪些硬件模块?下面来简单看一下。

现在大家不都是在提倡感知规控“端到端”吗?为什么还要拆开介绍?个人理解:完全端到端还有很长一段时间要走,了解感知模块,没什么坏处。

1.感知的定义

感知是指通过传感器获取环境信息并将其转化为可用数据的过程。在自动驾驶中,感知技术主要包括目标检测、识别、跟踪、分割、预测等。没有可靠的感知技术,下游规控很难进行决策,自动驾驶系统也很难实现安全驾驶。

2.感知硬件

感知系统通常由多种传感器和数据处理单元组成。常见的传感器包括:

- 激光雷达(LiDAR):通过激光扫描获取高精度的三维点云数据,能够准确测量物体的位置和形状。

- 摄像头:提供高分辨率的视觉信息,用于识别物体的颜色、形状以及交通标志等。

- 毫米波雷达:擅长检测动态物体,尤其适合在恶劣天气条件下工作。

- 超声波传感器:用于近距离障碍物检测,常用于泊车场景。

有了这些传感器,怎么把它们采集到的信息用起来呢?这就涉及到数据流转的计算单元了。常见的数据处理单元包括:

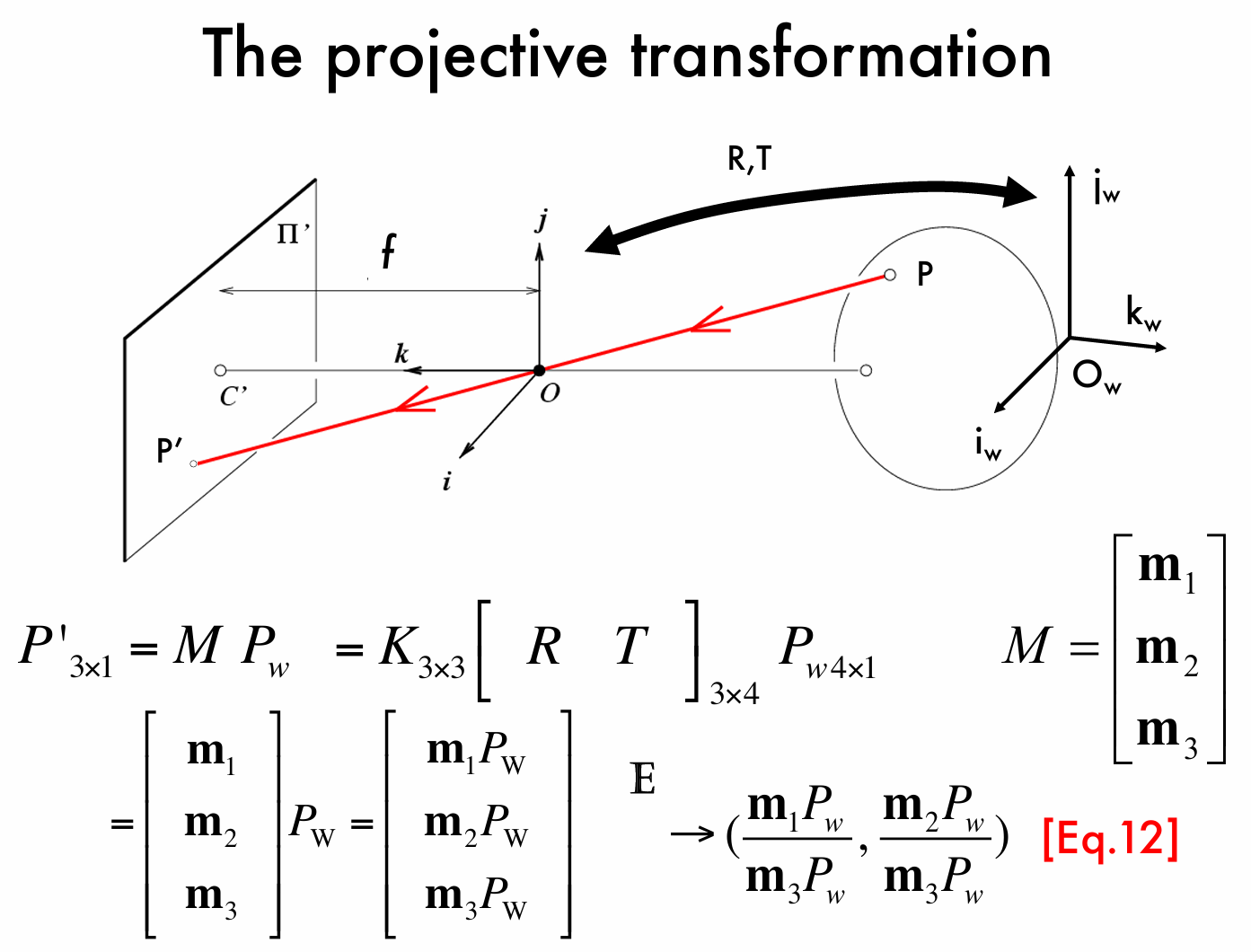

- Image Pyramid(简称Pyramid,图像金字塔)用于对输入的图像按照金字塔图层的方式处理,并输出到DDR,可实现对图像多尺度的缩小、裁剪,输出图像数据可直接用于BPU上的模型推理;

- GDC (Geometry and Distortion Correction,几何校正和失真校正)可将输入的图像进行视角变换、畸变校正和指定角度(0,90,180,270)旋转,常用于对鱼眼相机图像的畸变矫正;

- Stitch可对输入的图像进行裁剪、拼接,常用于AVM的环视图像拼接;

- ISP(Image Signal Processing) 图像信号处理。主要用来对前端图像传感器输出信号处理的单元,以匹配不同厂商的图像传感器。

- NPU(NeuralNetwork Processing Unit)神经网络处理器:常见的有GPU、BPU等。

- CPU(Central Processing Unit)中央处理器,常用于解释计算机指令以及处理软件中的数据。

有了输入数据传感器和数据处理单元后,下面就涉及到感知模块常用的算法了。

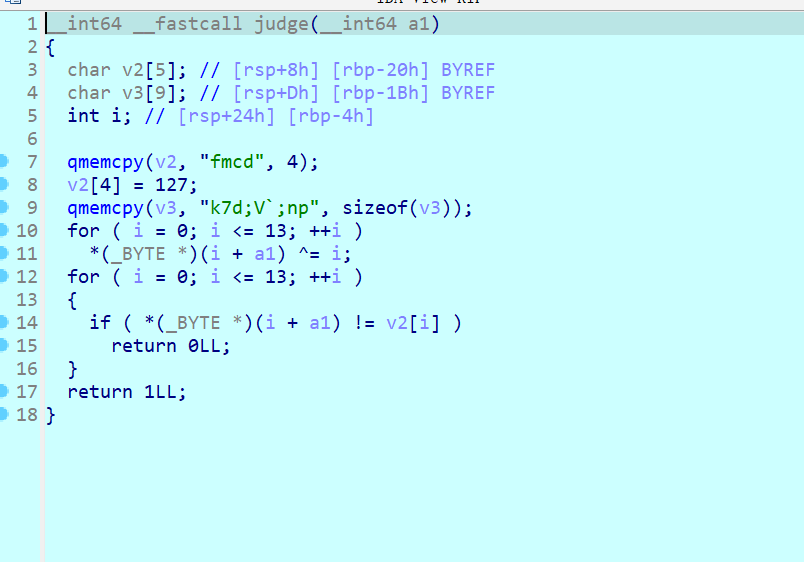

3.关键算法

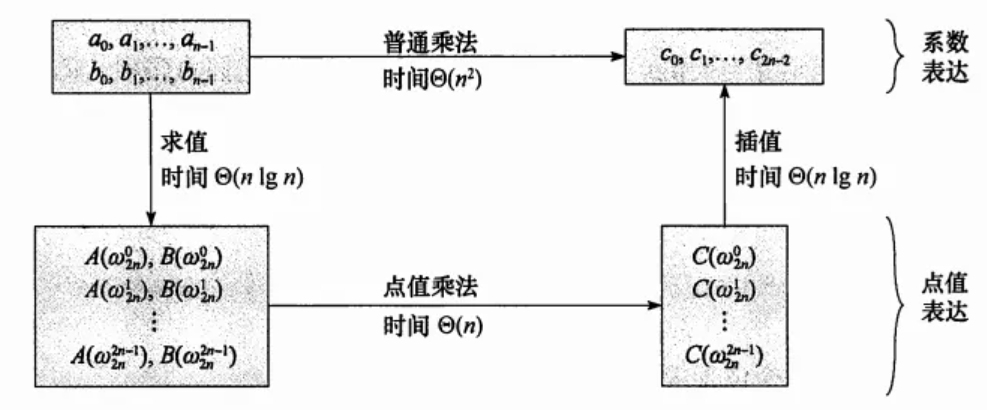

智能驾驶感知技术依赖于多种算法模型,以下是几种常用的算法:

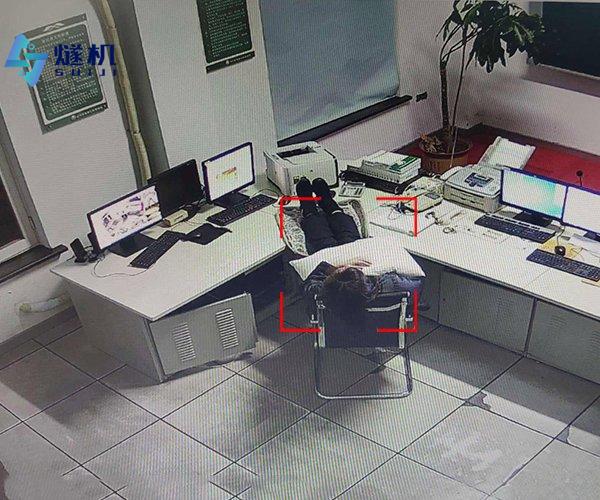

- 目标检测与识别:通过摄像头数据检测识别出车辆、行人、交通标志等。

- 点云分割与分类:通过激光雷达点云处理技术,识别障碍物和行驶道路。

- 多传感器融合:结合激光雷达、摄像头的数据,提高感知的准确性和鲁棒性。

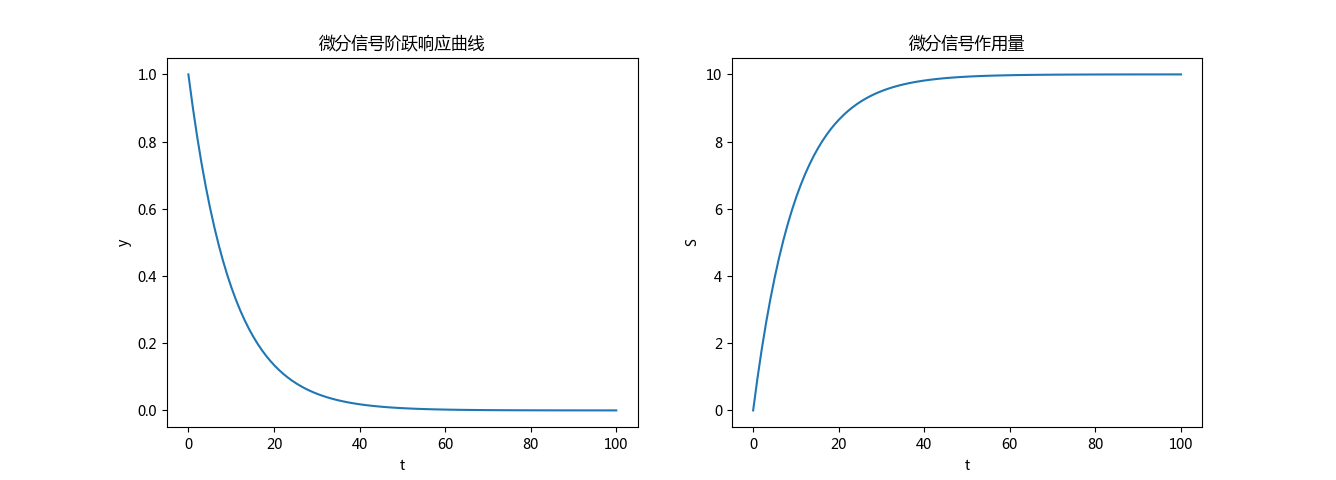

- 轨迹预测:对检测出的动态物体运动轨迹进行预测,为路径规划和决策提供支持。

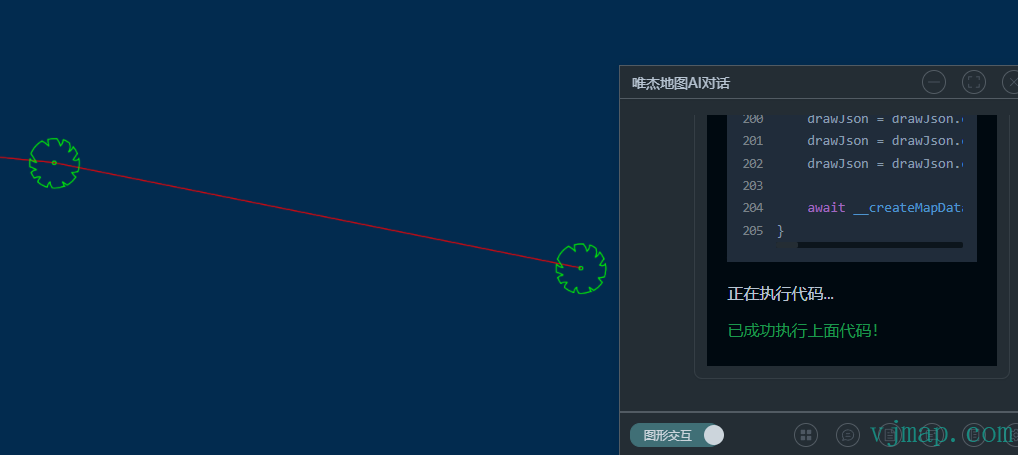

4.数据通路

以一个多传感器、多视角融合算法模型为例,介绍如何将整个数据通路串接起来,前面介绍的传感器和数据处理单元也会一起用起来。

5.感知技术的挑战

尽管感知技术已经取得显著进展,但仍然面临诸多挑战:

- 复杂环境下的可靠性:在雨雪、大雾、强光等恶劣天气条件下,传感器的性能会大幅下降,影响感知系统的可靠性。

- 计算效率:感知算法需要实时处理大量数据,计算复杂度高,对硬件性能要求极高。

- 传感器成本:高性能传感器如激光雷达成本较高,限制了其在量产车上的普及。

- 误检与漏检:在复杂场景中,感知系统可能出现误检(将无威胁物体识别为障碍)或漏检(忽略真实威胁)的情况,影响驾驶安全性。

希望本文能对您有所帮助,下次有时间再介绍别的~