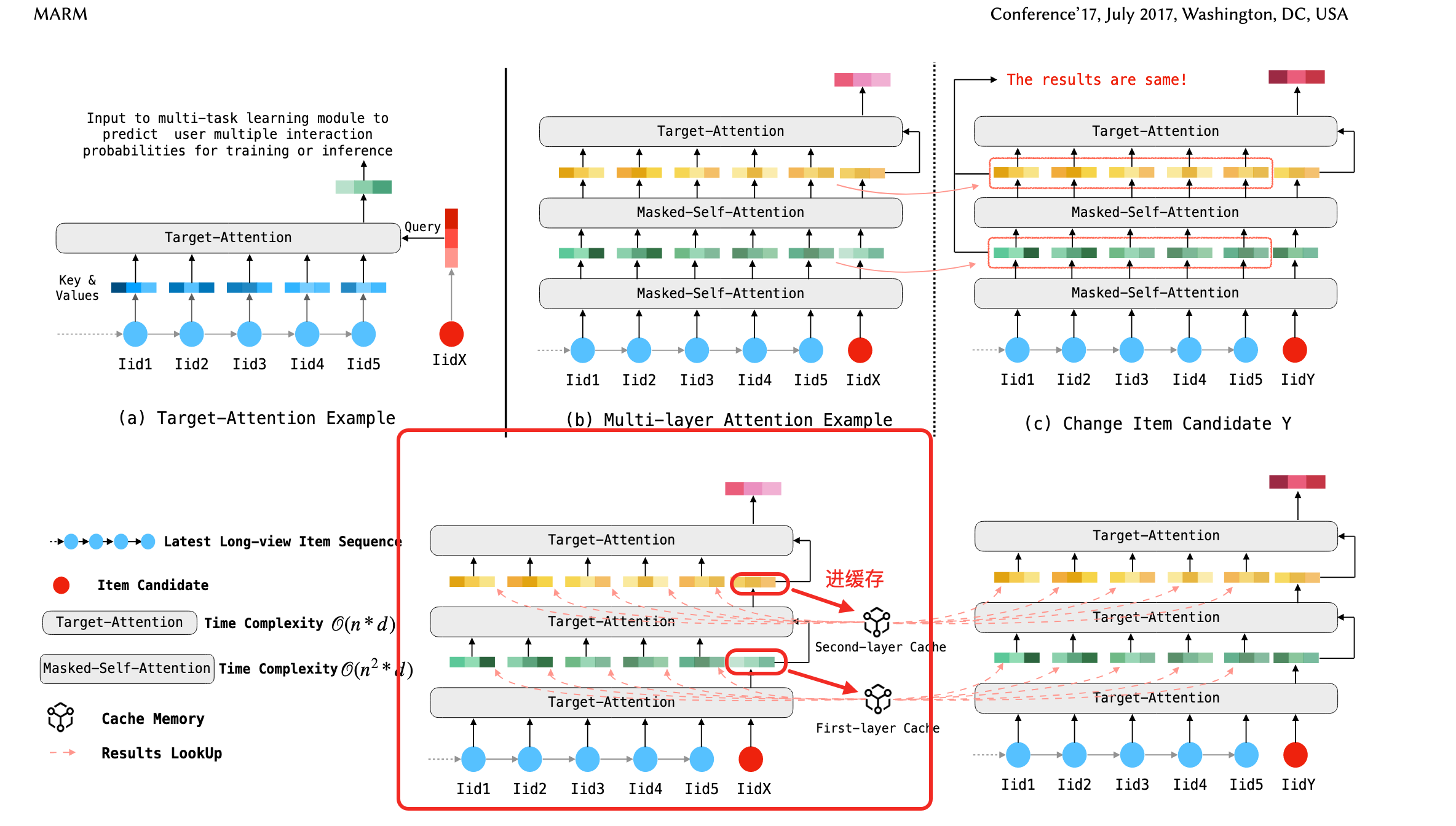

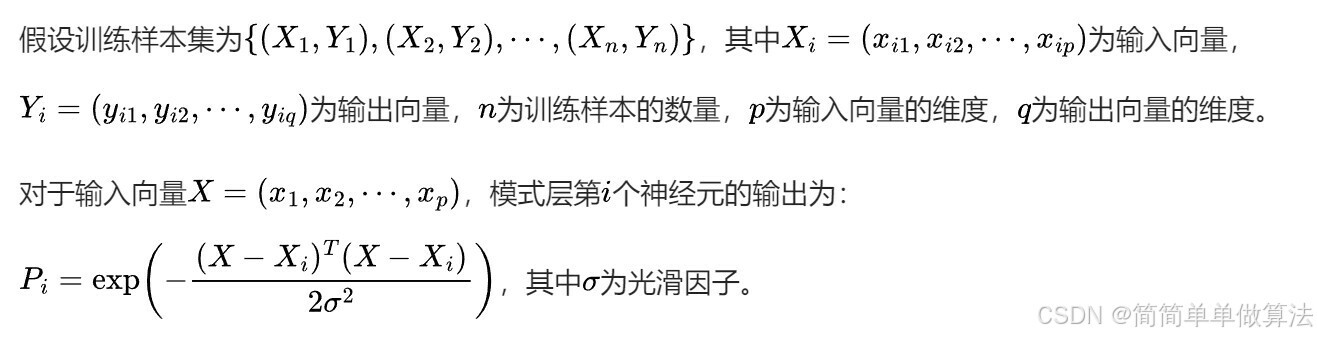

阅读了快手的论文 MARM,论文中的算法 符号看起来不容易理解。 对照图自己研究了下, 理解了。

-

需要知道为什么(b) 和(c) 中 的中间结果是相同的。需要知道 masked-self-attention

-

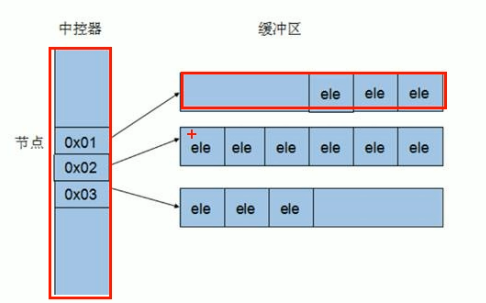

缓存是怎么处理,看箭头

-

快手 MARM: Unlocking the Future of Recommendation Systems through Memory Augmentation and Scalable Complexity

- masked-self-attention 参考这个 https://stackoverflow.blog/2024/09/26/masked-self-attention-how-llms-learn-relationships-between-tokens/

![NSSCTF--Crypto--[CISCN 2023 初赛]badkey](https://img2024.cnblogs.com/blog/3522845/202412/3522845-20241224191448431-944880286.png)

![[学习笔记] 线性筛与欧拉函数](https://nh.51goc.com/static/problemImage/10363/1583831789205.png/)

![[学习笔记] 网络流](https://cdn.luogu.com.cn/upload/pic/21712.png)